Дерево решений — это структура рекурсивного разбиения поддержки принятия решений , которая использует древовидную модель решений и их возможных последствий, включая результаты случайных событий, затраты ресурсов и полезность . Это один из способов отображения алгоритма , который содержит только условные операторы управления.

Деревья решений обычно используются в исследовании операций , в частности в анализе решений , [1] чтобы помочь определить стратегию, которая с наибольшей вероятностью достигнет цели, но также являются популярным инструментом в машинном обучении .

Дерево решений — это структура, похожая на блок-схему , в которой каждый внутренний узел представляет собой «тест» атрибута (например, выпадет ли при подбрасывании монеты орел или решка), каждая ветвь представляет собой результат теста, а каждый конечный узел представляет собой метку класса (решение, принятое после вычисления всех атрибутов). Пути от корня к листу представляют собой правила классификации .

В анализе решений дерево решений и тесно связанная с ним диаграмма влияния используются в качестве визуального и аналитического инструмента поддержки принятия решений, где рассчитываются ожидаемые значения (или ожидаемая полезность ) конкурирующих альтернатив.

Дерево решений состоит из трех типов узлов: [2]

Деревья решений обычно используются в исследовании операций и управлении операциями . Если на практике решения должны приниматься онлайн без отзыва в условиях неполного знания, дерево решений должно быть параллельно с вероятностной моделью в качестве модели наилучшего выбора или алгоритма модели онлайн-выбора . [ требуется ссылка ] Другое применение деревьев решений — в качестве описательного средства для расчета условных вероятностей .

Деревья решений, диаграммы влияния , функции полезности и другие инструменты и методы анализа решений преподаются студентам бакалавриата в школах бизнеса, экономики здравоохранения и общественного здравоохранения и являются примерами методов исследования операций или науки управления . Эти инструменты также используются для прогнозирования решений домовладельцев в обычных и чрезвычайных ситуациях. [3] [4]

Нарисованное слева направо дерево решений имеет только разрывные узлы (разделяющиеся пути), но не имеет стоковых узлов (сходящиеся пути). Поэтому при ручном использовании они могут стать очень большими, и тогда их часто трудно полностью нарисовать вручную. Традиционно деревья решений создавались вручную — как показывает этот пример — хотя все чаще используется специализированное программное обеспечение.

Дерево решений можно линеаризовать в правила принятия решений , [5] где результатом является содержимое листового узла, а условия вдоль пути образуют конъюнкцию в предложении if. В общем случае правила имеют вид:

Правила принятия решений могут быть сгенерированы путем построения правил ассоциации с целевой переменной справа. Они также могут обозначать временные или причинно-следственные связи. [6]

Обычно дерево решений рисуется с использованием символов блок-схемы , поскольку многим это проще читать и понимать. Обратите внимание, что в расчете "Proceed" дерева, показанного ниже, есть концептуальная ошибка; ошибка касается расчета "затрат", присужденных в судебном иске.

Анализ может учитывать предпочтения или функцию полезности лица, принимающего решение (например, компании) , например:

Основная интерпретация в этой ситуации заключается в том, что компания предпочитает риск и выплаты B при реалистичных коэффициентах предпочтения риска (более 400 тыс. долларов — в этом диапазоне неприятия риска компании необходимо будет смоделировать третью стратегию: «Ни A, ни B»).

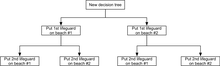

Другой пример, часто используемый в курсах по исследованию операций , — распределение спасателей на пляжах (также известный как пример «Жизнь — это пляж»). [7] В этом примере описываются два пляжа со спасателями, которых нужно распределить на каждом пляже. Существует максимальный бюджет B , который можно распределить между двумя пляжами (в общей сложности), и с помощью таблицы предельной доходности аналитики могут решить, сколько спасателей следует выделить на каждый пляж.

В этом примере можно нарисовать дерево решений, иллюстрирующее принципы убывающей доходности на пляже №1.

Дерево решений показывает, что при последовательном распределении спасателей размещение первого спасателя на пляже № 1 будет оптимальным, если есть бюджет только на 1 спасателя. Но если есть бюджет на двух спасателей, то размещение обоих на пляже № 2 предотвратит большее количество утоплений.

Большую часть информации в дереве решений можно представить более компактно в виде диаграммы влияния , сосредоточив внимание на проблемах и связях между событиями.

Деревья решений также можно рассматривать как генеративные модели правил индукции из эмпирических данных. Оптимальное дерево решений тогда определяется как дерево, которое учитывает большую часть данных, минимизируя при этом количество уровней (или «вопросов»). [8] Было разработано несколько алгоритмов для генерации таких оптимальных деревьев, таких как ID3 /4/5, [9] CLS, ASSISTANT и CART.

Среди инструментов поддержки принятия решений деревья решений (и диаграммы влияния ) имеют ряд преимуществ. Деревья решений:

Недостатки деревьев решений:

При улучшении точности классификатора дерева решений следует учитывать несколько моментов. Ниже приведены некоторые возможные оптимизации, которые следует учитывать при поиске того, чтобы убедиться, что созданная модель дерева решений принимает правильное решение или классификацию. Обратите внимание, что это не единственные моменты, которые следует учитывать, а лишь некоторые из них.

Увеличение количества уровней дерева

Точность дерева решений может меняться в зависимости от глубины дерева решений. Во многих случаях листья дерева являются чистыми узлами . [11] Когда узел является чистым, это означает, что все данные в этом узле принадлежат к одному классу. [12] Например, если классы в наборе данных — «Рак» и «Не рак», листовой узел будет считаться чистым, когда все данные выборки в листовом узле являются частью только одного класса: либо «рак», либо «не рак». Важно отметить, что более глубокое дерево не всегда лучше при оптимизации дерева решений. Более глубокое дерево может отрицательно влиять на время выполнения. Если используется определенный алгоритм классификации, то более глубокое дерево может означать, что время выполнения этого алгоритма классификации значительно замедляется. Существует также вероятность того, что фактический алгоритм, строящий дерево решений, станет значительно медленнее по мере того, как дерево становится глубже. Если используемый алгоритм построения дерева разделяет чистые узлы, то может наблюдаться снижение общей точности классификатора дерева. Иногда углубление в дерево может привести к снижению точности в целом, поэтому очень важно протестировать изменение глубины дерева решений и выбрать глубину, которая дает наилучшие результаты. Подводя итог, обратите внимание на пункты ниже, мы определим число D как глубину дерева.

Возможные преимущества увеличения числа D:

Возможные недостатки увеличения D

Возможность проверки различий в результатах классификации при изменении D является обязательной. Мы должны иметь возможность легко изменять и проверять переменные, которые могут повлиять на точность и надежность модели дерева решений.

Выбор функций разделения узлов

Используемая функция разделения узлов может влиять на повышение точности дерева решений. Например, использование функции прироста информации может дать лучшие результаты, чем использование функции фи. Функция фи известна как мера «хорошести» кандидата на разделение в узле дерева решений. Функция прироста информации известна как мера «снижения энтропии » . Далее мы построим два дерева решений. Одно дерево решений будет построено с использованием функции фи для разделения узлов, а другое дерево решений будет построено с использованием функции прироста информации для разделения узлов.

Основные преимущества и недостатки информационного прироста и функции фи

Это формула функции прироста информации. Формула утверждает, что прирост информации является функцией энтропии узла дерева решений за вычетом энтропии кандидата, разделенного на узел t дерева решений.

Это формула функции фи. Функция фи максимизируется, когда выбранная функция разделяет выборки таким образом, что производит однородные разделения и имеет примерно одинаковое количество выборок в каждом разделении.

Мы установим D, который является глубиной дерева решений, которое мы строим, на три (D = 3). У нас также есть следующий набор данных образцов рака и нерака и мутационные признаки, которые либо есть, либо нет в образцах. Если образец имеет мутацию признака, то образец положителен для этой мутации, и он будет представлен единицей. Если образец не имеет мутации признака, то образец отрицателен для этой мутации, и он будет представлен нулем.

Подводя итог, C означает рак, а NC означает нерак. Буква M означает мутацию , и если образец имеет определенную мутацию, она будет отображаться в таблице как единица, а в противном случае как ноль.

Теперь мы можем использовать формулы для вычисления значений функции phi и значений прироста информации для каждого M в наборе данных. После того, как все значения будут рассчитаны, можно построить дерево. Первое, что нужно сделать, это выбрать корневой узел. В приросте информации и функции phi мы считаем оптимальным разделением мутацию, которая дает наибольшее значение прироста информации или функции phi. Теперь предположим, что M1 имеет наибольшее значение функции phi, а M4 имеет наибольшее значение прироста информации. Мутация M1 будет корнем нашего дерева функции phi, а M4 будет корнем нашего дерева прироста информации. Вы можете наблюдать корневые узлы ниже

Теперь, как только мы выбрали корневой узел, мы можем разделить образцы на две группы в зависимости от того, является ли образец положительным или отрицательным для мутации корневого узла. Группы будут называться группой A и группой B. Например, если мы используем M1 для разделения образцов в корневом узле, мы получим образцы NC2 и C2 в группе A, а остальные образцы NC4, NC3, NC1, C1 в группе B.

Не обращая внимания на мутацию, выбранную для корневого узла, продолжайте размещать следующие лучшие признаки, которые имеют самые высокие значения для прироста информации или функции фи в левых или правых дочерних узлах дерева решений. После того, как мы выберем корневой узел и два дочерних узла для дерева глубины = 3, мы можем просто добавить листья. Листья будут представлять окончательное решение классификации, которое модель выработала на основе мутаций, которые либо есть, либо нет в образце. Левое дерево — это дерево решений, которое мы получаем, используя прирост информации для разделения узлов, а правое дерево — это то, что мы получаем, используя функцию фи для разделения узлов.

Теперь предположим, что результаты классификации по обоим деревьям даны с использованием матрицы путаницы .

Матрица путаницы прироста информации:

Матрица путаницы функции Фи:

Дерево с использованием прироста информации дает те же результаты, что и при использовании функции phi при расчете точности. Когда мы классифицируем образцы на основе модели с использованием прироста информации, мы получаем один истинно положительный результат, один ложно положительный результат, ноль ложно отрицательных результатов и четыре истинно отрицательных результата. Для модели с использованием функции phi мы получаем два истинно положительных результата, ноль ложно положительных результатов, один ложно отрицательный результат и три истинно отрицательных результата. Следующий шаг — оценить эффективность дерева решений с использованием некоторых ключевых метрик, которые будут рассмотрены в разделе «Оценка дерева решений» ниже. Метрики, которые будут рассмотрены ниже, могут помочь определить следующие шаги, которые необходимо предпринять при оптимизации дерева решений.

Другие методы

Вышеприведенная информация не является тем, чем заканчивается построение и оптимизация дерева решений. Существует множество методов улучшения моделей классификации дерева решений, которые мы строим. Один из методов — создание нашей модели дерева решений из набора данных с самозагрузкой . Набор данных с самозагрузкой помогает устранить смещение, которое возникает при построении модели дерева решений с теми же данными, с которыми модель тестируется. Возможность использовать мощь случайных лесов также может помочь значительно повысить общую точность создаваемой модели. Этот метод генерирует множество решений из множества деревьев решений и подсчитывает голоса из каждого дерева решений для создания окончательной классификации. Существует множество методов, но главная цель — протестировать построение вашей модели дерева решений разными способами, чтобы убедиться, что она достигает максимально возможного уровня производительности.

Важно знать измерения, используемые для оценки деревьев решений. Основные используемые метрики — это точность , чувствительность , специфичность , точность , коэффициент промахов , коэффициент ложных открытий и коэффициент ложных пропусков . Все эти измерения выводятся из количества истинно положительных , ложных положительных , истинно отрицательных и ложных отрицательных результатов , полученных при прогоне набора образцов через модель классификации дерева решений. Кроме того, можно создать матрицу путаницы для отображения этих результатов. Все эти основные метрики говорят что-то разное о сильных и слабых сторонах модели классификации, построенной на основе вашего дерева решений. Например, низкая чувствительность при высокой специфичности может указывать на то, что модель классификации, построенная на основе дерева решений, не справляется с идентификацией образцов рака по сравнению с образцами нераковых заболеваний.

Давайте рассмотрим матрицу путаницы ниже. Матрица путаницы показывает нам, что построенный классификатор модели дерева решений дал 11 истинно положительных результатов, 1 ложноположительный результат, 45 ложноотрицательных результатов и 105 истинно отрицательных результатов.

Теперь мы вычислим значения точности, чувствительности, специфичности, прецизионности, частоты пропусков, частоты ложных обнаружений и частоты ложных пропусков.

Точность:

Чувствительность (TPR – истинно положительный показатель): [14]

Специфичность (TNR – истинно отрицательный показатель):

Точность (PPV – положительная прогностическая ценность):

Коэффициент ложноотрицательных результатов (ЛОР):

Коэффициент ложных срабатываний (FDR):

Коэффициент ложного пропуска (FOR):

После того, как мы рассчитали ключевые показатели, мы можем сделать некоторые предварительные выводы о производительности построенной модели дерева решений. Точность, которую мы рассчитали, составила 71,60%. Значение точности хорошее для начала, но мы хотели бы, чтобы наши модели были максимально точными, сохраняя при этом общую производительность. Значение чувствительности 19,64% означает, что из всех, кто был фактически положительным на рак, тест был положительным. Если мы посмотрим на значение специфичности 99,06%, мы знаем, что из всех образцов, которые были фактически отрицательными на рак, тест был фактически отрицательным. Когда дело доходит до чувствительности и специфичности, важно иметь баланс между двумя значениями, поэтому, если мы можем уменьшить нашу специфичность, чтобы увеличить чувствительность, это окажется полезным. [15] Это всего лишь несколько примеров того, как использовать эти значения и значения, стоящие за ними, для оценки модели дерева решений и улучшения на следующей итерации.

{{cite book}}: CS1 maint: multiple names: authors list (link)