Метод наименьших квадратов — это метод оценки параметров в регрессионном анализе, основанный на минимизации суммы квадратов остатков ( остатком является разница между наблюдаемым значением и подобранным значением, предоставленным моделью), полученных в результатах каждого отдельного уравнения. (Проще говоря, наименьшие квадраты — это математическая процедура для нахождения наиболее подходящей кривой для заданного набора точек путем минимизации суммы квадратов смещений («остатков») точек от кривой.)

Наиболее важным применением является подгонка данных . Когда проблема имеет существенные неопределенности в независимой переменной ( переменной x ), то простые методы регрессии и наименьших квадратов имеют проблемы; в таких случаях вместо наименьших квадратов можно рассмотреть методологию, необходимую для подгонки моделей с ошибками в переменных .

Задачи наименьших квадратов делятся на две категории: линейные или обычные наименьшие квадраты и нелинейные наименьшие квадраты , в зависимости от того, являются ли функции модели линейными по всем неизвестным. Линейная задача наименьших квадратов возникает в статистическом регрессионном анализе ; она имеет решение в замкнутой форме . Нелинейная задача обычно решается итеративным уточнением ; на каждой итерации система аппроксимируется линейной, и, таким образом, основные вычисления в обоих случаях схожи.

Полиномиальный метод наименьших квадратов описывает дисперсию в прогнозе зависимой переменной как функцию независимой переменной и отклонения от подобранной кривой.

Когда наблюдения происходят из экспоненциального семейства с тождественностью в качестве его естественной достаточной статистики и выполняются мягкие условия (например, для нормального , экспоненциального , пуассоновского и биномиального распределений ), стандартизированные оценки наименьших квадратов и оценки максимального правдоподобия идентичны. [1] Метод наименьших квадратов также может быть выведен как метод оценки моментов .

Последующее обсуждение в основном представлено в терминах линейных функций, но использование наименьших квадратов допустимо и практично для более общих семейств функций. Кроме того, итеративно применяя локальное квадратичное приближение к правдоподобию (через информацию Фишера ), метод наименьших квадратов может быть использован для подгонки обобщенной линейной модели .

Метод наименьших квадратов был официально открыт и опубликован Адриеном-Мари Лежандром (1805) [2] , хотя его изобретение обычно приписывают Карлу Фридриху Гауссу (1809) [3] [4], который внес значительный теоретический вклад в этот метод [4] и, возможно, также использовал его в своих более ранних работах в 1794 и 1795 годах. [5] [4]

Метод наименьших квадратов возник в областях астрономии и геодезии , когда ученые и математики пытались найти решения проблем навигации в океанах Земли в эпоху Великих географических открытий . Точное описание поведения небесных тел стало ключом к тому, чтобы корабли могли плавать в открытом море, где моряки больше не могли полагаться на наземные наблюдения для навигации.

Этот метод стал кульминацией нескольких достижений, имевших место в течение восемнадцатого века: [6]

Первое ясное и краткое изложение метода наименьших квадратов было опубликовано Лежандром в 1805 году. [7] Метод описывается как алгебраическая процедура подгонки линейных уравнений к данным, и Лежандр демонстрирует новый метод, анализируя те же данные, что и Лаплас для формы Земли. В течение десяти лет после публикации Лежандра метод наименьших квадратов был принят в качестве стандартного инструмента в астрономии и геодезии во Франции , Италии и Пруссии , что представляет собой необычайно быстрое принятие научного метода. [6]

В 1809 году Карл Фридрих Гаусс опубликовал свой метод расчета орбит небесных тел. В этой работе он утверждал, что владеет методом наименьших квадратов с 1795 года. [8] Это, естественно, привело к приоритетному спору с Лежандром. Однако, к чести Гаусса, он пошел дальше Лежандра и преуспел в соединении метода наименьших квадратов с принципами вероятности и нормальным распределением . Ему удалось завершить программу Лапласа по указанию математической формы плотности вероятности для наблюдений, зависящей от конечного числа неизвестных параметров, и определить метод оценки, который минимизирует ошибку оценки. Гаусс показал, что среднее арифметическое действительно является наилучшей оценкой параметра местоположения, изменив как плотность вероятности , так и метод оценки. Затем он перевернул проблему, спросив, какую форму должна иметь плотность и какой метод оценки следует использовать, чтобы получить среднее арифметическое как оценку параметра местоположения. В этой попытке он изобрел нормальное распределение.

Ранняя демонстрация силы метода Гаусса произошла, когда он был использован для предсказания будущего местоположения недавно открытого астероида Церера . 1 января 1801 года итальянский астроном Джузеппе Пиацци открыл Цереру и смог отслеживать ее путь в течение 40 дней, прежде чем она затерялась в ярком свете Солнца. Основываясь на этих данных, астрономы хотели определить местоположение Цереры после того, как она вышла из-за Солнца, не решая сложные нелинейные уравнения Кеплера для движения планет. Единственными предсказаниями, которые успешно позволили венгерскому астроному Францу Ксаверу фон Заху переместить Цереру, были те, которые были выполнены 24-летним Гауссом с помощью анализа наименьших квадратов.

В 1810 году, прочитав работу Гаусса, Лаплас, доказав центральную предельную теорему , использовал ее для обоснования метода наименьших квадратов и нормального распределения на большой выборке. В 1822 году Гаусс смог заявить, что подход наименьших квадратов к регрессионному анализу является оптимальным в том смысле, что в линейной модели, где ошибки имеют нулевое среднее, некоррелированы, нормально распределены и имеют равные дисперсии, наилучшей линейной несмещенной оценкой коэффициентов является оценка наименьших квадратов. Расширенная версия этого результата известна как теорема Гаусса–Маркова .

Идея анализа наименьших квадратов была также независимо сформулирована американцем Робертом Эдрейном в 1808 году. В течение следующих двух столетий исследователи теории ошибок и статистики нашли много различных способов реализации метода наименьших квадратов. [9]

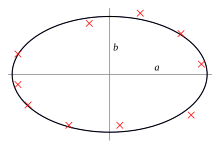

Цель состоит в настройке параметров функции модели для наилучшего соответствия набору данных. Простой набор данных состоит из n точек (пар данных) , i = 1, …, n , где — независимая переменная , а — зависимая переменная , значение которой находится путем наблюдения. Функция модели имеет вид , где m настраиваемых параметров хранятся в векторе . Цель состоит в том, чтобы найти значения параметров для модели, которые «наилучшим образом» соответствуют данным. Соответствие модели точке данных измеряется ее остатком , определяемым как разница между наблюдаемым значением зависимой переменной и значением, предсказанным моделью:

Метод наименьших квадратов находит оптимальные значения параметров путем минимизации суммы квадратов остатков : [10]

В простейшем случае результатом метода наименьших квадратов является среднее арифметическое входных данных.

Примером модели в двух измерениях является модель прямой линии. Обозначая точку пересечения с осью y как и наклон как , функция модели задается как . См. линейный метод наименьших квадратов для полностью разработанного примера этой модели.

Точка данных может состоять из более чем одной независимой переменной. Например, при подгонке плоскости к набору измерений высоты плоскость является функцией двух независимых переменных, скажем, x и z . В самом общем случае в каждой точке данных может быть одна или несколько независимых переменных и одна или несколько зависимых переменных.

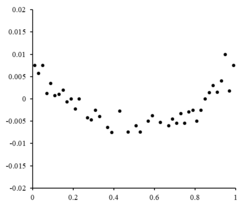

Справа находится остаточный график, иллюстрирующий случайные колебания около , что указывает на пригодность линейной модели . — независимая случайная величина. [10]

Если бы остаточные точки имели какую-то форму и не флуктуировали случайным образом, линейная модель не подходила бы. Например, если бы остаточный график имел параболическую форму, как показано справа, параболическая модель была бы подходящей для данных. Остатки для параболической модели можно рассчитать с помощью . [10]

Эта формулировка регрессии учитывает только ошибки наблюдения в зависимой переменной (но альтернативная общая регрессия наименьших квадратов может учитывать ошибки в обеих переменных). Существуют два довольно разных контекста с разными последствиями:

Минимум суммы квадратов находится путем установки градиента в ноль. Поскольку модель содержит m параметров, имеется m уравнений градиента : и поскольку , уравнения градиента становятся

Уравнения градиента применяются ко всем задачам наименьших квадратов. Каждая конкретная задача требует конкретных выражений для модели и ее частных производных . [12]

Регрессионная модель является линейной, когда модель представляет собой линейную комбинацию параметров, т. е. когда функция является функцией . [12]

Позволяя и помещая независимые и зависимые переменные в матрицы и , соответственно, мы можем вычислить наименьшие квадраты следующим образом. Обратите внимание, что это набор всех данных. [12] [13]

Градиент потерь составляет:

Приравнивая градиент потерь к нулю и решая для , получаем: [13] [12]

В некоторых случаях существует замкнутое решение нелинейной задачи наименьших квадратов, но в общем случае его нет. В случае отсутствия замкнутого решения используются численные алгоритмы для нахождения значения параметров, которое минимизирует цель. Большинство алгоритмов включают выбор начальных значений для параметров. Затем параметры уточняются итеративно, то есть значения получаются путем последовательного приближения: где верхний индекс k — это номер итерации, а вектор приращений называется вектором сдвига. В некоторых часто используемых алгоритмах на каждой итерации модель может быть линеаризована путем приближения к разложению в ряд Тейлора первого порядка около :

Якобиан J является функцией констант, независимой переменной и параметров, поэтому он меняется от одной итерации к другой. Остатки задаются как

Чтобы минимизировать сумму квадратов , градиентное уравнение приравнивается к нулю и решается относительно : которые при перестановке становятся m совместными линейными уравнениями, нормальными уравнениями :

Нормальные уравнения записываются в матричной форме как

Это определяющие уравнения алгоритма Гаусса–Ньютона .

Эти различия необходимо учитывать всякий раз, когда ищется решение нелинейной задачи наименьших квадратов. [12]

Рассмотрим простой пример из физики. Пружина должна подчиняться закону Гука , который гласит, что удлинение пружины y пропорционально силе, F , приложенной к ней. составляет модель, где F — независимая переменная. Чтобы оценить силовую постоянную , k , мы проводим серию из n измерений с различными силами, чтобы получить набор данных, , где y i — измеренное удлинение пружины. [14] Каждое экспериментальное наблюдение будет содержать некоторую ошибку, , и поэтому мы можем указать эмпирическую модель для наших наблюдений,

Существует много методов, которые мы могли бы использовать для оценки неизвестного параметра k . Поскольку n уравнений в m переменных в наших данных составляют переопределенную систему с одним неизвестным и n уравнениями, мы оцениваем k с помощью наименьших квадратов. Сумма квадратов, которая должна быть минимизирована, равна [12]

Оценка константы силы k методом наименьших квадратов определяется выражением

Мы предполагаем, что приложение силы заставляет пружину расширяться. После того, как мы вывели константу силы методом наименьших квадратов, мы предсказываем расширение по закону Гука.

При расчете наименьших квадратов с единичными весами или в линейной регрессии дисперсия j -го параметра, обозначенная , обычно оценивается с помощью где истинная дисперсия ошибки σ 2 заменяется оценкой, приведенной статистикой хи-квадрат , основанной на минимизированном значении остаточной суммы квадратов (целевой функции), S . Знаменатель, n − m , представляет собой статистические степени свободы ; см. эффективные степени свободы для обобщений. [12] C — ковариационная матрица .

Если распределение вероятностей параметров известно или сделано асимптотическое приближение, можно найти пределы доверия . Аналогично, статистические тесты остатков могут быть проведены, если распределение вероятностей остатков известно или предполагается. Мы можем вывести распределение вероятностей любой линейной комбинации зависимых переменных, если распределение вероятностей экспериментальных ошибок известно или предполагается. Вывод прост, если предположить, что ошибки следуют нормальному распределению, следовательно, подразумевая, что оценки параметров и остатки также будут нормально распределены в зависимости от значений независимых переменных. [12]

Необходимо сделать предположения о природе экспериментальных ошибок, чтобы статистически проверить результаты. Распространенное предположение заключается в том, что ошибки принадлежат нормальному распределению. Центральная предельная теорема поддерживает идею о том, что это хорошее приближение во многих случаях.

Однако предположим, что ошибки распределены не нормально. В этом случае центральная предельная теорема часто все же подразумевает, что оценки параметров будут приблизительно нормально распределены, пока выборка достаточно велика. По этой причине, учитывая важное свойство, что среднее значение ошибки не зависит от независимых переменных, распределение члена ошибки не является важным вопросом в регрессионном анализе. В частности, обычно не важно, следует ли член ошибки нормальному распределению.

Особый случай обобщенных наименьших квадратов, называемый взвешенными наименьшими квадратами, возникает, когда все недиагональные элементы Ω (корреляционная матрица остатков) равны нулю; дисперсии наблюдений (вдоль диагонали ковариационной матрицы) могут быть по-прежнему неравными ( гетероскедастичность ). Проще говоря, гетероскедастичность — это когда дисперсия зависит от значения , что заставляет график остатков создавать эффект «разветвления» в сторону больших значений, как показано на графике остатков справа. С другой стороны, гомоскедастичность предполагает, что дисперсия и дисперсия равны. [10]

Первый главный компонент о среднем значении набора точек может быть представлен той линией, которая наиболее близко подходит к точкам данных (измеряемым квадратом расстояния наибольшего приближения, т.е. перпендикулярно линии). Напротив, линейный метод наименьших квадратов пытается минимизировать расстояние только в направлении. Таким образом, хотя оба используют схожую метрику ошибки, линейный метод наименьших квадратов является методом, который обрабатывает одно измерение данных предпочтительно, в то время как PCA обрабатывает все измерения одинаково.

Известный статистик Сара ван де Гир использовала теорию эмпирических процессов и размерность Вапника–Червоненкиса, чтобы доказать, что оценка наименьших квадратов может быть интерпретирована как мера на пространстве квадратично интегрируемых функций . [16]

В некоторых контекстах регуляризованная версия решения наименьших квадратов может быть предпочтительнее. Регуляризация Тихонова (или гребневая регрессия ) добавляет ограничение, что , квадрат -нормы вектора параметров, не больше заданного значения в формулировке наименьших квадратов, что приводит к проблеме ограниченной минимизации. Это эквивалентно проблеме неограниченной минимизации, где целевая функция является остаточной суммой квадратов плюс штрафной член и является параметром настройки (это лагранжева форма проблемы ограниченной минимизации). [17]

В байесовском контексте это эквивалентно размещению нормально распределенной априорной вероятности с нулевым средним значением на векторе параметров.

Альтернативной регуляризованной версией наименьших квадратов является Лассо (оператор наименьшего абсолютного сжатия и выбора), который использует ограничение , что L 1 -норма вектора параметров не больше заданного значения. [18] [19] [20] (Можно показать, как и выше, используя множители Лагранжа, что это эквивалентно безусловной минимизации штрафа наименьших квадратов с добавлением.) В байесовском контексте это эквивалентно размещению априорного распределения Лапласа с нулевым средним на векторе параметров. [21] Задача оптимизации может быть решена с помощью квадратичного программирования или более общих методов выпуклой оптимизации , а также с помощью специальных алгоритмов, таких как алгоритм регрессии наименьшего угла .

Одно из главных различий между Lasso и гребневой регрессией заключается в том, что в гребневой регрессии по мере увеличения штрафа все параметры уменьшаются, оставаясь при этом ненулевыми, в то время как в Lasso увеличение штрафа приведет к тому, что все больше и больше параметров будут сведены к нулю. Это преимущество Lasso перед гребневой регрессией, поскольку сведение параметров к нулю отменяет выборку признаков из регрессии. Таким образом, Lasso автоматически выбирает более релевантные признаки и отбрасывает другие, тогда как гребневая регрессия никогда полностью не отбрасывает какие-либо признаки. Некоторые методы выбора признаков разработаны на основе LASSO, включая Bolasso, который бутстрапит выборки, [22] и FeaLect, который анализирует коэффициенты регрессии, соответствующие различным значениям для оценки всех признаков. [23]

L 1 -регуляризованная формулировка полезна в некоторых контекстах из-за ее тенденции предпочитать решения, где больше параметров равны нулю, что дает решения, зависящие от меньшего количества переменных. [ 18] По этой причине Лассо и его варианты являются основополагающими в области сжатого зондирования . Расширением этого подхода является эластичная сетевая регуляризация .

{{cite book}}: CS1 maint: others (link){{cite book}}: CS1 maint: location (link) CS1 maint: location missing publisher (link) CS1 maint: multiple names: authors list (link) CS1 maint: numeric names: authors list (link)