В информатике согласованное хеширование [1] [2] — это особый вид техники хеширования , при котором при изменении размера хеш-таблицы в среднем требуется переназначение только ключей, где — количество ключей, а — количество слотов. Напротив, в большинстве традиционных хеш-таблиц изменение количества слотов массива приводит к переназначению почти всех ключей, поскольку сопоставление между ключами и слотами определяется модульной операцией .

Последовательное хеширование равномерно распределяет ключи кэша по сегментам , даже если некоторые сегменты выходят из строя или становятся недоступными. [3]

Термин «последовательное хеширование» был введен Дэвидом Каргером и др. в Массачусетском технологическом институте для использования в распределенном кэшировании , в частности, для Интернета . [4] Эта академическая статья 1997 года на Симпозиуме по теории вычислений ввела термин «последовательное хеширование» как способ распределения запросов среди изменяющейся популяции веб-серверов. [5] Затем каждый слот представлен сервером в распределенной системе или кластере. Добавление сервера и удаление сервера (во время масштабируемости или простоя) требует только перетасовки элементов при изменении количества слотов (т. е. серверов). Авторы упоминают линейное хеширование и его способность обрабатывать последовательное добавление и удаление серверов, в то время как последовательное хеширование позволяет добавлять и удалять серверы в произвольном порядке. [1] Позднее статья была переориентирована на решение технической проблемы отслеживания файла в одноранговых сетях, таких как распределенная хеш-таблица . [6] [7]

Teradata использовала эту технику в своей распределенной базе данных, выпущенной в 1986 году, хотя они не использовали этот термин. Teradata до сих пор использует концепцию хэш-таблицы для достижения именно этой цели. Akamai Technologies была основана в 1998 году учеными Дэниелом Левином и Ф. Томсоном Лейтоном (соавторами статьи, в которой был введен термин «консистентное хэширование»). В сети доставки контента Akamai [8] для балансировки нагрузки внутри кластера серверов используется консистентное хэширование, в то время как для балансировки нагрузки между кластерами используется алгоритм стабильного брака . [2]

Последовательное хеширование также использовалось для снижения влияния частичных сбоев системы в крупных веб-приложениях, чтобы обеспечить надежное кэширование без общесистемных последствий сбоя. [9] Последовательное хеширование также является краеугольным камнем распределенных хеш-таблиц (DHT), которые используют хеш-значения для разделения пространства ключей по распределенному набору узлов, а затем создают оверлейную сеть связанных узлов, которая обеспечивает эффективное извлечение узлов по ключу.

Rendezvous hashing , разработанный в 1996 году, является более простой и более общей техникой [ требуется ссылка ] . Он достигает целей последовательного хеширования, используя совершенно другой алгоритм с наибольшим случайным весом (HRW).

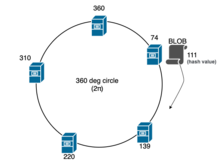

В задаче балансировки нагрузки , например, когда BLOB должен быть назначен одному из серверов в кластере , стандартная хэш-функция может быть использована таким образом, что мы вычисляем значение хэша для этого BLOB, предполагая, что результирующее значение хэша равно , мы выполняем модульную операцию с количеством серверов ( в данном случае), чтобы определить сервер, на котором мы можем разместить BLOB: ; следовательно, BLOB будет размещен на сервере, преемником которого является в этом случае. Однако, когда сервер добавляется или удаляется во время сбоя или масштабирования (при изменениях), все BLOB на каждом сервере должны быть переназначены и перемещены из-за повторного хэширования , но эта операция является дорогостоящей.

Согласованное хеширование было разработано для того, чтобы избежать проблемы необходимости переназначать каждый BLOB при добавлении или удалении сервера по всему кластеру. Основная идея заключается в использовании хеш-функции, которая сопоставляет как BLOB, так и серверы с единичной окружностью, обычно радианной. Например, (где — хэш BLOB или идентификатора сервера, такого как IP-адрес или UUID ). Затем каждый BLOB назначается следующему серверу, который появляется на окружности по часовой стрелке. Обычно алгоритм двоичного поиска или линейный поиск используется для поиска «места» или сервера для размещения этого конкретного BLOB в или сложностях соответственно; и в каждой итерации, которая происходит по часовой стрелке, выполняется операция (где — значение сервера в кластере) для поиска сервера для размещения BLOB. Это обеспечивает равномерное распределение BLOB по серверам. Но, что более важно, если сервер выходит из строя и удаляется из окружности, только BLOB, которые были сопоставлены с отказавшим сервером, необходимо переназначить следующему серверу по часовой стрелке. Аналогично, если добавляется новый сервер, он добавляется в единичный круг, и переназначать нужно только BLOB-объекты, сопоставленные с этим сервером.

Важно отметить, что при добавлении или удалении сервера подавляющее большинство BLOB сохраняют свои предыдущие назначения сервера, а добавление сервера приводит к перемещению только части BLOB. Хотя процесс перемещения BLOB между серверами кэширования в кластере зависит от контекста, обычно вновь добавленный сервер кэширования идентифицирует своего «преемника» и перемещает все BLOB, отображение которых принадлежит этому серверу (т. е. чье хэш-значение меньше, чем у нового сервера), с него. Однако в случае кэширования веб-страниц в большинстве реализаций перемещение или копирование не требуется, если кэшированный BLOB достаточно мал. Когда запрос попадает на вновь добавленный сервер кэширования, происходит промах кэширования , и делается запрос к фактическому веб-серверу , а BLOB кэшируется локально для будущих запросов. Избыточные BLOB на ранее используемых серверах кэширования будут удалены в соответствии с политиками вытеснения кэша . [10]

Пусть и будут хэш-функциями, используемыми для BLOB и уникального идентификатора сервера соответственно. На практике двоичное дерево поиска (BST) используется для динамического поддержания в пределах кластера или хэширования, а для поиска преемника или минимума в пределах BST используется обход дерева .

Чтобы избежать перекоса нескольких узлов в радиане, который возникает из-за отсутствия равномерного распределения серверов в кластере, используются несколько меток. Эти дублирующие метки называются «виртуальными узлами», т.е. несколько меток, которые указывают на одну «реальную» метку или сервер в кластере. Количество виртуальных узлов или дублирующих меток, используемых для конкретного сервера в кластере, называется «весом» этого конкретного сервера. [14]

Для эффективного использования согласованного хеширования для балансировки нагрузки на практике требуется ряд расширений базовой техники. В базовой схеме выше, если сервер выходит из строя, все его BLOB-объекты переназначаются следующему серверу по часовой стрелке, что потенциально удваивает нагрузку на этот сервер. Это может быть нежелательно. Чтобы обеспечить более равномерное перераспределение BLOB-объектов при отказе сервера, каждый сервер может быть хеширован в нескольких местах на единичной окружности. Когда сервер выходит из строя, BLOB-объекты, назначенные каждой из его реплик на единичной окружности, будут переназначены на другой сервер по часовой стрелке, тем самым перераспределяя BLOB-объекты более равномерно. Другое расширение касается ситуации, когда один BLOB-объект становится «горячим», к нему обращаются много раз и его придется размещать на нескольких серверах. В этой ситуации BLOB-объект может быть назначен нескольким смежным серверам путем обхода единичной окружности по часовой стрелке. Более сложное практическое рассмотрение возникает, когда два BLOB хэшируются рядом друг с другом в единичном круге и оба становятся «горячими» в одно и то же время. В этом случае оба BLOB будут использовать один и тот же набор смежных серверов в единичном круге. Эту ситуацию можно улучшить, выбрав для каждого BLOB другую хэш-функцию для сопоставления серверов с единичным кругом. [2]

Rendezvous hashing , разработанный в 1996 году, является более простой и более общей техникой и позволяет полностью распределенное соглашение о наборе опций из возможного набора опций. Фактически можно показать , что согласованное хеширование является частным случаем rendezvous hashing. Благодаря своей простоте и общности rendezvous hashing теперь используется вместо Consistent Hashing во многих приложениях.

Если значения ключей всегда будут увеличиваться монотонно , альтернативный подход с использованием хэш-таблицы с монотонными ключами может оказаться более подходящим, чем последовательное хэширование. [ необходима цитата ]

Средняя стоимость перераспределения ключей, а сложность последовательного хеширования обусловлена тем, что для нахождения следующего узла на кольце требуется двоичный поиск среди углов узлов. [ необходима цитата ]

Известные примеры последовательного использования хеширования включают в себя:

Последовательное хеширование — это метод, который позволяет избежать этих проблем, и мы используем его для вычисления местоположения каждого ключа в кластере.