В области интеллекта и искусственного интеллекта интеллектуальный агент ( ИА ) — это агент, который воспринимает окружающую среду , выполняет действия автономно для достижения целей и может улучшать свою эффективность посредством обучения или приобретения знаний .

Интеллектуальный агент может быть простым или сложным: термостат или другая система управления считается примером интеллектуального агента, как и человек , как и любая система, которая соответствует определению, например, фирма , государство или биом . [1]

Ведущие учебники по ИИ определяют «искусственный интеллект» как «изучение и проектирование интеллектуальных агентов», определение, которое рассматривает целенаправленное поведение как сущность интеллекта. Целеустремленные агенты также описываются с использованием термина, заимствованного из экономики , « рациональный агент ». [1]

Агент имеет «целевую функцию», которая инкапсулирует все цели IA. Такой агент предназначен для создания и выполнения любого плана, который по завершении максимизирует ожидаемое значение целевой функции. [2]

Например, агент обучения с подкреплением имеет «функцию вознаграждения», которая позволяет программистам формировать желаемое поведение ИИ, [3] а поведение эволюционного алгоритма формируется «функцией приспособленности». [4]

Интеллектуальные агенты в искусственном интеллекте тесно связаны с агентами в экономике , а версии парадигмы интеллектуального агента изучаются в когнитивной науке , этике и философии практического разума , а также во многих междисциплинарных социокогнитивных моделях и компьютерных социальных симуляциях .

Интеллектуальных агентов часто схематически описывают как абстрактную функциональную систему, похожую на компьютерную программу.

Абстрактные описания интеллектуальных агентов называются абстрактными интеллектуальными агентами ( АИА ), чтобы отличать их от их реальных реализаций.

Автономный интеллектуальный агент предназначен для работы в отсутствие вмешательства человека. Интеллектуальные агенты также тесно связаны с программными агентами . Автономная компьютерная программа, которая выполняет задачи от имени пользователей.

Искусственный интеллект: современный подход [5] [6] [2] определяет «агента» как

«Все, что можно рассматривать как воспринимающее окружающую среду посредством датчиков и воздействующее на эту среду посредством исполнительных механизмов»

Он определяет «рационального агента» как:

«Агент, который действует таким образом, чтобы максимизировать ожидаемое значение показателя эффективности на основе прошлого опыта и знаний».

В нем также определяется область «исследований искусственного интеллекта» как:

«Изучение и проектирование рациональных агентов»

Padgham & Winikoff (2005) согласны, что интеллектуальный агент находится в среде и реагирует своевременно (хотя не обязательно в реальном времени) на изменения в среде. Однако интеллектуальные агенты также должны активно преследовать цели гибким и надежным способом. [a] Необязательные желательные условия включают, что агент должен быть рациональным и что агент должен быть способен к анализу убеждений-желаний-намерений . [7]

Каплан и Хенлейн определяют искусственный интеллект как «способность системы правильно интерпретировать внешние данные, учиться на этих данных и использовать эти знания для достижения конкретных целей и задач посредством гибкой адаптации». [8] Это определение тесно связано с определением интеллектуального агента.

Философски это определение искусственного интеллекта избегает нескольких линий критики. В отличие от теста Тьюринга , оно никак не относится к человеческому интеллекту. Таким образом, нет необходимости обсуждать, является ли это «реальным» или «симулированным» интеллектом (т. е. «синтетическим» или «искусственным» интеллектом), и не указывает на то, что такая машина имеет разум , сознание или истинное понимание . Кажется, оно не подразумевает « сильную гипотезу ИИ » Джона Сирла . Оно также не пытается провести резкую разделительную линию между поведением, которое является «интеллектуальным» и поведением, которое является «неинтеллектуальным» — программы нужно измерять только с точки зрения их целевой функции.

Что еще важнее, он имеет ряд практических преимуществ, которые помогли продвинуть исследования ИИ вперед. Он обеспечивает надежный и научный способ тестирования программ; исследователи могут напрямую сравнивать или даже комбинировать различные подходы к изолированным проблемам, спрашивая, какой агент лучше всего максимизирует заданную «целевую функцию».

Это также дает им общий язык для общения с другими областями, такими как математическая оптимизация (которая определяется в терминах «целей») или экономика (которая использует то же определение « рационального агента »). [9]

Агент, которому назначена явная «целевая функция», считается более интеллектуальным, если он последовательно предпринимает действия, которые успешно максимизируют его запрограммированную целевую функцию.

Цель может быть простой: 1, если IA выигрывает игру в Го , 0 в противном случае.

Или цель может быть сложной: выполнить действия, математически аналогичные тем, которые были успешными в прошлом.

«Целевая функция» инкапсулирует все цели, ради которых действует агент; в случае рациональных агентов функция также инкапсулирует приемлемые компромиссы между достижением противоречивых целей.

Терминология варьируется. Например, некоторые агенты стремятся максимизировать или минимизировать « функцию полезности », «целевую функцию» или « функцию потерь ». [6] [2]

Цели могут быть явно определены или вызваны. Если ИИ запрограммирован на « обучение с подкреплением », у него есть « функция вознаграждения », которая поощряет одни типы поведения и наказывает другие.

В качестве альтернативы эволюционная система может индуцировать цели, используя « функцию приспособленности » для мутации и предпочтительного копирования систем ИИ с высокими показателями, подобно тому, как животные эволюционировали, чтобы изначально стремиться к определенным целям, таким как поиск пищи. [10]

Некоторые системы ИИ, такие как «ближайший сосед» , вместо рассуждений по аналогии , как правило, не имеют целей, за исключением той степени, в которой цели подразумеваются в их обучающих данных. [11] Такие системы все еще могут быть подвергнуты сравнительному анализу, если нецелевая система представлена как система, «целью» которой является выполнение ее узкой задачи классификации. [12]

Системы, которые традиционно не считаются агентами, такие как системы представления знаний , иногда включаются в парадигму , представляя их в качестве агентов, имеющих цель (например) отвечать на вопросы как можно точнее; понятие «действие» здесь расширено, чтобы охватить «действие» предоставления ответа на вопрос. В качестве дополнительного расширения системы, управляемые мимикрией, могут быть представлены в качестве агентов, которые оптимизируют «целевую функцию» на основе того, насколько близко ИА удается имитировать желаемое поведение. [6] [2] В генеративных состязательных сетях 2010-х годов компонент «кодировщик»/«генератор» пытается имитировать и импровизировать составление человеческого текста. Генератор пытается максимизировать функцию, инкапсулирующую то, насколько хорошо он может обмануть антагонистический компонент «предиктор»/«дискриминатор». [13]

В то время как символические системы ИИ часто принимают явную целевую функцию, парадигма может также применяться к нейронным сетям и эволюционным вычислениям . Обучение с подкреплением может генерировать интеллектуальных агентов, которые, по-видимому, действуют способами, направленными на максимизацию «функции вознаграждения». [14] Иногда, вместо того, чтобы устанавливать функцию вознаграждения так, чтобы она была прямо равна желаемой функции оценки эталона, программисты машинного обучения будут использовать формирование вознаграждения, чтобы изначально давать машине вознаграждения за постепенный прогресс в обучении. [15] Янн Лекун заявил в 2018 году: «Большинство алгоритмов обучения, которые придумали люди, по сути состоят из минимизации некоторой целевой функции». [16] У шахмат AlphaZero была простая целевая функция: каждая победа засчитывалась как +1 очко, а каждое поражение засчитывалось как -1 очко. Целевая функция для беспилотного автомобиля должна была бы быть более сложной. [17] Эволюционные вычисления могут развивать интеллектуальных агентов, которые, по-видимому, действуют способами, направленными на максимизацию «функции приспособленности», которая влияет на то, сколько потомков разрешено оставить каждому агенту. [4]

Математический формализм AIXI был предложен как максимально интеллектуальный агент в этой парадигме. [18] Однако AIXI невычислим . В реальном мире IA ограничен конечным временем и аппаратными ресурсами, и ученые соревнуются в создании алгоритмов, которые могут достигать все более высоких результатов в тестах производительности с существующим оборудованием. [19]

Простую программу агента можно математически определить как функцию f (называемую «функцией агента») [20] , которая сопоставляет каждую возможную последовательность восприятий с возможным действием, которое может выполнить агент, или с коэффициентом, элементом обратной связи, функцией или константой, которая влияет на конечные действия:

Функция агента является абстрактным понятием, поскольку она может включать в себя различные принципы принятия решений, такие как расчет полезности отдельных вариантов, дедукция по логическим правилам, нечеткая логика и т. д. [21]

Вместо этого программный агент сопоставляет каждое возможное восприятие с действием. [22]

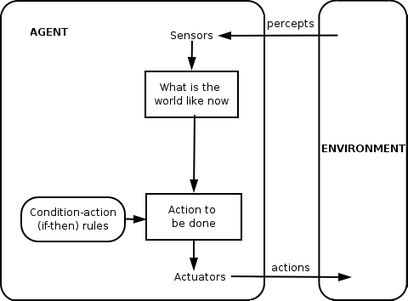

Мы используем термин восприятие для обозначения перцептивных входов агента в любой момент времени. На следующих рисунках агент — это все, что можно рассматривать как воспринимающее свое окружение посредством датчиков и воздействующее на это окружение посредством исполнительных механизмов.

Рассел и Норвиг (2003) группируют агентов в пять классов в зависимости от степени их воспринимаемого интеллекта и способностей: [23]

Простые рефлекторные агенты действуют только на основе текущего восприятия , игнорируя остальную часть истории восприятия. Функция агента основана на правиле условие-действие : «если условие, то действие».

Эта функция агента успешна только тогда, когда окружающая среда полностью наблюдаема. Некоторые агенты рефлекса могут также содержать информацию о своем текущем состоянии, что позволяет им игнорировать условия, исполнительные механизмы которых уже запущены.

Бесконечные циклы часто неизбежны для простых рефлекторных агентов, работающих в частично наблюдаемых средах. Если агент может рандомизировать свои действия, то, возможно, удастся избежать бесконечных циклов.

Агент на основе модели может обрабатывать частично наблюдаемые среды. Его текущее состояние хранится внутри агента, поддерживая некую структуру, описывающую часть мира, которую нельзя увидеть. Это знание о том, «как работает мир», называется моделью мира, отсюда и название «агент на основе модели».

Агент рефлекса на основе модели должен поддерживать некую внутреннюю модель , которая зависит от истории восприятия и, таким образом, отражает по крайней мере некоторые ненаблюдаемые аспекты текущего состояния. История восприятия и влияние действия на окружающую среду могут быть определены с помощью внутренней модели. Затем он выбирает действие таким же образом, как агент рефлекса.

Агент также может использовать модели для описания и прогнозирования поведения других агентов в окружающей среде. [24]

Агенты, основанные на цели, еще больше расширяют возможности агентов, основанных на модели, используя информацию о «цели». Информация о цели описывает желательные ситуации. Это дает агенту возможность выбирать среди множества возможностей, выбирая ту, которая достигает целевого состояния. Поиск и планирование — это подобласти искусственного интеллекта, посвященные поиску последовательностей действий, которые достигают целей агента.

Агенты, основанные на цели, различают только целевые и нецелевые состояния. Также можно определить меру того, насколько желательно определенное состояние. Эту меру можно получить с помощью функции полезности , которая сопоставляет состояние с мерой полезности состояния. Более общая мера производительности должна позволять сравнивать различные состояния мира в соответствии с тем, насколько хорошо они удовлетворяют целям агента. Термин полезность может использоваться для описания того, насколько «счастлив» агент.

Рациональный агент, основанный на полезности, выбирает действие, которое максимизирует ожидаемую полезность результатов действия, то есть то, что агент ожидает получить в среднем, учитывая вероятности и полезности каждого результата. Агент, основанный на полезности, должен моделировать и отслеживать свою среду, задачи, которые включают в себя множество исследований восприятия, представления, рассуждения и обучения.

Обучение имеет преимущество, позволяя агентам изначально работать в неизвестных условиях и становиться более компетентными, чем позволяют их первоначальные знания. Самое важное различие заключается в «элементе обучения», ответственном за внесение улучшений, и «элементе производительности», ответственном за выбор внешних действий.

Элемент обучения использует обратную связь от «критика» о том, как агент действует, и определяет, как элемент производительности, или «актер», должен быть изменен, чтобы действовать лучше в будущем. Элемент производительности, ранее считавшийся всем агентом, принимает восприятия и принимает решения о действиях.

Последний компонент обучающего агента — «генератор проблем». Он отвечает за предложение действий, которые приведут к новому и познавательному опыту.

Вайс (2013) определяет четыре класса агентов:

В 2013 году Александр Висснер-Гросс опубликовал теорию, касающуюся свободы и интеллекта для интеллектуальных агентов. [25] [26]

Интеллектуальные агенты могут быть организованы иерархически в несколько «субагентов». Интеллектуальные субагенты обрабатывают и выполняют функции более низкого уровня. Взятые вместе, интеллектуальный агент и субагенты создают полную систему, которая может выполнять сложные задачи или цели с поведением и реакциями, которые демонстрируют форму интеллекта.

В общем, агент может быть построен путем разделения тела на датчики и приводы, и таким образом, чтобы он работал со сложной системой восприятия, которая принимает описание мира в качестве входных данных для контроллера и выводит команды на привод. Однако иерархия уровней контроллера часто необходима для балансировки немедленной реакции, требуемой для низкоуровневых задач, и медленного рассуждения о сложных, высокоуровневых целях. [27]

«Интеллектуальный агент» также часто используется как неопределенный термин, иногда синоним « виртуального личного помощника ». [28] Некоторые определения 20-го века характеризуют агента как программу, которая помогает пользователю или действует от имени пользователя. [29] Эти примеры известны как программные агенты , и иногда «интеллектуальный программный агент» (то есть программный агент с интеллектом) упоминается как «интеллектуальный агент».

По словам Николы Касабова , системы ИА должны обладать следующими характеристиками: [30]

Халлербах и др. обсудили применение агентных подходов для разработки и проверки автоматизированных систем вождения с помощью цифрового двойника тестируемого транспортного средства и микроскопического моделирования дорожного движения на основе независимых агентов. [31] Waymo создала многоагентную среду моделирования Carcraft для тестирования алгоритмов для беспилотных автомобилей . [32] [33] Она моделирует взаимодействие между водителями-людьми, пешеходами и автоматизированными транспортными средствами. Поведение людей имитируется искусственными агентами на основе данных реального человеческого поведения. Основная идея использования агентного моделирования для понимания беспилотных автомобилей обсуждалась еще в 2003 году. [34]