В байесовской статистике оценка максимальной апостериорной вероятности ( MAP ) — это оценка неизвестной величины, которая равна моде апостериорного распределения . MAP можно использовать для получения точечной оценки ненаблюдаемой величины на основе эмпирических данных. Он тесно связан с методом оценки максимального правдоподобия (ML), но использует расширенную цель оптимизации , которая включает априорное распределение (которое количественно определяет дополнительную информацию, доступную через априорное знание связанного события) по величине, которую требуется оценить. Поэтому оценку MAP можно рассматривать как регуляризацию оценки максимального правдоподобия.

Предположим, что мы хотим оценить ненаблюдаемый параметр популяции на основе наблюдений . Пусть будет распределением выборки , так что есть вероятность того, что базовый параметр популяции равен . Тогда функция:

известна как функция правдоподобия и оценка:

является оценкой максимального правдоподобия .

Теперь предположим, что существует априорное распределение по . Это позволяет нам обращаться со случайной величиной, как в байесовской статистике . Мы можем вычислить апостериорное распределение с помощью теоремы Байеса :

где — функция плотности , — область определения .

Метод максимальной апостериорной оценки затем оценивает моду апостериорного распределения этой случайной величины :

Знаменатель апостериорного распределения (так называемое предельное правдоподобие ) всегда положителен и не зависит от и, следовательно, не играет никакой роли в оптимизации. Обратите внимание, что оценка MAP совпадает с оценкой ML, когда априорная вероятность равномерна (т.е. является постоянной функцией ).

Когда функция потерь имеет вид

При приближении к 0 байесовская оценка приближается к оценщику MAP, при условии, что распределение является квазивогнутым. [1] Однако, как правило, оценщик MAP не является байесовской оценкой, если только он не является дискретным .

Оценки MAP можно рассчитать несколькими способами:

Хотя для оценки MAP требуются только мягкие условия, чтобы она была предельным случаем оценки Байеса (при функции потерь 0–1), [1] она не очень репрезентативна для байесовских методов в целом. Это связано с тем, что оценки MAP являются точечными оценками, тогда как байесовские методы характеризуются использованием распределений для обобщения данных и выведения выводов: таким образом, байесовские методы, как правило, сообщают апостериорное среднее или медиану вместо этого вместе с достоверными интервалами . Это связано как с тем, что эти оценщики оптимальны при квадратичной и линейной ошибке потерь соответственно, которые более репрезентативны для типичных функций потерь , так и с тем, что для непрерывного апостериорного распределения нет функции потерь, которая предполагает, что MAP является оптимальной точечной оценкой. Кроме того, апостериорное распределение часто может не иметь простой аналитической формы: в этом случае распределение можно моделировать с помощью методов Монте-Карло на основе цепей Маркова , в то время как оптимизация для нахождения его моды(-ей) может быть сложной или невозможной. [ необходима цитата ]

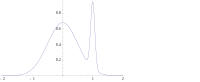

Во многих типах моделей, таких как модели смесей , апостериор может быть многомодальным . В таком случае обычно рекомендуют выбирать наивысшую моду: это не всегда осуществимо ( глобальная оптимизация — сложная проблема), а в некоторых случаях даже возможно (например, когда возникают проблемы с идентификацией ). Более того, наивысшая мода может быть нехарактерной для большинства апостериорных.

Наконец, в отличие от оценщиков ML, оценка MAP не инвариантна при репараметризации. Переключение с одной параметризации на другую подразумевает введение якобиана , который влияет на местоположение максимума. [2]

В качестве примера разницы между байесовскими оценками, упомянутыми выше (средние и медианные оценки), и использованием оценки MAP рассмотрим случай, когда необходимо классифицировать входные данные как положительные или отрицательные (например, кредиты как рискованные или безопасные). Предположим, что есть всего три возможных гипотезы о правильном методе классификации и с апостериорами 0,4, 0,3 и 0,3 соответственно. Предположим, что задан новый экземпляр, , классифицирует его как положительный, тогда как два других классифицируют его как отрицательный. Используя оценку MAP для правильного классификатора , классифицируется как положительный, тогда как байесовские оценки усреднили бы все гипотезы и классифицировали бы как отрицательный.

Предположим, что нам дана последовательность случайных величин IID и априорное распределение задается как . Мы хотим найти оценку MAP для . Обратите внимание, что нормальное распределение является своим собственным сопряженным априорным распределением , поэтому мы сможем найти решение в замкнутой форме аналитически.

Тогда максимизируемая функция определяется как [3]

что эквивалентно минимизации следующей функции :

Таким образом, мы видим, что оценка MAP для μ определяется выражением [3]

что оказывается линейной интерполяцией между априорным средним и выборочным средним, взвешенным по их соответствующим ковариациям.

Случай называется неинформативным априорным и приводит к неправильному распределению вероятностей ; в этом случае