На интернет -сайтах , которые приглашают пользователей оставлять комментарии, модерация контента — это процесс обнаружения материалов, которые являются неуместными, непристойными, незаконными, вредными или оскорбительными, в отличие от полезных или информативных материалов, часто для цензуры или подавления противоположных точек зрения. Цель модерации контента — удалить или применить предупреждающий ярлык к проблемному контенту или позволить пользователям самостоятельно блокировать и фильтровать контент. [1]

Различные типы интернет-сайтов допускают пользовательский контент , например комментарии, включая интернет-форумы , блоги и новостные сайты, работающие на основе таких сценариев, как phpBB , Wiki или PHP-Nuke . и т. д. В зависимости от содержания сайта и целевой аудитории администраторы сайта решают, какие комментарии пользователей подходят, а затем делегируют ответственность за анализ комментариев менее важным модераторам . Чаще всего они пытаются устранить троллинг , спам или флейминг , хотя это сильно варьируется от сайта к сайту.

Основные платформы используют комбинацию алгоритмических инструментов, пользовательских отчетов и человеческого анализа. [1] Сайты социальных сетей могут также нанимать модераторов контента для ручной проверки или удаления контента, помеченного как разжигание ненависти или другого нежелательного контента. Другие проблемы содержания включают порноместь , графический контент , материалы о жестоком обращении с детьми и пропаганду . [1] Некоторые веб-сайты также должны сделать свой контент пригодным для рекламы. [1]

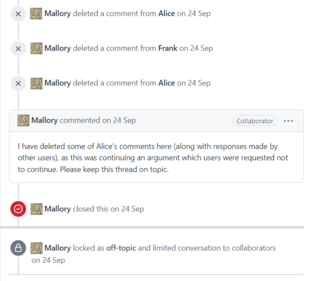

Эту систему модерации, также известную как односторонняя модерация, часто можно увидеть на интернет-форумах . Администраторы сайта выбирают группу людей (обычно на долгосрочной основе) в качестве делегатов, обеспечивающих соблюдение правил сообщества от их имени. Этим модераторам предоставляются особые привилегии удалять или редактировать материалы других людей и/или исключать людей на основании их адреса электронной почты или IP-адреса , и, как правило, они пытаются удалить негативные комментарии во всем сообществе. Они действуют как невидимая опора, поддерживая социальную сеть, выполняя решающую, но недооцененную роль. [2]

По состоянию на 2017 год Facebook увеличил количество модераторов контента с 4500 до 7500 в 2017 году из-за юридических и других разногласий . В Германии Facebook отвечал за удаление высказываний, разжигающих ненависть, в течение 24 часов с момента их публикации. [3] По данным Фрэнсис Хауген , по состоянию на 2021 год количество сотрудников Facebook, ответственных за модерацию контента, было намного меньше. [4]

Если у вас есть новая Страница на Facebook, вы можете управлять следующими настройками модерации:

Сайт социальной сети Twitter имеет политику блокировки . В период с августа 2015 года по декабрь 2017 года оно заблокировало более 1,2 миллиона аккаунтов с террористическим контентом, стремясь сократить количество подписчиков и количество контента, связанного с Исламским государством. [6] После приобретения Twitter Илоном Маском в октябре 2022 года правила содержания на платформе были ослаблены в попытке сделать свободу слова приоритетом. [7] Однако последствия этой кампании были поставлены под сомнение. [8]

Модерация коммерческого контента — это термин, придуманный Сарой Т. Робертс для описания практики «мониторинга и проверки пользовательского контента (UGC) для платформ социальных сетей всех типов, чтобы гарантировать, что контент соответствует правовым и нормативным требованиям». правила сайта/сообщества, пользовательские соглашения и что это соответствует нормам вкуса и приемлемости для этого сайта и его культурного контекста». [9]

Хотя когда-то эта работа могла выполняться добровольцами внутри онлайн-сообщества, для коммерческих веб-сайтов это в основном достигается за счет передачи этой задачи специализированным компаниям, часто в регионах с низкой заработной платой, таких как Индия и Филиппины. Аутсорсинг работ по модерации контента вырос в результате бума социальных сетей . В связи с огромным ростом пользователей и пользовательского контента компаниям потребовалось гораздо больше сотрудников для модерации контента. В конце 1980-х и начале 1990-х технологические компании начали передавать рабочие места в зарубежные страны, которые имели образованную рабочую силу, но были готовы работать за дешевую цену. [10]

По состоянию на 2010 год сотрудники просматривают, оценивают и удаляют тревожный контент. [11] В 2014 году Wired сообщил, что они могут получить психологический ущерб. [12] [13] [14] [2] [15] В 2017 году газета Guardian сообщила, что может возникнуть вторичная травма с симптомами, похожими на посттравматическое стрессовое расстройство . [16] Некоторые крупные компании, такие как Facebook, предлагают психологическую поддержку [16] и все чаще полагаются на использование искусственного интеллекта для сортировки наиболее графического и неприемлемого контента, однако критики утверждают, что этого недостаточно. [17] В 2019 году NPR назвало это опасным для работы. [18]

Facebook решил создать наблюдательный совет, который будет решать, какой контент останется, а какой будет удален. Такая идея была предложена в конце 2018 года. «Верховный суд» в Facebook должен заменить принятие решений на разовой основе. [18]

Распределенная модерация бывает двух типов: пользовательская модерация и спонтанная модерация.

Пользовательская модерация позволяет любому пользователю модерировать вклады других пользователей. Миллиарды людей в настоящее время ежедневно принимают решения о том, чем поделиться, переслать или сделать видимым. [19] На большом сайте с достаточно большим активным населением это обычно работает хорошо, поскольку относительно небольшое количество нарушителей спокойствия отсеивается голосами остального сообщества. Строго говоря, такие вики , как Википедия , являются идеальным средством модерации пользователей, но в контексте интернет-форумов ярким примером системы модерации пользователей является Slashdot . [ нужна цитата ]

Например, каждому модератору дается ограниченное количество «мод-баллов», каждый из которых можно использовать для модерации отдельного комментария вверх или вниз на один балл. Таким образом, комментарии накапливают оценку, которая дополнительно ограничена диапазоном от -1 до 5 баллов. При просмотре сайта можно выбрать пороговое значение из той же шкалы, и будут отображаться только сообщения, соответствующие этому пороговому значению или превышающие его. Эта система дополнительно уточняется концепцией кармы : рейтинги, присвоенные предыдущим вкладам пользователя, могут исказить первоначальный рейтинг вкладов, которые он или она делает.

На достаточно специализированных веб-сайтах модерация пользователей часто приводит к групповому мышлению , при котором любое мнение, противоречащее установленным принципам веб-сайта (независимо от того, насколько оно здравое или хорошо сформулированное), скорее всего, будет «изменено» и подвергнуто цензуре, что приведет к сохранение группового мышления. Это часто путают с троллингом . [ нужна цитата ]

Модерацию пользователей также можно охарактеризовать как реактивную модерацию. Этот тип модерации зависит от пользователей платформы или сайта, сообщающих о неуместном контенте и нарушающем стандарты сообщества . В этом процессе, когда пользователи сталкиваются с изображением или видео, которые они считают неприемлемыми, они могут нажать кнопку «Пожаловаться». Жалоба подана и поставлена в очередь на рассмотрение модераторов. [20]

Спонтанная модерация — это то, что происходит, когда не существует официальной схемы модерации. Не имея возможности модерировать комментарии, пользователи будут спонтанно модерировать своих коллег, публикуя собственные комментарии к комментариям других. Поскольку существует спонтанная модерация, ни одна система, позволяющая пользователям отправлять собственный контент, никогда не может обходиться полностью без какой-либо модерации. [ нужна цитата ]

{{cite web}}: CS1 maint: несколько имен: список авторов ( ссылка )