Надежная статистика — это статистика , которая сохраняет свои свойства, даже если базовые распределительные предположения неверны. Надежные статистические методы были разработаны для многих распространенных проблем, таких как оценка местоположения , масштаба и параметров регрессии . Одной из причин является создание статистических методов , которые не будут чрезмерно затронуты выбросами . Другой причиной является предоставление методов с хорошей производительностью при небольших отклонениях от параметрического распределения . Например, надежные методы хорошо работают для смесей двух нормальных распределений с различными стандартными отклонениями ; в рамках этой модели ненадежные методы, такие как t-тест, работают плохо. [1] [2]

Надежная статистика стремится предоставлять методы, которые имитируют популярные статистические методы, но не подвергаются чрезмерному влиянию выбросов или других небольших отклонений от предположений модели . В статистике классические методы оценки в значительной степени опираются на предположения, которые часто не выполняются на практике. В частности, часто предполагается, что ошибки данных распределены нормально, по крайней мере приблизительно, или что центральная предельная теорема может быть использована для получения нормально распределенных оценок. К сожалению, когда в данных есть выбросы, классические оценщики часто показывают очень плохую производительность, если судить с использованием точки разбивки и функции влияния, описанных ниже.

Практический эффект проблем, наблюдаемых в функции влияния, можно изучить эмпирически, изучив распределение выборки предлагаемых оценщиков в рамках модели смеси , где смешивается небольшое количество (часто достаточно 1–5%) загрязнения. Например, можно использовать смесь 95% нормального распределения и 5% нормального распределения с тем же средним значением, но значительно более высоким стандартным отклонением (представляющим выбросы).

Надежная параметрическая статистика может осуществляться двумя способами:

Надежные оценки были изучены для следующих задач:

Существуют различные определения «робастной статистики ». Строго говоря, робастная статистика устойчива к ошибкам в результатах, вызванным отклонениями от предположений [4] (например, нормальности). Это означает, что если предположения выполняются лишь приблизительно, робастная оценка все равно будет иметь разумную эффективность и разумно малое смещение , а также будет асимптотически несмещенной , то есть иметь смещение, стремящееся к 0, когда размер выборки стремится к бесконечности.

Обычно наиболее важным случаем является распределительная устойчивость — устойчивость к нарушению предположений о базовом распределении данных. [4] Классические статистические процедуры, как правило, чувствительны к «длиннохвостой» (например, когда распределение данных имеет более длинные хвосты, чем предполагаемое нормальное распределение). Это означает, что на них будет сильно влиять наличие выбросов в данных, и оценки, которые они производят, могут быть сильно искажены, если в данных есть экстремальные выбросы, по сравнению с тем, какими они были бы, если бы выбросы не были включены в данные.

Напротив, более надежные оценщики, которые не так чувствительны к дистрибутивным искажениям, таким как длиннохвостость, также устойчивы к присутствию выбросов. Таким образом, в контексте надежной статистики, дистрибутивно надежный и устойчивый к выбросам фактически являются синонимами. [4] Для одного из взглядов на исследования в области надежной статистики до 2000 года см. Portnoy & He (2000).

Некоторые эксперты предпочитают термин «устойчивая статистика » для распределительной устойчивости и резервируют «устойчивость» для нераспределительной устойчивости, например, устойчивости к нарушению предположений о вероятностной модели или оценщике, но это использование меньшинства. Обычное использование просто «устойчивости» в значении «распределительной устойчивости».

При рассмотрении того, насколько устойчива оценка к наличию выбросов, полезно проверить, что произойдет, если в набор данных будет добавлен экстремальный выброс, а также проверить, что произойдет, если экстремальный выброс заменяет одну из существующих точек данных, а затем рассмотреть эффект множественных добавлений или замен.

Среднее значение не является надежной мерой центральной тенденции . Если набор данных, например, содержит значения {2,3,5,6,9}, то если мы добавим к данным еще одну точку данных со значением -1000 или +1000, то полученное среднее значение будет сильно отличаться от среднего значения исходных данных. Аналогично, если мы заменим одно из значений точкой данных со значением -1000 или +1000, то полученное среднее значение будет сильно отличаться от среднего значения исходных данных.

Медиана — это надежная мера центральной тенденции . Если взять тот же набор данных {2,3,5,6,9}, то если мы добавим еще одну точку данных со значением -1000 или +1000, то медиана немного изменится, но она все равно будет похожа на медиану исходных данных. Если мы заменим одно из значений точкой данных со значением -1000 или +1000, то полученная медиана все равно будет похожа на медиану исходных данных.

Если описывать медиану с точки зрения точек разбиения, то медиана имеет точку разбиения 50%, то есть половина точек должна быть выбросами, прежде чем медиану можно будет вывести за пределы диапазона невыбросов, в то время как среднее значение имеет точку разбиения 0, поскольку одно большое наблюдение может ее сбить.

Медианное абсолютное отклонение и межквартильный размах являются надежными мерами статистической дисперсии , тогда как стандартное отклонение и размах таковыми не являются.

Усеченные оценки и оценки Winsorised являются общими методами, позволяющими сделать статистику более надежной. L-оценки представляют собой общий класс простых статистик, часто надежных, в то время как M-оценки представляют собой общий класс надежных статистик и в настоящее время являются предпочтительным решением, хотя их расчет может быть довольно сложным.

Гельман и др. в Байесовском анализе данных (2004) рассматривают набор данных, относящихся к измерениям скорости света, выполненным Саймоном Ньюкомбом . Наборы данных для этой книги можно найти на странице Классические наборы данных , а веб-сайт книги содержит дополнительную информацию о данных.

Хотя основная часть данных выглядит более или менее нормально распределенной, есть два очевидных выброса. Эти выбросы оказывают большое влияние на среднее значение, подтягивая его к себе и отдаляя от центра основной части данных. Таким образом, если среднее значение предназначено как мера местоположения центра данных, оно, в некотором смысле, смещено, когда присутствуют выбросы.

Также известно, что распределение среднего значения асимптотически нормально из-за центральной предельной теоремы. Однако выбросы могут сделать распределение среднего значения ненормальным даже для довольно больших наборов данных. Помимо этой ненормальности, среднее значение также неэффективно при наличии выбросов, и доступны менее изменчивые меры местоположения.

На графике ниже показан график плотности данных скорости света вместе с графиком ковров (панель (a)). Также показан обычный график Q–Q (панель (b)). На этих графиках видны выбросы.

Панели (c) и (d) графика показывают распределение бутстрепа среднего (c) и 10% усеченного среднего (d). Усеченное среднее — это простая, надежная оценка местоположения, которая удаляет определенный процент наблюдений (здесь 10%) с каждого конца данных, а затем вычисляет среднее обычным способом. Анализ был выполнен в R , и для каждого из необработанных и усеченных средних использовалось 10 000 выборок бутстрепа .

Распределение среднего значения явно намного шире, чем у 10% усеченного среднего (графики в том же масштабе). Кроме того, в то время как распределение усеченного среднего кажется близким к нормальному, распределение необработанного среднего значения довольно сильно смещено влево. Таким образом, в этой выборке из 66 наблюдений только 2 выброса приводят к неприменимости центральной предельной теоремы.

Надежные статистические методы, простым примером которых является усеченное среднее, стремятся превзойти классические статистические методы при наличии выбросов или, в более общем плане, когда базовые параметрические предположения не совсем верны.

Хотя усеченное среднее хорошо работает относительно среднего в этом примере, доступны более надежные оценки. Фактически, среднее, медиана и усеченное среднее являются частными случаями M-оценщиков . Подробности приведены в разделах ниже.

Выбросы в данных о скорости света оказывают не только отрицательное влияние на среднее значение; обычной оценкой масштаба является стандартное отклонение, и эта величина еще сильнее подвержена влиянию выбросов, поскольку в расчеты включаются квадраты отклонений от среднего значения, поэтому влияние выбросов усугубляется.

Графики ниже показывают распределение бутстрапа стандартного отклонения, медианного абсолютного отклонения (MAD) и оценки масштаба Руссеу-Кру (Qn). [5] Графики основаны на 10 000 выборках бутстрапа для каждой оценки с некоторым гауссовым шумом, добавленным к повторно выбранным данным ( сглаженный бутстрап ). Панель (a) показывает распределение стандартного отклонения, (b) MAD и (c) Qn.

Распределение стандартного отклонения неустойчиво и широко из-за выбросов. MAD ведет себя лучше, а Qn немного эффективнее MAD. Этот простой пример показывает, что при наличии выбросов стандартное отклонение не может быть рекомендовано в качестве оценки масштаба.

Традиционно статистики вручную проверяли данные на наличие выбросов и удаляли их, обычно проверяя источник данных, чтобы увидеть, были ли выбросы ошибочно зарегистрированы. Действительно, в приведенном выше примере со скоростью света легко увидеть и удалить два выброса, прежде чем приступать к дальнейшему анализу. Однако в наше время наборы данных часто состоят из большого количества переменных, измеряемых на большом количестве экспериментальных единиц. Поэтому ручной скрининг на наличие выбросов часто нецелесообразен.

Выбросы часто могут взаимодействовать таким образом, что они маскируют друг друга. В качестве простого примера рассмотрим небольшой одномерный набор данных, содержащий один скромный и один большой выброс. Оценочное стандартное отклонение будет сильно завышено большим выбросом. В результате скромный выброс выглядит относительно нормальным. Как только большой выброс удаляется, оцененное стандартное отклонение уменьшается, и скромный выброс теперь выглядит необычно.

Эта проблема маскировки усугубляется по мере увеличения сложности данных. Например, в задачах регрессии диагностические графики используются для выявления выбросов. Однако часто бывает так, что после удаления нескольких выбросов другие становятся видимыми. Проблема становится еще хуже в более высоких измерениях.

Надежные методы обеспечивают автоматические способы обнаружения, снижения веса (или удаления) и маркировки выбросов, в значительной степени устраняя необходимость в ручном скрининге. Необходимо соблюдать осторожность; первоначальные данные, показывающие, что озоновая дыра впервые появилась над Антарктидой, были отклонены как выбросы нечеловеческим скринингом. [6]

Хотя в данной статье рассматриваются общие принципы одномерных статистических методов, существуют также надежные методы для задач регрессии, обобщенных линейных моделей и оценки параметров различных распределений.

Основными инструментами, используемыми для описания и измерения надежности, являются точка пробоя , функция влияния и кривая чувствительности .

Интуитивно, точка сбоя оценщика — это доля неверных наблюдений (например, произвольно больших наблюдений), которую оценщик может обработать, прежде чем выдать неверный (например, произвольно большой) результат. Обычно в качестве точки сбоя указывается асимптотический (бесконечный выборочный) предел, хотя точка сбоя для конечной выборки может быть более полезной. [7] Например, при наличии независимых случайных величин и соответствующих реализаций мы можем использовать для оценки среднего значения. Такой оценщик имеет точку сбоя 0 (или точку сбоя для конечной выборки ), поскольку мы можем сделать сколь угодно большим, просто изменив любой из .

Чем выше точка сбоя оценки, тем она надежнее. Интуитивно мы можем понять, что точка сбоя не может превышать 50%, потому что если более половины наблюдений загрязнены, невозможно отличить базовое распределение от загрязняющего распределения Rousseeuw & Leroy (1987). Следовательно, максимальная точка сбоя составляет 0,5, и существуют оценки, которые достигают такой точки сбоя. Например, медиана имеет точку сбоя 0,5. X% усеченное среднее имеет точку сбоя X% для выбранного уровня X. Huber (1981) и Maronna et al. (2019) содержат больше подробностей. Уровень и точки сбоя мощности тестов исследуются в He, Simpson & Portnoy (1990).

Статистику с высокими точками разрыва иногда называют резистентной статистикой. [8]

В примере со скоростью света удаление двух самых низких наблюдений приводит к изменению среднего значения с 26,2 до 27,75, изменение на 1,55. Оценка масштаба, полученная методом Qn, составляет 6,3. Мы можем разделить это на квадратный корень размера выборки, чтобы получить надежную стандартную ошибку, и мы находим, что эта величина равна 0,78. Таким образом, изменение среднего значения в результате удаления двух выбросов примерно вдвое превышает надежную стандартную ошибку.

10% усеченное среднее для данных скорости света составляет 27,43. Удаление двух самых низких наблюдений и пересчет дает 27,67. Усеченное среднее меньше подвержено влиянию выбросов и имеет более высокую точку разбивки.

Если мы заменим наименьшее наблюдение, −44, на −1000, среднее станет 11,73, тогда как 10% усеченное среднее все еще будет 27,43. Во многих областях прикладной статистики данные обычно логарифмически преобразуются, чтобы сделать их почти симметричными. Очень маленькие значения становятся большими отрицательными при логарифмическом преобразовании, а нули становятся отрицательно бесконечными. Поэтому этот пример представляет практический интерес.

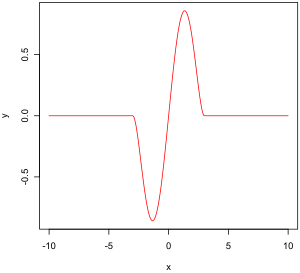

Эмпирическая функция влияния — это мера зависимости оценщика от значения любой из точек в выборке. Это модельно-свободная мера в том смысле, что она просто полагается на повторное вычисление оценщика с другим образцом. Справа — двухвесовая функция Тьюки, которая, как мы увидим позже, является примером того, как должна выглядеть «хорошая» (в определенном позже смысле) эмпирическая функция влияния.

В математических терминах функция влияния определяется как вектор в пространстве оценщика, который, в свою очередь, определяется для выборки, которая является подмножеством совокупности:

Например,

Эмпирическая функция влияния определяется следующим образом.

Пусть и являются iid и — выборка из этих переменных. — оценщик. Пусть . Эмпирическая функция влияния при наблюдении определяется как:

Это означает, что мы заменяем i -е значение в выборке произвольным значением и смотрим на выход оценщика. В качестве альтернативы EIF определяется как эффект, масштабированный на n+1 вместо n, на оценщике добавления точки к выборке. [ необходима цитата ]

Вместо того, чтобы полагаться исключительно на данные, мы могли бы использовать распределение случайных величин. Этот подход сильно отличается от подхода предыдущего параграфа. Сейчас мы пытаемся увидеть, что происходит с оценщиком, когда мы немного меняем распределение данных: он предполагает распределение и измеряет чувствительность к изменению этого распределения. Напротив, эмпирическое влияние предполагает выборочный набор и измеряет чувствительность к изменению выборок. [9]

Пусть будет выпуклым подмножеством множества всех конечных знаковых мер на . Мы хотим оценить параметр распределения в . Пусть функционал будет асимптотическим значением некоторой последовательности оценки . Мы предположим, что этот функционал является согласованным по Фишеру , т.е. . Это означает, что в модели последовательность оценки асимптотически измеряет правильную величину.

Пусть будет некоторое распределение в . Что происходит, когда данные не следуют точно модели, а немного отличаются, «идут в направлении» ?

Мы рассматриваем:

которая является односторонней производной Гато от в направлении .

Пусть . — вероятностная мера, которая дает массу 1 для . Мы выбираем . Тогда функция влияния определяется как:

Он описывает влияние бесконечно малого загрязнения в точке на искомую нами оценку, стандартизированную по массе загрязнения (асимптотическое смещение, вызванное загрязнением в наблюдениях). Для надежной оценки нам нужна ограниченная функция влияния, то есть такая, которая не стремится к бесконечности, когда x становится произвольно большим.

Эмпирическая функция влияния использует эмпирическую функцию распределения вместо функции распределения , применяя принцип падения.

Свойства функции влияния, которые придают ей желаемую эффективность, следующие:

Это значение, которое очень похоже на константу Липшица , представляет собой эффект небольшого смещения наблюдения из в соседнюю точку , т. е. добавления наблюдения в и удаления наблюдения в .

(Математический контекст этого параграфа приведен в разделе об эмпирических функциях влияния.)

Исторически было предложено несколько подходов к надежной оценке, включая R-оценки и L-оценки . Однако M-оценки сейчас, по-видимому, доминируют в этой области из-за их общности, их потенциала для высоких точек пробоя и сравнительно высокой эффективности. См. Huber (1981).

M-оценщики не являются изначально надежными. Однако их можно спроектировать так, чтобы они достигали благоприятных свойств, включая надежность. M-оценщики являются обобщением оценок максимального правдоподобия (MLE), которые определяются путем максимизации или, что эквивалентно, минимизации . В 1964 году Хубер предложил обобщить это до минимизации , где — некоторая функция. MLE, таким образом, являются особым случаем M-оценщиков (отсюда и название: оценки « типа максимального правдоподобия»).

Минимизацию часто можно осуществить путем дифференцирования и решения , где (если имеет производную).

Было предложено несколько вариантов и . На двух рисунках ниже показаны четыре функции и соответствующие им функции.

Для квадратичных ошибок увеличивается с ускоряющейся скоростью, в то время как для абсолютных ошибок увеличивается с постоянной скоростью. При использовании Winsorizing вводится смесь этих двух эффектов: для малых значений x увеличивается с квадратичной скоростью, но как только достигается выбранный порог (1,5 в этом примере), скорость увеличения становится постоянной. Эта оценка Winsorised также известна как функция потерь Хьюбера .

Функция биквадрата Тьюки (также известная как биквадратная) поначалу ведет себя аналогично функции квадратичной ошибки, но при больших ошибках функция сужается.

M-оценщики не обязательно связаны с функцией плотности вероятности. Поэтому готовые подходы к выводу, вытекающие из теории правдоподобия, в общем случае не могут быть использованы.

Можно показать, что М-оценки распределены асимптотически нормально, так что пока можно вычислить их стандартные ошибки, доступен приближенный подход к выводу.

Поскольку M-оценки нормальны только асимптотически, для небольших размеров выборки может быть целесообразно использовать альтернативный подход к выводу, такой как бутстрап. Однако M-оценки не обязательно уникальны (т. е. может быть более одного решения, удовлетворяющего уравнениям). Кроме того, возможно, что любая конкретная выборка бутстрапа может содержать больше выбросов, чем точка разбивки оценщика. Поэтому при проектировании схем бутстрапа требуется некоторая осторожность.

Конечно, как мы видели на примере скорости света, среднее значение распределено только нормально асимптотически, и когда присутствуют выбросы, приближение может быть очень плохим даже для довольно больших выборок. Однако классические статистические тесты, включая те, которые основаны на среднем значении, обычно ограничены сверху номинальным размером теста. Этого нельзя сказать о M-оценщиках, и частота ошибок типа I может быть существенно выше номинального уровня.

Эти соображения никоим образом не «аннулируют» M-оценку. Они просто дают понять, что при их использовании требуется определенная осторожность, как и при использовании любого другого метода оценки.

Можно показать, что функция влияния М-оценщика пропорциональна , [10] что означает, что мы можем вывести свойства такого оценщика (такие как его точка отклонения, чувствительность к грубой ошибке или чувствительность к локальному сдвигу), когда мы знаем его функцию.

с заданным:

Во многих практических ситуациях выбор функции не имеет решающего значения для получения хорошей надежной оценки, и многие варианты дадут схожие результаты, которые обеспечивают значительные улучшения с точки зрения эффективности и смещения по сравнению с классическими оценками при наличии выбросов. [11]

Теоретически, функции должны быть предпочтительными, [ необходимо разъяснение ] и функция двухвесового распределения Тьюки (также известная как биквадратная) является популярным выбором. [12] рекомендуют функцию двухвесового распределения с эффективностью в нормальном режиме, установленной на уровне 85%.

M-оценщики не обязательно связаны с функцией плотности и поэтому не являются полностью параметрическими. Полностью параметрические подходы к надежному моделированию и выводу, как байесовский, так и вероятностный подходы, обычно имеют дело с распределениями с тяжелыми хвостами, такими как t -распределение Стьюдента .

Для t -распределения со степенями свободы можно показать, что

Для t - распределение эквивалентно распределению Коши. Степени свободы иногда называют параметром эксцесса . Это параметр, который контролирует, насколько тяжелы хвосты. В принципе, может быть оценен по данным так же, как и любой другой параметр. На практике обычно бывает несколько локальных максимумов, когда допускается варьирование. Таким образом, обычно фиксируют значение около 4 или 6. На рисунке ниже показана -функция для 4 различных значений .

Для данных о скорости света, допуская изменение параметра эксцесса и максимизируя правдоподобие, получаем

Фиксация и максимизация вероятности дает

Основная величина — это функция данных, чье базовое распределение популяции является членом параметрического семейства, которое не зависит от значений параметров. Вспомогательная статистика — это такая функция, которая также является статистикой, то есть она вычисляется только на основе данных. Такие функции устойчивы к параметрам в том смысле, что они независимы от значений параметров, но не устойчивы к модели в том смысле, что они предполагают базовую модель (параметрическое семейство), и на самом деле такие функции часто очень чувствительны к нарушениям предположений модели. Таким образом, тестовые статистики , часто построенные в терминах этих, чтобы не быть чувствительными к предположениям о параметрах, все еще очень чувствительны к предположениям модели.

Замена пропущенных данных называется вменением . Если пропущенных точек относительно немного, есть некоторые модели, которые можно использовать для оценки значений для завершения ряда, например, замена пропущенных значений средним или медианой данных. Простая линейная регрессия также может использоваться для оценки пропущенных значений. [13] Кроме того, выбросы иногда могут быть размещены в данных с помощью усеченных средних, других оценщиков шкалы, помимо стандартного отклонения (например, MAD) и винсоризации. [14] При расчетах усеченного среднего фиксированный процент данных отбрасывается с каждого конца упорядоченных данных, тем самым устраняя выбросы. Затем среднее значение вычисляется с использованием оставшихся данных. винсоризация подразумевает размещение выброса путем замены его следующим наибольшим или наименьшим значением в зависимости от ситуации. [15]

Однако использование этих типов моделей для прогнозирования пропущенных значений или выбросов в длинных временных рядах является сложным и часто ненадежным, особенно если количество значений, которые необходимо заполнить, относительно велико по сравнению с общей длиной записи. Точность оценки зависит от того, насколько хороша и репрезентативна модель и насколько длителен период пропущенных значений. [16] Когда в ряду предполагается динамическая эволюция, проблема пропущенных точек данных становится упражнением в многомерном анализе (а не одномерном подходе большинства традиционных методов оценки пропущенных значений и выбросов). В таких случаях многомерная модель будет более репрезентативной, чем одномерная, для прогнозирования пропущенных значений. Самоорганизующаяся карта Кохонена (KSOM) предлагает простую и надежную многомерную модель для анализа данных, тем самым предоставляя хорошие возможности для оценки пропущенных значений, принимая во внимание их связь или корреляцию с другими соответствующими переменными в записи данных. [15]

Стандартные фильтры Калмана неустойчивы к выбросам. С этой целью Тинг, Теодору и Шааль (2007) недавно показали, что модификация теоремы Масрелье может справиться с выбросами.

Один из распространенных подходов к обработке выбросов в анализе данных заключается в том, чтобы сначала выполнить обнаружение выбросов, а затем применить эффективный метод оценки (например, наименьшие квадраты). Хотя этот подход часто полезен, следует помнить о двух проблемах. Во-первых, метод обнаружения выбросов, который опирается на ненадежную начальную подгонку, может страдать от эффекта маскировки, то есть группа выбросов может маскировать друг друга и избегать обнаружения. [17] Во-вторых, если для обнаружения выбросов используется начальная подгонка с высокой степенью разбивки, последующий анализ может унаследовать некоторые неэффективности начальной оценки. [18]

Хотя функции влияния имеют долгую историю в статистике, они не получили широкого распространения в машинном обучении из-за ряда проблем. Одним из основных препятствий является то, что традиционные функции влияния опираются на дорогостоящие вычисления производных второго порядка и предполагают дифференцируемость и выпуклость модели. Эти предположения являются ограничивающими, особенно в современном машинном обучении, где модели часто недифференцируемы, невыпуклы и работают в многомерных пространствах.

Кох и Лян (2017) решили эти проблемы, представив методы для эффективной аппроксимации функций влияния с использованием методов оптимизации второго порядка, таких как разработанные Перлмуттером (1994), Мартенсом (2010) и Агарвалом, Буллинзом и Хазаном (2017). Их подход остается эффективным даже при ухудшении предположений о дифференцируемости и выпуклости, что позволяет использовать функции влияния в контексте невыпуклых моделей глубокого обучения. Они продемонстрировали, что функции влияния являются мощным и универсальным инструментом, который можно применять для решения различных задач в машинном обучении, включая:

Вклад Коха и Ляна открыл двери для использования функций влияния в различных приложениях машинного обучения — от интерпретируемости до безопасности, что является значительным шагом вперед в их применимости.