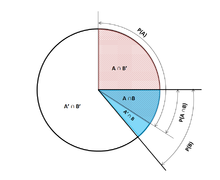

В теории вероятностей условная вероятность — это мера вероятности возникновения события при условии, что уже известно, что другое событие (по предположению, презумпции, утверждению или свидетельству) произошло. [1] Этот конкретный метод основан на том, что событие A происходит в некоторой связи с другим событием B. В этой ситуации событие A можно проанализировать с помощью условной вероятности относительно B. Если интересующее событие — это A, а событие Известно или предполагается, что событие B произошло, «условная вероятность A при условии B » или «вероятность A при условии B » обычно записывается как P( A | B ) [2] или иногда P B ( A ) . Это также можно понимать как долю вероятности B, которая пересекается с A, или отношение вероятностей того, что произойдет оба события, к случаю «данного» события (сколько раз происходит A, а не не предполагается, что B произошло): . [3]

Например, вероятность того, что у какого-либо человека в любой день будет кашель, может составлять всего 5%. Но если мы знаем или предполагаем, что человек болен, то вероятность того, что он будет кашлять, гораздо выше. Например, условная вероятность того, что кто-то нездоров (больной) кашляет, может составлять 75%, и в этом случае мы будем иметь P(Кашель) = 5% и P(Кашель | Больной) = 75%. Хотя в этом примере существует связь между A и B , такая связь или зависимость между A и B не является обязательной, и они не должны возникать одновременно.

P( A | B ) может быть равным или не равным P( A ) , т. е. безусловной вероятности или абсолютной вероятности A . Если P( A | B ) = P( A ) , то события A и B называются независимыми : в таком случае знание о любом событии не меняет вероятность друг друга. P( A | B ) (условная вероятность A при условии B ) обычно отличается от P( B | A ) . Например, если у человека лихорадка денге , вероятность того, что у него будет положительный результат теста на это заболевание, может составлять 90%. В этом случае измеряется то, что если событие B ( заболевание лихорадкой денге ) произошло, вероятность события A ( проверенного как положительное ) при условии, что произошло событие B , составляет 90%, просто записывая P( A | B ) = 90%. С другой стороны, если у человека положительный результат теста на лихорадку денге, у него может быть только 15% вероятность того, что он действительно заболеет этим редким заболеванием из-за высокого уровня ложноположительных результатов. В этом случае вероятность события B ( заболевание лихорадкой денге ) при условии, что событие A ( положительный результат теста ) произошло, составляет 15% или P( B | A ) = 15%. Теперь должно быть очевидно, что ошибочное приравнивание двух вероятностей может привести к различным ошибкам в рассуждениях, что обычно проявляется в ошибках базовой ставки .

Хотя условные вероятности могут предоставить чрезвычайно полезную информацию, часто предоставляется или находится под рукой ограниченная информация. Поэтому может быть полезно обратить вспять или преобразовать условную вероятность с помощью теоремы Байеса : . [4] Другой вариант — отобразить условные вероятности в таблице условной вероятности , чтобы пролить свет на взаимосвязь между событиями.

Учитывая два события A и B из сигма-поля вероятностного пространства, при этом безусловная вероятность B больше нуля (т. е. P( B ) > 0) , условная вероятность A при условии B ( ) является вероятностью Происшествие , если событие B произошло или предполагается, что произошло. [5] Предполагается, что A представляет собой набор всех возможных результатов эксперимента или случайного исследования с ограниченным или сокращенным пространством выборки. Условную вероятность можно найти как частное вероятности совместного пересечения событий A и B ( ) — вероятности того, что A и B произойдут вместе, хотя и не обязательно происходят одновременно, — и вероятности B : [ 2] [6] [7]

Для выборочного пространства, состоящего из исходов с равной вероятностью, вероятность события А понимается как доля числа исходов в А к числу всех исходов в выборочном пространстве. Тогда под этим уравнением понимается доля множества по отношению к множеству B . Обратите внимание, что приведенное выше уравнение является определением, а не просто теоретическим результатом. Обозначим величину как и назовем ее «условной вероятностью А при условии В ».

Некоторые авторы, например де Финетти , предпочитают вводить условную вероятность как аксиому вероятности :

Это уравнение для условной вероятности, хотя оно и эквивалентно математически, интуитивно может быть проще для понимания. Его можно интерпретировать как «вероятность возникновения B , умноженная на вероятность возникновения A , при условии, что B произошло, равна вероятности возникновения A и B вместе, хотя и не обязательно произойдет в одно и то же время». Кроме того, это может быть предпочтительным с философской точки зрения; Согласно основным интерпретациям вероятности , таким как субъективная теория , условная вероятность считается примитивной сущностью. Более того, это «правило умножения» может быть практически полезным при вычислении вероятности и вводит симметрию с аксиомой суммирования для формулы Пуанкаре:

Условную вероятность можно определить как вероятность условного события . Условное событие Гудмана -Нгуена-Ван Фраассена можно определить как:

Можно показать, что

что соответствует определению условной вероятности Колмогорова. [9]

Если , то по определению не определено .

Наибольший интерес представляет случай случайной величины Y , обусловленной непрерывной случайной величиной X , приводящей к определенному результату x . Событие имеет нулевую вероятность и, как таковое, не может быть обусловлено.

Вместо того, чтобы обуславливать X равным именно x , мы могли бы поставить условие, чтобы оно было ближе, чем расстояние от x . Событие обычно имеет ненулевую вероятность и, следовательно, может быть обусловлено. Тогда мы можем взять предел

Например, если две непрерывные случайные величины X и Y имеют совместную плотность , то по правилу Лопиталя и интегральному правилу Лейбница при дифференцировании по :

Результирующий предел представляет собой условное распределение вероятностей Y при заданном X и существует, когда знаменатель, плотность вероятности , строго положителен.

Соблазнительно определить неопределенную вероятность, используя этот предел, но это невозможно сделать последовательным образом. В частности, можно найти случайные величины X и W и значения x , w такие, что события и являются идентичными, но результирующие пределы не являются: [10]

Парадокс Бореля -Колмогорова демонстрирует это с помощью геометрического аргумента.

Пусть X — дискретная случайная величина, а ее возможные результаты обозначаются V. Например, если X представляет ценность брошенного игрального кубика, то V — это множество . Предположим для наглядности, что X — дискретная случайная величина, так что каждое значение в V имеет ненулевую вероятность.

Для значения x в V и события A условная вероятность определяется выражением . Письмо

короче, мы видим , что это функция двух переменных: x и A.

Для фиксированного A мы можем сформировать случайную величину . Он представляет собой результат всякий раз, когда наблюдается значение x из X.

Таким образом, условную вероятность A при данном X можно рассматривать как случайную величину Y с результатами в интервале . По закону полной вероятности его ожидаемое значение равно безусловной вероятности А.

Частичная условная вероятность — это вероятность события при условии, что каждое из событий-условий произошло в степени (степени убеждения, степени опыта), которая может отличаться от 100%. С точки зрения частотности, частичная условная вероятность имеет смысл, если условия проверяются в повторениях эксперимента соответствующей длины . [11] Такую -ограниченную частичную условную вероятность можно определить как условно ожидаемое среднее возникновение события на испытательных стендах такой длины , которая соответствует всем спецификациям вероятности , т.е.:

Исходя из этого, частичную условную вероятность можно определить как

где [11]

Кондиционализация Джеффри [12] [13] представляет собой частный случай частичной условной вероятности, в которой события условия должны образовывать раздел :

Предположим, что кто-то тайно бросает два справедливых шестигранных кубика , и мы хотим вычислить вероятность того, что выпавшее на лицевой стороне первое из них будет равно 2, учитывая информацию о том, что их сумма не превышает 5.

Вероятность того, что D 1 = 2

В таблице 1 показано выборочное пространство из 36 комбинаций выпавших значений двух игральных костей, каждая из которых встречается с вероятностью 1/36, при этом числа, отображаемые в красных и темно-серых ячейках, равны D 1 + D 2 .

D 1 = 2 ровно в 6 из 36 исходов; таким образом P ( D 1 = 2) = 6 ⁄ 36 = 1 ⁄ 6 :

Вероятность того, что D 1 + D 2 ≤ 5

Таблица 2 показывает, что D 1 + D 2 ≤ 5 ровно для 10 из 36 исходов, таким образом, P ( D 1 + D 2 ≤ 5) = 10 ⁄ 36 :

Вероятность того, что D 1 = 2 при условии, что D 1 + D 2 ≤ 5

Таблица 3 показывает, что для 3 из этих 10 исходов D 1 = 2.

Таким образом, условная вероятность P( D 1 = 2 | D 1 + D 2 ≤ 5) = 3 ⁄ 10 = 0,3:

Здесь, в более ранних обозначениях определения условной вероятности, обуславливающее событие B — это D 1 + D 2 ≤ 5, а событие A — это D 1 = 2. Мы имеем то, что видно из таблицы.

В статистическом выводе условная вероятность — это обновление вероятности события на основе новой информации. [14] Новая информация может быть включена следующим образом: [1]

В результате этого подхода получается вероятностная мера, согласующаяся с исходной вероятностной мерой и удовлетворяющая всем аксиомам Колмогорова . Эта условная вероятностная мера также могла бы возникнуть в результате предположения, что относительная величина вероятности A по отношению к X будет сохранена по отношению к B (см. Формальный вывод ниже).

Слова «доказательства» или «информация» обычно используются в байесовской интерпретации вероятности . Обусловливающее событие интерпретируется как свидетельство обусловленного события. То есть P ( A ) — это вероятность A до учета свидетельства E , а P ( A | E ) — это вероятность A после учета свидетельств E или после обновления P ( A ). Это согласуется с частотной интерпретацией, которая является первым определением, данным выше.

При передаче кода Морзе существует определенная вероятность того, что полученная «точка» или «тире» окажется ошибочной. Это часто воспринимается как вмешательство в передачу сообщения. Поэтому важно при отправке «точки» учитывать, например, вероятность того, что «точка» была получена. Это представлено следующим образом: В коде Морзе соотношение точек и тире в момент отправки составляет 3:4, поэтому вероятность появления «точки» и «тире» равна . Если предположить, что вероятность того, что точка будет передана как тире, равна 1/10, а вероятность того, что тире будет передана как точка, также равна 1/10, то для расчета можно использовать правило Байеса .

Теперь можно посчитать:

[15]

События A и B считаются статистически независимыми , если вероятность пересечения A и B равна произведению вероятностей A и B:

Если P ( B ) не равно нулю, то это эквивалентно утверждению, что

Аналогично, если P ( A ) не равно нулю, то

также эквивалентно. Хотя производные формы могут показаться более интуитивными, они не являются предпочтительным определением, поскольку условные вероятности могут быть неопределенными, а предпочтительное определение симметрично относительно A и B. Независимость не относится к непересекающемуся событию. [16]

Следует также отметить, что для пары независимых событий [AB] и события C пара определяется как условно независимая , если произведение истинно: [17]

Эта теорема может быть полезна в приложениях, где наблюдается множество независимых событий.

Независимые события против взаимоисключающих событий

Понятия взаимонезависимых событий и взаимоисключающих событий являются отдельными и различными. В следующей таблице сравниваются результаты для двух случаев (при условии, что вероятность события кондиционирования не равна нулю).

В действительности взаимоисключающие события не могут быть статистически независимыми (если только оба они невозможны), поскольку знание о том, что одно происходит, дает информацию о другом (в частности, о том, что последнее заведомо не произойдет).

В общем случае нельзя предполагать, что P ( A | B ) ≈ P ( B | A ). Это может быть коварной ошибкой даже для тех, кто хорошо знаком со статистикой. [18] Связь между P ( A | B ) и P ( B | A ) определяется теоремой Байеса :

То есть P( A | B ) ≈ P( B | A ) только в том случае, если P ( B )/ P ( A ) ≈ 1 или, что то же самое, P ( A ) ≈ P ( B ).

В общем случае нельзя предполагать, что P ( A ) ≈ P ( A | B ). Эти вероятности связаны законом полной вероятности :

где события образуют счетный раздел .

Эта ошибка может возникнуть из-за предвзятости отбора . [19] Например, в контексте медицинского заявления, пусть SC будет событием, когда последствие (хроническое заболевание) S возникает как следствие обстоятельства (острое состояние ) C. Пусть H — событие обращения человека за медицинской помощью. Предположим, что в большинстве случаев C не вызывает S (так что P ( SC ) низкое). Предположим также , что за медицинской помощью обращаются только в том случае, если S произошло из-за C. Поэтому, исходя из опыта пациентов, врач может ошибочно заключить, что P ( SC ) высокое. Фактическая вероятность , наблюдаемая врачом, равна P ( SC | H ).

Частичный или полный отказ от учета априорной вероятности называется пренебрежением базовой ставкой . Обратная ситуация – недостаточная корректировка априорной вероятности – это консерватизм .

Формально P ( A | B ) определяется как вероятность A в соответствии с новой функцией вероятности в выборочном пространстве, такая, что результаты, не входящие в B , имеют вероятность 0 и согласуются со всеми исходными вероятностными мерами . [20] [21]

Пусть Ω — дискретное выборочное пространство с элементарными событиями { ω }, и пусть P — вероятностная мера относительно σ-алгебры Ω. Предположим, нам сообщили, что событие B ⊆ Ω произошло. Чтобы отразить это, новое распределение вероятностей (обозначенное условным обозначением) должно быть назначено { ω }. Все события, которых нет в B, будут иметь нулевую вероятность в новом распределении. Для событий в B должны соблюдаться два условия: вероятность B равна единице и относительные величины вероятностей должны сохраняться. Первое требуется аксиомами вероятности , а последнее проистекает из того факта, что новая вероятностная мера должна быть аналогом P , в котором вероятность B равна единице - и поэтому каждое событие, которое не находится в B , имеет нулевая вероятность. Следовательно, для некоторого масштабного коэффициента α новое распределение должно удовлетворять:

Подставляя 1 и 2 в 3, чтобы выбрать α :

Итак , новое распределение вероятностей

Теперь об общем событии А :