Тест Тьюринга , первоначально названный Аланом Тьюрингом в 1949 году имитационной игрой , [2] является тестом способности машины демонстрировать интеллектуальное поведение , эквивалентное или неотличимое от поведения человека. Тьюринг предложил, чтобы человек-оценщик оценивал разговоры на естественном языке между человеком и машиной, разработанной для генерации ответов, подобных человеческим. Оценщик будет знать, что один из двух собеседников — машина, и все участники будут отделены друг от друга. Разговор будет ограничен только текстовым каналом, таким как клавиатура и экран компьютера, поэтому результат не будет зависеть от способности машины воспроизводить слова в виде речи. [3] Если оценщик не сможет надежно отличить машину от человека, то будет сказано, что машина прошла тест. Результаты теста не будут зависеть от способности машины давать правильные ответы на вопросы , а только от того, насколько близко ее ответы будут напоминать ответы человека. Поскольку тест Тьюринга является тестом на неразличимость производительности, его вербальная версия естественным образом обобщается на все производительные способности человека, как вербальные, так и невербальные (роботизированные). [4]

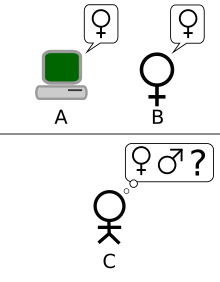

Тест был введен Тьюрингом в его статье 1950 года « Вычислительная техника и интеллект », когда он работал в Манчестерском университете . [5] Она начинается словами: «Я предлагаю рассмотреть вопрос: «Могут ли машины мыслить? » Поскольку «мышление» трудно определить, Тьюринг решает «заменить этот вопрос другим, который тесно связан с ним и выражается относительно недвусмысленными словами». [6] Тьюринг описывает новую форму проблемы в терминах игры для трех человек, называемой «имитационной игрой», в которой следователь задает вопросы мужчине и женщине в другой комнате, чтобы определить правильный пол двух игроков. Новый вопрос Тьюринга звучит так: «Существуют ли вообразимые цифровые компьютеры, которые хорошо справились бы с имитационной игрой ?» [2] Тьюринг считал, что на этот вопрос можно было бы ответить. В оставшейся части статьи он выступил против всех основных возражений против предложения о том, что «машины могут мыслить». [7]

С тех пор как Тьюринг представил свой тест, он был одновременно и очень влиятельным, и широко критиковался, и стал важной концепцией в философии искусственного интеллекта . [8] [9] [10] Философ Джон Сирл прокомментировал тест Тьюринга в своем аргументе о китайской комнате , мысленном эксперименте, который гласит, что машина не может иметь « разум », « понимание » или « сознание », независимо от того, насколько разумно или по-человечески программа может заставить компьютер вести себя. Сирл критикует тест Тьюринга и утверждает, что он недостаточен для обнаружения наличия сознания.

Тест Тьюринга позже привел к разработке « чатботов », программных объектов ИИ, разработанных с единственной целью проведения сеансов текстового чата с людьми. Теперь чатботы имеют более широкое определение: компьютерная программа, которая может поддерживать разговор с человеком, обычно через Интернет. OED [11] [12]

В 1966 году Джозеф Вайценбаум создал программу под названием ELIZA . Программа работала, проверяя набранные пользователем комментарии на наличие ключевых слов. Если ключевое слово найдено, применяется правило, преобразующее комментарии пользователя, и возвращается полученное предложение. Если ключевое слово не найдено, ELIZA отвечает либо общим ответом, либо повторяет один из предыдущих комментариев. [13] Кроме того, Вайценбаум разработал ELIZA для воспроизведения поведения роджерианского психотерапевта , позволяя ELIZA «свободно принимать позу почти ничего не знающего о реальном мире». [14] С помощью этих методов программа Вайценбаума смогла обмануть некоторых людей, заставив их поверить, что они разговаривают с реальным человеком, при этом некоторых испытуемых «очень трудно было убедить, что ELIZA [...] не является человеком». [14] Таким образом, некоторые утверждают, что ELIZA является одной из программ (возможно, первой), способной пройти тест Тьюринга, [14] [15] хотя эта точка зрения весьма спорна (см. Наивность допрашивающих ниже).

Кеннет Колби создал PARRY в 1972 году, программу, описанную как «ELIZA с отношением». [16] Она пыталась смоделировать поведение параноидального шизофреника , используя аналогичный (хотя и более продвинутый) подход, который использовал Вайценбаум. Чтобы подтвердить работу, PARRY была протестирована в начале 1970-х годов с использованием вариации теста Тьюринга. Группа опытных психиатров проанализировала комбинацию реальных пациентов и компьютеров, запускающих PARRY через телетайпы . Другой группе из 33 психиатров показали стенограммы разговоров. Затем обе группы попросили определить, какие из «пациентов» были людьми, а какие — компьютерными программами. [17] Психиатры смогли сделать правильную идентификацию только в 52 процентах случаев — цифра, соответствующая случайному угадыванию. [17]

В 2001 году в Санкт-Петербурге, Россия , группа из трех программистов, уроженца России Владимира Веселова, уроженца Украины Евгения Демченко и уроженца России Сергея Уласена, разработали чат-бота под названием « Юджин Густман ». 7 июля 2014 года он стал первым чат-ботом, который, как оказалось, прошел тест Тьюринга на мероприятии в Университете Рединга, посвященном 60-й годовщине смерти Алана Тьюринга. Тридцать три процента судей мероприятия посчитали, что Густман был человеком; организатор мероприятия Кевин Уорвик посчитал, что он прошел тест Тьюринга. Он был изображен как тринадцатилетний мальчик из Одессы, Украина , у которого есть домашняя морская свинка и отец- гинеколог . Выбор возраста был преднамеренным, чтобы побудить людей, которые «общаются» с ним, прощать незначительные грамматические ошибки в его ответах. [11] [18] [19]

В июне 2022 года чат-бот Google LaMDA (языковая модель для диалоговых приложений) получил широкое освещение в связи с утверждениями о том, что он достиг разумности. Первоначально в статье в The Economist научный сотрудник Google Блейз Агуэра-и-Аркас сказал, что чат-бот продемонстрировал определенную степень понимания социальных отношений. [20] Несколько дней спустя инженер Google Блейк Лемуан заявил в интервью Washington Post, что LaMDA достиг разумности. Лемуан был отправлен в отпуск Google за внутренние утверждения на этот счет. Агуэра-и-Аркас (вице-президент Google) и Джен Дженнай (руководитель Responsible Innovation) расследовали утверждения, но отклонили их. [21] Утверждение Лемуана было решительно отвергнуто другими экспертами в этой области, указав, что языковая модель, которая, по-видимому, имитирует человеческий разговор, не указывает на то, что за ней присутствует какой-либо интеллект, [22] несмотря на то, что, по-видимому, прошла тест Тьюринга. Широкое обсуждение сторонниками и противниками утверждения о том, что LaMDA обрела способность чувствовать, вызвало дискуссии на платформах социальных сетей, в том числе по поводу определения смысла способности чувствовать, а также того, что значит быть человеком.

Чат-бот OpenAI , ChatGPT, выпущенный в ноябре 2022 года, основан на больших языковых моделях GPT-3.5 и GPT-4 . Селеста Бивер написала в статье Nature , что «ChatGPT сломал тест Тьюринга». [23] Исследователи из Стэнфорда сообщили, что ChatGPT проходит тест; они обнаружили, что ChatGPT-4 «проходит строгий тест Тьюринга, отклоняясь от среднего человеческого поведения, главным образом, тем, что он более кооперативен». [24] [25]

Виртуальные помощники также являются программными агентами на базе искусственного интеллекта, разработанными для реагирования на команды или вопросы и выполнения задач в электронном виде, с помощью текстовых или вербальных команд, поэтому они, естественно, включают возможности чат-бота. Известные виртуальные помощники для прямого использования потребителями включают Siri от Apple , Amazon Alexa , Google Assistant , Bixby от Samsung и Microsoft Copilot . [26] [27] [28] [29]

Версии этих программ продолжают дурачить людей. «CyberLover», вредоносная программа, охотится на интернет-пользователей, убеждая их «раскрыть информацию о своей личности или заставить их посетить веб-сайт, который доставит вредоносный контент на их компьютеры». [30] Программа появилась как «риск для влюбленных», флиртуя с людьми, «ищущими отношений в сети, чтобы собрать их личные данные». [31]

Вопрос о том, могут ли машины мыслить, имеет долгую историю, которая прочно укоренилась в различии между дуалистическими и материалистическими взглядами на разум. Рене Декарт предвосхищает аспекты теста Тьюринга в своем «Рассуждении о методе» 1637 года , когда пишет:

[С]колько различных автоматов или движущихся машин может быть создано промышленностью человека... Ибо мы можем легко понять, что машина устроена так, что она может произносить слова и даже выдавать некоторые ответы на воздействие на нее телесного рода, что вызывает изменение в ее органах; например, если ее коснуться в определенной части, она может спросить, что мы хотим ей сказать; если в другой части, она может воскликнуть, что ей больно, и так далее. Но никогда не случается, чтобы она организовывала свою речь различными способами, чтобы соответствующим образом отвечать на все, что может быть сказано в ее присутствии, как это может сделать даже самый низший тип человека. [32]

Здесь Декарт отмечает, что автоматы способны реагировать на человеческие взаимодействия, но утверждает, что такие автоматы не могут адекватно реагировать на вещи, сказанные в их присутствии, так, как это может сделать любой человек. Поэтому Декарт предвосхищает тест Тьюринга, определяя недостаточность адекватной языковой реакции как то, что отделяет человека от автомата. Декарт не рассматривает возможность того, что будущие автоматы смогут преодолеть такую недостаточность, и поэтому не предлагает тест Тьюринга как таковой, даже если он предвосхищает его концептуальную структуру и критерий.

Дени Дидро в своей книге 1746 года «Философские мысли» формулирует критерий теста Тьюринга, хотя и с сохранением важного неявного ограничивающего предположения о том, что участники являются естественными живыми существами, а не рассматривают созданные артефакты:

Если бы они нашли попугая, который мог бы ответить на все вопросы, я бы без колебаний назвал его разумным существом.

Это не значит, что он согласен с этим, но это уже был распространенный аргумент материалистов того времени.

Согласно дуализму, разум не является физическим (или, по крайней мере, имеет нефизические свойства ) [33] и, следовательно, не может быть объяснен в чисто физических терминах. Согласно материализму, разум может быть объяснен физически, что оставляет открытой возможность разумов, созданных искусственно. [34]

В 1936 году философ Альфред Айер рассматривал стандартный философский вопрос о других разумах : откуда мы знаем, что другие люди имеют тот же сознательный опыт, что и мы? В своей книге « Язык, истина и логика » Айер предложил протокол для различения сознательного человека и бессознательной машины: «Единственное основание, которое я могу иметь для утверждения, что объект, который кажется сознательным, на самом деле не является сознательным существом, а всего лишь куклой или машиной, заключается в том, что он не удовлетворяет одному из эмпирических тестов, с помощью которых определяется наличие или отсутствие сознания». [35] (Это предположение очень похоже на тест Тьюринга, но нет уверенности, что популярная философская классика Айера была знакома Тьюрингу.) Другими словами, вещь не является сознательной, если она не проходит тест на сознание.

Элементарная идея теста Тьюринга появляется в романе 1726 года « Путешествия Гулливера» Джонатана Свифта . [36] [37] Когда Гулливера приводят к королю Бробдингнегцев, король сначала думает, что Гулливер может быть «часовым механизмом (который в той стране достиг очень большого совершенства), изобретенным каким-то гениальным художником». Даже когда он слышит, как Гулливер говорит, король все еще сомневается, научили ли Гулливера «набору слов», чтобы заставить его «продаваться по более высокой цене». Гулливер рассказывает, что только после того, как «он задал мне еще несколько вопросов и все еще получил рациональные ответы», король убедился, что Гулливер не машина. [38]

Тесты, в которых человек оценивает, является ли компьютер или инопланетянин разумным, стали общепринятой практикой в научной фантастике к 1940-м годам, и вполне вероятно, что Тьюринг знал о них. [39] « Марсианская одиссея » Стэнли Г. Вайнбаума (1934) является примером того, насколько тонкими могут быть такие тесты. [39]

Более ранние примеры машин или автоматов, пытающихся выдать себя за людей, включают древнегреческий миф о Пигмалионе , который создает скульптуру женщины, оживленную Афродитой , роман Карло Коллоди «Приключения Пиноккио » о кукле, которая хочет стать настоящим мальчиком, и рассказ Э. Т. А. Гофмана 1816 года « Песочный человек », где главный герой влюбляется в автомат. Во всех этих примерах люди обманываются искусственными существами, которые — до определенного момента — выдают себя за людей. [40]

Исследователи в Соединенном Королевстве изучали «машинный интеллект» в течение десяти лет до основания области исследований искусственного интеллекта ( ИИ ) в 1956 году. [41] Это была общая тема среди членов Ratio Club , неформальной группы британских исследователей кибернетики и электроники , в которую входил Алан Тьюринг. [42]

Тьюринг, в частности, разрабатывал концепцию машинного интеллекта по крайней мере с 1941 года [43], а одно из самых ранних известных упоминаний «компьютерного интеллекта» было сделано им в 1947 году. [44] В докладе Тьюринга «Интеллектуальные машины» [45] он исследовал «вопрос о том, могут ли машины демонстрировать разумное поведение» [46] и в рамках этого исследования предложил то, что можно считать предшественником его более поздних тестов:

Нетрудно придумать бумагоделательную машину, которая будет играть в не очень плохую игру в шахматы. [47] Теперь возьмите трех человек A, B и C в качестве подопытных для эксперимента. A и C должны быть довольно плохими игроками в шахматы, B — оператор, который управляет бумагоделательной машиной. ... Используются две комнаты с некоторым устройством для передачи ходов, и игра ведется между C и либо A, либо бумажной машиной. C может оказаться довольно сложным определить, во что он играет. [48]

« Вычислительная техника и интеллект » (1950) была первой опубликованной работой Тьюринга, которая была сосредоточена исключительно на машинном интеллекте. Тьюринг начинает работу 1950 года с утверждения: «Я предлагаю рассмотреть вопрос «Могут ли машины мыслить? » » [6] Как он подчеркивает, традиционный подход к такому вопросу заключается в том, чтобы начать с определений , определяя как термины «машина», так и «думать». Тьюринг предпочитает этого не делать; вместо этого он заменяет вопрос новым, «который тесно связан с ним и выражается относительно недвусмысленными словами». [6] По сути, он предлагает изменить вопрос с «Могут ли машины мыслить?» на «Могут ли машины делать то, что можем делать мы (как мыслящие существа)?» [49] Преимущество нового вопроса, утверждает Тьюринг, заключается в том, что он проводит «довольно резкую границу между физическими и интеллектуальными способностями человека». [50]

Чтобы продемонстрировать этот подход, Тьюринг предлагает тест, вдохновленный игрой для вечеринок , известной как «игра в имитацию», в которой мужчина и женщина идут в разные комнаты, а гости пытаются отличить их друг от друга, задавая ряд вопросов и читая отправленные им машинописные ответы. В этой игре и мужчина, и женщина стремятся убедить гостей, что они — друг друга. (Хума Шах утверждает, что эта версия игры с двумя людьми была представлена Тьюрингом только для того, чтобы познакомить читателя с тестом «вопрос-ответ» между машиной и человеком. [51] ) Тьюринг описал свою новую версию игры следующим образом:

Теперь мы зададим вопрос: «Что произойдет, когда машина возьмет на себя роль А в этой игре?» Будет ли следователь принимать неправильные решения так же часто, когда игра ведется таким образом, как и когда игра ведется между мужчиной и женщиной? Эти вопросы заменяют наш первоначальный вопрос: «Могут ли машины мыслить?» [50]

Позже в статье Тьюринг предлагает «эквивалентную» альтернативную формулировку, включающую судью, общающегося только с компьютером и человеком. [52] Хотя ни одна из этих формулировок не соответствует в точности версии теста Тьюринга, которая более широко известна сегодня, в 1952 году он предложил третью. В этой версии, которую Тьюринг обсуждал в радиопередаче BBC , присяжные задают вопросы компьютеру, и роль компьютера заключается в том, чтобы заставить значительную часть присяжных поверить, что это действительно человек. [53]

В статье Тьюринга были рассмотрены девять предполагаемых возражений, в том числе некоторые из основных аргументов против искусственного интеллекта , выдвинутых за годы, прошедшие с момента публикации статьи (см. « Вычислительная техника и интеллект »). [7]

В своей работе 1980 года « Умы, мозги и программы» Джон Сирл предложил мысленный эксперимент « Китайская комната » и утверждал, что тест Тьюринга не может быть использован для определения способности машины мыслить. Сирл отметил, что программное обеспечение (такое как ELIZA) может пройти тест Тьюринга, просто манипулируя символами, которые оно не понимает. Без понимания их нельзя назвать «мыслящими» в том же смысле, что и людей. Поэтому, заключил Сирл, тест Тьюринга не может доказать, что машины могут мыслить. [54] Подобно самому тесту Тьюринга, аргумент Сирла был как широко раскритикован [55] , так и одобрен. [56]

Аргументы, подобные аргументам Сирла и других, работающих над философией разума, спровоцировали более интенсивные дебаты о природе интеллекта, возможности существования машин с сознательным разумом и ценности теста Тьюринга, которые продолжались в 1980-х и 1990-х годах. [57]

Премия Лёбнера предоставляет ежегодную платформу для практических тестов Тьюринга, первый конкурс состоялся в ноябре 1991 года. [58] Она спонсируется Хью Лёбнером . Кембриджский центр поведенческих исследований в Массачусетсе , США, организовывал премии вплоть до конкурса 2003 года. Как описал Лёбнер, одной из причин создания конкурса было продвижение состояния исследований ИИ, по крайней мере частично, потому что никто не предпринял шагов для внедрения теста Тьюринга, несмотря на 40 лет его обсуждения. [59]

Первый конкурс на премию Лёбнера в 1991 году привел к возобновлению обсуждения жизнеспособности теста Тьюринга и ценности его проведения как в популярной прессе [60] , так и в академических кругах. [61] Первый конкурс выиграла бездумная программа без идентифицируемого интеллекта, которая сумела обмануть наивных исследователей, заставив их сделать неправильную идентификацию. Это выявило несколько недостатков теста Тьюринга (обсуждаемых ниже): победитель победил, по крайней мере отчасти, потому что он смог «имитировать человеческие ошибки при наборе текста»; [60] неискушенные исследователи были легко обмануты; [61] и некоторые исследователи в области искусственного интеллекта пришли к выводу, что тест — это просто отвлечение от более плодотворных исследований. [62]

Серебряный (только текст) и золотой (аудио и видео) призы никогда не были получены. Тем не менее, конкурс ежегодно присуждает бронзовую медаль компьютерной системе, которая, по мнению судей, демонстрирует «наиболее человеческое» разговорное поведение среди заявок этого года. Искусственная лингвистическая интернет-компьютерная сущность (ALICE) выигрывала бронзовую награду трижды в последнее время (2000, 2001, 2004). Обучение ИИ Jabberwacky побеждало в 2005 и 2006 годах.

Премия Лёбнера проверяет разговорный интеллект; победителями обычно становятся программы- чатботы или искусственные разговорные сущности (ACE) . Ранние правила премии Лёбнера ограничивали разговоры: каждая запись и скрытый человек общались на одну тему, [63] таким образом, допрашивающие были ограничены одной строкой вопроса на взаимодействие с сущностью. Правило ограниченного разговора было снято для премии Лёбнера 1995 года. Продолжительность взаимодействия между судьей и сущностью различалась в премиях Лёбнера. В деле Лёбнера 2003 года в Университете Суррея каждому допрашивающему было разрешено пять минут для взаимодействия с сущностью, машиной или скрытым человеком. В период с 2004 по 2007 год время взаимодействия, разрешенное в премиях Лёбнера, составляло более двадцати минут.

CAPTCHA (Completely Automated Public Turing test to Tell Computers and Humans Apart) — одна из старейших концепций искусственного интеллекта, система CAPTCHA обычно используется в Интернете для различения людей и ботов. Она также основана на тесте Тьюринга и включает в себя отображение искаженных букв и цифр, она просит пользователя определить буквы и цифры и ввести их в поле, что боты с трудом делают. [11] [64]

ReCaptcha — это система CAPTCHA, принадлежащая Google . ReCaptcha v1 и v2 обе работали, заставляя пользователя сопоставлять искаженные изображения или определять искаженные буквы и цифры. Но reCaptcha v3 разработана так, чтобы не прерывать пользователей и запускаться автоматически при загрузке страниц или нажатии кнопок. Эта «невидимая» проверка Captcha происходит в фоновом режиме, и никаких проблем не возникает, что отфильтровывает большинство базовых ботов. [65] [66]

Сол Трейгер утверждает, что существует по крайней мере три основных версии теста Тьюринга, две из которых предлагаются в «Вычислительной технике и интеллекте», а одну он описывает как «Стандартную интерпретацию». [67] Хотя ведутся споры о том, является ли «Стандартная интерпретация» той, что описана Тьюрингом, или же она основана на неправильном прочтении его статьи, эти три версии не считаются эквивалентными, [67] и их сильные и слабые стороны различны. [68]

В оригинальной статье Тьюринга описывается простая игра для вечеринок с участием трех игроков. Игрок A — мужчина, игрок B — женщина, а игрок C (который играет роль следователя) может быть любого пола. В имитационной игре игрок C не может видеть ни игрока A, ни игрока B и может общаться с ними только посредством письменных заметок. Задавая вопросы игроку A и игроку B, игрок C пытается определить, кто из них мужчина, а кто женщина. Роль игрока A — обмануть следователя, заставив его принять неправильное решение, в то время как игрок B пытается помочь следователю принять правильное. [8]

Затем Тьюринг спрашивает:

«Что произойдет, когда машина возьмет на себя роль А в этой игре? Будет ли следователь принимать неправильные решения так же часто, когда игра ведется таким образом, как и когда игра ведется между мужчиной и женщиной?» Эти вопросы заменяют наш оригинальный вопрос «Могут ли машины мыслить?» [50]

Вторая версия появилась позже в статье Тьюринга 1950 года. Подобно оригинальному тесту имитационной игры, роль игрока A исполняет компьютер. Однако роль игрока B исполняет мужчина, а не женщина.

Давайте сосредоточим наше внимание на одном конкретном цифровом компьютере C. Правда ли, что, модифицируя этот компьютер так, чтобы он имел достаточный объем памяти, соответствующим образом увеличивая скорость его работы и снабжая его соответствующей программой, можно заставить C удовлетворительно играть роль A в имитационной игре, при этом роль B будет играть человек? [50]

В этой версии и игрок А (компьютер), и игрок Б пытаются обмануть следователя, заставив его принять неверное решение.

Стандартная интерпретация не включена в оригинальную статью, но принята и обсуждается. Общее понимание состоит в том, что цель теста Тьюринга заключается не в том, чтобы определить, способен ли компьютер обмануть допрашивающего, заставив его поверить, что он человек, а в том, может ли компьютер имитировать человека. [8] Хотя есть некоторые споры о том, была ли эта интерпретация задумана Тьюрингом, Стерретт считает, что она была [69] и, таким образом, объединяет вторую версию с этой, в то время как другие, такие как Трейгер, этого не делают [67] – тем не менее, это привело к тому, что можно рассматривать как «стандартную интерпретацию». В этой версии игрок A является компьютером, а игрок B – человеком любого пола. Роль допрашивающего заключается не в том, чтобы определить, кто из них мужчина, а кто женщина, а в том, кто компьютер, а кто человек. [70] Основная проблема стандартной интерпретации заключается в том, что допрашивающий не может отличить, кто из респондентов является человеком, а кто машиной. Есть вопросы о продолжительности, но стандартная интерпретация в целом считает это ограничение чем-то разумным.

Возникли разногласия по поводу того, какую из альтернативных формулировок теста Тьюринг имел в виду. [69] Стерретт утверждает, что из его статьи 1950 года можно извлечь два различных теста, и что, с учетом замечания Тьюринга, они не эквивалентны. Тест, который использует игру-парти и сравнивает частоты успеха, называется «Исходным тестом имитационной игры», тогда как тест, состоящий из человека-судьи, беседующего с человеком и машиной, называется «Стандартным тестом Тьюринга», отмечая, что Стерретт приравнивает его к «стандартной интерпретации», а не ко второй версии имитационной игры. Стерретт соглашается, что стандартный тест Тьюринга (STT) имеет проблемы, на которые ссылаются его критики, но считает, что, напротив, исходный тест имитационной игры (OIG-тест), определенный таким образом, невосприимчив ко многим из них из-за принципиального различия: в отличие от STT, он не делает критерием сходство с человеческими показателями, хотя и использует человеческие показатели при установлении критерия для машинного интеллекта. Человек может провалить тест OIG, но утверждается, что это достоинство теста на интеллект, что провал указывает на отсутствие находчивости: Тест OIG требует находчивости, связанной с интеллектом, а не просто «симуляции человеческого разговорного поведения». Общая структура теста OIG может быть использована даже с невербальными версиями имитационных игр. [71]

По словам Хумы Шаха, сам Тьюринг был обеспокоен тем, может ли машина мыслить, и предлагал простой метод проверки этого вопроса: посредством сеансов вопросов и ответов человек-машина. [72] Шах утверждает, что имитационная игра, описанная Тьюрингом, может быть реализована двумя различными способами: а) тест один на один между опрашивающим и машиной и б) одновременное сравнение машины с человеком, при этом оба опрашиваются опрашивающим параллельно. [51]

Другие авторы [73] интерпретировали Тьюринга как предполагающего, что имитационная игра сама по себе является тестом, не уточняя, как учитывать утверждение Тьюринга о том, что предложенный им тест с использованием партийной версии имитационной игры основан на критерии сравнительной частоты успеха в этой имитационной игре, а не на способности добиться успеха в одном раунде игры.

Некоторые авторы утверждают, что имитационная игра лучше всего понимается через ее социальные аспекты. В своей статье 1948 года Тьюринг называет интеллект «эмоциональной концепцией» и отмечает, что

Степень, в которой мы считаем, что что-то ведет себя разумным образом, определяется как нашим собственным состоянием ума и обучением, так и свойствами рассматриваемого объекта. Если мы способны объяснить и предсказать его поведение или если, по-видимому, в нем мало скрытого плана, у нас мало соблазна вообразить интеллект. Поэтому с одним и тем же объектом возможно, что один человек посчитает его разумным, а другой нет; второй человек узнал бы правила его поведения. [74]

После этого замечания и подобных замечаний, разбросанных по публикациям Тьюринга, Диана Праудфут [75] утверждает, что Тьюринг придерживался подхода зависимости от ответа к интеллекту, согласно которому разумная (или мыслящая) сущность — это та, которая кажется разумной среднестатистическому допрашивающему. Бернардо Гонсалвеш показывает, что хотя Тьюринг использовал риторику представления своего теста как своего рода решающего эксперимента, чтобы решить, можно ли сказать, что машины мыслят, [76] фактическое представление его теста удовлетворяет хорошо известным свойствам мысленных экспериментов в современной научной традиции Галилея. [77] Шломо Данцигер [78] продвигает социально-технологическую интерпретацию, согласно которой Тьюринг рассматривал имитационную игру не как тест на интеллект, а как технологическое стремление — такое, реализация которого, вероятно, повлечет за собой изменение отношения общества к машинам. Согласно этому прочтению, знаменитое 50-летнее предсказание Тьюринга — что к концу 20-го века его тест будет пройден какой-то машиной — на самом деле состоит из двух различных предсказаний. Первый — технологический прогноз:

Я считаю, что примерно через пятьдесят лет можно будет запрограммировать компьютеры... так, чтобы они играли в имитационную игру настолько хорошо, что у среднего следователя не будет более 70% шансов правильно идентифицировать человека после пяти минут допроса. [79]

Второе предсказание Тьюринга носит социологический характер:

Я полагаю, что к концу столетия использование слов и общее образованное мнение изменятся настолько, что можно будет говорить о мыслящих машинах, не ожидая возражений. [79]

Данцигер далее утверждает, что, по Тьюрингу, изменение отношения общества к машинам является предпосылкой для существования разумных машин: Только когда термин «разумная машина» перестанет рассматриваться как оксюморон, существование разумных машин станет логически возможным.

Сайгин предположил, что, возможно, оригинальная игра является способом предложить менее предвзятый экспериментальный дизайн, поскольку он скрывает участие компьютера. [80] Имитационная игра также включает в себя «социальный хак», которого нет в стандартной интерпретации, поскольку в игре и компьютер, и мужчина должны играть, притворяясь тем, кем они не являются. [81]

Важнейшей частью любого лабораторного теста является то, что должен быть контроль. Тьюринг никогда не уточняет, знает ли следователь в своих тестах, что один из участников является компьютером. Он утверждает только, что игрок A должен быть заменен машиной, а не то, что игрок C должен быть осведомлен об этой замене. [50] Когда Колби, Ф. Д. Хильф, С. Вебер и А. Д. Крамер тестировали PARRY, они делали это, предполагая, что следователь не должен знать, что один или несколько из опрашиваемых были компьютером во время допроса. [82] Как подчеркивали Айше Сайгин, Питер Свирски [83] и другие, это имеет большое значение для реализации и результата теста. [8] В экспериментальном исследовании, изучавшем нарушения максимы Грайса с использованием стенограмм премий Лёбнера «один на один» (допрашивающий-скрытый собеседник) для конкурсов ИИ между 1994 и 1999 годами, Айше Сайгин обнаружила значительные различия между ответами участников, которые знали и не знали об участии компьютеров. [84]

Сила и привлекательность теста Тьюринга проистекают из его простоты. Философия разума , психология и современная нейронаука не смогли дать определения «интеллекта» и «мышления», которые были бы достаточно точными и общими для применения к машинам. Без таких определений невозможно ответить на центральные вопросы философии искусственного интеллекта . Тест Тьюринга, даже если он несовершенен, по крайней мере дает что-то, что можно фактически измерить. Таким образом, это прагматичная попытка ответить на сложный философский вопрос.

Формат теста позволяет опрашивающему давать машине широкий спектр интеллектуальных задач. Тьюринг писал, что «метод вопросов и ответов, по-видимому, подходит для введения практически любой из областей человеческой деятельности, которые мы хотим включить». [85] Джон Хаугеланд добавляет, что «недостаточно понимать слова; нужно также понимать тему ». [86]

Чтобы пройти хорошо разработанный тест Тьюринга, машина должна использовать естественный язык , рассуждать , иметь знания и учиться . Тест можно расширить, включив в него видеовход, а также «люк», через который можно передавать объекты: это заставит машину продемонстрировать умелое использование хорошо разработанного зрения и робототехники . Вместе они представляют собой почти все основные проблемы, которые исследования искусственного интеллекта хотели бы решить. [87]

Тест Фейгенбаума разработан с целью использования широкого спектра тем, доступных для теста Тьюринга. Это ограниченная форма игры Тьюринга «вопрос-ответ», которая сравнивает машину со способностями экспертов в определенных областях, таких как литература или химия .

Как выпускник Кембриджа с отличием по математике, Тьюринг мог бы ожидать, что предложит тест компьютерного интеллекта, требующий экспертных знаний в какой-то высокотехнологичной области, и, таким образом, предвосхищая более современный подход к предмету . Вместо этого, как уже отмечалось, тест, который он описал в своей основополагающей статье 1950 года, требует, чтобы компьютер был способен успешно соревноваться в обычной игре для вечеринок, и для этого он должен не хуже типичного мужчины отвечать на ряд вопросов, чтобы убедительно выдавать себя за женщину-участницу.

Учитывая статус человеческого полового диморфизма как одного из самых древних предметов , в вышеприведенном сценарии подразумевается, что вопросы, на которые нужно ответить, не будут включать ни специализированные фактические знания, ни технику обработки информации. Задача компьютера, скорее, будет заключаться в том, чтобы продемонстрировать эмпатию к роли женщины, а также продемонстрировать характерную эстетическую чувствительность — оба эти качества демонстрируются в этом фрагменте диалога, который придумал Тьюринг:

Когда Тьюринг вводит некоторые специальные знания в один из своих воображаемых диалогов, темой становится не математика или электроника, а поэзия:

Таким образом, Тьюринг снова демонстрирует свой интерес к эмпатии и эстетической чувствительности как компонентам искусственного интеллекта; и в свете растущего осознания угрозы со стороны ИИ, вышедшего из-под контроля, [88] было высказано предположение [89] , что этот фокус, возможно, представляет собой критическую интуицию со стороны Тьюринга, т. е. что эмоциональный и эстетический интеллект будут играть ключевую роль в создании « дружественного ИИ ». Далее отмечается, однако, что любое вдохновение, которое Тьюринг мог бы дать в этом направлении, зависит от сохранения его первоначального видения, то есть, далее, что обнародование «стандартной интерпретации» теста Тьюринга — т. е. той, которая фокусируется только на дискурсивном интеллекте — должно рассматриваться с некоторой осторожностью.

Тьюринг не утверждал прямо, что тест Тьюринга может быть использован в качестве меры « интеллекта » или любого другого человеческого качества. Он хотел предоставить ясную и понятную альтернативу слову «думать», которую он мог бы затем использовать для ответа на критику возможности «думающих машин» и для предложения путей, по которым исследования могли бы двигаться вперед.

Тем не менее, тест Тьюринга был предложен в качестве меры «способности мыслить» машины или ее «интеллекта». Это предложение подверглось критике как со стороны философов, так и со стороны компьютерных ученых. Интерпретация предполагает, что следователь может определить, «думает» ли машина, сравнивая ее поведение с поведением человека. Каждый элемент этого предположения был подвергнут сомнению: надежность суждения следователь, ценность сравнения машины с человеком и ценность сравнения только поведения. Из-за этих и других соображений некоторые исследователи ИИ подвергли сомнению релевантность теста для своей области.

На практике результаты теста могут легко зависеть не от интеллекта компьютера, а от отношения, мастерства или наивности спрашивающего. Многочисленные эксперты в этой области, включая когнитивного ученого Гэри Маркуса , настаивают на том, что тест Тьюринга лишь показывает, насколько легко обмануть людей, и не является показателем машинного интеллекта. [90]

Тьюринг не уточняет точные навыки и знания, необходимые допрашивающему в своем описании теста, но он использовал термин «средний допрашивающий»: «средний допрашивающий не будет иметь более 70-процентного шанса правильно идентифицировать после пяти минут допроса» [79] .

Программы-чатботы, такие как ELIZA, неоднократно обманывали ничего не подозревающих людей, заставляя их поверить, что они общаются с людьми. В этих случаях «допрашивающие» даже не осознают возможности того, что они взаимодействуют с компьютерами. Чтобы успешно казаться человеком, машине не нужно обладать каким-либо интеллектом вообще, требуется лишь поверхностное сходство с поведением человека.

В ранних конкурсах на премию Лёбнера использовались «неискушенные» следователи, которых машины легко обманывали. [61] С 2004 года организаторы премии Лёбнера привлекали философов, компьютерных специалистов и журналистов в качестве следователей. Тем не менее, некоторые из этих экспертов были обмануты машинами. [91]

Одной из интересных особенностей теста Тьюринга является частота эффекта сообщника , когда сообщники (тестируемые) люди ошибочно идентифицируются следователями как машины. Было высказано предположение, что то, что следователи ожидают как человеческие ответы, не обязательно типично для людей. В результате некоторые люди могут быть отнесены к категории машин. Следовательно, это может работать в пользу конкурирующей машины. Людям предписывается «действовать самим», но иногда их ответы больше похожи на то, что следователь ожидает услышать от машины. [92] Это поднимает вопрос о том, как гарантировать, что люди мотивированы «действовать по-человечески».

Тест Тьюринга не проверяет напрямую, ведет ли себя компьютер разумно. Он проверяет только, ведет ли себя компьютер как человек. Поскольку человеческое поведение и разумное поведение — это не совсем одно и то же, тест может не измерить интеллект точно двумя способами:

Тест Тьюринга касается исключительно того, как действует субъект – внешнего поведения машины. В этом отношении он использует бихевиористский или функционалистский подход к изучению разума. Пример ELIZA предполагает, что машина, прошедшая тест, может быть способна имитировать человеческое разговорное поведение, следуя простому (но большому) списку механических правил, не думая и не имея разума вообще.

Джон Сирл утверждал, что внешнее поведение не может быть использовано для определения того, думает ли машина «на самом деле» или просто «симулирует мышление». [54] Его аргумент китайской комнаты призван показать, что даже если тест Тьюринга является хорошим операциональным определением интеллекта, он может не указывать на то, что у машины есть разум , сознание или преднамеренность . (Преднамеренность — философский термин, обозначающий способность мыслей быть «о» чем-то.)

Тьюринг предвосхитил эту линию критики в своей оригинальной статье [96] , написав:

Я не хочу создавать впечатление, что я думаю, что нет никакой тайны в сознании. Например, есть некий парадокс, связанный с любой попыткой локализовать его. Но я не думаю, что эти тайны обязательно должны быть решены, прежде чем мы сможем ответить на вопрос, который нас интересует в этой статье. [97]

Исследователи ИИ, работающие в традиционном направлении, утверждают, что попытка пройти тест Тьюринга — это просто отвлечение от более плодотворных исследований. [62] Действительно, тест Тьюринга не является объектом активных академических или коммерческих усилий — как пишут Стюарт Рассел и Питер Норвиг : «Исследователи ИИ уделяют мало внимания прохождению теста Тьюринга». [98] Причин тому несколько.

Во-первых, существуют более простые способы тестирования их программ. Большинство современных исследований в областях, связанных с ИИ, направлены на скромные и конкретные цели, такие как распознавание объектов или логистика . Чтобы проверить интеллект программ, решающих эти проблемы, исследователи ИИ просто дают им задание напрямую. Стюарт Рассел и Питер Норвиг предлагают аналогию с историей полетов : самолеты проверяются по тому, насколько хорошо они летают, а не сравнивая их с птицами. « Тексты по авиационной технике », пишут они, «не определяют цель своей области как «создание машин, которые летают настолько точно, как голуби , что они могут обманывать других голубей » . [98 ]

Во-вторых, создание реалистичных симуляций людей является сложной проблемой само по себе, которую не нужно решать для достижения основных целей исследований ИИ. Правдоподобные человеческие персонажи могут быть интересны в произведении искусства, игре или сложном пользовательском интерфейсе , но они не являются частью науки создания интеллектуальных машин, то есть машин, которые решают проблемы с помощью интеллекта.

Тьюринг не намеревался использовать свою идею для проверки интеллекта программ — он хотел предоставить ясный и понятный пример, чтобы помочь в обсуждении философии искусственного интеллекта . [99] Джон Маккарти утверждает, что мы не должны удивляться, если философская идея оказывается бесполезной для практических приложений. Он замечает, что философия ИИ «вряд ли окажет большее влияние на практику исследований ИИ, чем философия науки в целом оказывает на практику науки». [100] [101]

Другое известное возражение, выдвинутое против теста Тьюринга, касается его исключительной сосредоточенности на лингвистическом поведении (т. е. это только «языковой» эксперимент, в то время как все другие когнитивные способности не тестируются). Этот недостаток принижает роль других модально-специфических «интеллектуальных способностей» относительно людей, которые психолог Говард Гарднер в своей « множественной теории интеллекта » предлагает учитывать (вербально-лингвистические способности являются лишь одними из них). [102]

Критический аспект теста Тьюринга заключается в том, что машина должна выдавать себя за машину своими высказываниями. Затем следователь должен провести «правильную идентификацию», правильно идентифицировав машину как именно машину. Однако если машина молчит во время разговора, то следователь не может точно идентифицировать машину, кроме как с помощью вычисленной догадки. [103] Даже принимая во внимание параллельного/скрытого человека как часть теста, это может не помочь ситуации, поскольку люди часто могут быть ошибочно идентифицированы как машины. [104]

Сосредоточившись на имитации людей, а не на расширении или дополнении человеческих возможностей, Тест Тьюринга рискует направить исследования и внедрение в сторону технологий, которые заменяют людей и тем самым снижают заработную плату и доход рабочих. Поскольку они теряют экономическую власть, эти рабочие могут также потерять политическую власть, что затрудняет для них изменение распределения богатства и дохода. Это может загнать их в ловушку плохого равновесия. Эрик Бриньолфссон назвал это «ловушкой Тьюринга» и утверждал, что в настоящее время существуют избыточные стимулы для создания машин, которые имитируют, а не дополняют людей.

За прошедшие годы было предложено множество других версий теста Тьюринга, включая те, что описаны выше.

Модификация теста Тьюринга, в которой цель одной или нескольких ролей была изменена между машинами и людьми, называется обратным тестом Тьюринга. Пример подразумевается в работе психоаналитика Вилфреда Биона [105], который был особенно очарован «штормом», возникшим в результате столкновения одного разума с другим. В своей книге 2000 года [83] среди нескольких других оригинальных моментов относительно теста Тьюринга литературовед Питер Свирски подробно обсудил идею того, что он назвал тестом Свирски — по сути, обратным тестом Тьюринга. Он указал, что он преодолевает большинство, если не все стандартные возражения, выдвигаемые против стандартной версии.

Развивая эту идею, Р. Д. Хиншелвуд [106] описал разум как «аппарат распознавания разума». Задача для компьютера будет заключаться в том, чтобы он мог определить, взаимодействует ли он с человеком или другим компьютером. Это расширение изначального вопроса, на который Тьюринг пытался ответить, но, возможно, предложит достаточно высокий стандарт для определения машины, которая могла бы «думать» способом, который мы обычно определяем как характерно человеческий.

CAPTCHA — это форма обратного теста Тьюринга. Перед тем, как разрешить пользователю выполнить какое-либо действие на веб-сайте, ему показывают буквенно-цифровые символы в искаженном графическом изображении и просят их набрать. Это сделано для того, чтобы предотвратить использование автоматизированных систем для злоупотребления сайтом. Обоснование заключается в том, что программное обеспечение, достаточно сложное для точного чтения и воспроизведения искаженного изображения, не существует (или недоступно для обычного пользователя), поэтому любая система, способная это сделать, скорее всего, будет человеком.

Программное обеспечение, которое может с некоторой точностью обходить CAPTCHA, анализируя закономерности в генерирующем движке, начало разрабатываться вскоре после создания CAPTCHA. [107] В 2013 году исследователи из Vicarious объявили, что разработали систему для решения задач CAPTCHA от Google , Yahoo! и PayPal в 90% случаев. [108] В 2014 году инженеры Google продемонстрировали систему, которая может обходить задачи CAPTCHA с точностью 99,8%. [109] В 2015 году Шуман Гошемаджумдер , бывший глава отдела по борьбе с мошенничеством с кликами в Google, заявил, что существуют сайты киберпреступников , которые обходят задачи CAPTCHA за определенную плату, чтобы обеспечить различные формы мошенничества. [110]

Еще одна вариация мотивирована опасением, что современная обработка естественного языка окажется весьма успешной в генерации текста на основе огромного текстового корпуса и в конечном итоге сможет пройти тест Тьюринга, просто манипулируя словами и предложениями, которые использовались при первоначальном обучении модели. Поскольку у проверяющего нет точного понимания обучающих данных, модель может просто возвращать предложения, которые существуют аналогичным образом в огромном количестве обучающих данных. По этой причине Артур Шванингер предлагает вариацию теста Тьюринга, которая может различать системы, способные только использовать язык , и системы, которые понимают язык. Он предлагает тест, в котором машина сталкивается с философскими вопросами, которые не зависят от каких-либо предварительных знаний и все же требуют саморефлексии для надлежащего ответа. [111]

Другой вариант описывается как тест Тьюринга эксперта по предметной области , где ответ машины не может быть отличен от ответа эксперта в данной области. Это также известно как «тест Фейгенбаума» и было предложено Эдвардом Фейгенбаумом в статье 2003 года. [112]

Роберт Френч (1990) утверждает, что допрашивающий может различать собеседников-людей и не-людей, задавая вопросы, которые раскрывают низкоуровневые (т. е. бессознательные) процессы человеческого познания, изучаемые когнитивной наукой . Такие вопросы раскрывают точные детали человеческого воплощения мысли и могут разоблачить компьютер, если он не воспринимает мир так, как это делают люди. [113]

«Тест Тьюринга» [4] — вариация теста Тьюринга, предложенная когнитивным ученым Стеваном Харнадом [114] , добавляет два дополнительных требования к традиционному тесту Тьюринга. Опрашивающий может также проверить перцептивные способности субъекта (требуя компьютерного зрения ) и способность субъекта манипулировать объектами (требуя робототехники ). [115]

В письме, опубликованном в Communications of the ACM [116], описывается концепция создания синтетической популяции пациентов и предлагается вариант теста Тьюринга для оценки разницы между синтетическими и реальными пациентами. В письме говорится: «В контексте EHR, хотя врач-человек может легко отличить синтетически созданных и реальных живых пациентов-людей, может ли машина быть наделена интеллектом, чтобы самостоятельно делать такое определение?» и далее в письме говорится: «Прежде чем синтетические личности пациентов станут проблемой общественного здравоохранения, законный рынок EHR может выиграть от применения методов, подобных тесту Тьюринга, для обеспечения большей надежности данных и диагностической ценности. Таким образом, любые новые методы должны учитывать неоднородность пациентов и, вероятно, будут иметь большую сложность, чем тест Аллена для восьмого класса по естественным наукам».

Тест минимального интеллектуального сигнала был предложен Крисом МакКинстри как «максимальная абстракция теста Тьюринга» [117] , в котором разрешены только бинарные ответы (истина/ложь или да/нет), чтобы сосредоточиться только на способности мыслить. Он устраняет проблемы текстового чата, такие как предвзятость антропоморфизма, и не требует эмуляции неразумного поведения человека, что позволяет использовать системы, превосходящие человеческий интеллект. Однако вопросы должны быть каждый сам по себе, что делает его больше похожим на тест IQ , чем на допрос. Обычно он используется для сбора статистических данных, по которым можно измерить производительность программ искусственного интеллекта. [118]

Организаторы премии Хаттера считают, что сжатие текста на естественном языке — сложная задача искусственного интеллекта, эквивалентная прохождению теста Тьюринга.

Тест на сжатие данных имеет некоторые преимущества по сравнению с большинством версий и вариаций теста Тьюринга, в том числе:

Основными недостатками использования сжатия данных в качестве теста являются:

Связанный с премией Хаттера подход, который появился гораздо раньше, в конце 1990-х годов, заключается во включении проблем сжатия в расширенный тест Тьюринга. [119] или с помощью тестов, которые полностью выводятся из сложности Колмогорова . [120] Другие связанные тесты в этом направлении представлены Эрнандесом-Оралло и Доу. [121]

Алгоритмический IQ, или сокращенно AIQ, представляет собой попытку преобразовать теоретическую универсальную меру интеллекта Легга и Хаттера (основанную на индуктивном выводе Соломонова ) в работающий практический тест машинного интеллекта. [122]

Два главных преимущества некоторых из этих тестов — их применимость к нечеловеческому интеллекту и отсутствие необходимости в участии людей в тестировании.

Тест Тьюринга вдохновил на создание теста Эберта, предложенного в 2011 году кинокритиком Роджером Эбертом. Этот тест позволяет проверить, обладает ли синтезированный на компьютере голос достаточными навыками в плане интонаций, модуляций, ритма и т. д., чтобы заставить людей смеяться. [123]

Используя преимущества Больших языковых моделей , в 2023 году исследовательская компания AI21 Labs создала онлайн-социальный эксперимент под названием «Человек или нет?». [124] [125] В него сыграли более 10 миллионов раз более 2 миллионов человек. [126] Это самый большой эксперимент в стиле Тьюринга на тот момент. Результаты показали, что 32% людей не смогли отличить людей от машин. [127] [128]

1990 год ознаменовал сороковую годовщину первой публикации статьи Тьюринга "Вычислительная техника и интеллект", и интерес к тесту возобновился. В том году произошло два важных события: первым был Коллоквиум Тьюринга, который состоялся в апреле в Университете Сассекса и объединил ученых и исследователей из самых разных дисциплин для обсуждения теста Тьюринга с точки зрения его прошлого, настоящего и будущего; вторым было учреждение ежегодного конкурса на премию Лёбнера .

Блей Уитби перечисляет четыре основных поворотных момента в истории теста Тьюринга — публикация «Вычислительной техники и интеллекта» в 1950 году, объявление Джозефа Вайценбаума о ELIZA в 1966 году, создание Кеннетом Колби PARRY , который был впервые описан в 1972 году, и Коллоквиум Тьюринга в 1990 году. [129]

Параллельно с премией Лёбнера 2008 года , проходившей в Университете Рединга , [130] Общество по изучению искусственного интеллекта и моделирования поведения (AISB) провело однодневный симпозиум для обсуждения теста Тьюринга, организованный Джоном Барнденом, Марком Бишопом , Хумой Шах и Кевином Уориком . [131] Среди докладчиков были директор Королевского института баронесса Сьюзан Гринфилд , Сельмер Брингсйорд , биограф Тьюринга Эндрю Ходжес и ученый, изучающий сознание Оуэн Холланд . Соглашение о каноническом тесте Тьюринга не было достигнуто, хотя Брингсйорд заявил, что значительная премия приведет к более быстрому прохождению теста Тьюринга.

Будучи геем, который провел почти всю свою жизнь в шкафу, Тьюринг, должно быть, остро осознавал социальную сложность постоянной подделки своей настоящей личности. И есть восхитительная ирония в том факте, что десятилетиями ученые ИИ предпочитали игнорировать тест Тьюринга на гендерное искажение — только чтобы за него ухватились три студентки. (Полная версия архивирована 23 марта 2019 года на Wayback Machine ).

называет это «тестом Эберта» в честь стандарта искусственного интеллекта Тьюринга...