В машинном обучении вероятностный классификатор — это классификатор , который способен предсказать, учитывая наблюдение за входными данными, распределение вероятностей по набору классов, а не только выводить наиболее вероятный класс, к которому должно принадлежать наблюдение. Вероятностные классификаторы обеспечивают классификацию, которая может быть полезна сама по себе [1] или при объединении классификаторов в ансамбли .

Формально «обычный» классификатор — это некоторое правило или функция , которая присваивает образцу x метку класса ŷ :

Образцы берутся из некоторого множества X (например, множества всех документов или множества всех изображений ), в то время как метки классов образуют конечное множество Y, определенное до обучения.

Вероятностные классификаторы обобщают это понятие классификаторов: вместо функций они являются условными распределениями , что означает, что для заданного они назначают вероятности всем (и эти вероятности в сумме дают единицу). «Жесткая» классификация может быть выполнена с использованием оптимального решающего правила [2] : 39–40

или, говоря по-английски, прогнозируемый класс — это тот, который имеет наибольшую вероятность.

Бинарные вероятностные классификаторы также называются в статистике бинарными регрессионными моделями . В эконометрике вероятностная классификация в целом называется дискретным выбором .

Некоторые модели классификации, такие как наивный байесовский , логистическая регрессия и многослойные персептроны (при обучении с использованием соответствующей функции потерь ) являются естественно вероятностными. Другие модели, такие как машины опорных векторов, не являются таковыми, но существуют методы, позволяющие превратить их в вероятностные классификаторы.

Некоторые модели, такие как логистическая регрессия , обучаются условно: они оптимизируют условную вероятность непосредственно на обучающем наборе (см. минимизация эмпирического риска ). Другие классификаторы, такие как наивный байесовский , обучаются генеративно : во время обучения находятся класс-условное распределение и класс- априор , а условное распределение выводится с использованием правила Байеса . [2] : 43

Не все модели классификации являются естественно вероятностными, и некоторые из них, особенно наивные байесовские классификаторы, деревья решений и методы усиления , создают искаженные распределения вероятностей классов. [3] В случае деревьев решений, где Pr( y | x ) — это доля обучающих выборок с меткой y в листе, где заканчивается x , эти искажения возникают из-за того, что алгоритмы обучения, такие как C4.5 или CART, явно нацелены на создание однородных листьев (давая вероятности, близкие к нулю или единице, и, следовательно, высокое смещение ) при использовании небольшого количества выборок для оценки соответствующей доли (высокая дисперсия ). [4]

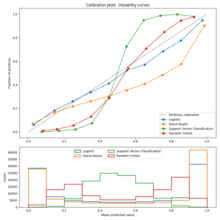

Калибровку можно оценить с помощью калибровочного графика (также называемого диаграммой надежности ). [3] [5] Калибровочный график показывает долю элементов в каждом классе для полос предсказанной вероятности или оценки (например, искаженное распределение вероятностей или «знаковое расстояние до гиперплоскости» в машине опорных векторов). Отклонения от функции тождества указывают на плохо откалиброванный классификатор, для которого предсказанные вероятности или оценки не могут использоваться в качестве вероятностей. В этом случае можно использовать метод, чтобы превратить эти оценки в должным образом откалиброванные вероятности принадлежности к классу.

Для бинарного случая распространенным подходом является применение масштабирования Платта , которое обучает модель логистической регрессии на основе оценок. [6] Альтернативный метод, использующий изотоническую регрессию [7] , как правило, превосходит метод Платта, когда доступно достаточно данных для обучения. [3]

В случае с несколькими классами можно использовать сведение к бинарным задачам, за которым следует одномерная калибровка с помощью алгоритма, описанного выше, и дальнейшее применение алгоритма парной связи Хасти и Тибширани. [8]

Обычно используемые метрики оценки, которые сравнивают прогнозируемую вероятность с наблюдаемыми результатами, включают логарифм потерь , оценку Брайера и различные ошибки калибровки. Первый также используется как функция потерь при обучении логистических моделей.

Метрики ошибок калибровки направлены на количественную оценку степени, в которой выходные данные вероятностного классификатора хорошо откалиброваны . Как выразился Филип Дэвид , «прогнозист хорошо откалиброван, если, например, из тех событий, которым он назначает вероятность 30 процентов, долгосрочная доля, которая фактически происходит, оказывается равной 30 процентам». [9] Основополагающая работа в области измерения ошибки калибровки — это метрика ожидаемой ошибки калибровки (ECE). [10] Более поздние работы предлагают варианты ECE, которые устраняют ограничения метрики ECE, которые могут возникнуть, когда оценки классификатора концентрируются на узком подмножестве [0,1], включая адаптивную ошибку калибровки (ACE) [11] и ошибку калибровки на основе теста (TCE). [12]

Метод, используемый для присвоения оценок парам прогнозируемых вероятностей и фактических дискретных результатов, чтобы можно было сравнивать различные методы прогнозирования, называется правилом подсчета баллов .

[В] приложениях для интеллектуального анализа данных интерес часто больше сосредоточен на самих вероятностях классов, а не на выполнении задания класса.