Иерархия кэша, или многоуровневый кэш , представляет собой архитектуру памяти, которая использует иерархию хранилищ памяти на основе различных скоростей доступа к кэшированным данным. Высокозапрашиваемые данные кэшируются в хранилищах памяти с высокоскоростным доступом, что обеспечивает более быстрый доступ ядрам центрального процессора (ЦП).

Иерархия кэша является формой и частью иерархии памяти и может считаться формой многоуровневого хранения . [1] Эта конструкция была предназначена для того, чтобы позволить ядрам ЦП обрабатывать данные быстрее, несмотря на задержку доступа к основной памяти . Доступ к основной памяти может стать узким местом для производительности ядра ЦП , поскольку ЦП ожидает данные, в то время как обеспечение высокой скорости всей основной памяти может быть непомерно дорогим. Высокоскоростные кэши являются компромиссом, обеспечивающим высокоскоростной доступ к данным, наиболее часто используемым ЦП, что позволяет использовать более быструю тактовую частоту ЦП . [2]

В истории развития компьютеров и электронных микросхем был период, когда рост скорости ЦП опережал улучшения в скорости доступа к памяти. [3] Разрыв между скоростью ЦП и памяти означал, что ЦП часто простаивал. [4] ЦП становились все более способными запускать и выполнять большее количество инструкций за определенное время, но время, необходимое для доступа к данным из основной памяти, не позволяло программам в полной мере использовать эту возможность. [5] Эта проблема побудила к созданию моделей памяти с более высокой скоростью доступа, чтобы реализовать потенциал более быстрых процессоров. [6]

Это привело к концепции кэш-памяти , впервые предложенной Морисом Уилксом , британским ученым-компьютерщиком из Кембриджского университета в 1965 году. Он назвал такие модели памяти «ведомой памятью». [7] Примерно между 1970 и 1990 годами в работах и статьях Ананта Агарвала , Алана Джея Смита , Марка Д. Хилла , Томаса Р. Пузака и других обсуждались лучшие конструкции кэш-памяти. Первые модели кэш-памяти были реализованы в то время, но даже когда исследователи исследовали и предлагали лучшие конструкции, потребность в более быстрых моделях памяти сохранялась. Эта потребность была вызвана тем фактом, что хотя ранние модели кэша улучшили задержку доступа к данным, с учетом стоимости и технических ограничений было невозможно приблизить кэш компьютерной системы к размеру основной памяти. С 1990 года предлагались такие идеи, как добавление еще одного уровня кэша (второго уровня) в качестве резервной копии для кэша первого уровня. Жан-Лу Баер , Вен-Ханн Ванг, Эндрю В. Уилсон и другие провели исследование этой модели. Когда несколько симуляций и реализаций продемонстрировали преимущества двухуровневых моделей кэша, концепция многоуровневых кэшей стала популярной как новая и в целом лучшая модель кэш-памяти. С 2000 года многоуровневые модели кэшей получили широкое внимание и в настоящее время реализованы во многих системах, например, трехуровневые кэши, которые присутствуют в продуктах Intel Core i7. [8]

Доступ к основной памяти для выполнения каждой инструкции может привести к медленной обработке, при этом тактовая частота зависит от времени, необходимого для поиска и извлечения данных. Чтобы скрыть эту задержку памяти от процессора, используется кэширование данных. [9] Всякий раз, когда процессору требуются данные, они извлекаются из основной памяти и сохраняются в меньшей структуре памяти, называемой кэшем. Если есть какая-либо дополнительная потребность в этих данных, кэш сначала просматривается перед переходом в основную память. [10] Эта структура находится ближе к процессору с точки зрения времени, необходимого для поиска и извлечения данных по отношению к основной памяти. [11] Преимущества использования кэша можно доказать, вычислив среднее время доступа (AAT) для иерархии памяти с кэшем и без него. [12]

Кэши, будучи небольшими по размеру, могут приводить к частым промахам – когда поиск в кэше не дает искомой информации – что приводит к вызову основной памяти для извлечения данных. Таким образом, AAT зависит от частоты промахов каждой структуры, из которой он ищет данные. [13]

AAT для основной памяти определяется по Hit time main memory . AAT для кэшей может быть определен по

Время попадания для кэшей меньше времени попадания для основной памяти, поэтому AAT для извлечения данных значительно ниже при доступе к данным через кэш, а не через основную память. [14]

Хотя использование кэша может улучшить задержку памяти, оно не всегда может привести к требуемому улучшению времени, необходимого для извлечения данных, из-за способа организации и обхода кэшей. Например, кэши с прямым отображением, которые имеют тот же размер, обычно имеют более высокий уровень промахов, чем полностью ассоциативные кэши. Это также может зависеть от эталонного теста компьютера, тестирующего процессор, и от шаблона инструкций. Но использование полностью ассоциативного кэша может привести к большему энергопотреблению, поскольку ему приходится каждый раз искать по всему кэшу. Из-за этого компромисс между энергопотреблением (и связанным с ним теплом) и размером кэша становится критическим в конструкции кэша. [13]

В случае промаха кэша цель использования такой структуры будет бесполезной, и компьютеру придется обратиться к основной памяти, чтобы извлечь требуемые данные. Однако, при многоуровневом кэше , если компьютер пропустит кэш, ближайший к процессору (кэш первого уровня или L1), он затем будет искать по следующему ближайшему уровню(ям) кэша и обращаться к основной памяти только в том случае, если эти методы не сработают. Общая тенденция заключается в том, чтобы кэш L1 оставался небольшим и на расстоянии 1–2 тактов ЦП от процессора, при этом нижние уровни кэшей увеличиваются в размере для хранения большего количества данных, чем L1, следовательно, будучи более удаленными, но с более низкой частотой промахов. Это приводит к лучшему AAT. [15] Количество уровней кэша может быть спроектировано архитекторами в соответствии с их требованиями после проверки компромиссов между стоимостью, AAT и размером. [16] [17]

Благодаря масштабированию технологий, которое позволило разместить системы памяти на одном кристалле, большинство современных процессоров имеют до трех или четырех уровней кэша. [18] Сокращение AAT можно понять на этом примере, где компьютер проверяет AAT для различных конфигураций вплоть до кэшей L3.

Пример : основная память = 50 нс , L1 = 1 нс с частотой промахов 10%, L2 = 5 нс с частотой промахов 1%, L3 = 10 нс с частотой промахов 0,2%.

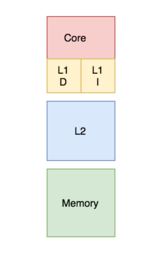

В банковском кэше кэш разделен на кэш, предназначенный для хранения инструкций , и кэш, предназначенный для данных. Напротив, унифицированный кэш содержит как инструкции, так и данные в одном и том же кэше. [22] Во время процесса процессор обращается к кэшу L1 (или самому верхнему по отношению к его подключению к процессору кэшу) для извлечения как инструкций, так и данных. Требование одновременной реализации обоих действий требует наличия нескольких портов и большего времени доступа в унифицированном кэше. Наличие нескольких портов требует дополнительного оборудования и проводки, что приводит к значительной структуре между кэшами и процессорами. [23] Чтобы избежать этого, кэш L1 часто организуется как банковский кэш, что приводит к меньшему количеству портов, меньшему количеству оборудования и, как правило, меньшему времени доступа. [13]

Современные процессоры имеют разделенные кэши, а в системах с многоуровневыми кэшами кэши более высокого уровня могут быть объединены, а кэши более низкого уровня могут быть разделены. [24]

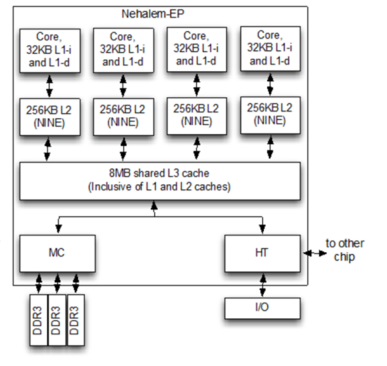

Может ли блок, присутствующий в верхнем слое кэша, также присутствовать в нижнем уровне кэша, регулируется политикой включения системы памяти , которая может быть включающей, исключающей или невключающей неисключающей (NINE). [ необходима цитата ]

При инклюзивной политике все блоки, присутствующие в кэше верхнего уровня, должны присутствовать и в кэше нижнего уровня. Каждый компонент кэша верхнего уровня является подмножеством компонента кэша нижнего уровня. В этом случае, поскольку есть дублирование блоков, есть некоторая потеря памяти. Однако проверка происходит быстрее. [ необходима цитата ]

В рамках политики исключительности все компоненты иерархии кэша полностью исключительны, так что любой элемент в кэше верхнего уровня не будет присутствовать ни в одном из компонентов кэша нижнего уровня. Это позволяет полностью использовать кэш-память. Однако существует высокая задержка доступа к памяти. [25]

Вышеуказанные политики требуют соблюдения набора правил для их реализации. Если ни одно из них не принудительно, результирующая политика включения называется невключающей неисключающей (NINE). Это означает, что кэш верхнего уровня может присутствовать или не присутствовать в кэше нижнего уровня. [21]

Существуют две политики, которые определяют способ обновления измененного блока кэша в основной памяти: сквозная запись и обратная запись. [ необходима цитата ]

В случае политики сквозной записи, всякий раз, когда изменяется значение блока кэша, оно также дополнительно модифицируется в иерархии памяти более низкого уровня. [26] Эта политика гарантирует, что данные хранятся безопасно, поскольку они записываются по всей иерархии.

Однако в случае политики обратной записи измененный блок кэша будет обновлен в иерархии нижнего уровня только при вытеснении блока кэша. «Грязный бит» прикрепляется к каждому блоку кэша и устанавливается всякий раз, когда блок кэша изменяется. [27] Во время вытеснения блоки с установленным грязным битом будут записаны в иерархию нижнего уровня. В рамках этой политики существует риск потери данных, поскольку последняя измененная копия данных хранится только в кэше, и поэтому необходимо соблюдать некоторые корректирующие методы.

В случае записи, когда байт отсутствует в блоке кэша, байт может быть перенесен в кэш, как определено политикой выделения или невыделения записи. [28] Политика выделения записи гласит, что в случае пропуска записи блок извлекается из основной памяти и помещается в кэш перед записью. [29] В политике невыделения записи, если блок отсутствует в кэше, он будет записан в иерархии памяти более низкого уровня без извлечения блока в кэш. [30]

Распространенными комбинациями политик являются «обратная запись, запись с выделением» и «сквозная запись, запись без выделения» .

Частный кэш назначается одному конкретному ядру в процессоре и не может быть доступен никаким другим ядрам. В некоторых архитектурах каждое ядро имеет свой собственный частный кэш; это создает риск дублирования блоков в архитектуре кэша системы, что приводит к снижению использования емкости. Однако этот тип выбора дизайна в архитектуре многослойного кэша также может быть хорош для более низкой задержки доступа к данным. [28] [31] [32]

Общий кэш — это кэш, к которому могут получить доступ несколько ядер. [33] Поскольку он общий, каждый блок в кэше уникален и, следовательно, имеет большую частоту попаданий, поскольку не будет дублирующихся блоков. Однако задержка доступа к данным может увеличиться, поскольку несколько ядер попытаются получить доступ к одному и тому же кэшу. [34]

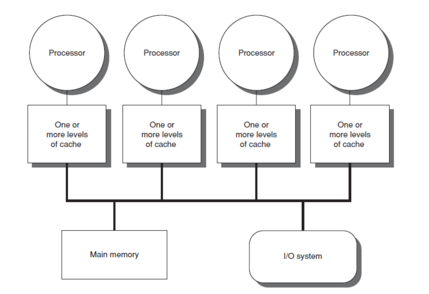

В многоядерных процессорах выбор дизайна для создания общего или частного кэша влияет на производительность процессора. [35] На практике, верхний уровень кэша L1 (или иногда L2) [36] [37] реализован как частный, а низшие уровни кэша реализованы как общие. Такая конструкция обеспечивает высокую скорость доступа для высокоуровневых кэшей и низкую скорость промахов для низкоуровневых кэшей. [35]

До 64 ядер:

6 ядер (производительность| эффективность):

96 ядер:

20 ядер (4:1 ядро «производительности» | ядро «эффективности»):

6–16 ядер:

{{cite news}}: CS1 maint: несколько имен: список авторов ( ссылка )