В статистике нелинейная регрессия — это форма регрессионного анализа , в которой данные наблюдений моделируются функцией, которая является нелинейной комбинацией параметров модели и зависит от одной или нескольких независимых переменных. Данные подгоняются методом последовательных приближений (итераций).

В нелинейной регрессии статистическая модель вида:

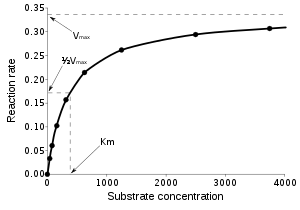

связывает вектор независимых переменных , , и его ассоциированные наблюдаемые зависимые переменные , . Функция нелинейна по компонентам вектора параметров , но в остальном произвольна. Например, модель Михаэлиса–Ментен для кинетики ферментов имеет два параметра и одну независимую переменную, связанные соотношением : [a]

Эта функция, представляющая собой прямоугольную гиперболу, является нелинейной , поскольку ее нельзя выразить как линейную комбинацию двух s.

Систематическая ошибка может присутствовать в независимых переменных, но ее обработка выходит за рамки регрессионного анализа. Если независимые переменные не свободны от ошибок, это модель с ошибками в переменных , также выходящая за рамки этого анализа.

Другие примеры нелинейных функций включают показательные функции , логарифмические функции , тригонометрические функции , степенные функции , гауссовы функции и распределения Лоренца . Некоторые функции, такие как показательные или логарифмические функции, можно преобразовать так, чтобы они стали линейными. При таком преобразовании можно выполнить стандартную линейную регрессию, но применять ее следует с осторожностью. Подробнее см. в разделе Линеаризация§Преобразование ниже.

В общем случае не существует замкнутого выражения для наиболее подходящих параметров, как в линейной регрессии . Обычно для определения наиболее подходящих параметров применяются алгоритмы численной оптимизации . Опять же, в отличие от линейной регрессии, может быть много локальных минимумов оптимизируемой функции, и даже глобальный минимум может давать смещенную оценку. На практике оценочные значения параметров используются в сочетании с алгоритмом оптимизации, чтобы попытаться найти глобальный минимум суммы квадратов.

Подробную информацию о нелинейном моделировании данных см. в разделах наименьшие квадраты и нелинейные наименьшие квадраты .

Предположение, лежащее в основе этой процедуры, заключается в том, что модель может быть аппроксимирована линейной функцией, а именно рядом Тейлора первого порядка :

где — элементы матрицы Якоби. Из этого следует, что оценки наименьших квадратов определяются как

сравнить обобщенные наименьшие квадраты с ковариационной матрицей, пропорциональной единичной матрице. Статистика нелинейной регрессии вычисляется и используется так же, как и в статистике линейной регрессии, но с использованием J вместо X в формулах.

Когда сама функция неизвестна аналитически, но ее необходимо линейно аппроксимировать с помощью или более известных значений (где — число оценщиков), наилучшая оценка получается непосредственно из линейной подгонки шаблона как [1] (см. также линейный метод наименьших квадратов ).

Линейное приближение вносит смещение в статистику. Поэтому при интерпретации статистики, полученной из нелинейной модели, требуется большая осторожность, чем обычно.

Часто предполагается, что наилучшая кривая — это та, которая минимизирует сумму квадратов остатков . Это подход обычных наименьших квадратов (OLS). Однако в случаях, когда зависимая переменная не имеет постоянной дисперсии или есть некоторые выбросы, сумма взвешенных квадратов остатков может быть минимизирована; см. взвешенные наименьшие квадраты . Каждый вес в идеале должен быть равен обратной величине дисперсии наблюдения или обратной величине зависимой переменной в некоторой степени в случае выброса [2] , но веса могут быть пересчитаны на каждой итерации в алгоритме итеративно взвешенных наименьших квадратов.

Некоторые задачи нелинейной регрессии можно перенести в линейную область путем соответствующего преобразования формулировки модели.

Например, рассмотрим задачу нелинейной регрессии

с параметрами a и b и с мультипликативным членом ошибки U. Если мы возьмем логарифм обеих сторон, это станет

где u = ln( U ), что предполагает оценку неизвестных параметров с помощью линейной регрессии ln( y ) на x , вычисление, которое не требует итеративной оптимизации. Однако использование нелинейного преобразования требует осторожности. Влияние значений данных изменится, как и структура ошибок модели и интерпретация любых выводимых результатов. Это могут быть нежелательные эффекты. С другой стороны, в зависимости от того, что является наибольшим источником ошибок, нелинейное преобразование может распределить ошибки по гауссову закону, поэтому выбор выполнения нелинейного преобразования должен быть обоснован соображениями моделирования.

Для кинетики Михаэлиса–Ментена линейный график Лайнуивера–Берка

1/ v против 1/[ S ] часто использовался. Однако, поскольку он очень чувствителен к ошибкам в данных и сильно смещен в сторону подгонки данных в определенном диапазоне независимой переменной [ S ], его использование настоятельно не рекомендуется.

Для распределений ошибок, принадлежащих к экспоненциальному семейству , можно использовать функцию связи для преобразования параметров в рамках обобщенной линейной модели .

Независимая или объясняющая переменная (например, X) может быть разделена на классы или сегменты, и линейная регрессия может быть выполнена для каждого сегмента. Сегментированная регрессия с анализом достоверности может дать результат, что зависимая или ответная переменная (например, Y) ведет себя по-разному в различных сегментах. [3]

На рисунке показано, что засоление почвы (X) изначально не оказывает никакого влияния на урожайность (Y) горчицы, пока не наступит критическое или пороговое значение ( точка разрыва ), после которого урожайность начинает ухудшаться. [4]