На веб-сайтах , которые позволяют пользователям создавать контент, модерация контента — это процесс обнаружения нерелевантных, непристойных, незаконных, вредных или оскорбительных материалов, в отличие от полезных или информативных материалов, часто для цензуры или подавления противоположных точек зрения. Цель модерации контента — удалить или применить предупреждающую метку к проблемному контенту или позволить пользователям блокировать и фильтровать контент самостоятельно. [1]

Различные типы интернет-сайтов допускают пользовательский контент, такой как посты, комментарии, видео, включая интернет-форумы , блоги и новостные сайты, работающие на скриптах, таких как phpBB , Wiki или PHP-Nuke и т. д. В зависимости от контента сайта и предполагаемой аудитории администраторы сайта решают, какие типы комментариев пользователей являются подходящими, а затем делегируют ответственность за просеивание комментариев младшим модераторам . Чаще всего они пытаются исключить троллинг , спам или флейминг , хотя это сильно различается от сайта к сайту.

Основные платформы используют комбинацию алгоритмических инструментов, сообщений пользователей и человеческого обзора. [1] Сайты социальных сетей также могут использовать модераторов контента, чтобы вручную помечать или удалять контент, помеченный как разжигающий ненависть или другой нежелательный контент. Другие проблемы с контентом включают порно мести , графический контент , материалы о жестоком обращении с детьми и пропаганду . [1] Некоторые веб-сайты также должны сделать свой контент гостеприимным для рекламы. [1]

В Соединенных Штатах модерация контента регулируется разделом 230 Закона о благопристойности в средствах массовой информации , и несколько дел по этому вопросу дошли до Верховного суда США , например, текущее дело Moody против NetChoice, LLC .

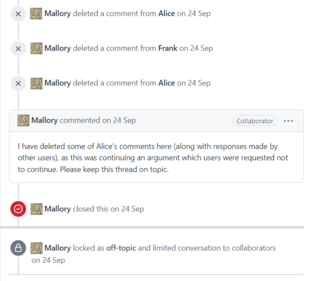

Также известная как односторонняя модерация, эта система модерации часто встречается на интернет-форумах . Группа людей выбирается администраторами сайта (обычно на долгосрочной основе) для выполнения функций делегатов, обеспечивая соблюдение правил сообщества от их имени. Эти модераторы получают особые привилегии для удаления или редактирования сообщений других лиц и/или исключения людей на основе их адреса электронной почты или IP-адреса , и, как правило, пытаются удалить негативные сообщения во всем сообществе. [2]

Модерация коммерческого контента — термин, введенный Сарой Т. Робертс для описания практики «мониторинга и проверки пользовательского контента (UGC) для социальных медиа- платформ всех типов с целью обеспечения соответствия контента правовым и нормативным требованиям, правилам сайта/сообщества, пользовательским соглашениям, а также соответствия нормам вкуса и приемлемости для данного сайта и его культурного контекста» [3] .

Индустрия модерации контента оценивается в 9 миллиардов долларов США. Хотя официальные цифры не приводятся, по оценкам, по состоянию на 2022 год в TikTok насчитывается 10 000 модераторов контента , в Facebook — 15 000, а в Twitter — 1500. [4]

Глобальная цепочка создания стоимости модерации контента обычно включает платформы социальных сетей, крупные многонациональные компании и поставщиков услуг модерации контента. Платформы социальных сетей (например, Facebook, Google) в основном базируются в Соединенных Штатах, Европе и Китае. Многонациональные компании (например, Accenture , Foiwe ) обычно имеют штаб-квартиры на глобальном севере или в Индии, в то время как поставщики услуг модерации контента в основном находятся в странах глобального юга, таких как Индия и Филиппины. [5] : 79–81

Хотя в свое время эта работа могла выполняться волонтерами в рамках интернет-сообщества, для коммерческих веб-сайтов это в значительной степени достигается путем аутсорсинга задачи специализированным компаниям, часто в регионах с низкой заработной платой, таких как Индия и Филиппины. Аутсорсинг работ по модерации контента вырос в результате бума социальных сетей . С ошеломляющим ростом пользователей и пользовательского контента компаниям требовалось гораздо больше сотрудников для модерации контента. В конце 1980-х и начале 1990-х годов технологические компании начали передавать работу на аутсорсинг в зарубежные страны, где была образованная рабочая сила, но которые были готовы работать за дешевую плату. [6]

Сотрудники работают, просматривая, оценивая и удаляя тревожный контент. [7] Wired сообщил в 2014 году, что они могут получить психологический ущерб [8] [9] [10] [2] [11] В 2017 году Guardian сообщила , что может возникнуть вторичная травма с симптомами, похожими на ПТСР . [12] Некоторые крупные компании, такие как Facebook, предлагают психологическую поддержку [12] и все больше полагаются на использование искусственного интеллекта для сортировки наиболее наглядного и ненадлежащего контента, но критики утверждают, что этого недостаточно. [13] В 2019 году NPR назвало это риском для работы. [14] Соглашения о неразглашении являются нормой при найме модераторов контента. Это заставляет модераторов более неохотно говорить об условиях работы или организации. [4]

Психологические риски, включая стресс и посттравматическое стрессовое расстройство , в сочетании с ненадежностью алгоритмического управления и низкой заработной платой делают модерацию контента чрезвычайно сложной. [15] : 123 Количество выполненных задач, например , маркировка контента как нарушающего авторские права, удаление поста, содержащего разжигание ненависти, или просмотр графического контента, количественно оценивается для обеспечения производительности и качества . [4]

В феврале 2019 года в отчете о расследовании The Verge были описаны плохие условия труда в офисе Cognizant в Финиксе , штат Аризона . [16] У сотрудников Cognizant, которым было поручено модерировать контент для Facebook, развились проблемы с психическим здоровьем , включая посттравматическое стрессовое расстройство , в результате воздействия сцен насилия , разжигания ненависти и теорий заговора в видеороликах, которые им было поручено оценивать. [16] [17] Модераторы в офисе в Финиксе сообщали о злоупотреблении наркотиками , злоупотреблении алкоголем и половых сношениях на рабочем месте и опасались возмездия со стороны уволенных работников, которые угрожали причинить им вред. [16] [18] В ответ представитель Cognizant заявил, что компания изучит проблемы, изложенные в отчете. [16]

The Verge опубликовал повторное расследование офиса Cognizant в Тампе, штат Флорида , в июне 2019 года. [19] [20] Сотрудники офиса в Тампе описали условия работы, которые были хуже, чем условия в офисе в Финиксе. [19] [21] [22]

Модераторы должны были подписать соглашения о неразглашении с Cognizant, чтобы получить работу, хотя трое бывших работников нарушили соглашения, чтобы предоставить информацию The Verge . [19] [23] В офисе в Тампе работники сообщили о нехватке ресурсов в области психического здоровья. [19] [24] В результате воздействия видеороликов, демонстрирующих откровенное насилие, жестокое обращение с животными и сексуальное насилие над детьми , у некоторых сотрудников развилась психологическая травма и посттравматическое стрессовое расстройство. [19] [25] В ответ на негативное освещение, связанное с его контрактами на модерацию контента, директор Facebook указал, что Facebook находится в процессе создания «глобальной команды по обеспечению устойчивости», которая будет помогать его подрядчикам. [19]

Facebook увеличил количество модераторов контента с 4500 до 7500 в 2017 году из-за юридических требований и других противоречий . В Германии Facebook отвечал за удаление разжигающих ненависть высказываний в течение 24 часов с момента их публикации. [26] В конце 2018 года Facebook создал надзорный совет или внутренний «Верховный суд», чтобы решать, какой контент остается, а какой удаляется. [14]

По словам Фрэнсис Хауген , по состоянию на 2021 год число сотрудников Facebook, ответственных за модерацию контента, было значительно меньше. [27]

Социальная сеть Twitter имеет политику приостановки . В период с августа 2015 года по декабрь 2017 года она заблокировала более 1,2 миллиона аккаунтов за террористический контент, чтобы сократить количество подписчиков и объем контента, связанного с Исламским государством. [28] После приобретения Twitter Илоном Маском в октябре 2022 года правила в отношении контента были ослаблены на всей платформе в попытке отдать приоритет свободе слова. [29] Однако последствия этой кампании были поставлены под сомнение. [30] [31]

Модерация пользователей позволяет любому пользователю модерировать вклады любого другого пользователя. Миллиарды людей в настоящее время ежедневно принимают решения о том, чем поделиться, что переслать или что сделать видимым. [32] На большом сайте с достаточно большой активной аудиторией это обычно работает хорошо, поскольку относительно небольшое количество нарушителей спокойствия отсеивается голосами остального сообщества.

Пользовательская модерация также может быть охарактеризована как реактивная модерация. Этот тип модерации зависит от пользователей платформы или сайта, которые сообщают о контенте, который является ненадлежащим и нарушает стандарты сообщества . В этом процессе, когда пользователи сталкиваются с изображением или видео, которые они считают неподходящими, они могут нажать кнопку «пожаловаться». Жалоба подается и ставится в очередь для рассмотрения модераторами. [33]

150 модераторов контента, заключивших контракты с Meta , ByteDance и OpenAI, собрались в Найроби, Кения, чтобы 1 мая 2023 года основать первый африканский профсоюз модераторов контента. Этот профсоюз был создан через 4 года после того, как Дэниел Мотаунг был уволен и подвергся репрессиям за организацию профсоюза в Sama , которая заключила контракты с Facebook. [34]