Анализ главных компонент ( PCA ) — это метод линейного снижения размерности , применяемый в разведочном анализе данных , визуализации и предварительной обработке данных .

Данные линейно преобразуются в новую систему координат таким образом, чтобы можно было легко определить направления (главные компоненты), отражающие наибольшие вариации в данных.

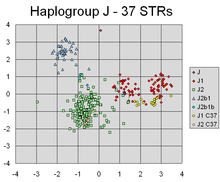

Главные компоненты набора точек в реальном координатном пространстве представляют собой последовательность единичных векторов , где -й вектор представляет собой направление линии, которая наилучшим образом соответствует данным, будучи ортогональной первым векторам. Здесь наилучшая подходящая линия определяется как та, которая минимизирует среднеквадратичное перпендикулярное расстояние от точек до линии . Эти направления (т. е. главные компоненты) составляют ортонормальный базис , в котором различные индивидуальные измерения данных линейно не коррелируют . Во многих исследованиях первые два главных компонента используются для того, чтобы построить данные в двух измерениях и визуально идентифицировать кластеры тесно связанных точек данных. [1]

Анализ главных компонент применяется во многих областях, таких как популяционная генетика , исследования микробиома и атмосферные науки .

При выполнении PCA первый главный компонент набора переменных — это производная переменная, сформированная как линейная комбинация исходных переменных, которая объясняет большую часть дисперсии. Второй главный компонент объясняет большую часть дисперсии в том, что осталось после удаления эффекта первого компонента, и мы можем продолжать итерации, пока вся дисперсия не будет объяснена. PCA чаще всего используется, когда многие переменные сильно коррелируют друг с другом и желательно сократить их количество до независимого набора. Первый главный компонент можно эквивалентно определить как направление, которое максимизирует дисперсию прогнозируемых данных. -й главный компонент можно взять как направление, ортогональное первым главным компонентам, которое максимизирует дисперсию прогнозируемых данных.

Для любой цели можно показать, что главные компоненты являются собственными векторами ковариационной матрицы данных . Таким образом, главные компоненты часто вычисляются путем разложения на собственные векторы ковариационной матрицы данных или разложения по сингулярным значениям матрицы данных. PCA является простейшим из истинно собственных векторов многомерного анализа и тесно связан с факторным анализом . Факторный анализ обычно включает в себя более специфичные для домена предположения о базовой структуре и решает собственные векторы немного другой матрицы. PCA также связан с каноническим корреляционным анализом (CCA) . CCA определяет системы координат, которые оптимально описывают кросс-ковариацию между двумя наборами данных, в то время как PCA определяет новую ортогональную систему координат , которая оптимально описывает дисперсию в одном наборе данных. [2] [3] [4] [5] Также были предложены надежные и основанные на L1-норме варианты стандартного PCA. [6] [7] [8] [5]

PCA был изобретен в 1901 году Карлом Пирсоном [ 9] как аналог теоремы о главной оси в механике; позднее он был независимо разработан и назван Гарольдом Хотеллингом в 1930-х годах. [10] В зависимости от области применения его также называют дискретным преобразованием Карунена–Лоэва (KLT) в обработке сигналов , преобразованием Хотеллинга в многомерном контроле качества, правильным ортогональным разложением (POD) в машиностроении, сингулярным разложением (SVD) X (изобретено в последней четверти 19 века [11] ), разложением по собственным значениям (EVD) X T X в линейной алгебре, факторным анализом (для обсуждения различий между PCA и факторным анализом см. гл. 7 Анализа главных компонент Джоллиффа ), [12] теоремой Эккарта–Янга (Harman, 1960) или эмпирическими ортогональными функциями (EOF) в метеорологической науке (Lorenz, 1956), эмпирическим разложением собственных функций (Sirovich, 1987), квазигармоническими модами (Brooks et al., 1988), спектральным разложением в шуме и вибрации и эмпирическим модальный анализ в структурной динамике.

PCA можно рассматривать как подгонку p -мерного эллипсоида к данным, где каждая ось эллипсоида представляет собой главный компонент. Если какая-то ось эллипсоида мала, то дисперсия вдоль этой оси также мала.

Чтобы найти оси эллипсоида, мы должны сначала центрировать значения каждой переменной в наборе данных на 0, вычитая среднее значение наблюдаемых значений переменной из каждого из этих значений. Эти преобразованные значения используются вместо исходных наблюдаемых значений для каждой из переменных. Затем мы вычисляем ковариационную матрицу данных и вычисляем собственные значения и соответствующие собственные векторы этой ковариационной матрицы. Затем мы должны нормализовать каждый из ортогональных собственных векторов, чтобы превратить их в единичные векторы. После этого каждый из взаимно ортогональных единичных собственных векторов можно интерпретировать как ось эллипсоида, подобранного к данным. Этот выбор базиса преобразует ковариационную матрицу в диагонализованную форму, в которой диагональные элементы представляют дисперсию каждой оси. Доля дисперсии, которую представляет каждый собственный вектор, может быть вычислена путем деления собственного значения, соответствующего этому собственному вектору, на сумму всех собственных значений.

Для интерпретации результатов PCA используются биплоты и графики каменистой осыпи (степень объясненной дисперсии ).

PCA определяется как ортогональное линейное преобразование в пространстве действительных внутренних произведений , которое преобразует данные в новую систему координат таким образом, что наибольшая дисперсия некоторой скалярной проекции данных приходится на первую координату (называемую первым главным компонентом), вторая по величине дисперсия — на вторую координату и т. д. [12]

Рассмотрим матрицу данных X с нулевым эмпирическим средним значением по столбцам ( выборочное среднее значение каждого столбца смещено к нулю), где каждая из n строк представляет собой различное повторение эксперимента, а каждый из p столбцов дает определенный вид характеристики (например, результаты с определенного датчика).

Математически преобразование определяется набором p - мерных векторов весов или коэффициентов , которые отображают каждый вектор-строку X в новый вектор оценок главных компонент , заданный как

таким образом, что отдельные переменные t , рассматриваемые по набору данных, последовательно наследуют максимально возможную дисперсию от X , при этом каждый вектор коэффициентов w ограничен единичным вектором (где обычно выбирается строго меньше, чем для уменьшения размерности).

Вышесказанное можно эквивалентно записать в матричной форме как

где , , и .

Чтобы максимизировать дисперсию, первый весовой вектор w (1) должен удовлетворять условию

Эквивалентно, запись этого в матричной форме дает

Поскольку w (1) определен как единичный вектор, он эквивалентно также удовлетворяет условию

Максимизируемая величина может быть распознана как отношение Рэлея . Стандартный результат для положительной полуопределенной матрицы, такой как X T X, заключается в том, что максимально возможное значение отношения является наибольшим собственным значением матрицы, что происходит, когда w является соответствующим собственным вектором .

После нахождения w (1) первый главный компонент вектора данных x ( i ) может быть представлен как оценка t 1( i ) = x ( i ) ⋅ w (1) в преобразованных координатах или как соответствующий вектор в исходных переменных, { x ( i ) ⋅ w (1) } w (1) .

K - й компонент можно найти, вычитая первые k − 1 главных компонентов из X :

и затем нахождение вектора веса, который извлекает максимальную дисперсию из этой новой матрицы данных

Оказывается, это дает оставшиеся собственные векторы X T X , причем максимальные значения для величины в скобках даны их соответствующими собственными значениями. Таким образом, весовые векторы являются собственными векторами X T X .

Следовательно, k - й главный компонент вектора данных x ( i ) может быть задан как оценка tk ( i ) = x ( i ) ⋅ w ( k ) в преобразованных координатах или как соответствующий вектор в пространстве исходных переменных, { x ( i ) ⋅ w ( k ) } w ( k ) , где w ( k ) — k - й собственный вектор XTX .

Полное разложение главных компонентов X , таким образом, можно представить как

где W — это матрица весов размером p на p , столбцы которой являются собственными векторами X T X . Транспонирование W иногда называют преобразованием отбеливания или сферизации . Столбцы W , умноженные на квадратный корень соответствующих собственных значений, то есть собственные векторы, масштабированные дисперсиями, называются нагрузками в PCA или в факторном анализе.

X T X сам по себе может быть признан пропорциональным эмпирической выборочной ковариационной матрице набора данных X T . [12] : 30–31

Выборочная ковариация Q между двумя различными главными компонентами в наборе данных определяется по формуле:

где свойство собственного значения w ( k ) было использовано для перехода от строки 2 к строке 3. Однако собственные векторы w ( j ) и w ( k ), соответствующие собственным значениям симметричной матрицы, являются ортогональными (если собственные значения различны) или могут быть ортогонализованы (если векторы имеют одинаковое повторяющееся значение). Таким образом, произведение в последней строке равно нулю; между различными главными компонентами в наборе данных нет выборочной ковариации.

Другой способ охарактеризовать преобразование главных компонент — это преобразование в координаты, которые диагонализируют эмпирическую выборочную ковариационную матрицу.

В матричной форме эмпирическую ковариационную матрицу для исходных переменных можно записать

Эмпирическая ковариационная матрица между главными компонентами становится

где Λ — диагональная матрица собственных значений λ ( k ) матрицы X T X . λ ( k ) равна сумме квадратов по набору данных, связанному с каждым компонентом k , то есть λ ( k ) = Σ i t k 2 ( i ) = Σ i ( x ( i ) ⋅ w ( k ) ) 2 .

Преобразование T = X W отображает вектор данных x ( i ) из исходного пространства p переменных в новое пространство p переменных, которые не коррелируют по набору данных. Однако не все главные компоненты должны быть сохранены. Сохранение только первых L главных компонентов, полученных с использованием только первых L собственных векторов, дает усеченное преобразование

где матрица T L теперь имеет n строк, но только L столбцов. Другими словами, PCA изучает линейное преобразование , где столбцы матрицы p × L образуют ортогональный базис для L признаков (компонентов представления t ), которые декоррелированы. [13] По построению, из всех преобразованных матриц данных только с L столбцами, эта матрица оценок максимизирует дисперсию в исходных данных, которые были сохранены, при этом минимизируя общую квадратичную ошибку реконструкции или .

Такое уменьшение размерности может быть очень полезным шагом для визуализации и обработки многомерных наборов данных, при этом сохраняя как можно больше дисперсии в наборе данных. Например, выбор L = 2 и сохранение только первых двух главных компонентов находит двумерную плоскость через многомерный набор данных, в которой данные наиболее разбросаны, поэтому, если данные содержат кластеры, они также могут быть наиболее разбросаны и, следовательно, наиболее заметны для отображения на двумерной диаграмме; тогда как, если два направления через данные (или две исходные переменные) выбираются случайным образом, кластеры могут быть гораздо менее разбросаны друг от друга и фактически могут с большей вероятностью существенно перекрывать друг друга, делая их неразличимыми.

Аналогично, в регрессионном анализе , чем больше допустимое количество объясняющих переменных , тем больше вероятность переобучения модели, что приводит к выводам, которые не могут быть обобщены на другие наборы данных. Один из подходов, особенно когда есть сильные корреляции между различными возможными объясняющими переменными, состоит в том, чтобы свести их к нескольким главным компонентам, а затем запустить регрессию против них, метод, называемый регрессией главных компонентов .

Снижение размерности также может быть уместным, когда переменные в наборе данных зашумлены. Если каждый столбец набора данных содержит независимый одинаково распределенный гауссовский шум, то столбцы T также будут содержать аналогично одинаково распределенный гауссовский шум (такое распределение инвариантно относительно эффектов матрицы W , которую можно рассматривать как высокоразмерное вращение осей координат). Однако, при большей концентрации общей дисперсии в первых нескольких главных компонентах по сравнению с той же дисперсией шума, пропорциональный эффект шума меньше — первые несколько компонентов достигают более высокого отношения сигнал/шум . Таким образом, PCA может иметь эффект концентрации большей части сигнала в первых нескольких главных компонентах, которые могут быть полезно уловлены снижением размерности; в то время как более поздние главные компоненты могут быть захвачены шумом и, таким образом, удалены без больших потерь. Если набор данных не слишком большой, значимость главных компонентов можно проверить с помощью параметрического бутстрапа , как помощь в определении того, сколько главных компонентов следует сохранить. [14]

Преобразование главных компонент может быть также связано с другой матричной факторизацией, сингулярным разложением (SVD) X ,

Здесь Σ — прямоугольная диагональная матрица размером n на p положительных чисел σ ( k ) , называемых сингулярными значениями X ; U — матрица размером n на n , столбцы которой являются ортогональными единичными векторами длины n, называемыми левыми сингулярными векторами X ; а W — матрица размером p на p , столбцы которой являются ортогональными единичными векторами длины p и называются правыми сингулярными векторами X .

В терминах этой факторизации матрицу X T X можно записать

где — квадратная диагональная матрица с сингулярными значениями X и обрезанными лишними нулями, удовлетворяющая . Сравнение с факторизацией собственных векторов X T X устанавливает, что правые сингулярные векторы W матрицы X эквивалентны собственным векторам X T X , в то время как сингулярные значения σ ( k ) матрицы X T X равны квадратному корню из собственных значений λ ( k ) матрицы X T X .

Используя разложение сингулярных значений, матрицу оценок T можно записать в виде

поэтому каждый столбец T задается одним из левых сингулярных векторов X , умноженным на соответствующее сингулярное значение. Эта форма также является полярным разложением T.

Существуют эффективные алгоритмы для расчета SVD для X без необходимости формирования матрицы X T X , поэтому вычисление SVD в настоящее время является стандартным способом расчета анализа главных компонентов из матрицы данных [15] , если только не требуется только несколько компонентов.

Как и в случае с собственным разложением, усеченную матрицу оценок T L размером n × L можно получить, рассматривая только первые L наибольших сингулярных значений и их сингулярные векторы:

Усечение матрицы M или T с использованием усеченного сингулярного разложения таким образом дает усеченную матрицу, которая является ближайшей возможной матрицей ранга L к исходной матрице в том смысле, что разница между ними имеет наименьшую возможную норму Фробениуса , результат, известный как теорема Эккарта–Янга [1936].

Сингулярные значения (в Σ ) являются квадратными корнями собственных значений матрицы X T X . Каждое собственное значение пропорционально части «дисперсии» (точнее, суммы квадратов расстояний точек от их многомерного среднего), которая связана с каждым собственным вектором. Сумма всех собственных значений равна сумме квадратов расстояний точек от их многомерного среднего. PCA по сути вращает набор точек вокруг их среднего значения, чтобы выровнять с главными компонентами. Это перемещает как можно большую часть дисперсии (используя ортогональное преобразование) в первые несколько измерений. Поэтому значения в остальных измерениях, как правило, малы и могут быть отброшены с минимальной потерей информации (см. ниже ). PCA часто используется таким образом для снижения размерности . PCA отличается тем, что является оптимальным ортогональным преобразованием для сохранения подпространства с наибольшей «дисперсией» (как определено выше). Однако это преимущество достигается за счет более высоких вычислительных требований по сравнению, например, с дискретным косинусным преобразованием , и в частности с DCT-II, которое просто известно как «DCT». Нелинейные методы снижения размерности, как правило, более требовательны к вычислительным ресурсам, чем PCA.

PCA чувствителен к масштабированию переменных. Если у нас есть только две переменные, и они имеют одинаковую дисперсию выборки и полностью коррелированы, то PCA повлечет за собой поворот на 45°, и «веса» (они являются косинусами поворота) для двух переменных относительно главного компонента будут равны. Но если мы умножим все значения первой переменной на 100, то первый главный компонент будет почти таким же, как эта переменная, с небольшим вкладом от другой переменной, тогда как второй компонент будет почти выровнен со второй исходной переменной. Это означает, что всякий раз, когда разные переменные имеют разные единицы (например, температуру и массу), PCA является несколько произвольным методом анализа. (Разные результаты были бы получены, если бы кто-то использовал градусы Фаренгейта, а не Цельсия, например.) Оригинальная статья Пирсона была озаглавлена «О линиях и плоскостях наиболее близкого соответствия системам точек в пространстве» — «в пространстве» подразумевает физическое евклидово пространство, где такие проблемы не возникают. Один из способов сделать PCA менее произвольным — использовать переменные, масштабированные так, чтобы иметь единичную дисперсию, путем стандартизации данных и, следовательно, использовать автокорреляционную матрицу вместо автоковариационной матрицы в качестве основы для PCA. Однако это сжимает (или расширяет) флуктуации во всех измерениях сигнального пространства до единичной дисперсии.

Вычитание среднего (также известное как «центрирование среднего») необходимо для выполнения классического PCA, чтобы гарантировать, что первый главный компонент описывает направление максимальной дисперсии. Если вычитание среднего не выполняется, первый главный компонент может вместо этого соответствовать более или менее среднему значению данных. Нулевое среднее значение необходимо для нахождения базиса, который минимизирует среднеквадратичную ошибку аппроксимации данных. [16]

Центрирование среднего не нужно, если выполняется анализ главных компонентов на корреляционной матрице, так как данные уже центрированы после вычисления корреляций. Корреляции выводятся из перекрестного произведения двух стандартных оценок (Z-оценок) или статистических моментов (отсюда и название: корреляция Пирсона по продукту и моменту ). Также см. статью Кромри и Фостера-Джонсона (1998) "Центрирование среднего в умеренной регрессии: много шума из ничего" . Поскольку ковариации являются корреляциями нормализованных переменных ( Z- или стандартных оценок ), PCA, основанный на корреляционной матрице X , равен PCA , основанному на ковариационной матрице Z , стандартизированной версии X.

PCA — популярный первичный метод распознавания образов . Однако он не оптимизирован для разделения классов. [17] Однако он использовался для количественной оценки расстояния между двумя или более классами путем вычисления центра масс для каждого класса в пространстве главных компонент и предоставления евклидового расстояния между центрами масс двух или более классов. [18] Линейный дискриминантный анализ — это альтернатива, оптимизированная для разделения классов.

Некоторые свойства PCA включают: [12] [ нужна страница ]

Статистическое значение этого свойства заключается в том, что последние несколько PC не являются просто неструктурированными остатками после удаления важных PC. Поскольку эти последние PC имеют наименьшие возможные дисперсии, они полезны сами по себе. Они могут помочь обнаружить неожиданные почти постоянные линейные отношения между элементами x , и они также могут быть полезны в регрессии , при выборе подмножества переменных из x и при обнаружении выбросов.

Прежде чем рассмотреть его использование, сначала рассмотрим диагональные элементы,

Тогда, возможно, главное статистическое значение результата заключается в том, что мы не только можем разложить объединенные дисперсии всех элементов x на убывающие вклады, обусловленные каждым PC, но мы также можем разложить всю ковариационную матрицу на вклады от каждого PC. Хотя элементы не являются строго убывающими, они будут иметь тенденцию становиться меньше по мере увеличения, как и не увеличиваются при увеличении , тогда как элементы имеют тенденцию оставаться примерно того же размера из-за ограничений нормализации: .

Как отмечено выше, результаты PCA зависят от масштабирования переменных. Это можно исправить, масштабируя каждую характеристику по ее стандартному отклонению, так что в итоге получим безразмерные характеристики с единичной дисперсией. [19]

Применимость PCA, как описано выше, ограничена определенными (молчаливыми) предположениями [20], сделанными при его выводе. В частности, PCA может улавливать линейные корреляции между признаками, но терпит неудачу, когда это предположение нарушается (см. Рисунок 6a в ссылке). В некоторых случаях преобразования координат могут восстановить предположение о линейности, и тогда PCA может быть применен (см. ядро PCA ).

Другим ограничением является процесс удаления среднего значения перед построением ковариационной матрицы для PCA. В таких областях, как астрономия, все сигналы неотрицательны, и процесс удаления среднего значения заставит среднее значение некоторых астрофизических экспозиций стать равным нулю, что, следовательно, создает нефизические отрицательные потоки, [21] и для восстановления истинной величины сигналов необходимо выполнить прямое моделирование. [22] В качестве альтернативного метода можно использовать неотрицательную матричную факторизацию, фокусирующуюся только на неотрицательных элементах в матрицах, что хорошо подходит для астрофизических наблюдений. [23] [24] [25] Подробнее см. в разделе Связь между PCA и неотрицательной матричной факторизацией.

PCA находится в невыгодном положении, если данные не были стандартизированы до применения к ним алгоритма. PCA преобразует исходные данные в данные, которые соответствуют основным компонентам этих данных, что означает, что новые переменные данных не могут быть интерпретированы теми же способами, что и исходные. Они являются линейными интерпретациями исходных переменных. Кроме того, если PCA не выполняется должным образом, существует высокая вероятность потери информации. [26]

PCA опирается на линейную модель. Если в наборе данных есть скрытый нелинейный шаблон, то PCA может фактически направить анализ в совершенно противоположном направлении прогресса. [27] [ нужна страница ] Исследователи из Университета штата Канзас обнаружили, что ошибка выборки в их экспериментах повлияла на смещение результатов PCA. «Если количество субъектов или блоков меньше 30 и/или исследователь заинтересован в PC за пределами первого, может быть лучше сначала исправить серийную корреляцию, прежде чем проводить PCA». [28] Исследователи из Университета штата Канзас также обнаружили, что PCA может быть «серьезно смещенным, если структура автокорреляции данных обрабатывается неправильно». [28]

Уменьшение размерности приводит к потере информации в целом. Уменьшение размерности на основе PCA имеет тенденцию минимизировать эту потерю информации при определенных моделях сигнала и шума.

При условии, что

то есть, что вектор данных представляет собой сумму желаемого информационного сигнала и шумового сигнала, можно показать, что PCA может быть оптимальным для снижения размерности с точки зрения теории информации.

В частности, Линскер показал, что если является гауссовым и является гауссовым шумом с ковариационной матрицей, пропорциональной единичной матрице, то PCA максимизирует взаимную информацию между желаемой информацией и выходными данными с уменьшенной размерностью . [29]

Если шум по-прежнему является гауссовым и имеет ковариационную матрицу, пропорциональную единичной матрице (то есть компоненты вектора являются iid ), но несущий информацию сигнал не является гауссовым (что является распространенным сценарием), PCA по крайней мере минимизирует верхнюю границу потери информации , которая определяется как [30] [31]

Оптимальность PCA также сохраняется, если шум является независимым и, по крайней мере, более гауссовым (в терминах расхождения Кульбака–Лейблера ), чем несущий информацию сигнал . [32] В общем случае, даже если приведенная выше модель сигнала верна, PCA теряет свою оптимальность с точки зрения теории информации, как только шум становится зависимым.

Ниже приведено подробное описание PCA с использованием метода ковариации [33] в отличие от метода корреляции. [34]

Цель состоит в том, чтобы преобразовать заданный набор данных X размерности p в альтернативный набор данных Y меньшей размерности L. Эквивалентно, мы пытаемся найти матрицу Y , где Y — это преобразование Карунена–Лоэва (KLT) матрицы X :

Предположим, у вас есть данные, включающие набор наблюдений p переменных, и вы хотите сократить данные так, чтобы каждое наблюдение можно было описать только с помощью L переменных, L < p . Предположим далее, что данные организованы как набор из n векторов данных , каждый из которых представляет собой одно сгруппированное наблюдение p переменных.

Вычитание среднего является неотъемлемой частью решения по поиску основного компонентного базиса, который минимизирует среднеквадратичную ошибку аппроксимации данных. [35] Поэтому мы действуем, центрируя данные следующим образом:

В некоторых приложениях каждая переменная (столбец B ) также может быть масштабирована, чтобы иметь дисперсию, равную 1 (см. Z-оценку ). [36] Этот шаг влияет на вычисляемые главные компоненты, но делает их независимыми от единиц, используемых для измерения различных переменных.

Пусть X — d -мерный случайный вектор, выраженный как вектор-столбец. Без потери общности предположим, что X имеет нулевое среднее значение.

Мы хотим найти матрицу ортонормального преобразования P размером d × d , чтобы PX имел диагональную ковариационную матрицу (то есть PX — это случайный вектор, все отдельные компоненты которого попарно некоррелированы).

Быстрый расчет, предполагающий единичную доходность:

Следовательно, выполняется тогда и только тогда, когда диагонализируется с помощью .

Это очень конструктивно, поскольку cov( X ) гарантированно является неотрицательно определенной матрицей и, таким образом, гарантированно диагонализируется некоторой унитарной матрицей.

В практических реализациях, особенно с данными высокой размерности (большие p ), наивный ковариационный метод используется редко, поскольку он неэффективен из-за высоких вычислительных и затрат памяти на явное определение ковариационной матрицы. Ковариационный подход без ковариации избегает np 2 операций явного вычисления и хранения ковариационной матрицы X T X , вместо этого используя один из безматричных методов , например, основанный на функции, оценивающей произведение X T (X r) за счет 2 np операций.

Один из способов эффективного вычисления первого главного компонента [41] показан в следующем псевдокоде для матрицы данных X с нулевым средним значением, без вычисления ее ковариационной матрицы.

r = случайный вектор длины p r = r / norm( r )сделать c раз: s = 0 (вектор длины p ) для каждой строки x в X s = s + ( x ⋅ r ) x λ = r T s // λ — собственное значение ошибка = |λ ⋅ r − s | r = s / norm( s ) выход, если ошибка < допуска возврат λ, r

Этот алгоритм итерации мощности просто вычисляет вектор X T (X r) , нормализует и помещает результат обратно в r . Собственное значение аппроксимируется r T (X T X) r , что является отношением Рэлея к единичному вектору r для ковариационной матрицы X T X . Если наибольшее сингулярное значение хорошо отделено от следующего по величине, вектор r приближается к первому главному компоненту X в пределах числа итераций c , которое мало по сравнению с p , при общей стоимости 2cnp . Сходимость итерации мощности можно ускорить без заметного ущерба для малой стоимости на итерацию, используя более продвинутые методы без матриц , такие как алгоритм Ланцоша или метод локально оптимального блочного предобусловленного сопряженного градиента ( LOBPCG ).

Последующие главные компоненты могут быть вычислены по одному с помощью дефляции или одновременно как блок. В первом подходе неточности в уже вычисленных приближенных главных компонентах аддитивно влияют на точность впоследствии вычисленных главных компонентов, тем самым увеличивая ошибку с каждым новым вычислением. Последний подход в методе блочной мощности заменяет отдельные векторы r и s на блочные векторы, матрицы R и S. Каждый столбец R аппроксимирует один из ведущих главных компонентов, в то время как все столбцы итерируются одновременно. Основным вычислением является оценка продукта X T (XR) . Реализованная, например, в LOBPCG , эффективная блокировка устраняет накопление ошибок, позволяет использовать высокоуровневые функции произведения матриц BLAS и, как правило, приводит к более быстрой сходимости по сравнению с методом одиночного вектора по одному.

Нелинейный итеративный метод частичных наименьших квадратов (NIPALS) — это вариант классической степенной итерации с матричной дефляцией вычитанием, реализованный для вычисления первых нескольких компонентов в анализе главных компонент или частичных наименьших квадратов . Для очень многомерных наборов данных, таких как те, которые генерируются в науках *omics (например, геномика , метаболомика ), обычно необходимо вычислить только первые несколько PC. Алгоритм нелинейных итерационных методов частичных наименьших квадратов (NIPALS) обновляет итерационные приближения к ведущим оценкам и нагрузкам t 1 и r 1 T с помощью степенной итерации , умножающейся на каждой итерации на X слева и справа, то есть вычисление ковариационной матрицы избегается, как и в безматричной реализации степенных итераций до X T X на основе функции, оценивающей произведение X T (X r) = ((X r) T X) T .

Дефляция матрицы вычитанием выполняется путем вычитания внешнего произведения t 1 r 1 T из X, оставляя дефлированную остаточную матрицу, используемую для вычисления последующих ведущих PC. [42] Для больших матриц данных или матриц с высокой степенью коллинеарности столбцов NIPALS страдает от потери ортогональности PC из-за ошибок округления точности машины , накопленных в каждой итерации, и дефляции матрицы вычитанием. [43] Алгоритм повторной ортогонализации Грама-Шмидта применяется как к оценкам, так и к нагрузкам на каждом шаге итерации, чтобы устранить эту потерю ортогональности. [44] Зависимость NIPALS от умножения отдельных векторов не может использовать преимущества высокоуровневого BLAS и приводит к медленной сходимости для кластеризованных ведущих сингулярных значений — оба этих недостатка устраняются в более сложных решателях без матриц, таких как метод локально-оптимального блочного предобусловленного сопряженного градиента ( LOBPCG ).

В ситуации «онлайн» или «потоковой передачи», когда данные поступают по частям, а не хранятся в едином пакете, полезно сделать оценку проекции PCA, которая может обновляться последовательно. Это можно сделать эффективно, но для этого требуются другие алгоритмы. [45]

В PCA часто мы хотим ввести качественные переменные в качестве дополнительных элементов. Например, многие количественные переменные были измерены на растениях. Для этих растений некоторые качественные переменные доступны, например, вид, к которому принадлежит растение. Эти данные были подвергнуты PCA для количественных переменных. При анализе результатов естественно связать главные компоненты с качественными переменными вида . Для этого получены следующие результаты.

Эти результаты являются тем, что называется введением качественной переменной как дополнительного элемента . Эта процедура подробно описана в и Husson, Lê, & Pagès (2009) и Pagès (2013). Немногие программы предлагают эту опцию «автоматическим» способом. Это случай SPAD, который исторически, следуя работе Людовика Лебарта , был первым, кто предложил эту опцию, и пакет R FactoMineR.

Самым ранним применением факторного анализа было определение и измерение компонентов человеческого интеллекта. Считалось, что интеллект имеет различные некоррелированные компоненты, такие как пространственный интеллект, вербальный интеллект, индукция, дедукция и т. д., и что оценки по ним могут быть получены с помощью факторного анализа из результатов различных тестов, чтобы дать единый индекс, известный как коэффициент интеллекта (IQ). Пионер статистического психолога Спирмен фактически разработал факторный анализ в 1904 году для своей двухфакторной теории интеллекта, добавив формальную технику к науке психометрии . В 1924 году Терстоун искал 56 факторов интеллекта, разработав понятие умственного возраста. Стандартные тесты IQ сегодня основаны на этой ранней работе. [46]

В 1949 году Шевки и Уильямс представили теорию факторной экологии , которая доминировала в исследованиях дифференциации жилых помещений с 1950-х по 1970-е годы. [47] Районы в городе были узнаваемы или могли отличаться друг от друга по различным характеристикам, которые можно было свести к трем с помощью факторного анализа. Они были известны как «социальный ранг» (индекс профессионального статуса), «семейность» или размер семьи и «этническая принадлежность»; Затем кластерный анализ можно было применить для разделения города на кластеры или районы в соответствии со значениями трех ключевых факторных переменных. Вокруг факторной экологии в городской географии возникла обширная литература, но этот подход вышел из моды после 1980 года, поскольку был методологически примитивным и имел мало места в постмодернистских географических парадигмах.

Одной из проблем факторного анализа всегда был поиск убедительных названий для различных искусственных факторов. В 2000 году Флуд возродил подход факторной экологии, чтобы показать, что анализ главных компонентов на самом деле давал содержательные ответы напрямую, не прибегая к ротации факторов. Главные компоненты на самом деле были двойными переменными или теневыми ценами «сил», сближающих или разделяющих людей в городах. Первым компонентом была «доступность», классический компромисс между спросом на поездки и спросом на пространство, вокруг которого базируется классическая городская экономика. Следующими двумя компонентами были «недостаток», который удерживает людей с одинаковым статусом в отдельных районах (опосредованно планированием), и этническая принадлежность, где люди с одинаковым этническим происхождением пытаются совместно проживать. [48]

Примерно в то же время Австралийское бюро статистики определило отдельные индексы преимуществ и недостатков, взяв первый главный компонент наборов ключевых переменных, которые считались важными. Эти индексы SEIFA регулярно публикуются для различных юрисдикций и часто используются в пространственном анализе. [49]

PCA может использоваться как формальный метод для разработки индексов. В качестве альтернативы был предложен подтверждающий композитный анализ для разработки и оценки индексов. [50]

Индекс развития города был разработан PCA из примерно 200 показателей результатов города в исследовании 254 городов мира в 1996 году. Первый главный компонент был подвергнут итеративной регрессии, добавляя исходные переменные по отдельности до тех пор, пока не было учтено около 90% его вариации. Индекс в конечном итоге использовал около 15 показателей, но был хорошим предиктором гораздо большего количества переменных. Его сравнительное значение очень хорошо согласовывалось с субъективной оценкой состояния каждого города. Коэффициенты по элементам инфраструктуры были примерно пропорциональны средним затратам на предоставление базовых услуг, что говорит о том, что индекс на самом деле был мерой эффективных физических и социальных инвестиций в город.

Индекс развития человеческого потенциала (ИРЧП) на уровне страны от ПРООН , который публикуется с 1990 года и очень широко используется в исследованиях развития, [51] имеет очень похожие коэффициенты по аналогичным показателям, что убедительно свидетельствует о том, что изначально он был построен с использованием PCA.

В 1978 году Кавалли-Сфорца и другие стали пионерами использования анализа главных компонент (PCA) для обобщения данных об изменении частот человеческих генов в разных регионах. Компоненты показали отличительные закономерности, включая градиенты и синусоидальные волны. Они интерпретировали эти закономерности как результат определенных древних миграционных событий.

С тех пор PCA повсеместно используется в популяционной генетике, и тысячи статей используют PCA в качестве механизма отображения. Генетика сильно варьируется в зависимости от близости, поэтому первые два главных компонента фактически показывают пространственное распределение и могут использоваться для картирования относительного географического положения различных групп населения, тем самым показывая особей, которые ушли из своих первоначальных мест. [52]

PCA в генетике был технически спорным, поскольку метод применялся к дискретным ненормальным переменным и часто к бинарным аллельным маркерам. Отсутствие каких-либо мер стандартной ошибки в PCA также является препятствием для более последовательного использования. В августе 2022 года молекулярный биолог Эран Элхаик опубликовал теоретическую статью в Scientific Reports, в которой анализировал 12 приложений PCA. Он пришел к выводу, что было легко манипулировать методом, который, по его мнению, давал результаты, которые были «ошибочными, противоречивыми и абсурдными». В частности, он утверждал, что результаты, достигнутые в популяционной генетике, характеризовались выборочным подходом и круговыми рассуждениями . [53]

Маркетинговые исследования широко используют PCA. Он используется для разработки оценок удовлетворенности клиентов или лояльности клиентов к продуктам, а также с кластеризацией для разработки сегментов рынка, которые могут быть направлены на рекламные кампании, во многом так же, как факторная экология будет определять географические области со схожими характеристиками. [54]

PCA быстро преобразует большие объемы данных в меньшие, более простые для усвоения переменные, которые можно быстрее и проще анализировать. В любой потребительской анкете есть ряд вопросов, разработанных для выявления потребительских установок, а главные компоненты ищут скрытые переменные, лежащие в основе этих установок. Например, в Оксфордском интернет-обследовании в 2013 году 2000 человек были опрошены об их установках и убеждениях, и из этих данных аналитики извлекли четыре главных компонента измерений, которые они определили как «побег», «социальные сети», «эффективность» и «создание проблем». [55]

Другой пример от Джо Флуда в 2008 году: индекс отношения к жилью был извлечен из 28 вопросов об отношении в национальном опросе 2697 домохозяйств в Австралии. Первый главный компонент представлял общее отношение к собственности и владению домом. Индекс или вопросы отношения, которые он воплощал, могли быть введены в общую линейную модель выбора права собственности. Самым сильным фактором, определяющим частную аренду, был индекс отношения, а не доход, семейное положение или тип домохозяйства. [56]

В количественной финансах PCA используется [57] в управлении финансовыми рисками и применяется к другим проблемам, таким как оптимизация портфеля .

PCA обычно используется в задачах, связанных с ценными бумагами и портфелями с фиксированным доходом , а также производными инструментами по процентным ставкам . Оценки здесь зависят от всей кривой доходности , включающей многочисленные высококоррелированные инструменты, и PCA используется для определения набора компонентов или факторов, которые объясняют движения ставок, [58] тем самым облегчая моделирование. Одним из распространенных приложений управления рисками является расчет стоимости под риском , VaR, с применением PCA к моделированию Монте-Карло . [59] Здесь для каждой выборки моделирования компоненты подвергаются стрессу, а ставки и, в свою очередь, значения опционов затем реконструируются; с VaR, вычисляемым, наконец, по всему циклу. PCA также используется для хеджирования подверженности риску процентных ставок , учитывая частичные дюрации и другие чувствительности. [58] В обоих случаях интерес представляют первые три, как правило, главных компонента системы ( представляющие «сдвиг», «поворот» и «кривизну»). Эти главные компоненты выводятся из собственного разложения ковариационной матрицы доходности при предопределенных сроках погашения; [60] и где дисперсия каждого компонента является его собственным значением (и поскольку компоненты ортогональны , нет необходимости включать корреляцию в последующее моделирование).

Для акций оптимальным портфелем является тот, в котором ожидаемая доходность максимизирована для заданного уровня риска или, в качестве альтернативы, где риск минимизирован для заданной доходности; см. модель Марковица для обсуждения. Таким образом, один подход заключается в снижении риска портфеля, когда стратегии распределения применяются к «основным портфелям» вместо базовых акций . Второй подход заключается в повышении доходности портфеля, используя основные компоненты для выбора акций компаний с потенциалом роста. [61] [62] PCA также использовался для понимания взаимосвязей [57] между международными рынками акций и внутри рынков между группами компаний в отраслях или секторах .

PCA также может применяться для стресс-тестирования , [63] по сути анализа способности банка выдерживать гипотетический неблагоприятный экономический сценарий . Его полезность заключается в «перегонке информации, содержащейся в [нескольких] макроэкономических переменных , в более управляемый набор данных, который затем может [использоваться] для анализа». [63] Здесь полученные факторы связаны, например, с процентными ставками — на основе наибольших элементов собственного вектора фактора — и затем наблюдается, как «шок» каждого из факторов влияет на подразумеваемые активы каждого из банков.

Вариант анализа главных компонент используется в нейронауке для определения специфических свойств стимула, который увеличивает вероятность генерации нейроном потенциала действия . [64] [65] Этот метод известен как ковариационный анализ, запускаемый спайком . В типичном приложении экспериментатор представляет процесс белого шума в качестве стимула (обычно либо как сенсорный вход для испытуемого, либо как ток, вводимый непосредственно в нейрон) и записывает последовательность потенциалов действия или спайков, производимых нейроном в результате. Предположительно, определенные особенности стимула делают нейрон более склонным к спайку. Чтобы извлечь эти особенности, экспериментатор вычисляет ковариационную матрицу ансамбля, запускаемого спайком , набора всех стимулов (определенных и дискретизированных в течение конечного временного окна, обычно порядка 100 мс), которые непосредственно предшествовали спайку. Собственные векторы разности между матрицей ковариации, вызванной спайком, и матрицей ковариации ансамбля предшествующих стимулов (набор всех стимулов, определенных в течение того же временного окна) затем указывают направления в пространстве стимулов , вдоль которых дисперсия ансамбля, вызванного спайком, больше всего отличалась от дисперсии ансамбля предшествующих стимулов. В частности, собственные векторы с наибольшими положительными собственными значениями соответствуют направлениям, вдоль которых дисперсия ансамбля, вызванного спайком, показала наибольшее положительное изменение по сравнению с дисперсией предшествующих. Поскольку это были направления, в которых изменение стимула приводило к спайку, они часто являются хорошими приближениями искомых соответствующих признаков стимула.

В нейронауке PCA также используется для различения идентичности нейрона по форме его потенциала действия. Сортировка спайков является важной процедурой, поскольку внеклеточные методы записи часто улавливают сигналы от более чем одного нейрона. При сортировке спайков сначала используется PCA для уменьшения размерности пространства волновых форм потенциала действия, а затем выполняется кластерный анализ для связывания определенных потенциалов действия с отдельными нейронами.

PCA как метод уменьшения размерности особенно подходит для обнаружения скоординированной активности больших нейронных ансамблей. Он использовался для определения коллективных переменных, то есть параметров порядка , во время фазовых переходов в мозге. [66]

Анализ соответствий (CA) был разработан Жаном-Полем Бензекри [67] и концептуально похож на PCA, но масштабирует данные (которые должны быть неотрицательными) так, чтобы строки и столбцы обрабатывались эквивалентно. Он традиционно применяется к таблицам сопряженности . CA разлагает статистику хи-квадрат, связанную с этой таблицей, на ортогональные факторы. [68] Поскольку CA является описательным методом, его можно применять к таблицам, для которых статистика хи-квадрат подходит или нет. Доступно несколько вариантов CA, включая анализ соответствий с исключенным трендом и анализ канонических соответствий . Одним из специальных расширений является анализ множественных соответствий , который можно рассматривать как аналог анализа главных компонентов для категориальных данных. [69]

Анализ главных компонент создает переменные, которые являются линейными комбинациями исходных переменных. Новые переменные обладают тем свойством, что все переменные ортогональны. Преобразование PCA может быть полезным в качестве шага предварительной обработки перед кластеризацией. PCA — это подход, ориентированный на дисперсию, стремящийся воспроизвести общую дисперсию переменной, в которой компоненты отражают как общую, так и уникальную дисперсию переменной. PCA обычно предпочитают для целей сокращения данных (то есть перевода пространства переменных в оптимальное пространство факторов), но не тогда, когда целью является обнаружение скрытой конструкции или факторов.

Факторный анализ похож на анализ главных компонент, в том, что факторный анализ также включает линейные комбинации переменных. В отличие от PCA, факторный анализ является корреляционно-ориентированным подходом, стремящимся воспроизвести интеркорреляции между переменными, в которых факторы «представляют общую дисперсию переменных, исключая уникальную дисперсию». [70] С точки зрения корреляционной матрицы это соответствует сосредоточению на объяснении недиагональных членов (то есть общей ковариации), в то время как PCA фокусируется на объяснении членов, которые находятся на диагонали. Однако, как побочный результат, при попытке воспроизвести диагональные члены, PCA также имеет тенденцию относительно хорошо соответствовать недиагональным корреляциям. [12] : 158 Результаты, полученные с помощью PCA и факторного анализа, очень похожи в большинстве ситуаций, но это не всегда так, и есть некоторые проблемы, когда результаты существенно различаются. Факторный анализ обычно используется, когда целью исследования является обнаружение структуры данных (то есть скрытых конструкций или факторов) или причинно-следственное моделирование . Если факторная модель сформулирована неправильно или предположения не выполняются, то факторный анализ даст ошибочные результаты. [71]

Было заявлено, что расслабленное решение кластеризации k -средних , заданное кластерными индикаторами, задается главными компонентами, а подпространство PCA, охватываемое главными направлениями, идентично подпространству кластерного центроида. [72] [73] Однако то, что PCA является полезным ослаблением кластеризации k -средних, не было новым результатом, [74] и легко обнаружить контрпримеры к утверждению, что подпространство кластерного центроида охватывается главными направлениями. [75]

Неотрицательная матричная факторизация (NMF) — это метод уменьшения размерности, в котором используются только неотрицательные элементы в матрицах, что, следовательно, является перспективным методом в астрономии, [23] [24] [25] в том смысле, что астрофизические сигналы неотрицательны. Компоненты PCA ортогональны друг другу, в то время как все компоненты NMF неотрицательны и, следовательно, создают неортогональный базис.

В PCA вклад каждого компонента ранжируется на основе величины его соответствующего собственного значения, что эквивалентно дробной остаточной дисперсии (FRV) при анализе эмпирических данных. [21] Для NMF его компоненты ранжируются только на основе эмпирических кривых FRV. [25] Графики остаточных дробных собственных значений, то есть как функция количества компонентов при общем количестве компонентов, для PCA имеют плоское плато, где не собираются никакие данные для удаления квазистатического шума, затем кривые быстро падают, что указывает на переобучение (случайный шум). [21] Кривые FRV для NMF непрерывно уменьшаются [25], когда компоненты NMF строятся последовательно , [24] указывая на непрерывный захват квазистатического шума; затем сходятся к более высоким уровням, чем PCA, [25] указывая на меньшее свойство переобучения NMF.

Часто бывает трудно интерпретировать главные компоненты, когда данные включают много переменных различного происхождения или когда некоторые переменные являются качественными. Это приводит пользователя PCA к деликатному исключению нескольких переменных. Если наблюдения или переменные оказывают чрезмерное влияние на направление осей, их следует удалить, а затем спроецировать как дополнительные элементы. Кроме того, необходимо избегать интерпретации близости между точками, близкими к центру факторной плоскости.

Иконография корреляций , напротив, которая не является проекцией на систему осей, лишена этих недостатков. Поэтому мы можем сохранить все переменные.

Принцип построения диаграммы заключается в подчеркивании «замечательных» корреляций корреляционной матрицы сплошной линией (положительная корреляция) или пунктирной линией (отрицательная корреляция).

Сильная корреляция не является «замечательной», если она не прямая, а вызвана влиянием третьей переменной. И наоборот, слабые корреляции могут быть «замечательными». Например, если переменная Y зависит от нескольких независимых переменных, то корреляции Y с каждой из них слабые и все же «замечательные».

Конкретным недостатком PCA является то, что главные компоненты обычно являются линейными комбинациями всех входных переменных. Разреженный PCA преодолевает этот недостаток, находя линейные комбинации, которые содержат всего несколько входных переменных. Он расширяет классический метод анализа главных компонент (PCA) для снижения размерности данных путем добавления ограничения разреженности на входные переменные. Было предложено несколько подходов, включая

Методологические и теоретические разработки Sparse PCA, а также его применение в научных исследованиях были недавно рассмотрены в обзорной статье. [82]

Большинство современных методов нелинейного снижения размерности находят свои теоретические и алгоритмические корни в PCA или K-средних. Первоначальная идея Пирсона состояла в том, чтобы взять прямую линию (или плоскость), которая будет «наилучшим образом соответствовать» набору точек данных. Тревор Хасти расширил эту концепцию, предложив основные кривые [86] в качестве естественного расширения геометрической интерпретации PCA, которая явно строит многообразие для аппроксимации данных с последующим проектированием точек на него. См. также алгоритм эластичной карты и главный геодезический анализ . [87] Другим популярным обобщением является ядро PCA , которое соответствует PCA, выполняемому в воспроизводящем ядре гильбертова пространства, связанного с положительно определенным ядром.

В многолинейном подпространственном обучении [ 88] [89] [90] PCA обобщается до многолинейного PCA (MPCA), который извлекает признаки непосредственно из тензорных представлений. MPCA решается путем итеративного выполнения PCA в каждой моде тензора. MPCA применялся для распознавания лиц, походки и т. д. MPCA далее расширяется до некоррелированного MPCA, неотрицательного MPCA и надежного MPCA.

N -факторный анализ главных компонент может быть выполнен с использованием таких моделей, как разложение Таккера , PARAFAC , многофакторный анализ, анализ коинерции, STATIS и DISTATIS.

Хотя PCA находит математически оптимальный метод (например, минимизируя квадратичную ошибку), он по-прежнему чувствителен к выбросам в данных, которые приводят к большим ошибкам, чего метод пытается избежать в первую очередь. Поэтому обычной практикой является удаление выбросов перед вычислением PCA. Однако в некоторых контекстах выбросы может быть трудно идентифицировать. [91] Например, в алгоритмах интеллектуального анализа данных , таких как корреляционная кластеризация , назначение точек кластерам и выбросам заранее неизвестно. Недавно предложенное обобщение PCA [92], основанное на взвешенном PCA, повышает надежность за счет назначения различных весов объектам данных на основе их оценочной релевантности.

Также были предложены варианты PCA, устойчивые к выбросам, на основе формулировок L1-нормы ( L1-PCA ). [6] [4]

Надежный анализ главных компонент (RPCA) посредством разложения на низкоранговые и разреженные матрицы представляет собой модификацию PCA, которая хорошо работает в отношении сильно искаженных наблюдений. [93] [94] [95]

Анализ независимых компонентов (ICA) направлен на решение тех же проблем, что и анализ главных компонентов, но находит аддитивно разделимые компоненты, а не последовательные приближения.

Учитывая матрицу , он пытается разложить ее на две матрицы таким образом, что . Ключевое отличие от таких методов, как PCA и ICA, заключается в том, что некоторые элементы ограничены 0. Здесь это называется регулирующим слоем. Хотя в общем случае такое разложение может иметь несколько решений, они доказывают, что если выполняются следующие условия:

тогда разложение однозначно с точностью до умножения на скаляр. [96]

Дискриминантный анализ главных компонентов (DAPC) — это многомерный метод, используемый для идентификации и описания кластеров генетически связанных индивидуумов. Генетическая изменчивость делится на два компонента: изменчивость между группами и внутри групп, и он максимизирует первую. Линейные дискриминанты — это линейные комбинации аллелей, которые наилучшим образом разделяют кластеры. Аллели, которые вносят наибольший вклад в эту дискриминацию, — это, следовательно, те, которые наиболее заметно различаются между группами. Вклад аллелей в группировки, идентифицированные DAPC, могут позволить идентифицировать области генома, управляющие генетической дивергенцией между группами [97] В DAPC данные сначала преобразуются с использованием анализа главных компонентов (PCA), а затем кластеры идентифицируются с использованием дискриминантного анализа (DA).

DAPC можно реализовать на языке R с помощью пакета Adegenet. (подробнее: adegenet в Интернете)

Анализ направленных компонентов (DCA) — это метод, используемый в атмосферных науках для анализа многомерных наборов данных. [98] Как и PCA, он позволяет уменьшить размерность, улучшить визуализацию и улучшить интерпретируемость больших наборов данных. Также, как и PCA, он основан на ковариационной матрице, полученной из входного набора данных. Разница между PCA и DCA заключается в том, что DCA дополнительно требует ввода направления вектора, называемого воздействием. В то время как PCA максимизирует объясненную дисперсию, DCA максимизирует плотность вероятности с учетом воздействия. Мотивацией DCA является поиск компонентов многомерного набора данных, которые являются как вероятными (измеренными с использованием плотности вероятности), так и важными (измеренными с использованием воздействия). DCA использовался для поиска наиболее вероятных и наиболее серьезных моделей тепловых волн в ансамблях прогнозирования погоды, [99] и наиболее вероятных и наиболее влиятельных изменений в количестве осадков из-за изменения климата. [100]

pcaкоманды, либо с помощью princomp()функции.pcaфункцией в пакете MultivariateStatsprincompи pca(R2012b) дают главные компоненты, в то время как функция pcaresдает остатки и реконструированную матрицу для аппроксимации PCA низкого ранга.g03aaпроцедуры (доступной в обеих версиях библиотеки на языке Fortran).princompвозвращает главный компонент.DBMS_DATA_MINING.SVDS_SCORING_MODEуказания значения параметраSVDS_SCORING_PCAprincompи prcompмогут использоваться для анализа главных компонент; prcompиспользует разложение по сингулярным значениям , что обычно обеспечивает лучшую численную точность. Некоторые пакеты, реализующие PCA в R, включают, но не ограничиваются: ade4, vegan, ExPosition, dimRed, и FactoMineR.princompвычисляет анализ главных компонентов pcaсо стандартизированными переменными.{{cite journal}}: CS1 maint: multiple names: authors list (link){{cite conference}}: CS1 maint: multiple names: authors list (link)