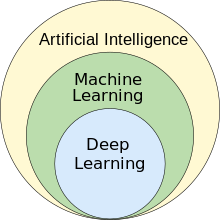

Машинное обучение ( МО ) — это область исследований в области искусственного интеллекта, занимающаяся разработкой и изучением статистических алгоритмов , которые могут обучаться на основе данных и обобщать их на невидимые данные, и, таким образом, выполнять задачи без явных инструкций . [1] Быстрый прогресс в области глубокого обучения , начавшийся в 2010-х годах, позволил нейронным сетям превзойти многие предыдущие подходы по производительности. [2]

Машинное обучение находит применение во многих областях, включая обработку естественного языка , компьютерное зрение , распознавание речи , фильтрацию электронной почты , сельское хозяйство и медицину . [3] [4] Применение машинного обучения к бизнес-задачам известно как предиктивная аналитика .

Статистика и методы математической оптимизации (математическое программирование) составляют основу машинного обучения. Интеллектуальный анализ данных — смежная область исследований, фокусирующаяся на исследовательском анализе данных (EDA) посредством неконтролируемого обучения . [6] [7]

С теоретической точки зрения, вероятно приблизительно правильное (PAC) обучение обеспечивает основу для описания машинного обучения.

Термин «машинное обучение» был придуман в 1959 году Артуром Сэмюэлем , сотрудником IBM и пионером в области компьютерных игр и искусственного интеллекта . [8] [9] В этот период времени также использовался синоним «самообучающиеся компьютеры» . [10] [11]

Хотя самая ранняя модель машинного обучения была представлена в 1950-х годах, когда Артур Сэмюэл изобрел программу , которая вычисляла шансы на победу в шашках для каждой стороны, история машинного обучения уходит корнями в десятилетия человеческого желания и усилий по изучению человеческих когнитивных процессов. [12] В 1949 году канадский психолог Дональд Хебб опубликовал книгу «Организация поведения» , в которой он представил теоретическую нейронную структуру , образованную определенными взаимодействиями между нервными клетками . [13] Модель Хебба нейронов , взаимодействующих друг с другом, заложила основу того, как ИИ и алгоритмы машинного обучения работают в узлах или искусственных нейронах, используемых компьютерами для передачи данных. [12] Другие исследователи, изучавшие человеческие когнитивные системы , также внесли свой вклад в современные технологии машинного обучения, включая логика Уолтера Питтса и Уоррена Маккалока , которые предложили ранние математические модели нейронных сетей для разработки алгоритмов , которые отражают мыслительные процессы человека. [12]

К началу 1960-х годов экспериментальная «обучающаяся машина» с памятью на перфоленте , названная Cybertron, была разработана компанией Raytheon Company для анализа сигналов сонара , электрокардиограмм и речевых шаблонов с использованием элементарного обучения с подкреплением . Она многократно «обучалась» оператором-человеком/учителем распознавать шаблоны и была снабжена кнопкой « goof », чтобы заставить ее переоценивать неверные решения. [14] Представительной книгой по исследованиям в области машинного обучения в 1960-х годах была книга Нильссона «Обучающиеся машины», посвященная в основном машинному обучению для классификации шаблонов. [15] Интерес, связанный с распознаванием шаблонов, продолжался и в 1970-х годах, как описано Дудой и Хартом в 1973 году. [16] В 1981 году был представлен отчет об использовании стратегий обучения, чтобы искусственная нейронная сеть научилась распознавать 40 символов (26 букв, 10 цифр и 4 специальных символа) с компьютерного терминала. [17]

Том М. Митчелл дал широко цитируемое, более формальное определение алгоритмов, изучаемых в области машинного обучения: «Говорят, что компьютерная программа обучается на опыте E в отношении некоторого класса задач T и показателя производительности P, если ее производительность в задачах из T , измеряемая P , улучшается с опытом E ». [18] Это определение задач, в которых задействовано машинное обучение, предлагает фундаментально операциональное определение , а не определение области в когнитивных терминах. Это следует предложению Алана Тьюринга в его статье « Вычислительная техника и интеллект », в которой вопрос «Могут ли машины думать?» заменен вопросом «Могут ли машины делать то, что можем делать мы (как мыслящие существа)?». [19]

Современное машинное обучение имеет две цели. Одна из них — классифицировать данные на основе разработанных моделей; другая цель — делать прогнозы будущих результатов на основе этих моделей. Гипотетический алгоритм, специфичный для классификации данных, может использовать компьютерное зрение родинок в сочетании с контролируемым обучением, чтобы научить его классифицировать раковые родинки. Алгоритм машинного обучения для торговли акциями может информировать трейдера о будущих потенциальных прогнозах. [20]

Как научное начинание, машинное обучение выросло из поиска искусственного интеллекта (ИИ). На заре ИИ как академической дисциплины некоторые исследователи были заинтересованы в том, чтобы машины обучались на основе данных. Они пытались подойти к проблеме с помощью различных символических методов, а также того, что тогда называлось « нейронными сетями »; это были в основном персептроны и другие модели , которые позже оказались переосмыслениями обобщенных линейных моделей статистики. [22] Вероятностные рассуждения также использовались, особенно в автоматизированной медицинской диагностике . [23] : 488

Однако растущий акцент на логическом подходе, основанном на знаниях, вызвал раскол между ИИ и машинным обучением. Вероятностные системы страдали от теоретических и практических проблем сбора и представления данных. [23] : 488 К 1980 году экспертные системы стали доминировать в ИИ, и статистика оказалась в немилости. [24] Работа над символьным/основанным на знаниях обучением продолжалась в рамках ИИ, что привело к индуктивному логическому программированию (ILP), но более статистическое направление исследований теперь находилось за пределами области собственно ИИ, в распознавании образов и поиске информации . [23] : 708–710, 755 Исследования нейронных сетей были заброшены ИИ и компьютерной наукой примерно в то же время. Это направление также было продолжено за пределами области ИИ/КС, как « коннекционизм », исследователями из других дисциплин, включая Джона Хопфилда , Дэвида Рамельхарта и Джеффри Хинтона . Их главный успех пришелся на середину 1980-х годов с переосмыслением обратного распространения . [23] : 25

Машинное обучение (МО), реорганизованное и признанное как отдельная область, начало процветать в 1990-х годах. Область изменила свою цель с достижения искусственного интеллекта на решение решаемых проблем практического характера. Она сместила фокус с символических подходов, унаследованных от ИИ, на методы и модели, заимствованные из статистики, нечеткой логики и теории вероятностей . [24]

Существует тесная связь между машинным обучением и сжатием. Система, которая предсказывает апостериорные вероятности последовательности, учитывая всю ее историю, может использоваться для оптимального сжатия данных (используя арифметическое кодирование выходного распределения). И наоборот, оптимальный компрессор может использоваться для предсказания (находя символ, который сжимает лучше всего, учитывая предыдущую историю). Эта эквивалентность использовалась в качестве обоснования использования сжатия данных в качестве эталона для «общего интеллекта». [25] [26] [27]

Альтернативный взгляд может показать, что алгоритмы сжатия неявно отображают строки в неявные векторы пространства признаков , а меры подобия на основе сжатия вычисляют подобие в этих пространствах признаков. Для каждого компрессора C(.) мы определяем связанное векторное пространство ℵ, так что C(.) отображает входную строку x, соответствующую векторной норме ||~x||. Исчерпывающее исследование пространств признаков, лежащих в основе всех алгоритмов сжатия, исключается из-за нехватки пространства; вместо этого векторы признаков выбирают для проверки три репрезентативных метода сжатия без потерь: LZW, LZ77 и PPM. [28]

Согласно теории AIXI , связь, более прямо объясненная в премии Хуттера , наилучшее возможное сжатие x — это наименьшее возможное программное обеспечение, которое генерирует x. Например, в этой модели сжатый размер zip-файла включает как zip-файл, так и программное обеспечение для распаковки, поскольку вы не можете распаковать его без обоих, но может быть еще меньшая объединенная форма.

Примерами программного обеспечения для сжатия аудио/видео на базе ИИ являются NVIDIA Maxine , AIVC. [29] Примерами программного обеспечения, которое может выполнять сжатие изображений на базе ИИ, являются OpenCV , TensorFlow , MATLAB 's Image Processing Toolbox (IPT) и High-Fidelity Generative Image Compression. [30]

В неконтролируемом машинном обучении кластеризация k-средних может использоваться для сжатия данных путем группировки схожих точек данных в кластеры. Этот метод упрощает обработку обширных наборов данных, в которых отсутствуют предопределенные метки, и находит широкое применение в таких областях, как сжатие изображений . [31]

Сжатие данных направлено на уменьшение размера файлов данных, повышение эффективности хранения и ускорение передачи данных. Кластеризация k-средних, неконтролируемый алгоритм машинного обучения, используется для разбиения набора данных на определенное количество кластеров, k, каждый из которых представлен центроидом своих точек. Этот процесс уплотняет обширные наборы данных в более компактный набор репрезентативных точек. Особенно полезная при обработке изображений и сигналов , кластеризация k-средних помогает в сокращении данных, заменяя группы точек данных их центроидами, тем самым сохраняя основную информацию исходных данных и значительно уменьшая требуемое пространство для хранения. [32]

Большие языковые модели (LLM) также способны к сжатию данных без потерь, как продемонстрировано исследованием DeepMind с моделью Chinchilla 70B. Разработанная DeepMind, Chinchilla 70B эффективно сжимает данные, превосходя традиционные методы, такие как Portable Network Graphics (PNG) для изображений и Free Lossless Audio Codec (FLAC) для аудио. Она достигла сжатия данных изображений и аудио до 43,4% и 16,4% от их исходных размеров соответственно. [33]Машинное обучение и интеллектуальный анализ данных часто используют одни и те же методы и в значительной степени пересекаются, но в то время как машинное обучение фокусируется на прогнозировании на основе известных свойств, извлеченных из обучающих данных, интеллектуальный анализ данных фокусируется на обнаружении (ранее) неизвестных свойств в данных (это этап анализа обнаружения знаний в базах данных). Интеллектуальный анализ данных использует много методов машинного обучения, но с разными целями; с другой стороны, машинное обучение также использует методы интеллектуального анализа данных как « неконтролируемое обучение » или как этап предварительной обработки для повышения точности обучающегося. Большая часть путаницы между этими двумя исследовательскими сообществами (которые часто проводят отдельные конференции и издают отдельные журналы, основным исключением является ECML PKDD ) возникает из-за основных предположений, с которыми они работают: в машинном обучении производительность обычно оценивается с точки зрения способности воспроизводить известные знания, в то время как в обнаружении знаний и интеллектуальном анализе данных (KDD) ключевой задачей является обнаружение ранее неизвестных знаний. При оценке с учетом известных знаний неинформированный (неконтролируемый) метод будет легко уступать другим контролируемым методам, в то время как в типичной задаче KDD контролируемые методы не могут быть использованы из-за отсутствия обучающих данных.

Машинное обучение также тесно связано с оптимизацией : многие проблемы обучения формулируются как минимизация некоторой функции потерь на обучающем наборе примеров. Функции потерь выражают расхождение между прогнозами обучаемой модели и фактическими экземплярами проблемы (например, при классификации требуется присвоить метку экземплярам , и модели обучаются правильно предсказывать предварительно назначенные метки набора примеров). [34]

Характеристика обобщения различных алгоритмов обучения является активной темой современных исследований, особенно в области алгоритмов глубокого обучения .

Машинное обучение и статистика являются тесно связанными областями с точки зрения методов, но различаются по своей основной цели: статистика делает выводы о популяции из выборки , в то время как машинное обучение находит обобщаемые прогностические модели. [35] По словам Майкла И. Джордана , идеи машинного обучения, от методологических принципов до теоретических инструментов, имели долгую предысторию в статистике. [36] Он также предложил термин «наука о данных» в качестве заполнителя для обозначения всей области. [36]

Обычный статистический анализ требует априорного выбора модели, наиболее подходящей для набора данных исследования. Кроме того, для анализа включаются только значимые или теоретически значимые переменные, основанные на предыдущем опыте. Напротив, машинное обучение не строится на предварительно структурированной модели; скорее, данные формируют модель, выявляя базовые закономерности. Чем больше переменных (входных данных) используется для обучения модели, тем точнее будет конечная модель. [37]

Лео Брейман различал две парадигмы статистического моделирования: модель данных и алгоритмическую модель, [38] где «алгоритмическая модель» в большей или меньшей степени означает алгоритмы машинного обучения, такие как случайный лес .

Некоторые статистики переняли методы машинного обучения, что привело к созданию комбинированной области, которую они называют статистическим обучением . [39]

Аналитические и вычислительные методы, полученные из глубоко укоренившейся физики неупорядоченных систем, могут быть распространены на крупномасштабные проблемы, включая машинное обучение, например, для анализа весового пространства глубоких нейронных сетей . [40] Таким образом, статистическая физика находит применение в области медицинской диагностики . [41]

Основная цель обучающегося — обобщать свой опыт. [5] [42] Обобщение в этом контексте — это способность обучающейся машины точно выполнять новые, невиданные примеры/задачи после того, как она испытала набор обучающих данных. Обучающие примеры берутся из некоторого, как правило, неизвестного распределения вероятностей (считающегося репрезентативным для пространства событий), и обучающийся должен построить общую модель этого пространства, которая позволит ему производить достаточно точные прогнозы в новых случаях.

Вычислительный анализ алгоритмов машинного обучения и их производительности — это раздел теоретической компьютерной науки, известный как теория вычислительного обучения через модель вероятного приблизительно правильного обучения (PAC). Поскольку обучающие наборы конечны, а будущее неопределенно, теория обучения обычно не дает гарантий производительности алгоритмов. Вместо этого довольно распространены вероятностные границы производительности. Разложение смещения-дисперсии — один из способов количественной оценки ошибки обобщения .

Для наилучшей производительности в контексте обобщения сложность гипотезы должна соответствовать сложности функции, лежащей в основе данных. Если гипотеза менее сложна, чем функция, то модель не соответствует данным. Если сложность модели увеличивается в ответ, то ошибка обучения уменьшается. Но если гипотеза слишком сложна, то модель подвержена переобучению, и обобщение будет хуже. [43]

В дополнение к ограничениям производительности, теоретики обучения изучают временную сложность и осуществимость обучения. В теории вычислительного обучения вычисление считается осуществимым, если его можно выполнить за полиномиальное время . Существует два вида результатов временной сложности : Положительные результаты показывают, что определенный класс функций может быть изучен за полиномиальное время. Отрицательные результаты показывают, что определенные классы не могут быть изучены за полиномиальное время.

Подходы к машинному обучению традиционно делятся на три широкие категории, которые соответствуют парадигмам обучения в зависимости от характера «сигнала» или «обратной связи», доступных обучающейся системе:

Хотя каждый алгоритм имеет свои преимущества и ограничения, ни один алгоритм не подходит для всех проблем. [44] [45] [46]

Контролируемые алгоритмы обучения создают математическую модель набора данных, которая содержит как входы, так и желаемые выходы. [47] Данные, известные как данные обучения , состоят из набора примеров обучения. Каждый пример обучения имеет один или несколько входов и желаемый выход, также известный как контрольный сигнал. В математической модели каждый пример обучения представлен массивом или вектором, иногда называемым вектором признаков , а данные обучения представлены матрицей . С помощью итеративной оптимизации целевой функции контролируемые алгоритмы обучения изучают функцию, которая может использоваться для прогнозирования выходных данных, связанных с новыми входами. [48] Оптимальная функция позволяет алгоритму правильно определять выходные данные для входов, которые не были частью данных обучения. Говорят, что алгоритм, который повышает точность своих выходных данных или предсказаний с течением времени, научился выполнять эту задачу. [18]

Типы алгоритмов контролируемого обучения включают активное обучение , классификацию и регрессию . [49] Алгоритмы классификации используются, когда выходные данные ограничены ограниченным набором значений, а алгоритмы регрессии используются, когда выходные данные могут иметь любое числовое значение в пределах диапазона. Например, для алгоритма классификации, который фильтрует электронные письма, входными данными будет входящее электронное письмо, а выходными данными будет имя папки, в которой будет сохранено электронное письмо. Примерами регрессии могут быть прогнозирование роста человека или будущей температуры. [50]

Обучение на основе сходства — это область контролируемого машинного обучения, тесно связанная с регрессией и классификацией, но ее цель — учиться на примерах, используя функцию сходства, которая измеряет, насколько похожи или связаны два объекта. Она применяется в ранжировании , рекомендательных системах , визуальном отслеживании идентичности, проверке лиц и проверке говорящего.

Алгоритмы неконтролируемого обучения находят структуры в данных, которые не были помечены, классифицированы или категоризированы. Вместо того, чтобы реагировать на обратную связь, алгоритмы неконтролируемого обучения выявляют общности в данных и реагируют на основе наличия или отсутствия таких общностей в каждом новом фрагменте данных. Основные приложения неконтролируемого машинного обучения включают кластеризацию, снижение размерности [7] и оценку плотности [51] . Алгоритмы неконтролируемого обучения также упростили процесс идентификации больших гаплотипов на основе инделей интересующего гена из пангенома [52] .

Кластерный анализ — это распределение набора наблюдений по подмножествам (называемым кластерами ), так что наблюдения в пределах одного кластера схожи по одному или нескольким заранее заданным критериям, тогда как наблюдения, взятые из разных кластеров, отличаются. Различные методы кластеризации делают разные предположения о структуре данных, часто определяемой некоторой метрикой сходства и оцениваемой, например, по внутренней компактности , или сходству между членами одного кластера, и разделению , различию между кластерами. Другие методы основаны на оценочной плотности и связности графа .

Особый тип неконтролируемого обучения, называемый самоконтролируемым обучением , подразумевает обучение модели путем генерации контрольного сигнала из самих данных. [54] [55]

Полуконтролируемое обучение находится между неконтролируемым обучением (без каких-либо маркированных обучающих данных) и контролируемым обучением (с полностью маркированными обучающими данными). В некоторых примерах обучения отсутствуют обучающие метки, однако многие исследователи машинного обучения обнаружили, что немаркированные данные, используемые в сочетании с небольшим количеством маркированных данных, могут значительно улучшить точность обучения.

При слабо контролируемом обучении обучающие метки являются шумными, ограниченными или неточными; однако эти метки часто дешевле получить, что приводит к более крупным эффективным обучающим наборам. [56]

Обучение с подкреплением — это область машинного обучения, связанная с тем, как программные агенты должны выполнять действия в среде, чтобы максимизировать некоторое понятие кумулятивного вознаграждения. Из-за своей общности эта область изучается во многих других дисциплинах, таких как теория игр , теория управления , исследование операций , теория информации , оптимизация на основе моделирования , многоагентные системы , роевой интеллект , статистика и генетические алгоритмы . В обучении с подкреплением среда обычно представляется как марковский процесс принятия решений (MDP). Многие алгоритмы обучения с подкреплением используют методы динамического программирования . [57] Алгоритмы обучения с подкреплением не предполагают знания точной математической модели MDP и используются, когда точные модели неосуществимы. Алгоритмы обучения с подкреплением используются в автономных транспортных средствах или при обучении игре против человеческого противника.

Снижение размерности — это процесс уменьшения числа рассматриваемых случайных величин путем получения набора главных переменных. [58] Другими словами, это процесс уменьшения размерности набора признаков , также называемый «количеством признаков». Большинство методов снижения размерности можно рассматривать как исключение или извлечение признаков . Одним из популярных методов снижения размерности является анализ главных компонент (PCA). PCA включает в себя изменение многомерных данных (например, 3D) на меньшее пространство (например, 2D). Гипотеза многообразия предполагает, что многомерные наборы данных лежат вдоль многообразий малой размерности , и многие методы снижения размерности делают это предположение, что приводит к области обучения многообразий и регуляризации многообразий .

Были разработаны другие подходы, которые не вписываются в эту тройную категоризацию, и иногда одна и та же система машинного обучения использует более одного подхода. Например, тематическое моделирование , метаобучение . [59]

Самообучение как парадигма машинного обучения было представлено в 1982 году вместе с нейронной сетью, способной к самообучению, названной перекрестной адаптивной матрицей (CAA). [60] Это обучение без внешних вознаграждений и без внешних советов учителя. Алгоритм самообучения CAA вычисляет перекрестным способом как решения о действиях, так и эмоции (чувства) о ситуациях последствий. Система управляется взаимодействием между познанием и эмоциями. [61] Алгоритм самообучения обновляет матрицу памяти W =||w(a,s)|| таким образом, что на каждой итерации выполняет следующую процедуру машинного обучения:

Это система только с одним входом, ситуацией, и только одним выходом, действием (или поведением) а. Нет ни отдельного подкрепляющего входа, ни советующего входа из окружающей среды. Обратно распространяемое значение (вторичное подкрепление) - это эмоция по отношению к ситуации последствий. CAA существует в двух средах, одна - это поведенческая среда, где он себя ведет, а другая - генетическая среда, откуда он изначально и только один раз получает начальные эмоции о ситуациях, с которыми он может столкнуться в поведенческой среде. После получения вектора генома (вида) из генетической среды CAA учится целенаправленному поведению в среде, которая содержит как желательные, так и нежелательные ситуации. [62]

Несколько алгоритмов обучения нацелены на обнаружение лучших представлений входных данных, предоставленных во время обучения. [63] Классические примеры включают анализ главных компонент и кластерный анализ. Алгоритмы обучения признакам, также называемые алгоритмами обучения представлениям, часто пытаются сохранить информацию во входных данных, но также преобразовать ее таким образом, чтобы сделать ее полезной, часто в качестве шага предварительной обработки перед выполнением классификации или прогнозирования. Этот метод позволяет реконструировать входные данные, поступающие из неизвестного распределения, генерирующего данные, при этом не обязательно будучи верным конфигурациям, которые неправдоподобны при этом распределении. Это заменяет ручную разработку признаков и позволяет машине как изучать признаки, так и использовать их для выполнения определенной задачи.

Обучение признакам может быть как контролируемым, так и неконтролируемым. При обучении признакам с учителем признаки изучаются с использованием маркированных входных данных. Примерами являются искусственные нейронные сети , многослойные персептроны и контролируемое обучение словарю . При обучении признакам без учителя признаки изучаются с использованием немаркированных входных данных. Примерами являются обучение словарю, независимый компонентный анализ , автоэнкодеры , матричная факторизация [64] и различные формы кластеризации . [65] [66] [67]

Многообразные алгоритмы обучения пытаются сделать это при ограничении, что изученное представление является низкоразмерным. Разреженные алгоритмы кодирования пытаются сделать это при ограничении, что изученное представление является разреженным, что означает, что математическая модель имеет много нулей. Многолинейные алгоритмы обучения подпространства направлены на изучение низкоразмерных представлений непосредственно из тензорных представлений для многомерных данных, не преобразуя их в многомерные векторы. [68] Алгоритмы глубокого обучения обнаруживают несколько уровней представления или иерархию признаков, с более высокоуровневыми, более абстрактными признаками, определенными в терминах (или генерирующими) признаков более низкого уровня. Утверждалось, что интеллектуальная машина — это та, которая изучает представление, которое распутывает основные факторы вариации, которые объясняют наблюдаемые данные. [69]

Изучение признаков мотивируется тем фактом, что задачи машинного обучения, такие как классификация, часто требуют ввода, который математически и вычислительно удобен для обработки. Однако реальные данные, такие как изображения, видео и сенсорные данные, не дали попыток алгоритмически определить конкретные признаки. Альтернативой является обнаружение таких признаков или представлений посредством проверки, не полагаясь на явные алгоритмы.

Обучение по разреженному словарю — это метод обучения признакам, в котором обучающий пример представляется в виде линейной комбинации базисных функций и предполагается, что это разреженная матрица . Метод является строго NP-трудным и его трудно решить приближенно. [70] Популярным эвристическим методом обучения по разреженному словарю является алгоритм k -SVD . Обучение по разреженному словарю применялось в нескольких контекстах. В классификации проблема заключается в определении класса, к которому принадлежит ранее не виданный обучающий пример. Для словаря, где каждый класс уже был построен, новый обучающий пример связывается с классом, который наилучшим образом разреженно представлен соответствующим словарем. Обучение по разреженному словарю также применялось при удалении шума с изображений . Ключевая идея заключается в том, что чистый фрагмент изображения может быть разреженно представлен словарем изображений, но шум не может. [71]

В интеллектуальном анализе данных обнаружение аномалий, также известное как обнаружение выбросов, представляет собой идентификацию редких элементов, событий или наблюдений, которые вызывают подозрения, существенно отличаясь от большинства данных. [72] Как правило, аномальные элементы представляют собой проблему, такую как банковское мошенничество , структурный дефект, медицинские проблемы или ошибки в тексте. Аномалии называются выбросами , новинками, шумом, отклонениями и исключениями. [73]

В частности, в контексте обнаружения злоупотреблений и сетевых вторжений интересными объектами часто являются не редкие объекты, а неожиданные всплески бездействия. Этот шаблон не соответствует общему статистическому определению выброса как редкого объекта. Многие методы обнаружения выбросов (в частности, неконтролируемые алгоритмы) не сработают с такими данными, если они не будут агрегированы надлежащим образом. Вместо этого алгоритм кластерного анализа может обнаружить микрокластеры, образованные этими шаблонами. [74]

Существуют три широкие категории методов обнаружения аномалий. [75] Методы обнаружения аномалий без учителя обнаруживают аномалии в немаркированном тестовом наборе данных, предполагая, что большинство экземпляров в наборе данных являются нормальными, путем поиска экземпляров, которые кажутся наименее подходящими к остальной части набора данных. Методы обнаружения аномалий с учителем требуют набора данных, который был помечен как «нормальный» и «ненормальный», и включают обучение классификатора (ключевое отличие от многих других задач статистической классификации заключается в изначально несбалансированном характере обнаружения выбросов). Методы обнаружения аномалий с учителем под учителем создают модель, представляющую нормальное поведение, из заданного нормального набора данных для обучения, а затем проверяют вероятность того, что модель сгенерирует тестовый экземпляр.

Обучение роботов вдохновлено множеством методов машинного обучения, начиная с контролируемого обучения, обучения с подкреплением [76] [77] и, наконец, метаобучения (например, MAML).

Обучение правилам ассоциации — это метод машинного обучения на основе правил для обнаружения связей между переменными в больших базах данных. Он предназначен для выявления сильных правил, обнаруженных в базах данных, с использованием некоторой меры «интересности». [78]

Машинное обучение на основе правил — это общий термин для любого метода машинного обучения, который идентифицирует, изучает или развивает «правила» для хранения, обработки или применения знаний. Определяющей характеристикой алгоритма машинного обучения на основе правил является идентификация и использование набора реляционных правил, которые в совокупности представляют знания, полученные системой. Это контрастирует с другими алгоритмами машинного обучения, которые обычно идентифицируют единственную модель, которая может быть универсально применена к любому экземпляру для составления прогноза. [79] Подходы машинного обучения на основе правил включают системы классификаторов обучения , обучение правил ассоциаций и искусственные иммунные системы .

Основываясь на концепции строгих правил, Ракеш Агравал , Томаш Имелински и Арун Свами ввели правила ассоциации для обнаружения закономерностей между продуктами в крупномасштабных данных транзакций, записанных системами точек продаж (POS) в супермаркетах. [80] Например, правило, найденное в данных о продажах супермаркета, будет указывать, что если клиент покупает лук и картофель вместе, он, скорее всего, также купит мясо для гамбургера. Такая информация может быть использована в качестве основы для принятия решений о маркетинговых мероприятиях, таких как рекламные цены или размещение продукта . Помимо анализа рыночной корзины , правила ассоциации сегодня используются в таких областях применения, как анализ использования Интернета , обнаружение вторжений , непрерывное производство и биоинформатика . В отличие от анализа последовательностей , изучение правил ассоциации обычно не учитывает порядок элементов ни в рамках транзакции, ни между транзакциями.

Системы классификаторов обучения (LCS) представляют собой семейство алгоритмов машинного обучения на основе правил, которые объединяют компонент обнаружения, обычно генетический алгоритм , с компонентом обучения, выполняя либо контролируемое обучение , либо обучение с подкреплением , либо неконтролируемое обучение . Они стремятся определить набор контекстно-зависимых правил, которые коллективно хранят и применяют знания кусочно для того, чтобы делать прогнозы. [81]

Индуктивное логическое программирование (ILP) — это подход к изучению правил, использующий логическое программирование в качестве единообразного представления для входных примеров, фоновых знаний и гипотез. При наличии кодировки известных фоновых знаний и набора примеров, представленных в виде логической базы данных фактов, система ILP выведет гипотетическую логическую программу, которая включает все положительные и ни одного отрицательного примера. Индуктивное программирование — это смежная область, которая рассматривает любой язык программирования для представления гипотез (и не только логического программирования), например, функциональные программы .

Индуктивное логическое программирование особенно полезно в биоинформатике и обработке естественного языка . Гордон Плоткин и Эхуд Шапиро заложили первоначальную теоретическую основу для индуктивного машинного обучения в логической обстановке. [82] [83] [84] Шапиро построил свою первую реализацию (систему вывода моделей) в 1981 году: программу на Прологе, которая индуктивно выводила логические программы из положительных и отрицательных примеров. [85] Термин «индуктивный» здесь относится к философской индукции, предлагающей теорию для объяснения наблюдаемых фактов, а не к математической индукции , доказывающей свойство для всех членов хорошо упорядоченного множества.

АМодель машинного обучения — это типматематической модели, которая после «обучения» на заданном наборе данных может использоваться для прогнозирования или классификации новых данных. Во время обучения алгоритм обучения итеративно корректирует внутренние параметры модели, чтобы минимизировать ошибки в ее прогнозах.[86]В более широком смысле термин «модель» может относиться к нескольким уровням специфичности, от общего класса моделей и связанных с ними алгоритмов обучения до полностью обученной модели со всеми ее настроенными внутренними параметрами.[87]

Для систем машинного обучения использовались и исследовались различные типы моделей; выбор лучшей модели для задачи называется выбором модели .

Искусственные нейронные сети (ИНС) или коннекционистские системы — это вычислительные системы, смутно вдохновлённые биологическими нейронными сетями , которые составляют мозг животных . Такие системы «учатся» выполнять задачи, рассматривая примеры, как правило, без программирования каких-либо специфических для задачи правил.

ANN — это модель, основанная на наборе связанных единиц или узлов, называемых « искусственными нейронами », которые в общих чертах моделируют нейроны в биологическом мозге. Каждое соединение, как и синапсы в биологическом мозге, может передавать информацию, «сигнал», от одного искусственного нейрона к другому. Искусственный нейрон, который получает сигнал, может обработать его, а затем подать сигнал дополнительным искусственным нейронам, подключенным к нему. В обычных реализациях ANN сигнал в соединении между искусственными нейронами является действительным числом , а выход каждого искусственного нейрона вычисляется некоторой нелинейной функцией суммы его входов. Соединения между искусственными нейронами называются «ребрами». Искусственные нейроны и ребра обычно имеют вес , который корректируется по мере обучения. Вес увеличивает или уменьшает силу сигнала в соединении. Искусственные нейроны могут иметь порог, так что сигнал отправляется только в том случае, если совокупный сигнал пересекает этот порог. Обычно искусственные нейроны объединяются в слои. Различные слои могут выполнять различные виды преобразований на своих входах. Сигналы передаются от первого слоя (входного слоя) к последнему слою (выходному слою), возможно, после многократного прохождения слоев.

Первоначальной целью подхода ANN было решение проблем таким же образом, как это делает человеческий мозг . Однако со временем внимание переместилось на выполнение конкретных задач, что привело к отклонениям от биологии . Искусственные нейронные сети использовались для решения различных задач, включая компьютерное зрение , распознавание речи , машинный перевод , фильтрацию социальных сетей , настольные и видеоигры , а также медицинскую диагностику .

Глубокое обучение состоит из нескольких скрытых слоев в искусственной нейронной сети. Этот подход пытается смоделировать способ, которым человеческий мозг обрабатывает свет и звук в зрение и слух. Некоторые успешные приложения глубокого обучения — это компьютерное зрение и распознавание речи. [88]

Обучение на основе дерева решений использует дерево решений в качестве предсказательной модели для перехода от наблюдений за элементом (представленных в ветвях) к выводам о целевом значении элемента (представленном в листьях). Это один из подходов предсказательного моделирования, используемых в статистике, интеллектуальном анализе данных и машинном обучении. Древовидные модели, в которых целевая переменная может принимать дискретный набор значений, называются деревьями классификации; в этих древовидных структурах листья представляют метки классов, а ветви представляют конъюнкции признаков, которые приводят к этим меткам классов. Деревья решений, в которых целевая переменная может принимать непрерывные значения (обычно действительные числа ), называются деревьями регрессии. В анализе решений дерево решений может использоваться для визуального и явного представления решений и принятия решений . В интеллектуальном анализе данных дерево решений описывает данные, но полученное в результате дерево классификации может быть входными данными для принятия решений.

Машины опорных векторов (SVM), также известные как сети опорных векторов, представляют собой набор связанных контролируемых методов обучения, используемых для классификации и регрессии. Учитывая набор обучающих примеров, каждый из которых помечен как принадлежащий к одной из двух категорий, алгоритм обучения SVM строит модель, которая предсказывает, попадает ли новый пример в одну категорию. [89] Алгоритм обучения SVM является не вероятностным , бинарным , линейным классификатором , хотя существуют такие методы, как масштабирование Платта, для использования SVM в вероятностной обстановке классификации. В дополнение к выполнению линейной классификации, SVM могут эффективно выполнять нелинейную классификацию, используя то, что называется трюком ядра , неявно отображая свои входные данные в многомерные пространства признаков.

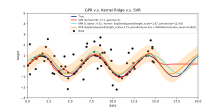

Регрессионный анализ охватывает большое разнообразие статистических методов для оценки взаимосвязи между входными переменными и связанными с ними признаками. Его наиболее распространенной формой является линейная регрессия , где одна линия рисуется для наилучшего соответствия заданным данным в соответствии с математическим критерием, таким как обычные наименьшие квадраты . Последний часто расширяется методами регуляризации для смягчения переобучения и смещения, как в гребневой регрессии . При работе с нелинейными задачами переходные модели включают полиномиальную регрессию (например, используемую для подгонки линии тренда в Microsoft Excel [90] ), логистическую регрессию (часто используемую в статистической классификации ) или даже ядерную регрессию , которая вводит нелинейность, используя трюк с ядром для неявного отображения входных переменных в многомерное пространство.

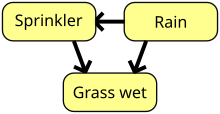

Байесовская сеть, сеть убеждений или направленная ациклическая графическая модель — это вероятностная графическая модель , которая представляет набор случайных величин и их условную независимость с направленным ациклическим графом (DAG). Например, байесовская сеть может представлять вероятностные связи между заболеваниями и симптомами. При наличии симптомов сеть может использоваться для вычисления вероятностей наличия различных заболеваний. Существуют эффективные алгоритмы, которые выполняют вывод и обучение. Байесовские сети, которые моделируют последовательности переменных, такие как речевые сигналы или последовательности белков , называются динамическими байесовскими сетями . Обобщения байесовских сетей, которые могут представлять и решать проблемы принятия решений в условиях неопределенности, называются диаграммами влияния .

Гауссовский процесс — это стохастический процесс , в котором каждый конечный набор случайных величин в процессе имеет многомерное нормальное распределение и опирается на предопределенную ковариационную функцию , или ядро, которое моделирует, как пары точек соотносятся друг с другом в зависимости от их местоположения.

При наличии набора наблюдаемых точек или примеров «вход-выход» распределение (ненаблюдаемого) выхода новой точки как функции ее входных данных можно напрямую вычислить, рассмотрев наблюдаемые точки и ковариации между этими точками и новой ненаблюдаемой точкой.

Гауссовские процессы являются популярными суррогатными моделями в байесовской оптимизации, используемыми для оптимизации гиперпараметров .

Генетический алгоритм (ГА) — это алгоритм поиска и эвристический метод, который имитирует процесс естественного отбора , используя такие методы, как мутация и кроссинговер, для генерации новых генотипов в надежде найти хорошие решения для данной проблемы. В машинном обучении генетические алгоритмы использовались в 1980-х и 1990-х годах. [92] [93] И наоборот, методы машинного обучения использовались для улучшения производительности генетических и эволюционных алгоритмов . [94]

Теория функций убеждений, также называемая теорией доказательств или теорией Демпстера–Шейфера, представляет собой общую структуру для рассуждений с неопределенностью, с понятными связями с другими структурами, такими как теории вероятности , возможности и неточные теории вероятностей . Эти теоретические структуры можно рассматривать как своего рода обучающийся и имеют некоторые аналогичные свойства того, как объединяются доказательства (например, правило объединения Демпстера), точно так же, как в байесовском подходе на основе pmf [ необходимо разъяснение ] объединяются вероятности. Однако существует множество оговорок относительно этих функций убеждений по сравнению с байесовскими подходами для включения невежества и количественной оценки неопределенности . Эти подходы к функциям убеждений, которые реализованы в области машинного обучения, обычно используют подход слияния различных методов ансамбля для лучшей обработки границы решения обучающегося , низких выборок и неоднозначных проблем класса, которые стандартный подход машинного обучения, как правило, с трудом решает. [4] [9] Однако вычислительная сложность этих алгоритмов зависит от количества предложений (классов) и может привести к значительно большему времени вычислений по сравнению с другими подходами машинного обучения.

Обычно модели машинного обучения требуют большого количества надежных данных для выполнения точных прогнозов. При обучении модели машинного обучения инженерам машинного обучения необходимо нацелиться и собрать большую и репрезентативную выборку данных. Данные из обучающего набора могут быть такими же разнообразными, как корпус текста , набор изображений, данные датчиков и данные, собранные от отдельных пользователей сервиса. Переобучение — это то, на что следует обращать внимание при обучении модели машинного обучения. Обученные модели, полученные из предвзятых или неоцененных данных, могут привести к искаженным или нежелательным прогнозам. Предвзятые модели могут привести к пагубным результатам, тем самым усугубляя негативное воздействие на общество или цели. Алгоритмическая предвзятость — потенциальный результат того, что данные не полностью подготовлены для обучения. Этика машинного обучения становится областью изучения и, в частности, интегрируется в команды инженеров машинного обучения.

Федеративное обучение — это адаптированная форма распределенного искусственного интеллекта для обучения моделей машинного обучения, которая децентрализует процесс обучения, позволяя сохранять конфиденциальность пользователей, не отправляя их данные на централизованный сервер. Это также повышает эффективность за счет децентрализации процесса обучения на множество устройств. Например, Gboard использует федеративное машинное обучение для обучения моделей прогнозирования поисковых запросов на мобильных телефонах пользователей без необходимости отправлять отдельные поисковые запросы обратно в Google . [95]

Существует множество приложений для машинного обучения, в том числе:

В 2006 году поставщик медиа-услуг Netflix провел первый конкурс « Netflix Prize », чтобы найти программу для лучшего прогнозирования предпочтений пользователей и повышения точности своего существующего алгоритма рекомендации фильмов Cinematch как минимум на 10%. Совместная команда, состоящая из исследователей из AT&T Labs -Research в сотрудничестве с командами Big Chaos и Pragmatic Theory, построила ансамблевую модель , чтобы выиграть главный приз в 2009 году в размере 1 миллиона долларов. [98] Вскоре после вручения премии Netflix понял, что рейтинги зрителей не являются лучшими индикаторами их моделей просмотра («все является рекомендацией»), и они соответствующим образом изменили свой механизм рекомендаций. [99] В 2010 году The Wall Street Journal написал о фирме Rebellion Research и их использовании машинного обучения для прогнозирования финансового кризиса. [100] В 2012 году соучредитель Sun Microsystems Винод Хосла предсказал, что 80% рабочих мест врачей будут потеряны в течение следующих двух десятилетий из-за автоматизированного машинного обучения медицинского диагностического программного обеспечения. [101] В 2014 году сообщалось, что алгоритм машинного обучения был применен в области истории искусств для изучения картин изобразительного искусства и что он, возможно, выявил ранее нераспознанные влияния среди художников. [102] В 2019 году Springer Nature опубликовал первую исследовательскую книгу, созданную с использованием машинного обучения. [103] В 2020 году технология машинного обучения была использована для помощи в постановке диагнозов и помощи исследователям в разработке лекарства от COVID-19. [104] Недавно машинное обучение было применено для прогнозирования проэкологического поведения путешественников. [105] Недавно технология машинного обучения также была применена для оптимизации производительности смартфона и теплового поведения на основе взаимодействия пользователя с телефоном. [106] [107] [108] При правильном применении алгоритмы машинного обучения (MLA) могут использовать широкий спектр характеристик компании для прогнозирования доходности акций без переобучения . Используя эффективную разработку признаков и объединяя прогнозы, MLA могут генерировать результаты, которые намного превосходят результаты, полученные с помощью базовых линейных методов, таких как OLS . [109]

Недавние достижения в области машинного обучения распространились на область квантовой химии, где новые алгоритмы теперь позволяют прогнозировать влияние растворителей на химические реакции, тем самым предлагая химикам новые инструменты для адаптации экспериментальных условий для получения оптимальных результатов. [110]

Машинное обучение становится полезным инструментом для исследования и прогнозирования принятия решений об эвакуации в случае крупномасштабных и мелкомасштабных катастроф. Были протестированы различные решения для прогнозирования того, решат ли и когда домовладельцы эвакуироваться во время лесных пожаров и ураганов. [111] [112] [113] Другие приложения были сосредоточены на решениях до эвакуации при пожарах в зданиях. [114] [115]

Хотя машинное обучение и стало преобразующим фактором в некоторых областях, программы машинного обучения часто не дают ожидаемых результатов. [116] [117] [118] Причин тому множество: отсутствие (подходящих) данных, отсутствие доступа к данным, предвзятость данных, проблемы с конфиденциальностью, неправильно выбранные задачи и алгоритмы, неправильные инструменты и люди, отсутствие ресурсов и проблемы оценки. [119]

« Теория черного ящика » представляет собой еще одну, но значительную проблему. Черный ящик относится к ситуации, когда алгоритм или процесс создания выходных данных полностью непрозрачен, что означает, что даже кодировщики алгоритма не могут проверить шаблон, который машина извлекла из данных. [120] Специальный комитет Палаты лордов, который утверждал, что такая «система разведки», которая может иметь «существенное влияние на жизнь человека», не будет считаться приемлемой, если она не предоставит «полного и удовлетворительного объяснения решений», которые она принимает. [120]

В 2018 году беспилотный автомобиль Uber не смог обнаружить пешехода, который погиб в результате столкновения. [121] Попытки использовать машинное обучение в здравоохранении с помощью системы IBM Watson не увенчались успехом даже после многих лет и миллиардов долларов инвестиций. [122] [123] Сообщается, что чат-бот Bing Chat от Microsoft вызывает враждебную и оскорбительную реакцию по отношению к своим пользователям. [124]

Машинное обучение использовалось в качестве стратегии для обновления доказательств, связанных с систематическим обзором и возросшей нагрузкой на рецензента, связанной с ростом биомедицинской литературы. Хотя оно улучшилось с тренировочными наборами, оно еще не достаточно развито, чтобы уменьшить нагрузку на рабочую нагрузку, не ограничивая необходимую чувствительность для самих исследований результатов. [125]

Различные подходы к машинному обучению могут страдать от различных предубеждений в данных. Система машинного обучения, специально обученная на текущих клиентах, может оказаться неспособной предсказать потребности новых групп клиентов, которые не представлены в обучающих данных. При обучении на созданных человеком данных машинное обучение, скорее всего, выявит конституционные и бессознательные предубеждения, уже присутствующие в обществе. [126]

Было показано, что языковые модели, полученные из данных, содержат человеческие предубеждения. [127] [128] В эксперименте, проведенном ProPublica , организацией журналистских расследований , алгоритм машинного обучения, анализирующий показатели рецидивизма среди заключенных, ложно помечал «чернокожих обвиняемых с высоким риском в два раза чаще, чем белых обвиняемых». [129] В 2015 году Google Photos часто помечал черных людей как горилл, [129] и в 2018 году эта проблема все еще не была решена, но Google, как сообщается, все еще использовал обходной путь для удаления всех горилл из обучающих данных и, таким образом, вообще не мог распознавать настоящих горилл. [130] Аналогичные проблемы с распознаванием небелых людей были обнаружены во многих других системах. [131] В 2016 году Microsoft протестировала Tay , чат-бота , который обучался у Twitter, и он быстро уловил расистский и сексистский язык. [132]

Из-за таких проблем эффективное использование машинного обучения может занять больше времени, чтобы быть принятым в других областях. [133] Озабоченность по поводу справедливости в машинном обучении, то есть снижения предвзятости в машинном обучении и продвижения его использования для блага человека, все чаще выражается учеными в области искусственного интеллекта, включая Фэй-Фэй Ли , который напоминает инженерам, что «в ИИ нет ничего искусственного. Он вдохновлен людьми, он создан людьми и — что самое важное — он влияет на людей. Это мощный инструмент, который мы только начинаем понимать, и это огромная ответственность». [134]

Объяснимый ИИ (XAI), или Интерпретируемый ИИ, или Объяснимое машинное обучение (XML) — это искусственный интеллект (ИИ), в котором люди могут понимать решения или прогнозы, сделанные ИИ. [135] Он контрастирует с концепцией «черного ящика» в машинном обучении, где даже его разработчики не могут объяснить, почему ИИ пришел к определенному решению. [136] Уточняя ментальные модели пользователей систем, работающих на основе ИИ, и разрушая их заблуждения, XAI обещает помочь пользователям действовать более эффективно. XAI может быть реализацией социального права на объяснение.

Остановка на плохой, слишком сложной теории, переделанной для соответствия всем прошлым тренировочным данным, известна как переобучение. Многие системы пытаются уменьшить переобучение, вознаграждая теорию в соответствии с тем, насколько хорошо она соответствует данным, но наказывая теорию в соответствии с тем, насколько она сложна. [137]

Учащиеся также могут разочаровать, «усвоив неправильный урок». Игрушечный пример: классификатор изображений, обученный только на фотографиях коричневых лошадей и черных кошек, может прийти к выводу, что все коричневые пятна, скорее всего, являются лошадьми. [138] Реальный пример: в отличие от людей, современные классификаторы изображений часто не выносят суждений на основе пространственных отношений между компонентами изображения, а изучают отношения между пикселями, которые люди не замечают, но которые все еще коррелируют с изображениями определенных типов реальных объектов. Изменение этих шаблонов на законном изображении может привести к «состязательным» изображениям, которые система неправильно классифицирует. [139] [140]

Уязвимости состязательных систем также могут возникать в нелинейных системах или в результате нешаблонных возмущений. Для некоторых систем возможно изменить вывод, изменив только один выбранный состязательным образом пиксель. [141] Модели машинного обучения часто уязвимы для манипуляций и/или уклонения посредством состязательного машинного обучения . [142]

Исследователи продемонстрировали, как бэкдоры могут быть незаметно размещены в классифицирующих (например, для категорий «спам» и хорошо видимых «не спам» сообщений) моделях машинного обучения, которые часто разрабатываются и/или обучаются третьими лицами. Стороны могут изменить классификацию любых входных данных, в том числе в случаях, когда предоставляется тип прозрачности данных/программного обеспечения , возможно, включая доступ к «белому ящику» . [143] [144] [145]

Классификация моделей машинного обучения может быть проверена с помощью методов оценки точности, таких как метод удержания , который разделяет данные на обучающий и тестовый набор (обычно 2/3 обучающего набора и 1/3 тестового набора) и оценивает производительность обучающей модели на тестовом наборе. Для сравнения, метод перекрестной проверки K-кратности случайным образом разделяет данные на K подмножеств, а затем выполняется K экспериментов, каждый из которых рассматривает 1 подмножество для оценки и оставшиеся K-1 подмножеств для обучения модели. В дополнение к методам удержания и перекрестной проверки, для оценки точности модели можно использовать бутстрап , который выбирает n экземпляров с заменой из набора данных. [146]

В дополнение к общей точности исследователи часто сообщают о чувствительности и специфичности , имея в виду истинно положительный показатель (TPR) и истинно отрицательный показатель (TNR) соответственно. Аналогично исследователи иногда сообщают ложноположительный показатель (FPR), а также ложноотрицательный показатель (FNR). Однако эти показатели являются отношениями, которые не раскрывают их числители и знаменатели. Общая рабочая характеристика (TOC) является эффективным методом выражения диагностической способности модели. TOC показывает числители и знаменатели ранее упомянутых показателей, таким образом, TOC предоставляет больше информации, чем обычно используемая рабочая характеристика приемника (ROC) и связанная с ROC площадь под кривой (AUC). [147]

Машинное обучение ставит множество этических вопросов . Системы, которые обучаются на наборах данных, собранных с предубеждениями, могут демонстрировать эти предубеждения при использовании ( алгоритмическое предубеждение ), тем самым оцифровывая культурные предрассудки. [148] Например, в 1988 году Комиссия по расовому равенству Великобритании обнаружила, что Медицинская школа Св. Георгия использовала компьютерную программу, обученную на данных предыдущих сотрудников приемной комиссии, и что эта программа отклонила почти 60 кандидатов, которые оказались либо женщинами, либо имели неевропейские имена. [126] Использование данных о найме на работу из фирмы с расистской политикой найма может привести к тому, что система машинного обучения будет дублировать предубеждение, оценивая кандидатов на работу по сходству с предыдущими успешными кандидатами. [149] [150] Другой пример включает в себя предиктивный алгоритм компании Geolitica , занимающейся полицейским прогнозированием , который привел к «непропорционально высокому уровню чрезмерного контроля в малообеспеченных и меньшинственных общинах» после обучения на исторических данных о преступлениях. [129]

Хотя ответственный сбор данных и документирование алгоритмических правил, используемых системой, считаются важнейшей частью машинного обучения, некоторые исследователи винят недостаточное участие и представительство меньшинств в области ИИ в уязвимости машинного обучения к предвзятости. [151] Фактически, согласно исследованию, проведенному Ассоциацией компьютерных исследований (CRA) в 2021 году, «женщины-преподаватели составляют всего 16,1%» всех преподавателей, которые занимаются ИИ в нескольких университетах по всему миру. [152] Кроме того, среди группы «новых выпускников аспирантуры по ИИ в США» 45% идентифицированы как белые, 22,4% как азиаты, 3,2% как латиноамериканцы и 2,4% как афроамериканцы, что еще раз демонстрирует отсутствие разнообразия в области ИИ. [152]

ИИ может быть хорошо оснащен для принятия решений в технических областях, которые в значительной степени опираются на данные и историческую информацию. Эти решения опираются на объективность и логическое обоснование. [153] Поскольку человеческие языки содержат предубеждения, машины, обученные на языковых корпусах , обязательно также изучат эти предубеждения. [154] [155]

Другие формы этических проблем, не связанные с личными предубеждениями, наблюдаются в здравоохранении. Среди специалистов в области здравоохранения существуют опасения, что эти системы могут быть разработаны не в интересах общественности, а как машины для получения дохода. [156] Это особенно актуально в Соединенных Штатах, где существует давняя этическая дилемма улучшения здравоохранения, но также и увеличения прибыли. Например, алгоритмы могут быть разработаны для предоставления пациентам ненужных тестов или лекарств, в которых владельцы алгоритма имеют долю. Существует потенциал для машинного обучения в здравоохранении, чтобы предоставить специалистам дополнительный инструмент для диагностики, лечения и планирования путей восстановления для пациентов, но для этого необходимо смягчить эти предубеждения. [157]

Начиная с 2010-х годов, достижения как в алгоритмах машинного обучения, так и в компьютерном оборудовании привели к более эффективным методам обучения глубоких нейронных сетей (определенная узкая подобласть машинного обучения), которые содержат много слоев нелинейных скрытых единиц. [158] К 2019 году графические процессоры ( GPU ), часто со специфическими для ИИ усовершенствованиями, вытеснили CPU в качестве доминирующего метода обучения крупномасштабного коммерческого облачного ИИ. [159] OpenAI оценила аппаратные вычисления, используемые в крупнейших проектах глубокого обучения от AlexNet (2012) до AlphaZero (2017), и обнаружила 300 000-кратное увеличение объема требуемых вычислений с трендом времени удвоения в 3,4 месяца. [160] [161]

Физическая нейронная сеть или нейроморфный компьютер — это тип искусственной нейронной сети , в которой электрически регулируемый материал используется для эмуляции функции нейронного синапса . «Физическая» нейронная сеть используется для того, чтобы подчеркнуть зависимость от физического оборудования, используемого для эмуляции нейронов, в отличие от подходов, основанных на программном обеспечении. В более общем смысле этот термин применим к другим искусственным нейронным сетям, в которых мемристор или другой электрически регулируемый материал сопротивления используется для эмуляции нейронного синапса. [162] [163]

Встроенное машинное обучение — это подраздел машинного обучения, в котором модель машинного обучения запускается на встроенных системах с ограниченными вычислительными ресурсами, таких как носимые компьютеры , периферийные устройства и микроконтроллеры . [164] [165] [166] Запуск модели машинного обучения на встроенных устройствах устраняет необходимость передачи и хранения данных на облачных серверах для дальнейшей обработки, в дальнейшем сокращая утечки данных и конфиденциальности, происходящие из-за передачи данных, а также сводит к минимуму кражу интеллектуальной собственности, персональных данных и деловых секретов. Встроенное машинное обучение может применяться с помощью нескольких методов, включая аппаратное ускорение , [167] [168] использование приближенных вычислений , [169] оптимизацию моделей машинного обучения и многое другое. [170] [171] Обрезка , квантование, дистилляция знаний , низкоранговая факторизация, поиск сетевой архитектуры (NAS) и совместное использование параметров — вот лишь некоторые из методов, используемых для оптимизации моделей машинного обучения.

Программные пакеты , содержащие различные алгоритмы машинного обучения, включают в себя следующее: