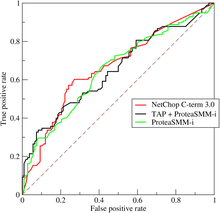

Кривая рабочей характеристики приемника , или кривая ROC , представляет собой графический график , иллюстрирующий эффективность модели бинарного классификатора (может использоваться и для многоклассовой классификации) при различных пороговых значениях.

Кривая ROC представляет собой график зависимости истинно положительного результата (TPR) от ложноположительного результата (FPR) при каждой настройке порогового значения.

ROC также можно рассматривать как график статистической мощности как функции ошибки типа I правила принятия решения (когда производительность рассчитывается только на основе выборки из совокупности, ее можно рассматривать как оценщики этих величин). Таким образом, ROC-кривая представляет собой чувствительность или полноту как функцию частоты ложных срабатываний .

Учитывая, что известны распределения вероятностей как для истинно положительных, так и для ложно положительных результатов, кривая ROC получается как кумулятивная функция распределения (CDF, площадь под распределением вероятностей от до порога дискриминации) вероятности обнаружения по оси Y в зависимости от CDF вероятности ложно положительных результатов по оси X.

Анализ ROC предоставляет инструменты для выбора потенциально оптимальных моделей и отбрасывания неоптимальных независимо от (и до указания) контекста затрат или распределения классов. Анализ ROC напрямую и естественным образом связан с анализом затрат/выгод принятия диагностических решений .

Истинно-положительный показатель также известен как чувствительность , отзыв или вероятность обнаружения . [1] Ложно-положительный показатель также известен как вероятность ложной тревоги [1] и равен (1 − специфичность ). ROC также известен как относительная кривая рабочей характеристики, поскольку он представляет собой сравнение двух рабочих характеристик (TPR и FPR) при изменении критерия. [2]

Кривая ROC была впервые разработана инженерами-электриками и инженерами-радиолокаторами во время Второй мировой войны для обнаружения вражеских объектов на полях сражений, начиная с 1941 года, что и привело к ее названию («рабочая характеристика приемника»). [3]

Вскоре он был введен в психологию для учета перцептивного обнаружения стимулов. Анализ ROC использовался в медицине , радиологии , биометрии , прогнозировании стихийных бедствий , [4] метеорологии , [5] оценке эффективности моделей [6] и других областях в течение многих десятилетий и все чаще используется в исследованиях машинного обучения и интеллектуального анализа данных .

Модель классификации ( классификатор или диагностика [7] ) — это отображение экземпляров между определенными классами/группами. Поскольку результат классификатора или диагностики может быть произвольным действительным значением (непрерывный вывод), граница классификатора между классами должна определяться пороговым значением (например, чтобы определить, есть ли у человека гипертония на основе измерения артериального давления ). Или это может быть дискретная метка класса, указывающая на один из классов.

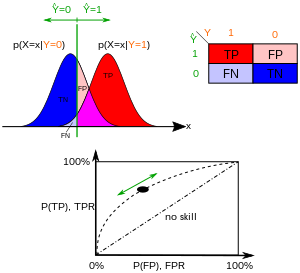

Рассмотрим задачу двухклассового прогнозирования ( бинарная классификация ), в которой результаты помечены как положительные ( p ) или отрицательные ( n ). Существует четыре возможных результата бинарного классификатора. Если результат прогноза равен p , а фактическое значение также равно p , то это называется истинно положительным (TP); однако если фактическое значение равно n , то это называется ложноположительным ( FP). И наоборот, истинно отрицательный (TN) результат имеет место, когда и результат прогноза, и фактическое значение равны n , а ложно отрицательный (FN) результат прогноза равен n , а фактическое значение равно p .

Чтобы получить подходящий пример в реальной проблеме, рассмотрим диагностический тест, который пытается определить, есть ли у человека определенное заболевание. Ложноположительный результат в этом случае возникает, когда у человека положительный результат теста, но на самом деле у него нет заболевания. Ложноотрицательный результат, с другой стороны, возникает, когда у человека отрицательный результат теста, предполагающий, что он здоров, хотя на самом деле у него есть заболевание.

Рассмотрим эксперимент с P положительными примерами и N отрицательными примерами для некоторого условия. Четыре результата можно сформулировать в виде таблицы сопряженности 2×2 или матрицы путаницы следующим образом:

Таблица сопряженности может вывести несколько «метрик» оценки (см. инфобокс). Для построения ROC-кривой необходимы только истинно положительные результаты (TPR) и ложноположительные результаты (FPR) (как функции некоторого параметра классификатора). TPR определяет, сколько правильных положительных результатов происходит среди всех положительных образцов, доступных во время теста. FPR, с другой стороны, определяет, сколько неправильных положительных результатов происходит среди всех отрицательных образцов, доступных во время теста.

Пространство ROC определяется FPR и TPR как оси x и y соответственно, которые отображают относительные компромиссы между истинным положительным результатом (выгоды) и ложным положительным результатом (затраты). Поскольку TPR эквивалентно чувствительности, а FPR равно 1 − специфичность , график ROC иногда называют графиком чувствительности против (1 − специфичность). Каждый результат прогноза или пример матрицы путаницы представляет одну точку в пространстве ROC.

Наилучший возможный метод прогнозирования даст точку в верхнем левом углу или координату (0,1) пространства ROC, что представляет 100% чувствительность (без ложных отрицательных результатов) и 100% специфичность (без ложных положительных результатов). Точка (0,1) также называется идеальной классификацией . Случайная догадка даст точку вдоль диагональной линии (так называемой линии недискриминации ) от нижнего левого до верхнего правого угла (независимо от положительных и отрицательных базовых ставок ). [16] Интуитивным примером случайной догадки является решение, принимаемое путем подбрасывания монет. По мере увеличения размера выборки точка ROC случайного классификатора стремится к диагональной линии. В случае сбалансированной монеты она будет стремиться к точке (0,5, 0,5).

Диагональ делит пространство ROC. Точки над диагональю представляют хорошие результаты классификации (лучше случайных); точки под линией представляют плохие результаты (хуже случайных). Обратите внимание, что вывод постоянно плохого предиктора можно просто инвертировать, чтобы получить хороший предиктор.

Рассмотрим четыре результата прогнозирования из 100 положительных и 100 отрицательных случаев:

Графики четырех результатов выше в пространстве ROC приведены на рисунке. Результат метода A ясно показывает лучшую предсказательную силу среди A , B , и C . Результат B лежит на линии случайного предположения (диагональная линия), и в таблице можно увидеть, что точность B составляет 50%. Однако, когда C зеркально отображается относительно центральной точки (0,5, 0,5), результирующий метод C′ даже лучше, чем A . Этот зеркальный метод просто меняет предсказания любого метода или теста, создавшего таблицу сопряженности C. Хотя исходный метод C имеет отрицательную предсказательную силу, простое изменение его решений приводит к новому предсказательному методу C′, который имеет положительную предсказательную силу. Когда метод C предсказывает p или n , метод C′ предскажет n или p , соответственно. Таким образом, тест C′ будет работать лучше всего. Чем ближе результат из таблицы сопряженности к верхнему левому углу, тем лучше он предсказывает, но расстояние от линии случайной догадки в любом направлении является лучшим индикатором того, насколько предсказательной силой обладает метод. Если результат находится ниже линии (т. е. метод хуже случайной догадки), все предсказания метода должны быть обращены вспять, чтобы использовать его силу, тем самым перемещая результат выше линии случайной догадки.

В бинарной классификации предсказание класса для каждого экземпляра часто делается на основе непрерывной случайной величины , которая является «оценкой», вычисленной для экземпляра (например, предполагаемая вероятность в логистической регрессии). При заданном пороговом параметре экземпляр классифицируется как «положительный», если , и «отрицательный» в противном случае. следует плотности вероятности , если экземпляр действительно принадлежит к классу «положительный», и если в противном случае. Таким образом, истинно положительный показатель определяется как , а ложноположительный показатель определяется как . Кривая ROC параметрически строится в зависимости от того, какой параметр является переменным.

Например, представьте, что уровни белка в крови у больных и здоровых людей распределены нормально со средними значениями 2 г / дл и 1 г/дл соответственно. Медицинский тест может измерить уровень определенного белка в образце крови и классифицировать любое число выше определенного порога как указание на заболевание. Экспериментатор может отрегулировать порог (зеленая вертикальная линия на рисунке), что, в свою очередь, изменит уровень ложноположительных результатов. Увеличение порога приведет к меньшему количеству ложноположительных результатов (и большему количеству ложноотрицательных результатов), что соответствует движению кривой влево. Фактическая форма кривой определяется тем, насколько перекрываются два распределения.

Несколько исследований критикуют определенные применения кривой ROC и ее площади под кривой в качестве измерений для оценки бинарных классификаций, когда они не охватывают информацию, относящуюся к применению. [18] [17] [19] [20] [21]

Основная критика ROC-кривой, описанной в этих исследованиях, касается включения областей с низкой чувствительностью и низкой специфичностью (оба ниже 0,5) для расчета общей площади под кривой (AUC) [19] , как показано на графике справа.

По мнению авторов этих исследований, эта часть площади под кривой (с низкой чувствительностью и низкой специфичностью) касается матриц путаницы, где бинарные предсказания дают плохие результаты, и поэтому не должна включаться в оценку общей производительности. Более того, эта часть AUC указывает на пространство с высоким или низким порогом матрицы путаницы, которое редко представляет интерес для ученых, выполняющих бинарную классификацию в любой области. [19]

Еще одно замечание в адрес ROC и его площади под кривой заключается в том, что они ничего не говорят о точности и отрицательной прогностической ценности. [17]

Высокий ROC AUC, например 0,9, может соответствовать низким значениям точности и отрицательной предсказательной ценности, таким как 0,2 и 0,1 в диапазоне [0, 1]. Если кто-то выполнил бинарную классификацию, получил ROC AUC 0,9 и решил сосредоточиться только на этой метрике, он может чрезмерно оптимистично полагать, что его бинарный тест был превосходным. Однако, если этот человек взглянет на значения точности и отрицательной предсказательной ценности, он может обнаружить, что их значения низкие.

ROC AUC суммирует чувствительность и специфичность, но не дает информации о точности и отрицательной прогностической ценности. [17]

Иногда ROC используется для создания сводной статистики. Распространенные версии:

Однако любая попытка суммировать кривую ROC в одно число приводит к потере информации о закономерностях компромиссов конкретного алгоритма дискриминатора.

Площадь под кривой (часто называемая просто AUC) равна вероятности того, что классификатор оценит случайно выбранный положительный экземпляр выше, чем случайно выбранный отрицательный (предполагая, что «положительный» ранг выше, чем «отрицательный»). [26] Другими словами, когда дан один случайно выбранный положительный экземпляр и один случайно выбранный отрицательный экземпляр, AUC — это вероятность того, что классификатор сможет сказать, какой из них какой.

Это можно увидеть следующим образом: площадь под кривой определяется выражением (границы интеграла меняются местами, поскольку больший порог имеет меньшее значение на оси x )

где — оценка положительного случая, — оценка отрицательного случая, а и — плотности вероятности, определенные в предыдущем разделе.

Если и следует двум гауссовым распределениям, то .

Можно показать, что AUC тесно связана с U Манна-Уитни , [27] [28] , который проверяет, ранжируются ли положительные результаты выше, чем отрицательные. Для предиктора несмещенная оценка его AUC может быть выражена следующей статистикой Вилкоксона-Манна-Уитни : [29]

где обозначает индикаторную функцию , которая возвращает 1, в противном случае возвращает 0; — множество отрицательных примеров, а — множество положительных примеров.

В контексте кредитного скоринга часто используется измененная версия AUC:

.

называется индексом Джини или коэффициентом Джини, [30] но его не следует путать с мерой статистической дисперсии, которая также называется коэффициентом Джини . является частным случаем D Сомерса .

Также принято вычислять площадь под выпуклой оболочкой ROC (ROC AUCH = ROCH AUC), поскольку любая точка на отрезке линии между двумя результатами прогнозирования может быть достигнута путем случайного использования одной или другой системы с вероятностями, пропорциональными относительной длине противоположного компонента отрезка. [31] Также возможно инвертировать вогнутости — как на рисунке, худшее решение может быть отражено, чтобы стать лучшим решением; вогнутости могут быть отражены в любом отрезке линии, но эта более экстремальная форма слияния гораздо более вероятно приведет к переобучению данных. [32]

Сообщество машинного обучения чаще всего использует статистику ROC AUC для сравнения моделей. [33] Эта практика была подвергнута сомнению, поскольку оценки AUC довольно шумные и страдают от других проблем. [34] [35] [36] Тем не менее, согласованность AUC как меры агрегированной эффективности классификации была подтверждена с точки зрения равномерного распределения скорости, [37] и AUC была связана с рядом других показателей эффективности, таких как оценка Брайера . [38]

Другая проблема с ROC AUC заключается в том, что сведение ROC-кривой к одному числу игнорирует тот факт, что речь идет о компромиссах между различными системами или нанесенными на график точками производительности, а не о производительности отдельной системы, а также игнорирует возможность исправления вогнутости, поэтому рекомендуются связанные альтернативные меры, такие как Информированность [ требуется ссылка ] или DeltaP. [23] [39] Эти меры по сути эквивалентны индексу Джини для одной точки прогнозирования с DeltaP' = Информированность = 2AUC-1, в то время как DeltaP = Маркированность представляет собой дуал (т. е. прогнозирование прогноза из реального класса), а их геометрическое среднее является коэффициентом корреляции Мэтьюза [ требуется ссылка ]

В то время как ROC AUC варьируется от 0 до 1 — с неинформативным классификатором, дающим 0,5 — альтернативные меры, известные как Информированность , [ требуется ссылка ] Определенность [23] и Коэффициент Джини (в случае одиночной параметризации или одиночной системы) [ требуется ссылка ] имеют то преимущество, что 0 представляет собой случайное выполнение, в то время как 1 представляет собой идеальное выполнение, а −1 представляет собой «извращенный» случай полной информированности, всегда дающий неправильный ответ. [40] Приведение случайного выполнения к 0 позволяет интерпретировать эти альтернативные шкалы как статистику Каппы. Было показано, что информированность имеет желаемые характеристики для машинного обучения по сравнению с другими распространенными определениями Каппы, такими как Каппа Коэна и Каппа Флейсса . [ требуется ссылка ] [41]

Иногда может быть полезнее взглянуть на определенную область ROC-кривой, а не на всю кривую. Можно вычислить частичную AUC . [42] Например, можно сосредоточиться на области кривой с низким уровнем ложноположительных результатов, которая часто представляет основной интерес для тестов скрининга населения. [43] Другой распространенный подход к задачам классификации, в которых P ≪ N (распространенный в приложениях биоинформатики), заключается в использовании логарифмической шкалы для оси x . [44]

Площадь ROC под кривой также называется c-статистикой или c-статистикой . [45]

Общая операционная характеристика (TOC) также характеризует диагностическую способность, раскрывая при этом больше информации, чем ROC. Для каждого порога ROC раскрывает два соотношения, TP/(TP + FN) и FP/(FP + TN). Другими словами, ROC раскрывает и . С другой стороны, TOC показывает общую информацию в таблице сопряженности для каждого порога. [46] Метод TOC раскрывает всю информацию, которую предоставляет метод ROC, плюс дополнительную важную информацию, которую ROC не раскрывает, то есть размер каждой записи в таблице сопряженности для каждого порога. TOC также предоставляет популярную AUC ROC. [47]

Эти рисунки представляют собой кривые TOC и ROC, использующие те же данные и пороговые значения. Рассмотрим точку, которая соответствует пороговому значению 74. Кривая TOC показывает количество попаданий, которое равно 3, и, следовательно, количество промахов, которое равно 7. Кроме того, кривая TOC показывает, что количество ложных тревог равно 4, а количество правильных отклонений равно 16. В любой заданной точке кривой ROC можно почерпнуть значения для отношений и . Например, при пороговом значении 74 очевидно, что координата x равна 0,2, а координата y равна 0,3. Однако этих двух значений недостаточно для построения всех записей базовой таблицы сопряженности два на два.

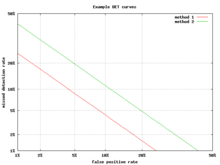

Альтернативой кривой ROC является график компромисса между ошибкой обнаружения (DET), который отображает частоту ложных отрицательных результатов (пропущенные обнаружения) и частоту ложных положительных результатов (ложные тревоги) на нелинейно преобразованных осях x и y. Функция преобразования является функцией квантиля нормального распределения, т. е. обратной кумулятивному нормальному распределению. По сути, это то же самое преобразование, что и zROC, ниже, за исключением того, что используется дополнение частоты попаданий, частота промахов или частота ложных отрицательных результатов. Эта альтернатива тратит большую площадь графика на интересующую область. Большая часть области ROC не представляет особого интереса; в первую очередь нас интересует область, примыкающая к оси y , и верхний левый угол, который из-за использования частоты промахов вместо ее дополнения, частоты попаданий, является нижним левым углом на графике DET. Кроме того, графики DET обладают полезным свойством линейности и линейного порогового поведения для нормальных распределений. [48] График DET широко используется в сообществе автоматического распознавания говорящего , где впервые было использовано название DET. Анализ производительности ROC в графиках с этой деформацией осей использовался психологами в исследованиях восприятия в середине 20-го века, [ требуется ссылка ], где это было названо «бумагой двойной вероятности». [49]

Если к кривой ROC применить стандартную оценку , кривая преобразуется в прямую линию. [50] Эта z-оценка основана на нормальном распределении со средним значением, равным нулю, и стандартным отклонением, равным единице. В теории силы памяти необходимо предположить, что zROC не только линейна, но и имеет наклон 1,0. Нормальное распределение целей (изученных объектов, которые субъекты должны вспомнить) и приманок (неизученных объектов, которые субъекты пытаются вспомнить) является фактором, заставляющим zROC быть линейной.

Линейность кривой zROC зависит от стандартных отклонений распределения силы цели и приманки. Если стандартные отклонения равны, наклон будет равен 1,0. Если стандартное отклонение распределения силы цели больше стандартного отклонения распределения силы приманки, то наклон будет меньше 1,0. В большинстве исследований было обнаружено, что наклоны кривой zROC постоянно опускаются ниже 1, обычно между 0,5 и 0,9. [51] Многие эксперименты дали наклон zROC 0,8. Наклон 0,8 подразумевает, что изменчивость распределения силы цели на 25% больше, чем изменчивость распределения силы приманки. [52]

Другая используемая переменная — d' (d prime) (обсуждалась выше в разделе «Другие меры»), которую можно легко выразить через z-значения. Хотя d ' — это часто используемый параметр, следует признать, что он имеет значение только при строгом соблюдении очень сильных предположений теории прочности, сделанных выше. [53]

Z-оценка кривой ROC всегда линейна, как и предполагалось, за исключением особых ситуаций. Модель знакомства-воспоминания Йонелинаса представляет собой двумерный отчет об узнавании памяти. Вместо того, чтобы субъект просто отвечал «да» или «нет» на определенный ввод, субъект дает вводу ощущение знакомства, которое работает как исходная кривая ROC. Однако, что меняется, так это параметр для Воспоминания (R). Воспоминание предполагается как «все или ничего», и оно преобладает над знакомством. Если бы не было компонента воспоминания, zROC имел бы прогнозируемый наклон 1. Однако при добавлении компонента воспоминания кривая zROC будет вогнутой вверх с уменьшенным наклоном. Эта разница в форме и наклоне является результатом добавленного элемента изменчивости из-за припоминания некоторых элементов. Пациенты с антероградной амнезией не способны вспомнить, поэтому их кривая zROC Йонелинаса имела бы наклон, близкий к 1,0. [54]

Кривая ROC впервые была использована во время Второй мировой войны для анализа радиолокационных сигналов , прежде чем она была применена в теории обнаружения сигналов . [55] После атаки на Перл-Харбор в 1941 году военные США начали новые исследования, чтобы улучшить прогнозирование правильно обнаруженных японских самолетов по их радиолокационным сигналам. Для этих целей они измерили способность оператора радиолокационного приемника делать эти важные различия, что было названо рабочей характеристикой приемника. [56]

В 1950-х годах ROC-кривые использовались в психофизике для оценки обнаружения слабых сигналов человеком (а иногда и животными). [55] В медицине ROC-анализ широко использовался при оценке диагностических тестов . [57] [58] ROC-кривые также широко используются в эпидемиологии и медицинских исследованиях и часто упоминаются в сочетании с доказательной медициной . В радиологии ROC-анализ является распространенным методом оценки новых методов радиологии. [59] В социальных науках ROC-анализ часто называют коэффициентом точности ROC, распространенным методом оценки точности моделей вероятности по умолчанию. ROC-кривые широко используются в лабораторной медицине для оценки диагностической точности теста, выбора оптимального порогового значения теста и сравнения диагностической точности нескольких тестов.

ROC-кривые также оказались полезными для оценки методов машинного обучения . Первое применение ROC в машинном обучении было сделано Спэкманом, который продемонстрировал ценность ROC-кривых при сравнении и оценке различных алгоритмов классификации . [60]

Кривые ROC также используются для проверки прогнозов в метеорологии. [61]

Как уже упоминалось, кривые ROC имеют решающее значение для работы и теории радара . Сигналы, полученные на приемной станции, отраженные целью, часто имеют очень низкую энергию по сравнению с уровнем шума . Отношение сигнала к шуму является важным показателем при определении того, будет ли обнаружена цель. Это отношение сигнала к шуму напрямую коррелирует с рабочими характеристиками приемника всей радиолокационной системы, которые используются для количественной оценки возможностей радиолокационной системы.

Рассмотрим разработку радиолокационной системы. Спецификация возможностей системы может быть предоставлена в терминах вероятности обнаружения, , с определенным допуском ложных тревог, . Упрощенное приближение требуемого отношения сигнал/шум на приемной станции может быть рассчитано путем решения [62]

для отношения сигнал/шум . Здесь не в децибелах , как это принято во многих радиолокационных приложениях. Преобразование в децибелы осуществляется через . Из этого рисунка можно решить общие записи в уравнении дальности действия радара (с коэффициентами шума) для оценки требуемой эффективной излучаемой мощности .

Расширение кривых ROC для задач классификации с более чем двумя классами является громоздким. Два распространенных подхода для случаев, когда есть несколько классов, это (1) усреднение по всем парным значениям AUC [63] и (2) вычисление объема под поверхностью (VUS). [64] [65] Чтобы усреднить по всем парным классам, вычисляется AUC для каждой пары классов, используя только примеры из этих двух классов, как если бы не было других классов, а затем усредняются эти значения AUC по всем возможным парам. Когда есть c классов, будет c ( c − 1) / 2 возможных пар классов.

Подход объема под поверхностью предполагает построение гиперповерхности, а не кривой, а затем измерение гиперобъема под этой гиперповерхностью. Каждое возможное правило принятия решения, которое можно использовать для классификатора для c классов, можно описать в терминах его истинно положительных показателей (TPR 1 , . . . , TPR c ) . Именно этот набор показателей определяет точку, а набор всех возможных правил принятия решения дает облако точек, которые определяют гиперповерхность. При таком определении VUS представляет собой вероятность того, что классификатор сможет правильно пометить все c примеров, когда ему дан набор, содержащий один случайно выбранный пример из каждого класса. Реализация классификатора, который знает, что его входной набор состоит из одного примера из каждого класса, может сначала вычислить оценку соответствия для каждой из c 2 возможных пар примера с классом, а затем применить венгерский алгоритм для максимизации суммы c выбранных оценок по всем c ! возможным способам назначения ровно одного примера каждому классу.

Учитывая успех кривых ROC для оценки моделей классификации, также было исследовано расширение кривых ROC для других контролируемых задач. Известными предложениями для проблем регрессии являются так называемые кривые характеристики ошибки регрессии (REC) [66] и кривые ROC регрессии (RROC). [67] В последнем случае кривые RROC становятся чрезвычайно похожими на кривые ROC для классификации с понятиями асимметрии, доминирования и выпуклой оболочки. Кроме того, площадь под кривыми RROC пропорциональна дисперсии ошибки регрессионной модели.

{{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link)