В статистике коэффициент детерминации , обозначаемый R2 или r2 и произносимый как «R в квадрате » , представляет собой долю вариации зависимой переменной, которая предсказуема на основе независимой(ых) переменной(ых) .

Это статистика, используемая в контексте статистических моделей, чьей основной целью является либо предсказание будущих результатов, либо проверка гипотез на основе другой связанной информации. Она обеспечивает меру того, насколько хорошо наблюдаемые результаты воспроизводятся моделью, на основе доли общей вариации результатов, объясняемых моделью. [1] [2] [3]

Существует несколько определений R 2 , которые лишь иногда эквивалентны. Один класс таких случаев включает простую линейную регрессию , где r 2 используется вместо R 2 . Когда включен только отсекаемый член , то r 2 является просто квадратом коэффициента корреляции выборки (т. е. r ) между наблюдаемыми результатами и наблюдаемыми значениями предиктора. [4] Если включены дополнительные регрессоры , R 2 является квадратом коэффициента множественной корреляции . В обоих таких случаях коэффициент детерминации обычно находится в диапазоне от 0 до 1.

Существуют случаи, когда R 2 может давать отрицательные значения. Это может возникнуть, когда прогнозы, которые сравниваются с соответствующими результатами, не были получены из процедуры подгонки модели с использованием этих данных. Даже если была использована процедура подгонки модели, R 2 все равно может быть отрицательным, например, когда линейная регрессия проводится без включения отсекателя [5] или когда для подгонки данных используется нелинейная функция. [6] В случаях, когда возникают отрицательные значения, среднее значение данных обеспечивает лучшее соответствие результатам, чем подогнанные значения функции, согласно этому конкретному критерию.

Коэффициент детерминации может быть более интуитивно информативным, чем MAE , MAPE , MSE и RMSE при оценке регрессионного анализа , поскольку первый может быть выражен в процентах, тогда как последние меры имеют произвольные диапазоны. Он также оказался более надежным для плохих подгонок по сравнению с SMAPE на тестовых наборах данных в статье. [7]

При оценке степени соответствия смоделированных ( Y pred ) и измеренных ( Y obs ) значений нецелесообразно основывать это на R 2 линейной регрессии (т. е. Y obs = m · Y pred + b). [ требуется цитирование ] R 2 количественно определяет степень любой линейной корреляции между Y obs и Y pred , в то время как для оценки степени соответствия следует учитывать только одну конкретную линейную корреляцию: Y obs = 1 · Y pred + 0 (т. е . линию 1:1). [8] [9]

Набор данных содержит n значений, обозначенных как y 1 , ..., y n (совместно именуемых y i или вектором y = [ y 1 , ..., y n ] T ), каждое из которых связано с подобранным (или смоделированным, или предсказанным) значением f 1 , ..., f n (известным как f i , или иногда ŷ i , как вектор f ).

Определим остатки как e i = y i − f i (образуя вектор e ).

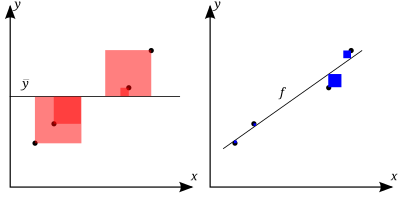

Если — среднее значение наблюдаемых данных: тогда изменчивость набора данных можно измерить с помощью двух формул суммы квадратов :

Наиболее общее определение коэффициента детерминации:

В лучшем случае смоделированные значения точно соответствуют наблюдаемым значениям, что приводит к R 2 = 1. Базовая модель, которая всегда предсказывает y , будет иметь R 2 = 0 .

В общем виде R 2 можно рассматривать как связанный с долей необъясненной дисперсии (FVU), поскольку второй член сравнивает необъясненную дисперсию (дисперсию ошибок модели) с общей дисперсией (данных):

Большее значение R 2 подразумевает более успешную модель регрессии. [4] : 463 Предположим, что R 2 = 0,49 . Это означает, что 49% изменчивости зависимой переменной в наборе данных было учтено, а оставшиеся 51% изменчивости все еще не учтены. Для моделей регрессии сумма квадратов регрессии, также называемая объясненной суммой квадратов , определяется как

В некоторых случаях, как в простой линейной регрессии , общая сумма квадратов равна сумме двух других сумм квадратов, определенных выше:

См. Partitioning in the general OLS model для вывода этого результата для одного случая, когда это отношение выполняется. Когда это отношение выполняется, приведенное выше определение R 2 эквивалентно

где n — количество наблюдений (случаев) по переменным.

В этой форме R 2 выражается как отношение объясненной дисперсии (дисперсии предсказаний модели, которая равна SS reg / n ) к общей дисперсии (выборочной дисперсии зависимой переменной, которая равна SS tot / n ).

Это разбиение суммы квадратов выполняется, например, когда значения модели ƒ i получены с помощью линейной регрессии . Более мягкое достаточное условие выглядит следующим образом: Модель имеет вид

где q i — произвольные значения, которые могут зависеть или не зависеть от i или от других свободных параметров (общий выбор q i = x i является лишь одним частным случаем), а оценки коэффициентов и получаются путем минимизации остаточной суммы квадратов.

Этот набор условий является важным и имеет ряд последствий для свойств подобранных остатков и смоделированных значений. В частности, при этих условиях:

В линейной множественной регрессии наименьших квадратов (с подобранным свободным отрезком и наклоном) R 2 равен квадрату коэффициента корреляции Пирсона между наблюдаемыми и смоделированными (прогнозируемыми) значениями данных зависимой переменной.

В линейной регрессии наименьших квадратов с одним объясняющим фактором (с подобранным свободным отрезком и наклоном) это также равно квадрату коэффициента корреляции Пирсона между зависимой переменной и объясняющей переменной .

Его не следует путать с коэффициентом корреляции между двумя объясняющими переменными , определяемым как

где ковариация между двумя оценками коэффициентов, а также их стандартные отклонения , получаются из ковариационной матрицы оценок коэффициентов, .

В более общих условиях моделирования, когда прогнозируемые значения могут быть получены из модели, отличной от линейной регрессии наименьших квадратов, значение R 2 может быть рассчитано как квадрат коэффициента корреляции между исходными и смоделированными значениями данных. В этом случае значение не является прямой мерой того, насколько хороши смоделированные значения, а скорее мерой того, насколько хорош предиктор, который может быть построен из смоделированных значений (путем создания пересмотренного предиктора формы α + βƒ i ). [ необходима цитата ] Согласно Эверитту [10], это использование является конкретно определением термина «коэффициент детерминации»: квадрат корреляции между двумя (общими) переменными.

R 2 — это мера качества соответствия модели. [11] В регрессии коэффициент детерминации R 2 — это статистическая мера того, насколько хорошо предсказания регрессии приближаются к реальным точкам данных. R 2 , равный 1, указывает на то, что предсказания регрессии идеально соответствуют данным.

Значения R 2 вне диапазона от 0 до 1 возникают, когда модель соответствует данным хуже, чем наихудший возможный предиктор наименьших квадратов (эквивалент горизонтальной гиперплоскости на высоте, равной среднему значению наблюдаемых данных). Это происходит, когда была выбрана неправильная модель или по ошибке были применены бессмысленные ограничения. Если используется уравнение 1 Квольсета [12] (это уравнение используется чаще всего), R 2 может быть меньше нуля. Если используется уравнение 2 Квольсета, R 2 может быть больше единицы.

Во всех случаях, когда используется R 2 , предикторы вычисляются с помощью обычной регрессии наименьших квадратов: то есть путем минимизации SS res . В этом случае R 2 увеличивается по мере увеличения числа переменных в модели ( R 2 монотонно увеличивается с числом включенных переменных — он никогда не уменьшится). Это иллюстрирует недостаток одного из возможных вариантов использования R 2 , когда можно продолжать добавлять переменные ( регрессия кухонной раковины ) для увеличения значения R 2 . Например, если кто-то пытается предсказать продажи модели автомобиля по расходу бензина автомобиля, цене и мощности двигателя, можно включить, вероятно, не имеющие значения факторы, такие как первая буква названия модели или рост ведущего инженера, проектирующего автомобиль, потому что R 2 никогда не уменьшится по мере добавления переменных и, скорее всего, увеличится исключительно по воле случая.

Это приводит к альтернативному подходу рассмотрения скорректированного R2. Объяснение этой статистики почти такое же, как и R2 , но оно штрафует статистику, поскольку в модель включены дополнительные переменные. Для случаев, отличных от подгонки обычными наименьшими квадратами, статистика R2 может быть рассчитана, как указано выше, и все еще может быть полезной мерой. Если подгонка осуществляется взвешенными наименьшими квадратами или обобщенными наименьшими квадратами , альтернативные версии R2 могут быть рассчитаны в соответствии с этими статистическими рамками, в то время как «сырой» R2 все еще может быть полезен , если его легче интерпретировать. Значения для R2 могут быть рассчитаны для любого типа прогностической модели, которая не обязательно должна иметь статистическую основу.

Рассмотрим линейную модель с более чем одной объясняющей переменной в форме

где для i- го случая — это ответная переменная, — p -регрессоры, а — среднее значение нулевой ошибки . Величины — это неизвестные коэффициенты, значения которых оцениваются методом наименьших квадратов . Коэффициент детерминации R 2 — это мера глобального соответствия модели. В частности, R 2 — это элемент [0, 1] и представляет собой долю изменчивости в Y i , которая может быть отнесена к некоторой линейной комбинации регрессоров ( объясняющих переменных ) в X . [13]

R 2 часто интерпретируется как доля вариации отклика, «объясненная» регрессорами в модели. Таким образом, R 2 = 1 указывает на то, что подобранная модель объясняет всю изменчивость в , в то время как R 2 = 0 указывает на отсутствие «линейной» связи (для прямой линейной регрессии это означает, что прямая линейная модель представляет собой постоянную линию (наклон = 0, отсекаемый отрезок = ) между переменной отклика и регрессорами). Внутреннее значение, такое как R 2 = 0,7, можно интерпретировать следующим образом: «Семьдесят процентов дисперсии в переменной отклика можно объяснить объясняющими переменными. Остальные тридцать процентов можно отнести к неизвестным, скрытым переменным или присущей изменчивости».

Предостережение, которое относится к R 2 , как и к другим статистическим описаниям корреляции и ассоциации, заключается в том, что « корреляция не подразумевает причинно-следственную связь ». Другими словами, хотя корреляции иногда могут давать ценные подсказки в раскрытии причинно-следственных связей между переменными, ненулевая оценочная корреляция между двумя переменными сама по себе не является доказательством того, что изменение значения одной переменной приведет к изменению значений других переменных. Например, практика ношения спичек (или зажигалки) коррелирует с заболеваемостью раком легких, но ношение спичек не вызывает рак (в стандартном смысле «причины»).

В случае одного регрессора, подобранного по наименьшим квадратам, R 2 является квадратом коэффициента корреляции Пирсона, связывающего регрессор и переменную отклика. В более общем смысле, R 2 является квадратом корреляции между сконструированным предиктором и переменной отклика. При наличии более одного регрессора R 2 можно назвать коэффициентом множественной детерминации .

В регрессии наименьших квадратов с использованием типичных данных R 2 по крайней мере слабо увеличивается с увеличением числа регрессоров в модели. Поскольку увеличение числа регрессоров увеличивает значение R 2 , R 2 сам по себе не может использоваться в качестве осмысленного сравнения моделей с очень разным числом независимых переменных. Для осмысленного сравнения двух моделей можно выполнить F-тест на остаточной сумме квадратов [ требуется ссылка ] , аналогично F-тестам в причинности по Грейнджеру , хотя это не всегда уместно [ требуется дополнительное объяснение ] . В качестве напоминания об этом некоторые авторы обозначают R 2 как R q 2 , где q — число столбцов в X (число объясняющих факторов, включая константу).

Чтобы продемонстрировать это свойство, сначала вспомним, что цель линейной регрессии наименьших квадратов —

где X i — вектор-строка значений объясняющих переменных для случая i, а b — вектор-столбец коэффициентов соответствующих элементов X i .

Оптимальное значение цели слабо меньше по мере добавления дополнительных объясняющих переменных и, следовательно, дополнительных столбцов (матрицы объясняющих данных, i -я строка которой — X i ), из-за того, что менее ограниченная минимизация приводит к оптимальной стоимости, которая слабо меньше, чем более ограниченная минимизация. Учитывая предыдущий вывод и отмечая, что зависит только от y , свойство неубывания R 2 следует непосредственно из определения выше.

Интуитивная причина того, что использование дополнительной объясняющей переменной не может снизить R 2 , заключается в следующем: минимизация эквивалентна максимизации R 2 . Когда включена дополнительная переменная, данные всегда имеют возможность придать ей оценочный коэффициент, равный нулю, оставляя прогнозируемые значения и R 2 неизменными. Единственный способ, которым задача оптимизации даст ненулевой коэффициент, — это если это улучшит R 2 .

Вышеизложенное дает аналитическое объяснение инфляции R 2 . Далее, ниже показан пример, основанный на обычном наименьшем квадрате с геометрической точки зрения. [14]

Сначала рассмотрим простой случай:

Это уравнение описывает обычную модель регрессии наименьших квадратов с одним регрессором. Прогноз показан красным вектором на рисунке справа. Геометрически это проекция истинного значения на модельное пространство в (без пересечения). Остаток показан красной линией.

Это уравнение соответствует обычной модели регрессии наименьших квадратов с двумя регрессорами. Прогноз показан в виде синего вектора на рисунке справа. Геометрически это проекция истинного значения на большее пространство модели в (без отсекателя). Примечательно, что значения и не совпадают с значениями в уравнении для меньшего пространства модели, пока и не являются нулевыми векторами. Поэтому ожидается, что уравнения дадут разные прогнозы (т. е. ожидается, что синий вектор будет отличаться от красного вектора). Критерий регрессии наименьших квадратов гарантирует, что остаток минимизируется. На рисунке синяя линия, представляющая остаток, ортогональна пространству модели в , что дает минимальное расстояние от пространства.

Меньшее пространство модели является подпространством большего, и, таким образом, остаток меньшей модели гарантированно будет больше. Сравнивая красную и синюю линии на рисунке, синяя линия ортогональна пространству, и любая другая линия будет больше синей. Принимая во внимание расчет для R 2 , меньшее значение приведет к большему значению R 2 , что означает, что добавление регрессоров приведет к инфляции R 2 .

В R 2 не указано:

Использование скорректированного R 2 (одно из распространенных обозначений — , произносится как «R bar squared»; другое — или ) — это попытка объяснить явление автоматического увеличения R 2 при добавлении в модель дополнительных объясняющих переменных. Существует множество различных способов корректировки. [15] Наиболее часто используемым из них, до такой степени, что его обычно называют просто скорректированным R , является поправка, предложенная Мордехаем Иезекиилем . [15] [16] [17] Скорректированный R 2 определяется как

где df res — степени свободы оценки дисперсии совокупности вокруг модели, а df tot — степени свободы оценки дисперсии совокупности вокруг среднего значения. df res задается через размер выборки n и количество переменных p в модели, df res = n − p − 1. df tot задается таким же образом, но с p , равным единице для среднего значения, т. е. df tot = n − 1 .

Вставляя степени свободы и используя определение R 2 , его можно переписать как:

где p — общее число объясняющих переменных в модели (исключая свободный член), а n — размер выборки.

Скорректированный R 2 может быть отрицательным, и его значение всегда будет меньше или равно значению R 2 . В отличие от R 2 , скорректированный R 2 увеличивается только тогда, когда увеличение R 2 (из-за включения новой объясняющей переменной) больше, чем можно было бы ожидать увидеть случайно. Если набор объясняющих переменных с предопределенной иерархией важности вводится в регрессию по одной за раз, при этом скорректированный R 2 вычисляется каждый раз, уровень, на котором скорректированный R 2 достигает максимума и затем уменьшается, будет регрессией с идеальной комбинацией наилучшего соответствия без лишних/ненужных членов.

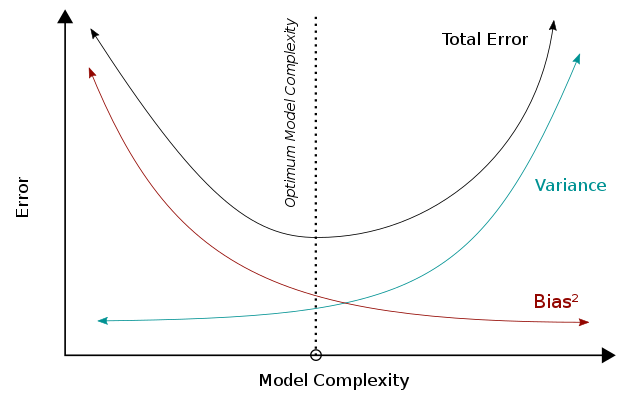

Скорректированный R 2 можно интерпретировать как пример компромисса смещения-дисперсии . Когда мы рассматриваем производительность модели, меньшая ошибка представляет лучшую производительность. Когда модель становится более сложной, дисперсия будет увеличиваться, тогда как квадрат смещения будет уменьшаться, и эти две метрики в сумме будут составлять общую ошибку. Объединяя эти две тенденции, компромисс смещения-дисперсии описывает связь между производительностью модели и ее сложностью, которая показана в виде U-образной кривой справа. Для скорректированного R 2 в частности сложность модели (т. е. количество параметров) влияет на R 2 и член / frac и тем самым фиксирует их атрибуты в общей производительности модели.

R 2 можно интерпретировать как дисперсию модели, на которую влияет сложность модели. Высокий R 2 указывает на меньшую ошибку смещения, поскольку модель может лучше объяснить изменение Y с помощью предикторов. По этой причине мы делаем меньше (ошибочных) предположений, и это приводит к меньшей ошибке смещения. Между тем, чтобы учесть меньше предположений, модель имеет тенденцию быть более сложной. Исходя из компромисса смещения-дисперсии, более высокая сложность приведет к уменьшению смещения и лучшей производительности (ниже оптимальной линии). В R 2 член ( 1 − R 2 ) будет ниже при высокой сложности и приведет к более высокому R 2 , последовательно указывая на лучшую производительность.

С другой стороны, на term/frac обратное влияние оказывает сложность модели. term/frac увеличится при добавлении регрессоров (т.е. увеличится сложность модели) и приведет к ухудшению производительности. Исходя из компромисса смещения-дисперсии, более высокая сложность модели (за пределами оптимальной линии) приводит к увеличению ошибок и ухудшению производительности.

Принимая во внимание расчет R 2 , больше параметров увеличит R 2 и приведет к увеличению R 2 . Тем не менее, добавление большего количества параметров увеличит term/frac и, таким образом, уменьшит R 2 . Эти две тенденции создают обратную u-образную зависимость между сложностью модели и R 2 , что согласуется с u-образной тенденцией сложности модели по сравнению с общей производительностью. В отличие от R 2 , который всегда будет увеличиваться при увеличении сложности модели, R 2 увеличится только тогда, когда смещение, устраненное добавленным регрессором, больше, чем дисперсия, введенная одновременно. Использование R 2 вместо R 2 может таким образом предотвратить переобучение.

Следуя той же логике, скорректированный R 2 можно интерпретировать как менее смещенную оценку совокупности R 2 , тогда как наблюдаемая выборка R 2 является положительно смещенной оценкой значения совокупности. [18] Скорректированный R 2 более уместен при оценке соответствия модели (дисперсия в зависимой переменной, учтенная независимыми переменными) и при сравнении альтернативных моделей на этапе выбора признаков при построении модели. [18]

Принцип, лежащий в основе скорректированной статистики R 2 , можно увидеть, переписав обычную статистику R 2 как

где и являются выборочными дисперсиями оцененных остатков и зависимой переменной соответственно, которые можно рассматривать как смещенные оценки дисперсий популяции ошибок и зависимой переменной. Эти оценки заменяются статистически несмещенными версиями: и .

Несмотря на использование несмещенных оценок для дисперсий популяции ошибки и зависимой переменной, скорректированный R 2 не является несмещенной оценкой популяции R 2 , [18] что получается путем использования дисперсий популяции ошибок и зависимой переменной вместо их оценки. Ингрэм Олкин и Джон В. Пратт вывели несмещенную оценку с минимальной дисперсией для популяции R 2 , [19] которая известна как оценка Олкина–Пратта. Сравнения различных подходов к корректировке R 2 пришли к выводу, что в большинстве ситуаций либо приближенная версия оценки Олкина–Пратта [18] , либо точная оценка Олкина–Пратта [20] должны быть предпочтительнее скорректированного R 2 (Иезекииля) .

Коэффициент частичной детерминации можно определить как долю вариации, которую невозможно объяснить в сокращенной модели, но можно объяснить предикторами, указанными в полной (более полной) модели. [21] [22] [23] Этот коэффициент используется для получения информации о том, могут ли быть полезны один или несколько дополнительных предикторов в более полной регрессионной модели.

Расчет для частичного R 2 относительно прост после оценки двух моделей и создания таблиц ANOVA для них. Расчет для частичного R 2 выглядит следующим образом:

что аналогично обычному коэффициенту детерминации:

Как объяснялось выше, эвристики выбора модели, такие как скорректированный критерий R 2 и F-тест, проверяют, достаточно ли увеличивается общий R 2, чтобы определить, следует ли добавлять в модель новый регрессор. Если в модель добавляется регрессор, который сильно коррелирует с другими регрессорами, которые уже были включены, то общий R 2 вряд ли увеличится, даже если новый регрессор имеет значение. В результате вышеупомянутые эвристики будут игнорировать соответствующие регрессоры, когда кросс-корреляции высоки. [24]

В качестве альтернативы можно разложить обобщенную версию R 2 для количественной оценки релевантности отклонения от гипотезы. [24] Как показывает Хорнвег (2018), несколько оценок сжатия , такие как байесовская линейная регрессия , гребневая регрессия и (адаптивное) лассо , используют это разложение R 2 , когда они постепенно сжимают параметры от неограниченных решений OLS к предполагаемым значениям. Давайте сначала определим модель линейной регрессии как

Предполагается, что матрица X стандартизирована с помощью Z-оценок и что вектор-столбец центрирован так, чтобы иметь среднее значение, равное нулю. Пусть вектор-столбец относится к предполагаемым параметрам регрессии, а вектор-столбец обозначает предполагаемые параметры. Затем мы можем определить

R 2 75% означает , что точность в выборке улучшается на 75%, если вместо предполагаемых значений используются оптимизированные по данным решения b . В особом случае, который является вектором нулей, мы снова получаем традиционный R 2 .

Индивидуальный эффект отклонения от гипотезы на R 2 можно вычислить с помощью ('R-outer'). Эта матрица времен задается как

где . Диагональные элементы точно складывают до R 2 . Если регрессоры не коррелируют и представляет собой вектор нулей, то диагональный элемент просто соответствует значению r 2 между и . Когда регрессоры и коррелируют, может увеличиться за счет уменьшения . В результате диагональные элементы могут быть меньше 0 и, в более исключительных случаях, больше 1. Чтобы справиться с такими неопределенностями, несколько оценщиков сжатия неявно берут средневзвешенное значение диагональных элементов для количественной оценки релевантности отклонения от предполагаемого значения. [24] Щелкните по лассо для примера.

В случае логистической регрессии , обычно подходящей по принципу максимального правдоподобия , существует несколько вариантов псевдо- R2 .

Одним из них является обобщенный R 2, первоначально предложенный Коксом и Снеллом [25] и независимо Маги: [26]

где — вероятность модели только с интерсептом, — вероятность оценочной модели (т. е. модели с заданным набором оценок параметров), а n — размер выборки. Это легко переписать в:

где D — это тестовая статистика теста отношения правдоподобия .

Нико Нагелькерке отметил, что он обладает следующими свойствами: [27] [22]

Однако в случае логистической модели, где не может быть больше 1, R 2 находится в диапазоне от 0 до : таким образом, Нагелькерке предложил возможность определить масштабированный R 2 как R 2 / R 2 max . [22]

Иногда норма остатков используется для указания степени соответствия. Этот термин вычисляется как квадратный корень из суммы квадратов остатков :

И R 2 , и норма остатков имеют свои относительные достоинства. Для анализа наименьших квадратов R 2 изменяется от 0 до 1, причем большие числа указывают на лучшее соответствие, а 1 представляет идеальное соответствие. Норма остатков изменяется от 0 до бесконечности, причем меньшие числа указывают на лучшее соответствие, а ноль указывает на идеальное соответствие. Одним из преимуществ и недостатков R 2 является то, что член действует для нормализации значения. Если все значения y i умножить на константу, норма остатков также изменится на эту константу, но R 2 останется прежним. В качестве простого примера для линейного наименьших квадратов, соответствующих набору данных:

R 2 = 0,998, а норма остатков = 0,302. Если все значения y умножить на 1000 (например, при смене префикса СИ ), то R 2 останется прежним, но норма остатков = 302.

Другим однопараметрическим индикатором соответствия является RMSE остатков или стандартное отклонение остатков. Оно будет иметь значение 0,135 для приведенного выше примера, учитывая, что соответствие было линейным с невынужденным отсеканием. [28]

Создание коэффициента детерминации приписывается генетику Сьюэллу Райту и впервые опубликовано в 1921 году. [29]