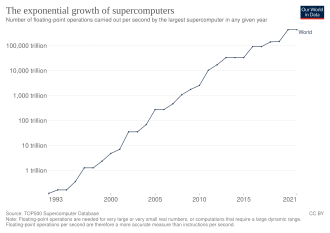

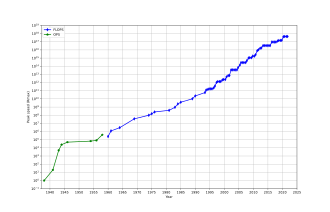

Суперкомпьютер — это тип компьютера с высоким уровнем производительности по сравнению с компьютером общего назначения. Производительность суперкомпьютера обычно измеряется в операциях с плавающей точкой в секунду ( FLOPS ), а не в миллионах инструкций в секунду (MIPS). С 2022 года существуют суперкомпьютеры , которые могут выполнять более 10 18 FLOPS, так называемые суперкомпьютеры exascale . [3] Для сравнения, производительность настольного компьютера находится в диапазоне от сотен гигаФЛОПС (10 11 ) до десятков терафЛОПС (10 13 ). [4] [5] С ноября 2017 года все 500 самых быстрых суперкомпьютеров в мире работают на операционных системах на базе Linux . [6] Дополнительные исследования проводятся в Соединенных Штатах, Европейском союзе, Тайване, Японии и Китае для создания более быстрых, мощных и технологически превосходящих суперкомпьютеров exascale. [7]

Суперкомпьютеры играют важную роль в области вычислительной науки и используются для широкого спектра вычислительно-интенсивных задач в различных областях, включая квантовую механику , прогнозирование погоды , климатические исследования , разведку нефти и газа , молекулярное моделирование (вычисление структур и свойств химических соединений, биологических макромолекул , полимеров и кристаллов) и физическое моделирование (например, моделирование ранних моментов Вселенной, аэродинамики самолетов и космических кораблей , детонации ядерного оружия и ядерного синтеза ). Они были необходимы в области криптоанализа . [8]

Суперкомпьютеры были представлены в 1960-х годах, и в течение нескольких десятилетий самые быстрые из них были созданы Сеймуром Крейем в Control Data Corporation (CDC), Cray Research и последующих компаниях, носящих его имя или монограмму. Первые такие машины представляли собой тщательно настроенные обычные конструкции, которые работали быстрее, чем их более универсальные современники. В течение десятилетия добавлялось все большее количество параллелизма , при этом типичным было от одного до четырех процессоров . В 1970-х годах векторные процессоры, работающие с большими массивами данных, стали доминировать. Ярким примером является весьма успешный Cray-1 1976 года. Векторные компьютеры оставались доминирующей конструкцией вплоть до 1990-х годов. С тех пор и по сей день нормой стали массивно-параллельные суперкомпьютеры с десятками тысяч готовых процессоров. [9] [10]

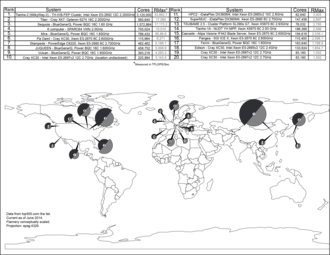

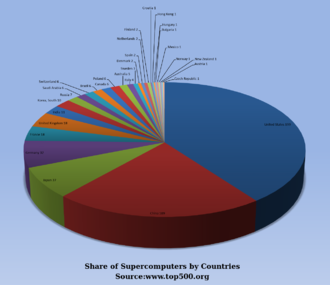

США долгое время были лидером в области суперкомпьютеров, сначала благодаря почти непрерывному доминированию Cray в этой области, а затем благодаря различным технологическим компаниям. Япония добилась больших успехов в этой области в 1980-х и 90-х годах, а Китай становился все более активным в этой области. По состоянию на июнь 2024 года самым быстрым суперкомпьютером в списке суперкомпьютеров TOP500 является Frontier в США с результатом теста LINPACK 1,102 экзафлоп/с, за ним следует Aurora . В США пять из 10 лучших; у Японии, Финляндии, Швейцарии, Италии и Испании по одному. [11] В июне 2018 года все объединенные суперкомпьютеры в списке TOP500 преодолели отметку в 1 экзафлопс . [12]

В 1960 году UNIVAC построил Ливерморский атомный исследовательский компьютер (LARC), который сегодня считается одним из первых суперкомпьютеров, для Научно-исследовательского центра ВМС США. Он по-прежнему использовал высокоскоростную барабанную память , а не недавно появившуюся технологию дисковых накопителей . [13] Также одним из первых суперкомпьютеров был IBM 7030 Stretch . IBM 7030 был построен IBM для Лос-Аламосской национальной лаборатории , которая в 1955 году запросила компьютер в 100 раз быстрее любого существующего компьютера. IBM 7030 использовал транзисторы , память на магнитных сердечниках, конвейерные инструкции, предварительную выборку данных через контроллер памяти и включал в себя новаторские дисковые накопители с произвольным доступом. IBM 7030 был завершен в 1961 году и, несмотря на то, что не справился с задачей стократного увеличения производительности, он был куплен Лос-Аламосской национальной лабораторией. Клиенты в Англии и Франции также купили компьютер, и он стал основой для IBM 7950 Harvest , суперкомпьютера, созданного для криптоанализа . [14]

Третьим пионерским проектом суперкомпьютера в начале 1960-х годов был Atlas в Манчестерском университете , созданный командой под руководством Тома Килбурна . Он спроектировал Atlas так, чтобы иметь память объемом до миллиона слов по 48 бит, но поскольку магнитная память с такой емкостью была недоступна, фактическая основная память Atlas составляла всего 16 000 слов, а барабан обеспечивал память еще для 96 000 слов. Atlas Supervisor обменивался данными в виде страниц между магнитным сердечником и барабаном. Операционная система Atlas также ввела разделение времени в суперкомпьютерах, так что на суперкомпьютере одновременно могло выполняться более одной программы. [15] Atlas был совместным предприятием Ferranti и Манчестерского университета и был разработан для работы со скоростью обработки, приближающейся к одной микросекунде на инструкцию, около миллиона инструкций в секунду. [16]

CDC 6600 , разработанный Сеймуром Крэем , был закончен в 1964 году и ознаменовал переход от германиевых к кремниевым транзисторам. Кремниевые транзисторы могли работать быстрее, а проблема перегрева была решена путем внедрения охлаждения в конструкцию суперкомпьютера. [17] Таким образом, CDC6600 стал самым быстрым компьютером в мире. Учитывая, что 6600 превзошел все другие современные компьютеры примерно в 10 раз, его окрестили суперкомпьютером и определили рынок суперкомпьютеров, когда сто компьютеров были проданы по 8 миллионов долларов каждый. [18] [19] [20] [21]

Крей покинул CDC в 1972 году, чтобы основать собственную компанию Cray Research . [19] Спустя четыре года после ухода из CDC, в 1976 году Крей выпустил 80-мегагерцовый Cray-1 , который стал одним из самых успешных суперкомпьютеров в истории. [22] [23] Cray -2 был выпущен в 1985 году. Он имел восемь центральных процессоров (ЦП), жидкостное охлаждение , а охлаждающая жидкость для электроники Fluorinert прокачивалась через архитектуру суперкомпьютера . Он достиг 1,9 гигафлопс , что сделало его первым суперкомпьютером, преодолевшим барьер гигафлопс. [24]

Единственным компьютером, который серьезно оспаривал производительность Cray-1 в 1970-х годах, был ILLIAC IV . Эта машина была первым реализованным примером настоящего массивно-параллельного компьютера, в котором множество процессоров работали вместе для решения различных частей одной более крупной задачи. В отличие от векторных систем, которые были разработаны для максимально быстрого запуска одного потока данных, в этой концепции компьютер вместо этого подает отдельные части данных на совершенно разные процессоры, а затем рекомбинирует результаты. Проект ILLIAC был завершен в 1966 году с 256 процессорами и предлагал скорость до 1 GFLOPS по сравнению с пиком Cray-1 в 1970-х годах в 250 MFLOPS. Однако проблемы разработки привели к тому, что было построено всего 64 процессора, и система никогда не могла работать быстрее, чем около 200 MFLOPS, будучи намного больше и сложнее, чем Cray. Другая проблема заключалась в том, что написание программного обеспечения для системы было сложным, а достижение ее максимальной производительности требовало серьезных усилий.

Но частичный успех ILLIAC IV широко рассматривался как указание пути к будущему суперкомпьютеров. Крей выступил против этого, остроумно заявив: «Если бы вы пахали поле, что бы вы предпочли использовать? Двух сильных вола или 1024 цыплят?» [25] Но к началу 1980-х годов несколько команд работали над параллельными проектами с тысячами процессоров, в частности, над Connection Machine (CM), разработанной в результате исследований в MIT . CM-1 использовал до 65 536 упрощенных пользовательских микропроцессоров, соединенных вместе в сеть для обмена данными. Затем последовало несколько обновленных версий; суперкомпьютер CM-5 — это компьютер с массивной параллельной обработкой, способный выполнять многие миллиарды арифметических операций в секунду. [26]

В 1982 году система компьютерной графики LINKS-1 Университета Осаки использовала архитектуру массивной параллельной обработки с 514 микропроцессорами , включая 257 управляющих процессоров Zilog Z8001 и 257 процессоров с плавающей точкой iAPX 86/20 . Она в основном использовалась для рендеринга реалистичной трехмерной компьютерной графики . [27] VPP500 от Fujitsu 1992 года необычен, поскольку для достижения более высоких скоростей его процессоры использовали GaAs , материал, обычно используемый для микроволновых приложений из-за его токсичности. [28] Суперкомпьютер Numerical Wind Tunnel от Fujitsu использовал 166 векторных процессоров, чтобы занять первое место в 1994 году с пиковой скоростью 1,7 гигаФЛОПС (GFLOPS) на процессор. [29] [30] Hitachi SR2201 достиг пиковой производительности 600 GFLOPS в 1996 году, используя 2048 процессоров, соединенных через быструю трехмерную перекрестную сеть. [31] [32] [33] Intel Paragon мог иметь от 1000 до 4000 процессоров Intel i860 в различных конфигурациях и был признан самым быстрым в мире в 1993 году. Paragon был машиной MIMD , которая соединяла процессоры через высокоскоростную двумерную сетку, позволяя процессам выполняться на отдельных узлах, взаимодействуя через интерфейс передачи сообщений . [34]

Разработка программного обеспечения оставалась проблемой, но серия CM послужила толчком к значительному исследованию этой проблемы. Аналогичные проекты с использованием специального оборудования были созданы многими компаниями, включая Evans & Sutherland ES-1 , MasPar , nCUBE , Intel iPSC и Goodyear MPP . Но к середине 1990-х годов производительность ЦП общего назначения настолько улучшилась, что можно было построить суперкомпьютер, используя их в качестве отдельных процессорных блоков, вместо использования специальных чипов. К началу 21-го века проекты с десятками тысяч обычных ЦП стали нормой, а более поздние машины добавили к этому миксу графические блоки . [9] [10]

В 1998 году Дэвид Бейдер разработал первый суперкомпьютер Linux , используя стандартные детали. [35] Во время работы в Университете Нью-Мексико Бейдер стремился построить суперкомпьютер, работающий под управлением Linux, используя потребительские готовые детали и высокоскоростную сеть соединений с малой задержкой. Прототип использовал Alta Technologies «AltaCluster» из восьми двухъядерных компьютеров Intel Pentium II с частотой 333 МГц, работающих под управлением модифицированного ядра Linux. Бейдер перенес значительное количество программного обеспечения для обеспечения поддержки Linux для необходимых компонентов, а также код от членов Национального альянса вычислительной науки (NCSA) для обеспечения совместимости, поскольку ни один из них ранее не запускался на Linux. [36] Используя успешный дизайн прототипа, он возглавил разработку «RoadRunner», первого суперкомпьютера Linux для открытого использования национальным научным и инженерным сообществом через Национальную технологическую сеть Национального научного фонда. RoadRunner был запущен в эксплуатацию в апреле 1999 года. На момент его развертывания он считался одним из 100 самых быстрых суперкомпьютеров в мире. [36] [37] Хотя кластеры на базе Linux, использующие компоненты потребительского уровня, такие как Beowulf , существовали до разработки прототипа Бейдера и RoadRunner, им не хватало масштабируемости, пропускной способности и возможностей параллельных вычислений, чтобы считаться «настоящими» суперкомпьютерами. [36]

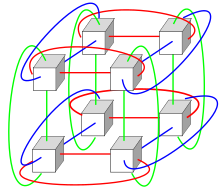

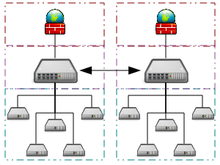

Системы с огромным числом процессоров обычно выбирают один из двух путей. В подходе сетевых вычислений вычислительная мощность многих компьютеров, организованных как распределенные, разнообразные административные домены, используется по мере необходимости всякий раз, когда компьютер доступен. [38] В другом подходе многие процессоры используются в непосредственной близости друг от друга, например, в компьютерном кластере . В такой централизованной массивно-параллельной системе скорость и гибкостьМежсоединения становятся очень важными, и современные суперкомпьютеры используют различные подходы, начиная от усовершенствованныхInfinibandдо трехмерныхторовых межсоединений.[39][40]Использованиемногоядерных процессоровв сочетании с централизацией является новым направлением, например, как вCyclops64.[41][42]

Поскольку цена, производительность и энергоэффективность графических процессоров общего назначения (GPGPU) улучшились, ряд суперкомпьютеров с производительностью петафлопс, таких как Tianhe-I и Nebulae, начали полагаться на них. [43] Однако другие системы, такие как компьютер K, продолжают использовать обычные процессоры, такие как SPARC -ориентированные конструкции, и общая применимость GPGPU в высокопроизводительных вычислительных приложениях общего назначения стала предметом дебатов, поскольку, хотя GPGPU можно настроить на хорошие результаты в определенных тестах, его общая применимость к повседневным алгоритмам может быть ограничена, если не будут приложены значительные усилия для настройки приложения под него. [44] Однако графические процессоры набирают обороты, и в 2012 году суперкомпьютер Jaguar был преобразован в Titan путем модернизации центральных процессоров с графическими процессорами. [45] [46] [47]

Ожидаемый жизненный цикл высокопроизводительных компьютеров составляет около трех лет, прежде чем потребуется модернизация. [48] Суперкомпьютер Gyoukou уникален тем, что он использует как массивно-параллельную конструкцию, так и жидкостное охлаждение .

Было разработано несколько систем специального назначения, предназначенных для одной проблемы. Это позволяет использовать специально запрограммированные чипы FPGA или даже специальные микросхемы ASIC , что позволяет улучшить соотношение цена/производительность, жертвуя универсальностью. Примерами суперкомпьютеров специального назначения являются Belle , [49] Deep Blue , [50] и Hydra [51] для игры в шахматы , Gravity Pipe для астрофизики, [52] MDGRAPE-3 для предсказания структуры белка и молекулярной динамики, [53] и Deep Crack для взлома шифра DES . [54]

.jpg/440px-Summit_(supercomputer).jpg)

На протяжении десятилетий управление плотностью тепла оставалось ключевой проблемой для большинства централизованных суперкомпьютеров. [57] [58] [59] Большое количество тепла, вырабатываемого системой, может также иметь другие эффекты, например, сокращать срок службы других компонентов системы. [60] Существовали различные подходы к управлению теплом, от прокачки Fluorinert через систему до гибридной системы жидкостно-воздушного охлаждения или воздушного охлаждения с нормальными температурами кондиционирования воздуха . [61] [62] Типичный суперкомпьютер потребляет большое количество электроэнергии, почти вся из которой преобразуется в тепло, требующее охлаждения. Например, Tianhe-1A потребляет 4,04 мегаватт (МВт) электроэнергии. [63] Стоимость питания и охлаждения системы может быть значительной, например, 4 МВт по 0,10 долл. США/кВт·ч составляет 400 долл. США в час или около 3,5 млн. долл. США в год.

Управление теплом является серьезной проблемой в сложных электронных устройствах и влияет на мощные компьютерные системы различными способами. [64] Проблемы тепловой мощности проектирования и рассеивания мощности ЦП в суперкомпьютерах превосходят проблемы традиционных технологий охлаждения компьютеров . Награды суперкомпьютерам за экологичные вычисления отражают эту проблему. [65] [66] [67]

Упаковка тысяч процессоров вместе неизбежно генерирует значительные объемы тепловой плотности , с которыми необходимо иметь дело. Cray-2 был жидкостным охлаждением и использовал «охлаждающий водопад» Fluorinert , который подавался через модули под давлением. [61] Однако подход с погружным жидкостным охлаждением был непрактичен для многокорпусных систем, основанных на готовых процессорах, и в System X совместно с компанией Liebert была разработана специальная система охлаждения, которая сочетала кондиционирование воздуха с жидкостным охлаждением . [62]

В системе Blue Gene IBM намеренно использовала маломощные процессоры, чтобы справиться с плотностью тепла. [68] IBM Power 775 , выпущенный в 2011 году, имеет плотно упакованные элементы, требующие водяного охлаждения. [69] Система IBM Aquasar использует водяное охлаждение для достижения энергоэффективности, вода также используется для отопления зданий. [70] [71]

Энергоэффективность компьютерных систем обычно измеряется в терминах « FLOPS на ватт ». В 2008 году Roadrunner от IBM работал на уровне 376 MFLOPS/Вт . [72] [73] В ноябре 2010 года Blue Gene/Q достиг 1684 MFLOPS/Вт [74] [75] , а в июне 2011 года первые два места в списке Green 500 заняли машины Blue Gene в Нью-Йорке (одна из них достигла 2097 MFLOPS/Вт), а кластер DEGIMA в Нагасаки занял третье место с 1375 MFLOPS/Вт. [76]

Поскольку медные провода могут передавать энергию в суперкомпьютер с гораздо более высокой плотностью мощности, чем нагнетаемый воздух или циркулирующие хладагенты могут удалять отработанное тепло , [77] способность систем охлаждения удалять отработанное тепло является ограничивающим фактором. [78] [79] По состоянию на 2015 год [обновлять]многие существующие суперкомпьютеры имеют большую емкость инфраструктуры, чем фактическая пиковая потребность машины — проектировщики обычно консервативно проектируют инфраструктуру питания и охлаждения, чтобы обрабатывать больше, чем теоретическая пиковая электрическая мощность, потребляемая суперкомпьютером. Проекты будущих суперкомпьютеров ограничены по мощности — тепловая расчетная мощность суперкомпьютера в целом, количество, которое может обрабатывать инфраструктура питания и охлаждения, несколько больше ожидаемого нормального потребления мощности, но меньше теоретического пикового потребления мощности электронного оборудования. [80]

С конца 20-го века операционные системы суперкомпьютеров претерпели значительные изменения, основанные на изменениях в архитектуре суперкомпьютеров . [81] В то время как ранние операционные системы были индивидуально адаптированы для каждого суперкомпьютера для увеличения скорости, тенденция заключалась в переходе от внутренних операционных систем к адаптации общего программного обеспечения, такого как Linux . [82]

Поскольку современные суперкомпьютеры с массовым параллелизмом обычно отделяют вычисления от других служб, используя несколько типов узлов , они обычно используют разные операционные системы на разных узлах, например, используя небольшое и эффективное легковесное ядро , такое как CNK или CNL, на вычислительных узлах, но более крупную систему, такую как производная Linux, на серверах и узлах ввода-вывода . [83] [84] [85]

В то время как в традиционной многопользовательской компьютерной системе планирование заданий , по сути, является проблемой постановки задач для обработки и периферийных ресурсов, в системе с массовым параллелизмом система управления заданиями должна управлять распределением как вычислительных, так и коммуникационных ресурсов, а также изящно справляться с неизбежными сбоями оборудования при наличии десятков тысяч процессоров. [86]

Хотя большинство современных суперкомпьютеров используют операционные системы на базе Linux , у каждого производителя есть своя собственная производная от Linux, и не существует отраслевого стандарта, отчасти из-за того, что различия в аппаратной архитектуре требуют изменений для оптимизации операционной системы под каждую аппаратную конструкцию. [81] [87]

Параллельная архитектура суперкомпьютеров часто диктует использование специальных методов программирования для использования их скорости. Программные инструменты для распределенной обработки включают стандартные API, такие как MPI [89] и PVM , VTL , а также программное обеспечение с открытым исходным кодом, такое как Beowulf .

В наиболее распространенном сценарии используются такие среды, как PVM и MPI для слабо связанных кластеров и OpenMP для тесно скоординированных машин с общей памятью. Требуются значительные усилия для оптимизации алгоритма для характеристик межсоединений машины, на которой он будет запущен; цель состоит в том, чтобы не допустить, чтобы какой-либо из ЦП тратил время на ожидание данных от других узлов. GPGPU имеют сотни процессорных ядер и программируются с использованием моделей программирования, таких как CUDA или OpenCL .

Более того, отлаживать и тестировать параллельные программы довольно сложно. Для тестирования и отладки таких приложений необходимо использовать специальные методы .

Оппортунистические супервычисления — это форма сетевых вычислений , в которой «супервиртуальный компьютер» из множества слабосвязанных добровольных вычислительных машин выполняет очень большие вычислительные задачи. Сетевые вычисления были применены к ряду крупномасштабных ошеломляюще параллельных задач, которые требуют масштабов производительности суперкомпьютеров. Однако базовые подходы к сетевым и облачным вычислениям , которые полагаются на добровольные вычисления, не могут справиться с традиционными задачами суперкомпьютеров, такими как моделирование динамики жидкости. [90]

Самая быстрая система сетевых вычислений — проект добровольных вычислений Folding@home (F@h). По состоянию на апрель 2020 года [обновлять]F@h сообщил о 2,5 эксафлопс вычислительной мощности x86 . Из них более 100 PFLOPS вносят клиенты, работающие на различных графических процессорах, а остальное — различные системы ЦП. [91]

Платформа Berkeley Open Infrastructure for Network Computing (BOINC) размещает ряд проектов по добровольному вычислению. По состоянию на февраль 2017 года [обновлять]BOINC зафиксировал вычислительную мощность более 166 петафлопс через более чем 762 тысячи активных компьютеров (хостов) в сети. [92]

По состоянию на октябрь 2016 года [обновлять]распределенный поиск простых чисел Мерсенна Great Internet Mersenne Prime Search (GIMPS) достиг производительности около 0,313 PFLOPS с использованием более 1,3 миллиона компьютеров. [93] Сервер PrimeNet поддерживал подход GIMPS к сетевым вычислениям, один из самых ранних проектов добровольных вычислений, с 1997 года.

Квази-оппортунистические суперкомпьютеры — это форма распределенных вычислений , в которой «супервиртуальный компьютер» множества объединенных в сеть географически распределенных компьютеров выполняет вычислительные задачи, требующие огромной вычислительной мощности. [94] Квази-оппортунистические суперкомпьютеры нацелены на обеспечение более высокого качества обслуживания, чем оппортунистические грид-вычисления, путем достижения большего контроля над назначением задач распределенным ресурсам и использования интеллекта о доступности и надежности отдельных систем в суперкомпьютерной сети. Однако квази-оппортунистическое распределенное выполнение требовательного параллельного вычислительного программного обеспечения в гридах должно быть достигнуто путем внедрения соглашений о распределении по сетке, подсистем совместного распределения, механизмов распределения с учетом топологии связи, отказоустойчивых библиотек передачи сообщений и предварительной подготовки данных. [94]

Облачные вычисления с их недавним и быстрым расширением и развитием привлекли внимание пользователей и разработчиков высокопроизводительных вычислений (HPC) в последние годы. Облачные вычисления пытаются предоставлять HPC-как-услугу точно так же, как и другие формы услуг, доступные в облаке, такие как программное обеспечение как услуга , платформа как услуга и инфраструктура как услуга . Пользователи HPC могут извлечь выгоду из облака с разных сторон, таких как масштабируемость, ресурсы по требованию, быстрота и недорогостоимость. С другой стороны, перемещение приложений HPC также имеет ряд проблем. Хорошими примерами таких проблем являются накладные расходы виртуализации в облаке, многопользовательская аренда ресурсов и проблемы с задержкой сети. В настоящее время проводится много исследований, чтобы преодолеть эти проблемы и сделать HPC в облаке более реалистичной возможностью. [95] [96] [97] [98]

В 2016 году Penguin Computing, Parallel Works, R-HPC, Amazon Web Services , Univa , Silicon Graphics International , Rescale , Sabalcore и Gomput начали предлагать облачные вычисления HPC . Облако Penguin On Demand (POD) представляет собой вычислительную модель bare-metal для выполнения кода, но каждому пользователю предоставляется виртуализированный узел входа. Вычислительные узлы POD подключаются через невиртуализированные сети Ethernet 10 Гбит/с или QDR InfiniBand . Скорость подключения пользователей к центру обработки данных POD составляет от 50 Мбит/с до 1 Гбит/с. [99] Ссылаясь на EC2 Elastic Compute Cloud от Amazon, Penguin Computing утверждает, что виртуализация вычислительных узлов не подходит для HPC. Penguin Computing также критиковал то, что облака HPC могли выделять вычислительные узлы клиентам, которые находятся далеко друг от друга, что приводило к задержкам, которые ухудшали производительность некоторых приложений HPC. [100]

Суперкомпьютеры обычно стремятся к максимуму в вычислительных возможностях, а не к вычислительным мощностям. Вычисления возможностей обычно рассматриваются как использование максимальной вычислительной мощности для решения одной большой проблемы за кратчайшее время. Часто система возможностей способна решить проблему такого размера или сложности, которую не может решить ни один другой компьютер, например, очень сложное приложение для моделирования погоды . [101]

Напротив, вычисление мощности обычно рассматривается как использование эффективной и экономически эффективной вычислительной мощности для решения нескольких довольно крупных задач или множества мелких задач. [101] Архитектуры, которые позволяют поддерживать множество пользователей для выполнения рутинных повседневных задач, могут иметь большую мощность, но обычно не считаются суперкомпьютерами, учитывая, что они не решают ни одной очень сложной задачи. [101]

В целом, скорость суперкомпьютеров измеряется и тестируется в FLOPS (операции с плавающей точкой в секунду), а не в терминах MIPS (миллионы инструкций в секунду), как в случае с компьютерами общего назначения. [102] Эти измерения обычно используются с префиксом СИ , таким как тера- , объединенным в сокращенное обозначение TFLOPS (10 12 FLOPS, произносится как терафлопс ), или пета- , объединенным в сокращенное обозначение PFLOPS (10 15 FLOPS, произносится как петафлопс ). Суперкомпьютеры Petascale могут обрабатывать один квадриллион (10 15 ) (1000 триллионов) FLOPS. Exascale — это вычислительная производительность в диапазоне exaFLOPS (EFLOPS). EFLOPS составляет один квинтиллион (10 18 ) FLOPS (один миллион TFLOPS). Однако производительность суперкомпьютера может серьезно зависеть от колебаний, вызванных такими факторами, как нагрузка на систему, сетевой трафик и параллельные процессы, как упоминают Брем и Брувилер (2015). [103]

Ни одно число не может отразить общую производительность компьютерной системы, однако цель теста Linpack — приблизительно оценить, насколько быстро компьютер решает численные задачи, и он широко используется в отрасли. [104] Измерение FLOPS либо указывается на основе теоретической производительности процессора с плавающей точкой (выведенной из спецификаций процессора производителя и показанной как «Rpeak» в списках TOP500), которая, как правило, недостижима при выполнении реальных рабочих нагрузок, либо на достижимой пропускной способности, выведенной из тестов LINPACK и показанной как «Rmax» в списке TOP500. [105] Тест LINPACK обычно выполняет LU-разложение большой матрицы. [106] Производительность LINPACK дает некоторое представление о производительности для некоторых реальных задач, но не обязательно соответствует требованиям обработки многих других рабочих нагрузок суперкомпьютера, которые, например, могут потребовать большей пропускной способности памяти или могут потребовать лучшей производительности целочисленных вычислений, или могут потребовать высокопроизводительной системы ввода-вывода для достижения высокого уровня производительности. [104]

С 1993 года самые быстрые суперкомпьютеры ранжируются в списке TOP500 согласно результатам бенчмарка LINPACK . Список не претендует на беспристрастность или окончательность, но это широко цитируемое текущее определение «самого быстрого» суперкомпьютера, доступного в любой момент времени.

Это список компьютеров, которые появлялись на вершине списка TOP500 с июня 1993 года, [107] и "Пиковая скорость" указана как рейтинг "Rmax". В 2018 году Lenovo стала крупнейшим в мире поставщиком суперкомпьютеров TOP500, выпустив 117 единиц. [108]

Этапы применения суперкомпьютера можно суммировать в следующей таблице:

Компьютер IBM Blue Gene /P использовался для моделирования ряда искусственных нейронов, эквивалентных приблизительно одному проценту коры головного мозга человека, содержащей 1,6 миллиарда нейронов с приблизительно 9 триллионами связей. Та же исследовательская группа также преуспела в использовании суперкомпьютера для моделирования ряда искусственных нейронов, эквивалентных всему мозгу крысы. [120]

Современное прогнозирование погоды также опирается на суперкомпьютеры. Национальное управление океанических и атмосферных исследований использует суперкомпьютеры для обработки сотен миллионов наблюдений, чтобы сделать прогнозы погоды более точными. [121]

В 2011 году проблемы и трудности в развитии суперкомпьютеров были подчеркнуты отказом IBM от петафлопсного проекта Blue Waters . [122]

В настоящее время Программа усовершенствованного моделирования и вычислений использует суперкомпьютеры для поддержания и моделирования ядерного арсенала США. [123]

В начале 2020 года COVID-19 был в центре внимания в мире. Суперкомпьютеры использовали различные симуляции для поиска соединений, которые могли бы потенциально остановить распространение. Эти компьютеры работают десятки часов, используя несколько параллельно работающих ЦП для моделирования различных процессов. [124] [125] [126]

В 2010-х годах Китай, США, Европейский союз и другие страны соревновались за право первыми создать суперкомпьютер производительностью 1 экзаФЛОПС ( 1018 или один квинтиллион ФЛОПС). [127] Эрик П. ДеБенедиктис из Sandia National Laboratories предположил, что для полного моделирования погоды , которое могло бы точно охватить двухнедельный промежуток времени, требуется компьютер производительностью зеттаФЛОПС ( 1021 или один секстиллион ФЛОПС). [128] [129] [130] Такие системы могут быть построены около 2030 года. [131]

Многие модели Монте-Карло используют один и тот же алгоритм для обработки случайно сгенерированного набора данных; в частности, интегро-дифференциальные уравнения, описывающие физические процессы переноса , случайные пути , столкновения, а также передачу энергии и импульса нейтронам, фотонам, ионам, электронам и т. д.Следующим шагом для микропроцессоров может стать переход в третье измерение ; и, специализируясь на методе Монте-Карло, многие слои могут быть идентичны, что упростит процесс проектирования и производства. [132]

Стоимость эксплуатации высокопроизводительных суперкомпьютеров выросла, в основном из-за увеличения энергопотребления. В середине 1990-х годов топ-10 суперкомпьютеров требовали около 100 киловатт, в 2010 году топ-10 суперкомпьютеров требовали от 1 до 2 мегаватт. [133] Исследование 2010 года, заказанное DARPA, определило энергопотребление как наиболее распространенную проблему в достижении Exascale вычислений . [134] В то время мегаватт в год потребления энергии стоил около 1 миллиона долларов. Суперкомпьютерные мощности были построены для эффективного удаления растущего количества тепла, вырабатываемого современными многоядерными центральными процессорами . Основываясь на энергопотреблении списка суперкомпьютеров Green 500 в период с 2007 по 2011 год, суперкомпьютер с 1 эксафлопс в 2011 году потребовал бы почти 500 мегаватт. Операционные системы были разработаны для существующего оборудования, чтобы экономить энергию, когда это возможно. [135] Ядра ЦП, не используемые во время выполнения параллельного приложения, были переведены в состояния с низким энергопотреблением, что обеспечивало экономию энергии для некоторых суперкомпьютерных приложений. [136]

Растущая стоимость эксплуатации суперкомпьютеров стала движущим фактором в тенденции к объединению ресурсов через распределенную суперкомпьютерную инфраструктуру. Национальные суперкомпьютерные центры впервые появились в США, затем в Германии и Японии. Европейский союз запустил Партнерство по передовым вычислениям в Европе (PRACE) с целью создания постоянной общеевропейской суперкомпьютерной инфраструктуры с услугами по поддержке ученых по всему Европейскому союзу в портировании, масштабировании и оптимизации суперкомпьютерных приложений. [133] Исландия построила первый в мире суперкомпьютер с нулевым уровнем выбросов. Расположенный в Центре обработки данных Thor в Рейкьявике , Исландия, этот суперкомпьютер использует полностью возобновляемые источники энергии, а не ископаемое топливо. Более холодный климат также снижает потребность в активном охлаждении, что делает его одним из самых экологичных объектов в мире компьютеров. [137]

Финансирование суперкомпьютерного оборудования также становилось все более сложным. В середине 1990-х годов топ-10 суперкомпьютеров стоил около 10 миллионов евро, в то время как в 2010 году топ-10 суперкомпьютеров требовали инвестиций в размере от 40 до 50 миллионов евро. [133] В 2000-х годах национальные правительства внедрили различные стратегии финансирования суперкомпьютеров. В Великобритании национальное правительство полностью финансировало суперкомпьютеры, а высокопроизводительные вычисления были переданы под контроль национального агентства по финансированию. Германия разработала смешанную модель финансирования, объединяющую местное государственное финансирование и федеральное финансирование. [133]

Примерами суперкомпьютеров в художественной литературе являются HAL 9000 , Multivac , The Machine Stops , GLaDOS , The Evitable Conflict , Vulcan's Hammer , Colossus , WOPR , AM и Deep Thought . Суперкомпьютер от Thinking Machines упоминался как суперкомпьютер, использовавшийся для секвенирования ДНК, извлеченной из законсервированных паразитов в серии «Парк Юрского периода» .

выполнение 376 миллионов вычислений на каждый ватт потребляемой электроэнергии.

Система IBM... BlueGene/Q... установила рекорд энергоэффективности со значением 1680 МФЛОПС/Вт, что более чем в два раза превышает показатели следующей лучшей системы.

{{cite web}}: CS1 maint: постскриптум ( ссылка )