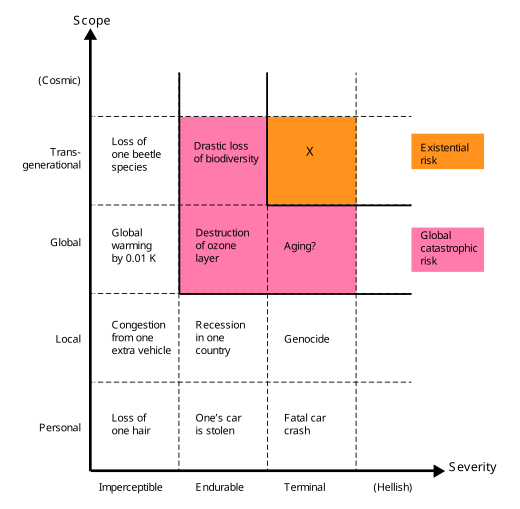

Риск глобальной катастрофы или сценарий конца света — это гипотетическое событие, которое может нанести ущерб человеческому благополучию в глобальном масштабе, [2] даже поставить под угрозу или разрушить современную цивилизацию . [3] Событие, которое может привести к вымиранию человечества или навсегда и радикально ограничить существование или потенциал человечества, известно как « экзистенциальный риск ». [4]

В 21 веке был создан ряд академических и некоммерческих организаций для исследования глобальных катастрофических и экзистенциальных рисков, разработки потенциальных мер по смягчению последствий и либо пропаганды, либо реализации этих мер. [5] [6] [7] [8]

Термин «глобальный катастрофический риск» «не имеет четкого определения» и обычно (в широком смысле) относится к риску, который может нанести «серьезный ущерб благополучию человека в глобальном масштабе». [10]

Человечество уже переживало крупные катастрофы. Некоторые из них нанесли серьезный ущерб, но были локальными по масштабу — например, Черная смерть могла привести к гибели трети населения Европы [11] , 10% населения мира в то время. [12] Некоторые были глобальными, но не такими серьезными — например, пандемия гриппа 1918 года убила, по оценкам, 3–6% населения мира. [13] Большинство глобальных катастрофических рисков не будут настолько интенсивными, чтобы убить большую часть жизни на Земле, но даже если бы это произошло, экосистема и человечество в конечном итоге восстановились бы (в отличие от экзистенциальных рисков ).

Аналогично, в книге «Катастрофа: риск и ответ » Ричард Познер выделяет и группирует события, которые приводят к «полному ниспровержению или разрушению» в глобальном, а не «локальном или региональном» масштабе. Познер выделяет такие события как заслуживающие особого внимания по соображениям затрат и выгод , поскольку они могут прямо или косвенно поставить под угрозу выживание человеческой расы в целом. [14]

Экзистенциальные риски определяются как «риски, которые угрожают разрушением долгосрочного потенциала человечества». [15] Реализация экзистенциального риска (экзистенциальной катастрофы [16] ) либо приведет к прямому вымиранию человечества, либо необратимо зафиксирует радикально худшее положение дел. [9] [17] Экзистенциальные риски являются подклассом глобальных катастрофических рисков, где ущерб не только глобальный, но и смертельный и постоянный, препятствуя восстановлению и тем самым влияя как на нынешнее, так и на все будущие поколения. [9]

Хотя вымирание является наиболее очевидным способом, которым долгосрочный потенциал человечества может быть уничтожен, есть и другие, включая необратимый крах и необратимую дистопию . [18] Катастрофа, достаточно серьезная, чтобы вызвать постоянный, необратимый крах человеческой цивилизации, будет представлять собой экзистенциальную катастрофу, даже если она не достигла уровня вымирания. [18] Аналогично, если бы человечество попало под тоталитарный режим, и не было бы никаких шансов на восстановление, то такая дистопия также была бы экзистенциальной катастрофой. [19] Брайан Каплан пишет, что «возможно, вечность тоталитаризма была бы хуже вымирания». [19] ( Роман Джорджа Оруэлла «1984» предлагает [20] пример. [21] ) Антиутопический сценарий разделяет ключевые черты вымирания и необратимого краха цивилизации: до катастрофы человечество сталкивалось с огромным диапазоном светлых будущих на выбор; после катастрофы человечество навсегда заперто в ужасном состоянии. [18]

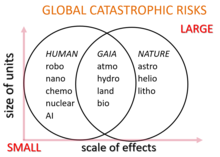

Потенциальные глобальные катастрофические риски традиционно классифицируются как антропогенные или неантропогенные опасности. Примерами неантропогенных рисков являются столкновение астероида или кометы , извержение супервулкана , природная пандемия , смертельный гамма-всплеск , геомагнитная буря от выброса корональной массы , разрушающего электронное оборудование, естественное долгосрочное изменение климата , враждебная внеземная жизнь или превращение Солнца в красную гигантскую звезду и поглощение Земли через миллиарды лет в будущем . [22]

Антропогенные риски — это риски, вызванные людьми, и они включают риски, связанные с технологиями, управлением и изменением климата. Технологические риски включают создание искусственного интеллекта, не соответствующего целям человека, биотехнологии и нанотехнологии . Недостаточное или вредоносное глобальное управление создает риски в социальной и политической сфере, такие как глобальная война и ядерный холокост , [23] биологическая война и биотерроризм с использованием генетически модифицированных организмов , кибервойна и кибертерроризм, разрушающие критически важную инфраструктуру , такую как электросеть , или радиологическая война с использованием оружия, такого как большие кобальтовые бомбы . Другие глобальные катастрофические риски включают изменение климата, ухудшение состояния окружающей среды , вымирание видов , голод в результате несправедливого распределения ресурсов, перенаселение или недонаселение людей , неурожаи и неустойчивое сельское хозяйство .

Исследования природы и смягчения глобальных катастрофических рисков и экзистенциальных рисков сопряжены с уникальным набором проблем и, как следствие, нелегко поддаются обычным стандартам научной строгости. [18] Например, нецелесообразно и неэтично изучать эти риски экспериментально. Карл Саган выразил это в отношении ядерной войны: «Понимание долгосрочных последствий ядерной войны не является проблемой, поддающейся экспериментальной проверке». [24] Более того, многие катастрофические риски быстро меняются по мере развития технологий и изменения фоновых условий, таких как геополитические условия. Еще одной проблемой является общая сложность точного прогнозирования будущего в длительных временных масштабах, особенно для антропогенных рисков, которые зависят от сложных человеческих политических, экономических и социальных систем. [18] В дополнение к известным и ощутимым рискам могут произойти непредвиденные события вымирания черного лебедя , что представляет собой дополнительную методологическую проблему. [18] [25]

Человечество никогда не переживало экзистенциальных катастроф, и если бы таковая произошла, она обязательно была бы беспрецедентной. [18] Таким образом, экзистенциальные риски представляют собой уникальные проблемы для прогнозирования, даже больше, чем другие долгосрочные события, из-за эффектов отбора наблюдения . [26] В отличие от большинства событий, отсутствие события полного вымирания в прошлом не является доказательством против его вероятности в будущем, потому что каждый мир, который пережил такое событие вымирания, не имеет наблюдателей, поэтому независимо от их частоты, ни одна цивилизация не наблюдает экзистенциальных рисков в своей истории. [26] Этих антропных проблем можно частично избежать, рассматривая доказательства, которые не имеют таких эффектов отбора, такие как кратеры от ударов астероидов на Луне, или напрямую оценивая вероятное воздействие новых технологий. [9]

Чтобы понять динамику беспрецедентного, необратимого глобального цивилизационного коллапса (тип экзистенциального риска), может быть поучительно изучить различные локальные цивилизационные коллапсы , которые происходили на протяжении человеческой истории. [27] Например, такие цивилизации, как Римская империя, закончились потерей централизованного управления и крупной общецивилизационной потерей инфраструктуры и передовых технологий. Однако эти примеры показывают, что общества, по-видимому, довольно устойчивы к катастрофам; например, средневековая Европа пережила Черную смерть , не испытав ничего, напоминающего цивилизационный коллапс, несмотря на потерю от 25 до 50 процентов своего населения. [28]

Существуют экономические причины, которые могут объяснить, почему так мало усилий направляется на снижение экзистенциального риска. Это глобальное общественное благо , поэтому мы должны ожидать, что рынки будут его недопоставлять. [9] Даже если крупная страна инвестирует в меры по снижению риска, эта страна получит лишь малую часть выгоды от этого. Более того, снижение экзистенциального риска является межпоколенческим глобальным общественным благом, поскольку большинство выгод от снижения экзистенциального риска будут получены будущими поколениями, и хотя эти будущие люди теоретически, возможно, были бы готовы заплатить значительные суммы за снижение экзистенциального риска, механизма для такой транзакции не существует. [9]

Многочисленные когнитивные предубеждения могут влиять на суждение людей о важности экзистенциальных рисков, включая нечувствительность к масштабу , гиперболическое дисконтирование , эвристику доступности , ошибку конъюнкции , эвристику аффекта и эффект чрезмерной уверенности . [29]

Нечувствительность к масштабу влияет на то, насколько плохим люди считают вымирание человеческой расы. Например, когда люди мотивированы жертвовать деньги на альтруистические цели, сумма, которую они готовы дать, не увеличивается линейно с масштабом проблемы: люди примерно так же готовы предотвратить гибель 200 000 или 2000 птиц. [30] Аналогично, люди часто больше обеспокоены угрозами для отдельных лиц, чем для более крупных групп. [29]

Элиезер Юдковски выдвигает теорию о том, что пренебрежение масштабом играет роль в общественном восприятии экзистенциальных рисков: [31] [32]

Значительно большие цифры, такие как 500 миллионов смертей, и особенно качественно иные сценарии, такие как вымирание всего человеческого вида, по-видимому, вызывают иной образ мышления... Люди, которые никогда не подумали бы причинить вред ребенку, слышат о риске для существования и говорят: «Ну, может быть, человеческий вид на самом деле не заслуживает того, чтобы выживать».

Все прошлые предсказания вымирания человечества оказались ложными. Для некоторых это делает будущие предупреждения менее достоверными. Ник Бостром утверждает, что отсутствие вымирания человечества в прошлом является слабым доказательством того, что в будущем не будет вымирания человечества из-за ошибки выжившего и других антропных эффектов . [33]

Социобиолог Э. О. Уилсон утверждал, что: «Причина этого близорукого тумана, утверждают эволюционные биологи, заключается в том, что он был на самом деле выгоден в течение всего, кроме последних нескольких тысячелетий из двух миллионов лет существования рода Homo ... Особое внимание уделялось пристальному вниманию к ближайшему будущему и раннему воспроизводству, и мало чему другому. Катастрофы такого масштаба, которые случаются лишь раз в несколько столетий, были забыты или превращены в миф». [34]

Глубокая защита — это полезная структура для классификации мер по снижению риска по трем уровням защиты: [35]

Вымирание человечества наиболее вероятно, когда все три защиты слабы, то есть «из-за рисков, которые мы вряд ли сможем предотвратить, на которые вряд ли сможем успешно отреагировать и которым вряд ли сможем противостоять». [35]

Беспрецедентный характер экзистенциальных рисков представляет особую проблему при разработке мер по снижению рисков, поскольку человечество не сможет извлечь уроки из опыта предыдущих событий. [18]

Некоторые исследователи утверждают, что как исследования, так и другие инициативы, связанные с экзистенциальным риском, недофинансируются. Ник Бостром утверждает, что больше исследований было проведено по «Звездному пути» , сноуборду или навозным жукам , чем по экзистенциальным рискам. Сравнения Бострома были раскритикованы как «высокомерные». [36] [37] По состоянию на 2020 год годовой бюджет организации «Конвенция о биологическом оружии» составлял 1,4 миллиона долларов США. [38]

Некоторые ученые предлагают создать на Земле одно или несколько самодостаточных, удаленных, постоянно заселенных поселений, специально созданных для выживания в случае глобальной катастрофы. [39] [40] [41] Экономист Робин Хэнсон утверждает, что убежище, в котором постоянно будут проживать всего лишь 100 человек, значительно повысит шансы человечества на выживание во время ряда глобальных катастроф. [39] [42]

Хранение продуктов питания предлагалось во всем мире, но денежная стоимость была бы высокой. Кроме того, это, вероятно, способствовало бы нынешним миллионам смертей в год из-за недоедания . [43] В 2022 году группа под руководством Дэвида Денкенбергера смоделировала экономическую эффективность устойчивых продуктов питания для безопасности искусственного общего интеллекта (AGI) и обнаружила «~98-99% уверенности» для более высокого предельного воздействия работы на устойчивые продукты питания. [44] Некоторые выживальщики снабжают убежища для выживания многолетними запасами продовольствия.

Глобальное хранилище семян на Шпицбергене зарыто на глубине 400 футов (120 м) внутри горы на острове в Арктике . Оно предназначено для хранения 2,5 млрд семян из более чем 100 стран в качестве меры предосторожности для сохранения урожая со всего мира. Окружающая порода имеет температуру −6 °C (21 °F) (по состоянию на 2015 год), но хранилище поддерживается на уровне −18 °C (0 °F) с помощью холодильников, работающих на местном угле. [45] [46]

Более спекулятивно, если общество продолжит функционировать и если биосфера останется пригодной для жизни, потребности в калориях для нынешней популяции людей теоретически могут быть удовлетворены во время длительного отсутствия солнечного света, при условии достаточного предварительного планирования. Предполагаемые решения включают выращивание грибов на мертвой растительной биомассе, оставшейся после катастрофы, преобразование целлюлозы в сахар или кормление природным газом бактерий, переваривающих метан. [47] [48]

Недостаточное глобальное управление создает риски в социальной и политической сфере, но механизмы управления развиваются медленнее, чем технологические и социальные изменения. Правительства, частный сектор, а также широкая общественность обеспокоены отсутствием механизмов управления для эффективного управления рисками, ведения переговоров и разрешения споров между различными и конфликтующими интересами. Это еще больше подчеркивается пониманием взаимосвязанности глобальных системных рисков. [49] В отсутствие или в ожидании глобального управления национальные правительства могут действовать индивидуально, чтобы лучше понимать, смягчать и готовиться к глобальным катастрофам. [50]

В 2018 году Римский клуб призвал к более активным действиям по борьбе с изменением климата и опубликовал свой План действий по борьбе с изменением климата, в котором предлагается десять пунктов действий по ограничению повышения глобальной средней температуры до 1,5 градусов по Цельсию. [51] Кроме того, в 2019 году Клуб опубликовал более полный План действий по борьбе с изменением климата. [52]

Есть данные, позволяющие предположить, что коллективное взаимодействие с эмоциональными переживаниями, возникающими во время размышлений об уязвимости человеческого вида в контексте изменения климата, позволяет этим переживаниям быть адаптивными. Когда коллективное взаимодействие с эмоциональными переживаниями и их обработка оказывают поддержку, это может привести к росту устойчивости, психологической гибкости, толерантности к эмоциональным переживаниям и вовлеченности в сообщество. [53]

Колонизация космоса является предлагаемой альтернативой для повышения шансов на выживание в случае вымирания. [54] Решения такого масштаба могут потребовать мегамасштабной инженерии .

Астрофизик Стивен Хокинг выступал за колонизацию других планет Солнечной системы, как только технологии достигнут достаточного уровня развития, чтобы повысить шансы человечества на выживание в условиях событий планетарного масштаба, таких как глобальная термоядерная война. [55] [56]

Миллиардер Илон Маск пишет, что человечество должно стать многопланетным видом, чтобы избежать вымирания. [57] Маск использует свою компанию SpaceX для разработки технологий, которые, как он надеется, будут использованы при колонизации Марса .

Психолог Стивен Пинкер назвал экзистенциальный риск «бесполезной категорией», которая может отвлечь от реальных угроз, таких как изменение климата и ядерная война. [36]

Bulletin of the Atomic Scientists (основан в 1945 г.) — одна из старейших международных организаций по оценке рисков, основанная после того, как общественность встревожилась потенциалом атомной войны после Второй мировой войны. Она изучает риски, связанные с ядерной войной и энергетикой, и, как известно, поддерживает Часы Судного дня , установленные в 1947 г. Foresight Institute (основан в 1986 г.) изучает риски нанотехнологий и их преимущества. Это была одна из первых организаций, изучавших непреднамеренные последствия безвредных технологий, вышедших из строя в глобальном масштабе. Она была основана К. Эриком Дрекслером, который постулировал « серую слизь ». [58] [59]

Начиная с 2000 года все большее число ученых, философов и миллиардеров, работающих в сфере технологий, создавали организации, занимающиеся изучением глобальных рисков как внутри, так и за пределами академической среды. [60]

Независимые неправительственные организации (НПО) включают Институт исследований машинного интеллекта (основан в 2000 г.), который стремится снизить риск катастрофы, вызванной искусственным интеллектом, [61] с донорами, включая Питера Тиля и Джеда Маккалеба . [62] Инициатива по ядерной угрозе (основана в 2001 г.) стремится снизить глобальные угрозы от ядерных, биологических и химических угроз, а также ограничить ущерб после события. [8] Он ведет индекс безопасности ядерных материалов. [63] Фонд Lifeboat (основан в 2009 г.) финансирует исследования по предотвращению техногенных катастроф. [64] Большая часть исследовательских денег идет на финансирование проектов в университетах. [65] Институт глобального катастрофического риска (основан в 2011 г.) — некоммерческий, беспартийный аналитический центр, базирующийся в США, основанный Сетом Баумом и Тони Барреттом. GCRI проводит исследования и разрабатывает политику в отношении различных рисков, включая искусственный интеллект, ядерную войну, изменение климата и удары астероидов. [66] Фонд Global Challenges Foundation (основан в 2012 году), базирующийся в Стокгольме и основанный Ласло Сомбатфальви , выпускает ежегодный отчет о состоянии глобальных рисков. [67] [68] Институт Future of Life (основан в 2014 году) работает над снижением экстремальных, крупномасштабных рисков от преобразующих технологий, а также над управлением разработкой и использованием этих технологий на благо всей жизни посредством предоставления грантов, пропаганды политики в Соединенных Штатах, Европейском союзе и Организации Объединенных Наций, а также образовательной деятельности. [7] Илон Маск , Виталик Бутерин и Яан Таллинн являются одними из его крупнейших доноров. [69] Центр по долгосрочному риску (основан в 2016 году), ранее известный как Институт фундаментальных исследований, является британской организацией, сосредоточенной на снижении рисков астрономических страданий ( s-рисков ) от новых технологий. [70]

Университетские организации включали Future of Humanity Institute (основан в 2005 году), который исследовал вопросы долгосрочного будущего человечества, в частности экзистенциальный риск. [5] Он был основан Ником Бостромом и базировался в Оксфордском университете. [5] Центр изучения экзистенциального риска (основан в 2012 году) — это организация Кембриджского университета, которая изучает четыре основных технологических риска: искусственный интеллект, биотехнологии, глобальное потепление и война. [6] Все они являются рисками, созданными человеком, как объяснил Хью Прайс информационному агентству AFP: «Кажется разумным прогнозом, что когда-нибудь в этом или следующем столетии интеллект выйдет из-под ограничений биологии». Он добавил, что когда это произойдет, «мы больше не будем самыми умными существами вокруг» и рискуем оказаться во власти «машин, которые не являются злонамеренными, но машин, интересы которых не включают нас». [71] Стивен Хокинг был исполняющим обязанности советника. Альянс тысячелетия за человечество и биосферу — это организация, базирующаяся в Стэнфордском университете, которая фокусируется на многих вопросах, связанных с глобальной катастрофой, объединяя членов академических кругов в области гуманитарных наук. [72] [73] Она была основана Полом Эрлихом и другими. [74] В Стэнфордском университете также есть Центр международной безопасности и сотрудничества , который фокусируется на политическом сотрудничестве для снижения риска глобальных катастроф. [75] Центр безопасности и новых технологий был создан в январе 2019 года в Школе дипломатической службы Уолша в Джорджтауне и будет фокусироваться на политических исследованиях новых технологий с первоначальным акцентом на искусственный интеллект. [76] Они получили грант в размере 55 млн долларов США от Good Ventures , как и было предложено Open Philanthropy . [76]

Другие группы оценки риска базируются в правительственных организациях или являются их частью. Всемирная организация здравоохранения (ВОЗ) включает в себя подразделение под названием Глобальное оповещение и ответ (GAR), которое отслеживает и реагирует на глобальный эпидемический кризис. [77] GAR помогает государствам-членам в обучении и координации реагирования на эпидемии. [78] Агентство США по международному развитию (USAID) имеет свою Программу по новым угрозам пандемий, которая направлена на предотвращение и сдерживание естественно возникающих пандемий у их источника. [79] В Национальной лаборатории Лоуренса Ливермора есть подразделение под названием Главное управление глобальной безопасности, которое исследует от имени правительства такие вопросы, как биологическая безопасность и борьба с терроризмом. [80]

Это эквивалентное, хотя и более четкое, определение Ника Бострома : «Экзистенциальный риск — это риск, который угрожает преждевременным вымиранием разумной жизни, возникшей на Земле, или постоянным и радикальным уничтожением ее потенциала для желаемого будущего развития». Источник: Бостром, Ник (2013). «Предотвращение экзистенциального риска как глобальный приоритет». Глобальная политика. 4:15-31.

Уинстона, Джордж Оруэлл, верил, что свобода в конечном итоге победит искажающий правду тоталитаризм, изображенный в «1984».

Европа выжила, потеряв от 25 до 50 процентов своего населения во время Черной смерти, но при этом сохранив цивилизацию нетронутой.

Международный орган, ответственный за постоянный запрет биологического оружия (Конвенция о биологическом оружии), имеет годовой бюджет в размере 1,4 миллиона долларов — меньше, чем средний ресторан McDonald's.

Институт исследований машинного интеллекта стремится снизить риск катастрофы, если такое событие в конечном итоге произойдет.

настоящее время мы сосредоточены на усилиях по снижению наихудших рисков астрономических страданий (s-рисков) от новых технологий, уделяя особое внимание преобразующему искусственному интеллекту.

Независимо от того, ищете ли вы лекарство от рака, занимаетесь ли научной или художественной карьерой или занимаетесь созданием более справедливых институтов, угроза будущему человечества — это также угроза значимости того, что вы делаете.