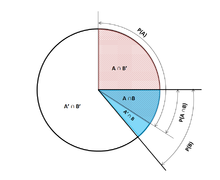

В теории вероятностей условная вероятность является мерой вероятности наступления события при условии, что другое событие (по предположению, презумпции, утверждению или доказательству) уже известно, что произошло. [1] Этот конкретный метод основан на событии A, происходящем с некоторой связью с другим событием B. В этой ситуации событие A может быть проанализировано с помощью условной вероятности относительно B. Если интересующее событие - A , и известно или предполагается, что событие B произошло, "условная вероятность A при условии B " или "вероятность A при условии B " обычно записывается как P( A | B ) [2] или иногда P B ( A ) . Это также можно понимать как долю вероятности B, которая пересекается с A, или отношение вероятностей того, что оба события произойдут, к тому, что произойдет "заданное" событие (сколько раз A произойдет, а не при условии, что B не произошло): . [3]

Например, вероятность того, что у любого человека будет кашель в любой день, может быть всего 5%. Но если мы знаем или предполагаем, что человек болен, то вероятность того, что он будет кашлять, гораздо выше. Например, условная вероятность того, что кто-то нездоровый (больной) кашляет, может быть 75%, и в этом случае мы получим, что P(кашель) = 5% и P(кашель|болен) = 75%. Хотя в этом примере есть связь между A и B , такая связь или зависимость между A и B не является необходимой, и они не должны возникать одновременно.

P( A | B ) может быть равен или не равен P( A ) , т. е. безусловной вероятности или абсолютной вероятности A . Если P( A | B ) = P( A ) , то события A и B называются независимыми : в таком случае знание о любом из событий не изменяет вероятность друг друга. P( A | B ) (условная вероятность A при наличии B ) обычно отличается от P( B | A ) . Например, если у человека лихорадка денге , у него может быть 90% шанс получить положительный результат теста на заболевание. В этом случае измеряется то, что если произошло событие B ( наличие лихорадки денге ), вероятность A ( положительный результат теста ) при условии, что произошло B , составляет 90%, просто записывая P( A | B ) = 90%. В качестве альтернативы, если у человека положительный результат теста на лихорадку денге, у него может быть только 15% шанс на самом деле иметь это редкое заболевание из-за высоких показателей ложноположительных результатов . В этом случае вероятность события B ( заболевание лихорадкой денге ) при условии, что произошло событие A ( положительный результат теста ), составляет 15% или P( B | A ) = 15%. Теперь должно быть очевидно, что ложное уравнивание двух вероятностей может привести к различным ошибкам в рассуждениях, что обычно наблюдается через ошибки базовой ставки .

Хотя условные вероятности могут предоставить чрезвычайно полезную информацию, ограниченная информация часто предоставляется или находится под рукой. Поэтому может быть полезно обратить или преобразовать условную вероятность с помощью теоремы Байеса : . [4] Другой вариант — отобразить условные вероятности в таблице условных вероятностей , чтобы пролить свет на связь между событиями.

Если даны два события A и B из сигма-поля вероятностного пространства, причем безусловная вероятность B больше нуля (т. е. P( B ) > 0) , условная вероятность A при заданном B ( ) — это вероятность наступления A, если B произошло или предполагается, что произошло. [5] Предполагается, что A — это множество всех возможных результатов эксперимента или случайного испытания с ограниченным или сокращенным пространством выборки. Условная вероятность может быть найдена с помощью частного вероятности совместного пересечения событий A и B , то есть вероятности, с которой A и B происходят вместе, и вероятности B : [2] [ 6] [7]

Для выборочного пространства, состоящего из равновероятных исходов, вероятность события A понимается как доля числа исходов в A к числу всех исходов в выборочном пространстве. Тогда это уравнение понимается как доля множества к множеству B . Обратите внимание, что приведенное выше уравнение является определением, а не просто теоретическим результатом. Мы обозначаем величину как и называем ее «условной вероятностью A при заданном B ».

Некоторые авторы, такие как де Финетти , предпочитают вводить условную вероятность как аксиому вероятности :

Это уравнение для условной вероятности, хотя и математически эквивалентно, может быть интуитивно понятнее. Его можно интерпретировать как «вероятность возникновения B , умноженная на вероятность возникновения A , при условии, что B произошло, равна вероятности возникновения A и B вместе, хотя и не обязательно в одно и то же время». Кроме того, это может быть предпочтительнее с философской точки зрения; в основных интерпретациях вероятности , таких как субъективная теория , условная вероятность считается примитивной сущностью. Более того, это «правило умножения» может быть практически полезным при вычислении вероятности и вводит симметрию с аксиомой суммирования для формулы Пуанкаре:

Условную вероятность можно определить как вероятность условного события . Условное событие Гудмана–Нгуена–Ван Фраассена можно определить как:

Можно показать, что

что соответствует определению условной вероятности Колмогорова. [9]

Если , то согласно определению, не определено .

Наибольший интерес представляет случай случайной величины Y , обусловленной непрерывной случайной величиной X, приводящей к определенному результату x . Событие имеет нулевую вероятность и, как таковое, не может быть обусловлено.

Вместо того, чтобы обуславливать, что X точно x , мы могли бы обуславливать, что он находится ближе, чем расстояние от x . Событие, как правило, будет иметь ненулевую вероятность и, следовательно, может быть обуславлено. Затем мы можем взять предел

Например, если две непрерывные случайные величины X и Y имеют совместную плотность , то по правилу Лопиталя и интегральному правилу Лейбница , при дифференцировании по :

Полученный предел представляет собой условное распределение вероятностей Y при заданном X и существует , когда знаменатель, плотность вероятности , строго положителен.

Возникает соблазн определить неопределенную вероятность с помощью предела ( 1 ), но это невозможно сделать последовательно. В частности, можно найти случайные величины X и W и значения x , w такие, что события и будут идентичны, но результирующие пределы не будут:

Парадокс Бореля –Колмогорова демонстрирует это с помощью геометрического аргумента.

Пусть X — дискретная случайная величина, а ее возможные результаты обозначены V. Например, если X представляет собой значение брошенной кости, то V — это множество . Предположим для наглядности, что X — дискретная случайная величина, так что каждое значение в V имеет ненулевую вероятность.

Для значения x в V и события A условная вероятность определяется как . Запись

короче говоря, мы видим, что это функция двух переменных , x и A.

Для фиксированного A мы можем сформировать случайную величину . Она представляет собой результат всякий раз, когда наблюдается значение x из X.

Условную вероятность A при заданном X можно , таким образом , рассматривать как случайную величину Y с результатами в интервале . Из закона полной вероятности ее ожидаемое значение равно безусловной вероятности A.

Частичная условная вероятность - это вероятность события, при условии, что каждое из событий условия произошло в степени (степени веры, степени опыта), которая может отличаться от 100%. Часто частичная условная вероятность имеет смысл, если условия проверяются в повторениях эксперимента соответствующей длины . [10] Такая ограниченная частичная условная вероятность может быть определена как условно ожидаемое среднее возникновение события в испытательных стендах длины , которые соответствуют всем вероятностным спецификациям , то есть:

Исходя из этого, частичную условную вероятность можно определить как

где [10]

Условие Джеффри [11] [12] представляет собой особый случай частичной условной вероятности, в котором условные события должны образовывать раздел :

Предположим, что кто-то тайно бросает две честные шестигранные игральные кости , и мы хотим вычислить вероятность того, что выпавшее на лицевой стороне первой кости значение равно 2, учитывая информацию о том, что их сумма не превышает 5.

Вероятность того, что D 1 = 2

В таблице 1 показано выборочное пространство из 36 комбинаций значений, выпавших на двух игральных костях, каждая из которых выпадает с вероятностью 1/36, при этом числа, отображаемые в красных и темно-серых ячейках, равны D 1 + D 2 .

D 1 = 2 ровно в 6 из 36 результатов; таким образом, P ( D 1 = 2) = 6 ⁄ 36 = 1 ⁄ 6 :

Вероятность того, что D 1 + D 2 ≤ 5

Таблица 2 показывает, что D 1 + D 2 ≤ 5 ровно для 10 из 36 результатов, таким образом, P ( D 1 + D 2 ≤ 5) = 10 ⁄ 36 :

Вероятность того, что D 1 = 2, учитывая, что D 1 + D 2 ≤ 5

Таблица 3 показывает, что для 3 из этих 10 результатов D 1 = 2.

Таким образом, условная вероятность P( D 1 = 2 | D 1 + D 2 ≤ 5) = 3 ⁄ 10 = 0,3:

Здесь, в более ранней записи определения условной вероятности, обусловливающее событие B состоит в том, что D 1 + D 2 ≤ 5, а событие A — в том, что D 1 = 2. Мы имеем то, что видно из таблицы.

В статистическом выводе условная вероятность представляет собой обновление вероятности события на основе новой информации. [13] Новая информация может быть включена следующим образом: [1]

Этот подход приводит к вероятностной мере, которая согласуется с исходной вероятностной мерой и удовлетворяет всем аксиомам Колмогорова . Эта условная вероятностная мера также могла бы быть получена, если предположить, что относительная величина вероятности A по отношению к X будет сохранена по отношению к B (ср. формальный вывод ниже).

Формулировка «доказательство» или «информация» обычно используется в байесовской интерпретации вероятности . Обусловливающее событие интерпретируется как доказательство для обусловленного события. То есть, P ( A ) — это вероятность A до учета доказательства E , а P ( A | E ) — это вероятность A после учета доказательства E или после обновления P ( A ). Это согласуется с частотной интерпретацией, которая является первым определением, данным выше.

При передаче кода Морзе существует определенная вероятность того, что полученная «точка» или «тире» ошибочна. Это часто воспринимается как помеха при передаче сообщения. Поэтому при отправке, например, «точки» важно учитывать вероятность того, что была получена «точка». Это представлено следующим образом: В коде Морзе соотношение точек и тире составляет 3:4 в точке отправки, поэтому вероятность «точки» и «тире» составляет . Если предположить, что вероятность того, что точка будет передана как тире, составляет 1/10, и что вероятность того, что тире будет передано как точка, также составляет 1/10, то можно использовать правило Байеса для вычисления .

Теперь можно посчитать:

[14]

События A и B определяются как статистически независимые , если вероятность пересечения A и B равна произведению вероятностей A и B:

Если P ( B ) не равно нулю, то это эквивалентно утверждению, что

Аналогично, если P ( A ) не равно нулю, то

также эквивалентно. Хотя полученные формы могут показаться более интуитивными, они не являются предпочтительным определением, поскольку условные вероятности могут быть неопределенными, а предпочтительное определение симметрично относительно A и B. Независимость не относится к несовместному событию. [15]

Следует также отметить, что при наличии пары независимых событий [AB] и события C пара определяется как условно независимая, если справедливо произведение: [16]

Эта теорема может быть полезна в приложениях, где наблюдается несколько независимых событий.

Независимые события против взаимоисключающих событий

Концепции взаимонезависимых событий и взаимоисключающих событий являются отдельными и различимыми. Следующая таблица сопоставляет результаты для двух случаев (при условии, что вероятность обуславливающего события не равна нулю).

На самом деле взаимоисключающие события не могут быть статистически независимыми (если только оба они не невозможны), поскольку знание того, что одно произойдет, дает информацию о другом (в частности, что последнее наверняка не произойдет).

В общем случае нельзя предполагать, что P ( A | B ) ≈ P ( B | A ). Это может быть коварной ошибкой, даже для тех, кто хорошо разбирается в статистике. [17] Связь между P ( A | B ) и P ( B | A ) определяется теоремой Байеса :

То есть P( A | B ) ≈ P( B | A ) только если P ( B )/ P ( A ) ≈ 1, или, что эквивалентно, P ( A ) ≈ P ( B ).

В общем случае нельзя предположить, что P ( A ) ≈ P ( A | B ). Эти вероятности связаны законом полной вероятности :

где события образуют счетное разбиение .

Эта ошибка может возникнуть из-за смещения отбора . [18] Например, в контексте медицинского заявления пусть S C будет событием, когда последствие (хроническое заболевание) S возникает как следствие обстоятельства (острое состояние) C . Пусть H будет событием, когда человек обращается за медицинской помощью. Предположим, что в большинстве случаев C не вызывает S (так что P ( S C ) является низким). Предположим также, что медицинская помощь требуется только в том случае, если S произошло из-за C . Поэтому на основе опыта пациентов врач может ошибочно заключить, что P ( S C ) является высоким. Фактическая вероятность, наблюдаемая врачом, равна P ( S C | H ).

Непринятие во внимание априорной вероятности частично или полностью называется игнорированием базовой ставки . Обратное, недостаточное изменение априорной вероятности называется консерватизмом .

Формально P ( A | B ) определяется как вероятность A в соответствии с новой функцией вероятности на пространстве выборки, такой, что результаты, не входящие в B, имеют вероятность 0 и что это согласуется со всеми исходными мерами вероятности . [19] [20]

Пусть Ω будет дискретным пространством выборки с элементарными событиями { ω }, и пусть P будет вероятностной мерой относительно σ-алгебры Ω. Предположим, что нам сообщили, что произошло событие B ⊆ Ω. Новое распределение вероятностей (обозначаемое условной записью) должно быть назначено на { ω }, чтобы отразить это. Все события, которые не находятся в B , будут иметь нулевую вероятность в новом распределении. Для событий в B должны быть выполнены два условия: вероятность B равна единице, и относительные величины вероятностей должны быть сохранены. Первое требуется аксиомами вероятности , а второе вытекает из того факта, что новая вероятностная мера должна быть аналогом P , в котором вероятность B равна единице - и каждое событие, которое не находится в B , следовательно, имеет нулевую вероятность. Следовательно, для некоторого масштабного коэффициента α новое распределение должно удовлетворять:

Подставим 1 и 2 в 3, чтобы выбрать α :

Итак, новое распределение вероятностей равно

Теперь для общего события A ,