В статистике метод наименьших квадратов ( МНК ) — это тип линейного метода наименьших квадратов для выбора неизвестных параметров в модели линейной регрессии (с фиксированными эффектами первого уровня [ требуется разъяснение ] линейной функции набора объясняющих переменных ) по принципу наименьших квадратов : минимизация суммы квадратов разностей между наблюдаемой зависимой переменной (значениями наблюдаемой переменной) во входном наборе данных и выходом (линейной) функции независимой переменной . Некоторые источники считают МНК линейной регрессией. [1]

Геометрически это выглядит как сумма квадратов расстояний, параллельных оси зависимой переменной, между каждой точкой данных в наборе и соответствующей точкой на поверхности регрессии — чем меньше различия, тем лучше модель соответствует данным. Полученная оценка может быть выражена простой формулой, особенно в случае простой линейной регрессии , в которой есть один регрессор в правой части уравнения регрессии.

Оценка OLS является последовательной для фиксированных эффектов уровня один, когда регрессоры являются экзогенными , и образует идеальную коллинеарность (условие ранга), последовательной для оценки дисперсии остатков, когда регрессоры имеют конечные четвертые моменты [2] , и — по теореме Гаусса–Маркова — оптимальной в классе линейных несмещенных оценок , когда ошибки гомоскедастичны и последовательно некоррелированы . При этих условиях метод OLS обеспечивает оценку среднего несмещенного с минимальной дисперсией , когда ошибки имеют конечные дисперсии . При дополнительном предположении, что ошибки распределены нормально с нулевым средним , OLS является оценкой максимального правдоподобия , которая превосходит любую нелинейную несмещенную оценку.

Предположим, что данные состоят из наблюдений . Каждое наблюдение включает скалярный отклик и вектор-столбец параметров (регрессоров), т.е. . В линейной регрессионной модели переменная отклика, , является линейной функцией регрессоров:

или в векторной форме,

где , как было введено ранее, является вектором-столбцом -го наблюдения всех объясняющих переменных; является вектором неизвестных параметров; и скаляр представляет ненаблюдаемые случайные величины ( ошибки ) -го наблюдения. учитывает влияние на отклики источников, отличных от объясняющих переменных . Эту модель также можно записать в матричной записи как

где и — векторы переменных отклика и ошибок наблюдений , а — матрица регрессоров, также иногда называемая матрицей дизайна , строка которой содержит -е наблюдения по всем объясняющим переменным.

Обычно постоянный член включается в набор регрессоров , скажем, путем взятия для всех . Коэффициент, соответствующий этому регрессору, называется отсекателем . Без отсекателя подобранная линия вынуждена пересекать начало координат, когда .

Регрессоры не обязательно должны быть независимыми, чтобы оценка была последовательной, например, они могут быть нелинейно зависимыми. За исключением идеальной мультиколлинеарности, оценки параметров могут быть последовательными; однако, по мере увеличения мультиколлинеарности стандартная ошибка вокруг таких оценок увеличивается и снижает точность таких оценок. Когда есть идеальная мультиколлинеарность, больше невозможно получить уникальные оценки для коэффициентов для связанных регрессоров; оценка для этих параметров не может сходиться (таким образом, она не может быть последовательной).

В качестве конкретного примера, где регрессоры нелинейно зависимы, но оценка все еще может быть последовательной, мы могли бы предположить, что ответ линейно зависит как от значения, так и от его квадрата; в этом случае мы бы включили один регрессор, значение которого является просто квадратом другого регрессора. В этом случае модель была бы квадратичной во втором регрессоре, но тем не менее все еще считалась бы линейной моделью, поскольку модель все еще линейна по параметрам ( ).

Рассмотрим переопределенную систему

линейных уравнений с неизвестными коэффициентами , , с . Это можно записать в матричной форме как

где

(Примечание: для линейной модели, как указано выше, не все элементы в содержат информацию о точках данных. Первый столбец заполнен единицами, . Только другие столбцы содержат фактические данные. Поэтому здесь равно числу регрессоров плюс один).

Такая система обычно не имеет точного решения, поэтому цель состоит в том, чтобы найти коэффициенты , которые соответствуют уравнениям «лучше всего», в смысле решения задачи квадратичной минимизации.

где целевая функция задается выражением

Обоснование выбора этого критерия приведено в разделе Свойства ниже. Эта задача минимизации имеет единственное решение при условии, что столбцы матрицы линейно независимы , что определяется решением так называемых нормальных уравнений :

Матрица известна как нормальная матрица или матрица Грама , а матрица известна как матрица моментов регресса регрессорами. [3] Наконец, — это вектор коэффициентов гиперплоскости наименьших квадратов , выраженный как

или

Предположим, что b является "кандидатным" значением для вектора параметров β . Величина y i − x i T b , называемая остатком для i -го наблюдения, измеряет вертикальное расстояние между точкой данных ( x i , y i ) и гиперплоскостью y = x T b , и таким образом оценивает степень соответствия между фактическими данными и моделью. Сумма квадратов остатков ( SSR ) (также называемая суммой квадратов ошибок ( ESS ) или суммой квадратов остатков ( RSS )) [4] является мерой общего соответствия модели:

где T обозначает транспонированную матрицу , а строки X , обозначающие значения всех независимых переменных, связанных с определенным значением зависимой переменной, равны X i = x i T . Значение b , которое минимизирует эту сумму, называется оценкой МНК для β . Функция S ( b ) является квадратичной по b с положительно определенным гессианом , и, следовательно, эта функция обладает единственным глобальным минимумом при , который может быть задан явной формулой: [5] [доказательство]

Произведение N = X T X является матрицей Грама , а ее обратная матрица, Q = N –1 , является матрицей кофакторов β , [6] [7] [ 8], тесно связанной с ее ковариационной матрицей, C β . Матрица ( X T X ) –1 X T = Q X T называется псевдообратной матрицей Мура–Пенроуза для X. Эта формулировка подчеркивает тот факт, что оценка может быть выполнена тогда и только тогда, когда нет идеальной мультиколлинеарности между объясняющими переменными (что привело бы к тому, что матрица Грама не имела бы обратной матрицы).

После того, как мы оценили β , подобранные значения (или предсказанные значения ) из регрессии будут

где P = X ( X T X ) −1 X T — матрица проекции на пространство V , охватываемое столбцами X . Эту матрицу P также иногда называют матрицей шляпы , потому что она «надевает шляпу» на переменную y . Другая матрица, тесно связанная с P — это матрица аннигилятора M = I n − P ; это матрица проекции на пространство, ортогональное V . Обе матрицы P и M симметричны и идемпотентны (это означает, что P 2 = P и M 2 = M ) , и связаны с матрицей данных X через тождества PX = X и MX = 0 . [9] Матрица M создает остатки от регрессии:

Используя эти остатки, мы можем оценить значение σ2 , используя приведенную статистику хи-квадрат :

Знаменатель, n − p , является статистическими степенями свободы . Первая величина, s 2 , является оценкой OLS для σ 2 , тогда как вторая, , является оценкой MLE для σ 2 . Эти две оценки довольно похожи в больших выборках; первая оценка всегда несмещена , в то время как вторая оценка смещена , но имеет меньшую среднеквадратичную ошибку . На практике s 2 используется чаще, так как она более удобна для проверки гипотез. Квадратный корень из s 2 называется стандартной ошибкой регрессии , [10] стандартной ошибкой регрессии , [11] [12] или стандартной ошибкой уравнения . [9]

Обычно оценивают степень соответствия регрессии OLS, сравнивая, насколько начальная вариация в выборке может быть уменьшена путем регрессии на X. Коэффициент детерминации R 2 определяется как отношение «объясненной» дисперсии к «общей» дисперсии зависимой переменной y в случаях, когда сумма квадратов регрессии равна сумме квадратов остатков: [13]

где TSS — это общая сумма квадратов для зависимой переменной, , и — матрица n × n единиц. ( — центрирующая матрица , которая эквивалентна регрессии на константу; она просто вычитает среднее значение из переменной.) Для того чтобы R 2 была осмысленной, матрица X данных о регрессорах должна содержать вектор-столбец из единиц для представления константы, коэффициент которой является свободным членом регрессии. В этом случае R 2 всегда будет числом от 0 до 1, причем значения, близкие к 1, указывают на хорошую степень соответствия.

Дисперсия в прогнозе независимой переменной как функция зависимой переменной приведена в статье Полиномиальные наименьшие квадраты .

Если матрица данных X содержит только две переменные, константу и скалярный регрессор x i , то это называется "простой регрессионной моделью". Этот случай часто рассматривается на занятиях по статистике для начинающих, так как он обеспечивает гораздо более простые формулы, даже подходящие для ручного расчета. Параметры обычно обозначаются как ( α , β ) :

Оценки наименьших квадратов в этом случае даются простыми формулами

В предыдущем разделе оценка наименьших квадратов была получена как значение, которое минимизирует сумму квадратов остатков модели. Однако также возможно вывести ту же оценку из других подходов. Во всех случаях формула для оценки МНК остается той же: ^ β = ( X T X ) −1 X T y ; единственное отличие заключается в том, как мы интерпретируем этот результат.

Для математиков МНК — это приближенное решение переопределенной системы линейных уравнений Xβ ≈ y , где β — неизвестное. Предполагая, что система не может быть решена точно (количество уравнений n намного больше количества неизвестных p ), мы ищем решение, которое могло бы обеспечить наименьшее расхождение между правой и левой частями. Другими словами, мы ищем решение, которое удовлетворяет

где ‖ · ‖ — стандартная норма L 2 в n -мерном евклидовом пространстве R n . Предсказанная величина Xβ — это просто некоторая линейная комбинация векторов регрессоров. Таким образом, остаточный вектор y − Xβ будет иметь наименьшую длину, когда y ортогонально проецируется на линейное подпространство , охватываемое столбцами X . Оценку МНК в этом случае можно интерпретировать как коэффициенты векторного разложения ^ y = Py по базису X .

Другими словами, уравнения градиента в минимуме можно записать как:

Геометрическая интерпретация этих уравнений заключается в том, что вектор остатков ортогонален пространству столбцов X , поскольку скалярное произведение равно нулю для любого конформного вектора v . Это означает, что является самым коротким из всех возможных векторов , то есть дисперсия остатков является минимально возможной. Это проиллюстрировано справа.

Вводя матрицу K с предположением, что матрица невырожденная и K T X = 0 (ср. Ортогональные проекции ), остаточный вектор должен удовлетворять следующему уравнению:

Уравнение и решение линейного метода наименьших квадратов, таким образом, описываются следующим образом:

Другой способ взглянуть на это — считать линию регрессии средневзвешенным значением линий, проходящих через комбинацию любых двух точек в наборе данных. [14] Хотя этот способ расчета более затратен в вычислительном отношении, он обеспечивает лучшее интуитивное представление об OLS.

Оценка МНК идентична оценке максимального правдоподобия (MLE) при предположении нормальности для членов ошибки. [15] [доказательство] Это предположение о нормальности имеет историческое значение, поскольку оно послужило основой для ранних работ по линейному регрессионному анализу Юла и Пирсона . [ необходима ссылка ] Из свойств MLE можно сделать вывод, что оценка МНК асимптотически эффективна (в смысле достижения границы Крамера–Рао для дисперсии), если предположение о нормальности выполняется. [16]

В этом случае оценку OLS можно также рассматривать как оценку GMM , возникающую из моментных условий

Эти условия моментов утверждают, что регрессоры должны быть некоррелированы с ошибками. Поскольку x i является p -вектором, количество условий моментов равно размерности вектора параметров β , и, таким образом, система точно идентифицируется. Это так называемый классический случай GMM, когда оценка не зависит от выбора весовой матрицы.

Обратите внимание, что исходное строгое предположение экзогенности E[ ε i | x i ] = 0 подразумевает гораздо более богатый набор моментных условий, чем указано выше. В частности, это предположение подразумевает, что для любой векторной функции ƒ будет выполняться моментное условие E[ ƒ ( x i )· ε i ] = 0. Однако с помощью теоремы Гаусса–Маркова можно показать , что оптимальным выбором функции ƒ является взятие ƒ ( x ) = x , что приводит к уравнению моментов, приведенному выше.

Существует несколько различных фреймворков, в которых может быть использована модель линейной регрессии для того, чтобы сделать метод OLS применимым. Каждая из этих настроек дает одни и те же формулы и одни и те же результаты. Единственное отличие заключается в интерпретации и предположениях, которые должны быть введены для того, чтобы метод давал значимые результаты. Выбор применимого фреймворка в основном зависит от характера имеющихся данных и от задачи вывода, которую необходимо выполнить.

Одной из линий различия в интерпретации является то, следует ли рассматривать регрессоры как случайные величины или как предопределенные константы. В первом случае ( случайный дизайн ) регрессоры x i случайны и выбираются вместе с y i из некоторой популяции , как в наблюдательном исследовании . Этот подход позволяет более естественно изучать асимптотические свойства оценщиков. В другой интерпретации ( фиксированный дизайн ) регрессоры X рассматриваются как известные константы, установленные планом , а y выбирается условно на основе значений X , как в эксперименте . Для практических целей это различие часто неважно, поскольку оценка и вывод выполняются при обусловлении X. Все результаты, изложенные в этой статье, находятся в рамках случайного дизайна.

Классическая модель фокусируется на оценке и выводе "конечной выборки", что означает, что число наблюдений n фиксировано. Это контрастирует с другими подходами, которые изучают асимптотическое поведение OLS, и в которых изучается поведение при большом числе выборок.

В некоторых приложениях, особенно с данными поперечного сечения , накладывается дополнительное предположение — что все наблюдения независимы и одинаково распределены . Это означает, что все наблюдения берутся из случайной выборки , что упрощает и облегчает интерпретацию всех перечисленных ранее предположений. Также эта структура позволяет устанавливать асимптотические результаты (поскольку размер выборки n → ∞ ), которые понимаются как теоретическая возможность извлечения новых независимых наблюдений из процесса генерации данных . Список предположений в этом случае таков:

Прежде всего, при строгом предположении экзогенности оценки OLS и s 2 являются несмещенными , что означает, что их ожидаемые значения совпадают с истинными значениями параметров: [23] [доказательство]

Если строгая экзогенность не выполняется (как в случае со многими моделями временных рядов , где экзогенность предполагается только по отношению к прошлым шокам, но не к будущим), то эти оценки будут смещены в конечных выборках.

Дисперсионно -ковариационная матрица (или просто ковариационная матрица ) равна [24]

В частности, стандартная ошибка каждого коэффициента равна квадратному корню из j -го диагонального элемента этой матрицы. Оценка этой стандартной ошибки получается путем замены неизвестной величины σ 2 на ее оценку s 2 . Таким образом,

Также можно легко показать, что оценка не коррелирует с остатками модели: [24]

Теорема Гаусса –Маркова утверждает, что при предположении сферических ошибок (то есть, ошибки должны быть некоррелированными и гомоскедастичными ) оценщик эффективен в классе линейных несмещенных оценщиков. Это называется наилучшим линейным несмещенным оценщиком (BLUE). Эффективность следует понимать так, как если бы мы нашли какой-то другой оценщик , который был бы линейным по y и несмещенным, тогда [24]

в том смысле, что это неотрицательно-определенная матрица . Эта теорема устанавливает оптимальность только в классе линейных несмещенных оценок, что является довольно ограничительным. В зависимости от распределения членов ошибки ε другие, нелинейные оценки могут давать лучшие результаты, чем OLS.

Все перечисленные до сих пор свойства действительны независимо от базового распределения членов ошибки. Однако, если вы готовы предположить, что предположение о нормальности выполняется (то есть, что ε ~ N (0, σ 2 I n ) ), то можно указать дополнительные свойства оценщиков МНК.

Оценка имеет нормальное распределение со средним значением и дисперсией, как указано ранее: [25]

Эта оценка достигает границы Крамера–Рао для модели и, таким образом, является оптимальной в классе всех несмещенных оценок. [16] Обратите внимание, что в отличие от теоремы Гаусса–Маркова , этот результат устанавливает оптимальность как среди линейных, так и среди нелинейных оценок, но только в случае нормально распределенных ошибок.

Оценка s 2 будет пропорциональна распределению хи-квадрат : [26]

Дисперсия этой оценки равна 2 σ 4 /( n − p ) , что не достигает границы Крамера–Рао 2 σ 4 / n . Однако было показано, что не существует несмещенных оценок σ 2 с дисперсией, меньшей, чем у оценки s 2 . [27] Если мы готовы допустить смещенные оценки и рассмотреть класс оценок, которые пропорциональны сумме квадратов остатков (SSR) модели, то наилучшей (в смысле среднеквадратической ошибки ) оценкой в этом классе будет ~ σ 2 = SSR / ( n − p + 2) , что даже превосходит границу Крамера–Рао в случае, когда есть только один регрессор ( p = 1 ). [28]

Более того, оценки и s2 независимы [ 29], что полезно при построении t- и F-тестов для регрессии.

Как упоминалось ранее, оценщик линеен по y , что означает, что он представляет собой линейную комбинацию зависимых переменных y i . Веса в этой линейной комбинации являются функциями регрессоров X и, как правило, неравны. Наблюдения с высокими весами называются влиятельными, поскольку они оказывают более выраженное влияние на значение оценщика.

Чтобы проанализировать, какие наблюдения являются влиятельными, мы удаляем конкретное j -е наблюдение и рассматриваем, насколько изменятся оцененные величины (аналогично методу складного ножа ). Можно показать, что изменение в оценке OLS для β будет равно [30]

где h j = x j T ( X T X ) −1 x j — j -й диагональный элемент матрицы P , а x j — вектор регрессоров, соответствующий j -му наблюдению. Аналогично, изменение прогнозируемого значения для j -го наблюдения в результате исключения этого наблюдения из набора данных будет равно [30]

Из свойств матрицы шляпы следует, что 0 ≤ h j ≤ 1 , и они в сумме дают p , так что в среднем h j ≈ p/n . Эти величины h j называются рычагами , а наблюдения с высоким h j называются точками рычага . [31] Обычно наблюдения с высоким рычагом следует проверять более тщательно, на случай, если они ошибочны, или являются выбросами, или каким-либо другим образом нетипичны для остального набора данных.

Иногда переменные и соответствующие им параметры в регрессии можно логически разделить на две группы, так что регрессия принимает вид

где X 1 и X 2 имеют размерности n × p 1 , n × p 2 , а β 1 , β 2 являются векторами p 1 ×1 и p 2 ×1, причем p 1 + p 2 = p .

Теорема Фриша –Во–Ловелла утверждает , что в этой регрессии остатки и оценка МНК будут численно идентичны остаткам и оценке МНК для β2 в следующей регрессии: [32]

где M 1 — матрица аннигилятора для регрессоров X 1 .

Теорему можно использовать для установления ряда теоретических результатов. Например, наличие регрессии с константой и другим регрессором эквивалентно вычитанию средних значений из зависимой переменной и регрессора, а затем запуску регрессии для вычтенных переменных, но без постоянного члена.

Предположим, что известно, что коэффициенты регрессии удовлетворяют системе линейных уравнений

где Q — матрица p × q полного ранга, а c — вектор известных констант размером q × 1, где q < p . В этом случае оценка наименьших квадратов эквивалентна минимизации суммы квадратов остатков модели, подчиняющейся ограничению A . Оценка наименьших квадратов с ограничениями (CLS) может быть задана явной формулой: [33]

Это выражение для ограниченной оценки справедливо до тех пор, пока матрица X T X обратима. С самого начала статьи предполагалось, что эта матрица имеет полный ранг, и было отмечено, что когда условие ранга не выполняется, β не будет идентифицируемой. Однако может случиться так, что добавление ограничения A сделает β идентифицируемой, и в этом случае хотелось бы найти формулу для оценки. Оценка равна [34]

где R — матрица p × ( p − q ) такая, что матрица [ QR ] невырожденная, и R T Q = 0 . Такую матрицу всегда можно найти, хотя, как правило, она не единственная. Вторая формула совпадает с первой в случае, когда X T X обратима. [34]

Оценки наименьших квадратов являются точечными оценками параметров линейной регрессионной модели β . Однако, как правило, мы также хотим знать, насколько близки эти оценки к истинным значениям параметров. Другими словами, мы хотим построить интервальные оценки .

Поскольку мы не сделали никаких предположений о распределении погрешности ε i , невозможно вывести распределение оценок и . Тем не менее, мы можем применить центральную предельную теорему для вывода их асимптотических свойств, когда размер выборки n стремится к бесконечности. Хотя размер выборки обязательно конечен, принято предполагать, что n «достаточно велико», чтобы истинное распределение оценки МНК было близко к ее асимптотическому пределу.

Мы можем показать, что при предположениях модели оценка наименьших квадратов для β является последовательной (то есть сходится по вероятности к β ) и асимптотически нормальной: [доказательство]

где

Используя это асимптотическое распределение, можно построить приблизительные двусторонние доверительные интервалы для j -го компонента вектора как

где q обозначает функцию квантиля стандартного нормального распределения, а [·] jj — j -й диагональный элемент матрицы.

Аналогично, оценка наименьших квадратов для σ 2 также является последовательной и асимптотически нормальной (при условии, что существует четвертый момент ε i ) с предельным распределением

Эти асимптотические распределения могут использоваться для прогнозирования, проверки гипотез, построения других оценок и т. д. В качестве примера рассмотрим задачу прогнозирования. Предположим, что есть некоторая точка в области распределения регрессоров, и кто-то хочет узнать, какой была бы переменная отклика в этой точке. Средний отклик — это величина , тогда как предсказанный отклик — это . Очевидно, что предсказанный отклик — это случайная величина, его распределение можно вывести из распределения :

что позволяет построить доверительные интервалы для построения среднего отклика:

Особенно широко используются два теста гипотез. Во-первых, нужно узнать, лучше ли оцененное уравнение регрессии, чем простое предсказание того, что все значения переменной отклика равны ее выборочному среднему (если нет, говорят, что оно не имеет объяснительной силы). Нулевая гипотеза об отсутствии объяснительной силы оцененной регрессии проверяется с помощью F-теста . Если вычисленное F-значение оказывается достаточно большим, чтобы превысить свое критическое значение для заранее выбранного уровня значимости, нулевая гипотеза отвергается, а альтернативная гипотеза о том, что регрессия имеет объяснительную силу, принимается. В противном случае принимается нулевая гипотеза об отсутствии объяснительной силы.

Во-вторых, для каждой интересующей объясняющей переменной нужно узнать, отличается ли ее оценочный коэффициент от нуля, то есть имеет ли эта конкретная объясняющая переменная на самом деле объяснительную силу в предсказании ответной переменной. Здесь нулевая гипотеза заключается в том, что истинный коэффициент равен нулю. Эта гипотеза проверяется путем вычисления t-статистики коэффициента как отношения оценки коэффициента к его стандартной ошибке . Если t-статистика больше заранее определенного значения, нулевая гипотеза отвергается, и обнаруживается, что переменная имеет объяснительную силу, причем ее коэффициент значительно отличается от нуля. В противном случае принимается нулевая гипотеза о нулевом значении истинного коэффициента.

Кроме того, тест Чоу используется для проверки того, имеют ли две подвыборки одинаковые базовые истинные значения коэффициентов. Сумма квадратов остатков регрессий на каждом из подмножеств и на объединенном наборе данных сравнивается путем вычисления F-статистики; если она превышает критическое значение, нулевая гипотеза об отсутствии различий между двумя подмножествами отклоняется; в противном случае она принимается.

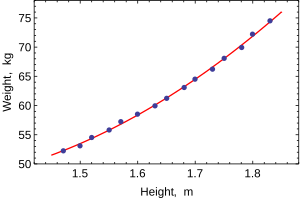

Следующий набор данных содержит средние показатели роста и веса американских женщин в возрасте 30–39 лет (источник: The World Almanac and Book of Facts, 1975 ).

Когда моделируется только одна зависимая переменная, диаграмма рассеяния покажет форму и силу связи между зависимой переменной и регрессорами. Она также может выявить выбросы, гетероскедастичность и другие аспекты данных, которые могут усложнить интерпретацию подобранной модели регрессии. Диаграмма рассеяния показывает, что связь сильная и может быть аппроксимирована как квадратичная функция. МНК может обрабатывать нелинейные связи, вводя регрессор HEIGHT 2 . Тогда регрессионная модель становится множественной линейной моделью:

Вывод большинства популярных статистических пакетов будет выглядеть примерно так:

В этой таблице:

Обычный анализ наименьших квадратов часто включает использование диагностических графиков, предназначенных для обнаружения отклонений данных от предполагаемой формы модели. Вот некоторые из распространенных диагностических графиков:

Важным соображением при выполнении статистического вывода с использованием регрессионных моделей является то, как были отобраны данные. В этом примере данные являются средними, а не измерениями отдельных женщин. Подгонка модели очень хорошая, но это не означает, что вес отдельной женщины можно предсказать с высокой точностью, основываясь только на ее росте.

Этот пример также демонстрирует, что коэффициенты, определяемые этими расчетами, чувствительны к тому, как подготовлены данные. Первоначально высоты были округлены до ближайшего дюйма и были преобразованы и округлены до ближайшего сантиметра. Поскольку коэффициент преобразования составляет один дюйм к 2,54 см, это не точное преобразование. Исходные дюймы можно восстановить с помощью Round(x/0,0254), а затем снова преобразовать в метрическую систему без округления. Если это сделать, результаты станут:

Использование любого из этих уравнений для прогнозирования веса женщины ростом 5 футов 6 дюймов (1,6764 м) дает схожие значения: 62,94 кг с округлением против 62,98 кг без округления. Таким образом, кажущееся небольшим изменение в данных оказывает реальное влияние на коэффициенты, но незначительное влияние на результаты уравнения.

Хотя это может выглядеть безобидным в середине диапазона данных, оно может стать существенным в крайних значениях или в случае, когда подобранная модель используется для проецирования за пределы диапазона данных ( экстраполяция ).

Это подчеркивает распространенную ошибку: этот пример является злоупотреблением OLS, которое по своей сути требует, чтобы ошибки в независимой переменной (в данном случае высоте) были равны нулю или, по крайней мере, пренебрежимо малы. Первоначальное округление до ближайшего дюйма плюс любые фактические ошибки измерения составляют конечную и непренебрежимо малую ошибку. В результате подобранные параметры не являются наилучшими оценками, какими они предположительно должны быть. Хотя это и не полностью ложно, ошибка в оценке будет зависеть от относительного размера ошибок x и y .

Мы можем использовать механизм наименьших квадратов, чтобы вычислить уравнение орбиты двух тел в полярных базовых координатах. Обычно используется уравнение, где — радиус того, насколько далеко объект находится от одного из тел. В уравнении параметры и используются для определения пути орбиты. Мы измерили следующие данные.

Нам необходимо найти приближение наименьших квадратов и для заданных данных.

Сначала нам нужно представить e и p в линейной форме. Поэтому мы собираемся переписать уравнение как . Кроме того, можно подогнать для апсид , расширив с помощью дополнительного параметра как , который линеен в обоих и в дополнительной базисной функции , используемой для дополнительной . Мы используем исходную двухпараметрическую форму для представления наших наблюдательных данных как:

где есть и есть и построено по первому столбцу, являющемуся коэффициентом , и второму столбцу, являющемуся коэффициентом , и есть значения для соответствующих so и

При решении получаем

так и