Дисперсионный анализ ( ANOVA ) представляет собой набор статистических моделей и связанных с ними процедур оценки (таких как «вариация» среди групп и между ними), используемых для анализа различий между средними значениями. ANOVA был разработан статистиком Рональдом Фишером . ANOVA основан на законе общей дисперсии , где наблюдаемая дисперсия в конкретной переменной разбивается на компоненты, приписываемые различным источникам вариации. В своей простейшей форме ANOVA обеспечивает статистический тест того, равны ли два или более средних значения совокупности, и, следовательно, обобщает t -тест за пределы двух средних значений. Другими словами, ANOVA используется для проверки разницы между двумя или более средними значениями.

В то время как дисперсионный анализ достиг своего расцвета в 20 веке, предшественники, по словам Стиглера, уходят на столетия в прошлое . [1] К ним относятся проверка гипотез, разбиение сумм квадратов, экспериментальные методы и аддитивная модель. Лаплас проводил проверку гипотез в 1770-х годах. [2] Около 1800 года Лаплас и Гаусс разработали метод наименьших квадратов для объединения наблюдений, который улучшил методы, использовавшиеся тогда в астрономии и геодезии . Он также инициировал множество исследований вкладов в суммы квадратов. Лаплас знал, как оценить дисперсию из остаточной (а не общей) суммы квадратов. [3] К 1827 году Лаплас использовал методы наименьших квадратов для решения проблем ANOVA, касающихся измерений атмосферных приливов. [4] До 1800 года астрономы изолировали ошибки наблюдений, возникающие из-за времени реакции (« личное уравнение »), и разработали методы уменьшения ошибок. [5] Экспериментальные методы, используемые при изучении личного уравнения, позднее были приняты развивающейся областью психологии [6] , которая разработала сильные (полные факторные) экспериментальные методы, к которым вскоре были добавлены рандомизация и ослепление. [7] Красноречивое нематематическое объяснение модели аддитивных эффектов было доступно в 1885 году. [8]

Рональд Фишер ввел термин «дисперсия» и предложил его формальный анализ в статье 1918 года по теоретической популяционной генетике « Корреляция между родственниками при предположении о менделевском наследовании» . [9] Его первое применение дисперсионного анализа к анализу данных было опубликовано в 1921 году в работе «Исследования вариации сельскохозяйственных культур I» . [10] В ней вариация временного ряда была разделена на компоненты, представляющие ежегодные причины и медленное ухудшение. Следующая работа Фишера « Исследования вариации сельскохозяйственных культур II» , написанная совместно с Уинифред Маккензи и опубликованная в 1923 году, изучала вариацию урожайности на участках, засеянных разными сортами и подвергнутых разным обработкам удобрениями. [11] Дисперсионный анализ стал широко известен после того, как был включен в книгу Фишера 1925 года «Статистические методы для научных работников» .

Модели рандомизации были разработаны несколькими исследователями. Первая была опубликована на польском языке Ежи Нейманом в 1923 году. [12]

Дисперсионный анализ может быть использован для описания сложных взаимосвязей между переменными. Примером может служить выставка собак. Выставка собак не является случайной выборкой породы: она обычно ограничивается взрослыми, чистокровными и образцовыми собаками. Гистограмма веса собак с выставки, вероятно, будет довольно сложной, как желто-оранжевое распределение, показанное на иллюстрациях. Предположим, мы хотим предсказать вес собаки на основе определенного набора характеристик каждой собаки. Один из способов сделать это — объяснить распределение веса, разделив популяцию собак на группы на основе этих характеристик. Успешная группировка разделит собак таким образом, что (a) каждая группа будет иметь низкую дисперсию веса собак (то есть группа будет относительно однородной) и (b) среднее значение каждой группы будет различным (если две группы имеют одинаковое среднее значение, то неразумно делать вывод о том, что группы фактически разделены каким-либо значимым образом).

На иллюстрациях справа группы обозначены как X 1 , X 2 и т. д. На первой иллюстрации собаки разделены в соответствии с произведением (взаимодействием) двух бинарных группировок: молодые против старых и короткошерстные против длинношерстных (например, группа 1 — молодые собаки с короткой шерстью, группа 2 — молодые собаки с длинной шерстью и т. д.). Поскольку распределение веса собак внутри каждой из групп (показано синим цветом) имеет относительно большую дисперсию, а средние значения очень похожи по группам, группировка собак по этим характеристикам не дает эффективного способа объяснить вариацию веса собак: знание того, в какой группе находится собака, не позволяет нам предсказать ее вес намного лучше, чем просто знание того, что собака участвует в выставке собак. Таким образом, эта группировка не может объяснить вариацию в общем распределении (желто-оранжевый).

Попытка объяснить распределение веса, сгруппировав собак как домашних животных против рабочих пород и менее спортивных против более спортивных, вероятно, была бы несколько более успешной (справедливое соответствие). Самые тяжелые выставочные собаки, скорее всего, будут крупными, сильными, рабочими породами, в то время как породы, содержащиеся в качестве домашних животных, как правило, меньше и, следовательно, легче. Как показано на второй иллюстрации, распределения имеют дисперсии, которые значительно меньше, чем в первом случае, а средние значения более различимы. Однако значительное перекрытие распределений, например, означает, что мы не можем надежно различить X 1 и X 2. Группировка собак по подбрасыванию монеты может привести к распределениям, которые выглядят похожими.

Попытка объяснить вес породой, скорее всего, даст очень хорошее соответствие. Все чихуахуа легкие, а все сенбернары тяжелые. Разница в весе между сеттерами и пойнтерами не оправдывает разделение пород. Дисперсионный анализ предоставляет формальные инструменты для обоснования этих интуитивных суждений. Распространенным применением метода является анализ экспериментальных данных или разработка моделей. Метод имеет некоторые преимущества по сравнению с корреляцией: не все данные должны быть числовыми, и одним из результатов метода является суждение о достоверности объясняющей связи.

В дисперсионном анализе используются три класса моделей, которые описаны здесь.

Модель с фиксированными эффектами (класс I) дисперсионного анализа применяется к ситуациям, в которых экспериментатор применяет одно или несколько воздействий к субъектам эксперимента, чтобы увидеть, изменяются ли значения переменной отклика . Это позволяет экспериментатору оценить диапазоны значений переменной отклика, которые воздействие будет генерировать в популяции в целом.

Модель случайных эффектов (класс II) используется, когда обработки не фиксированы. Это происходит, когда различные уровни факторов выбираются из более крупной популяции. Поскольку сами уровни являются случайными величинами , некоторые предположения и метод сопоставления обработок (многовариантное обобщение простых различий) отличаются от модели фиксированных эффектов. [13]

Модель со смешанными эффектами (класс III) содержит экспериментальные факторы как фиксированного, так и случайного типов эффектов, с соответственно различными интерпретациями и анализом для двух типов.

Обучающие эксперименты могут проводиться факультетом колледжа или университета, чтобы найти хороший вводный учебник, при этом каждый текст может считаться лечением. Модель с фиксированными эффектами будет сравнивать список текстов-кандидатов. Модель со случайными эффектами будет определять, существуют ли важные различия в списке случайно выбранных текстов. Модель со смешанными эффектами будет сравнивать (фиксированные) действующие тексты со случайно выбранными альтернативами.

Определение фиксированных и случайных эффектов оказалось неуловимым, поскольку существует множество конкурирующих определений. [14]

Анализ дисперсии изучался с помощью нескольких подходов, наиболее распространенный из которых использует линейную модель , которая связывает ответ с обработками и блоками. Обратите внимание, что модель линейна по параметрам, но может быть нелинейной по уровням факторов. Интерпретация проста, когда данные сбалансированы по факторам, но для несбалансированных данных требуется гораздо более глубокое понимание.

Дисперсионный анализ можно представить в виде линейной модели , которая делает следующие предположения о распределении вероятностей ответов: [15] [16] [17] [18]

Отдельные предположения модели учебника подразумевают, что ошибки независимы, идентичны и нормально распределены для моделей с фиксированными эффектами, то есть, что ошибки ( ) независимы и

В рандомизированном контролируемом эксперименте воздействия случайным образом назначаются экспериментальным единицам в соответствии с экспериментальным протоколом. Эта рандомизация является объективной и объявляется до проведения эксперимента. Объективное случайное назначение используется для проверки значимости нулевой гипотезы в соответствии с идеями CS Peirce и Ronald Fisher . Этот анализ, основанный на дизайне, обсуждался и разрабатывался Francis J. Anscombe на Rothamsted Experimental Station и Oscar Kempthorne в Iowa State University . [19] Kempthorne и его студенты делают предположение об аддитивности воздействия единиц , которое обсуждается в книгах Kempthorne и David R. Cox . [20] [21]

В своей простейшей форме предположение об аддитивности единицы воздействия [nb 1] гласит, что наблюдаемая реакция экспериментальной единицы при получении воздействия может быть записана как сумма реакции единицы и эффекта воздействия , то есть [22] [23] [24] Предположение об аддитивности единицы воздействия подразумевает, что для каждой обработки й вид воздействия оказывает точно такой же эффект на каждую экспериментальную единицу.

Предположение об аддитивности единичного лечения обычно не может быть напрямую фальсифицировано , согласно Коксу и Кемпторну. Однако многие следствия аддитивности единичного лечения могут быть фальсифицированы. Для рандомизированного эксперимента предположение об аддитивности единичного лечения подразумевает , что дисперсия постоянна для всех видов лечения. Поэтому, контрапозицией , необходимым условием аддитивности единичного лечения является то, что дисперсия постоянна.

Использование аддитивности единичного воздействия и рандомизации аналогично выводу на основе дизайна, который является стандартным при выборочном обследовании конечной популяции .

Кемпторн использует рандомизацию-распределение и предположение об аддитивности единичного воздействия для создания производной линейной модели , очень похожей на модель из учебника, обсуждавшуюся ранее. [25] Тестовая статистика этой производной линейной модели близко аппроксимируется тестовой статистикой соответствующей нормальной линейной модели, согласно теоремам аппроксимации и исследованиям моделирования. [26] Однако есть и различия. Например, анализ на основе рандомизации приводит к небольшой, но (строго) отрицательной корреляции между наблюдениями. [27] [28] В анализе на основе рандомизации нет предположения о нормальном распределении и, конечно, нет предположения о независимости . Напротив, наблюдения зависимы !

Анализ на основе рандомизации имеет тот недостаток, что его изложение требует утомительной алгебры и большого количества времени. Поскольку анализ на основе рандомизации сложен и близко аппроксимируется подходом с использованием нормальной линейной модели, большинство преподавателей подчеркивают подход с использованием нормальной линейной модели. Мало кто из статистиков возражает против анализа на основе модели сбалансированных рандомизированных экспериментов.

Однако при применении к данным нерандомизированных экспериментов или наблюдательных исследований анализ на основе моделей не имеет гарантии рандомизации. [29] Для наблюдательных данных вывод доверительных интервалов должен использовать субъективные модели, как подчеркивали Рональд Фишер и его последователи. На практике оценки эффектов лечения из наблюдательных исследований, как правило, часто непоследовательны. На практике «статистические модели» и наблюдательные данные полезны для предложения гипотез, к которым общественность должна относиться очень осторожно. [30]

Анализ ANOVA на основе нормальной модели предполагает независимость, нормальность и однородность дисперсий остатков. Анализ на основе рандомизации предполагает только однородность дисперсий остатков (как следствие аддитивности единичного воздействия) и использует процедуру рандомизации эксперимента. Оба эти анализа требуют гомоскедастичности как предположения для анализа нормальной модели и как следствие рандомизации и аддитивности для анализа на основе рандомизации.

Однако исследования процессов, которые изменяют дисперсии, а не средние значения (так называемые эффекты дисперсии), были успешно проведены с использованием ANOVA. [31] Для ANOVA в его полной общности нет необходимых предположений, но F - тест , используемый для проверки гипотез ANOVA, имеет предположения и практические ограничения, которые продолжают представлять интерес.

Проблемы, которые не удовлетворяют предположениям ANOVA, часто можно преобразовать, чтобы удовлетворить предположениям. Свойство аддитивности единичной обработки не является инвариантным относительно «изменения масштаба», поэтому статистики часто используют преобразования для достижения аддитивности единичной обработки. Если ожидается, что переменная отклика будет следовать параметрическому семейству распределений вероятностей, то статистик может указать (в протоколе эксперимента или наблюдательного исследования), что отклики должны быть преобразованы для стабилизации дисперсии. [32] Кроме того, статистик может указать, что логарифмические преобразования должны применяться к откликам, которые, как полагают, следуют мультипликативной модели. [23] [33] Согласно теореме Коши о функциональном уравнении , логарифм является единственным непрерывным преобразованием, которое преобразует действительное умножение в сложение. [ необходима ссылка ]

ANOVA используется при анализе сравнительных экспериментов, в которых интерес представляет только разница в результатах. Статистическая значимость эксперимента определяется отношением двух дисперсий. Это отношение не зависит от нескольких возможных изменений экспериментальных наблюдений: Добавление константы ко всем наблюдениям не меняет значимости. Умножение всех наблюдений на константу не меняет значимости. Таким образом, результат статистической значимости ANOVA не зависит от смещения константы и ошибок масштабирования, а также от единиц, используемых при выражении наблюдений. В эпоху механических вычислений было принято вычитать константу из всех наблюдений (когда это эквивалентно отбрасыванию первых цифр) для упрощения ввода данных. [34] [35] Это пример кодирования данных .

Расчеты ANOVA можно охарактеризовать как вычисление ряда средних значений и дисперсий, деление двух дисперсий и сравнение отношения со значением из справочника для определения статистической значимости. Расчет эффекта лечения затем тривиален: «эффект любого лечения оценивается путем взятия разницы между средним значением наблюдений, которые подвергаются лечению, и общим средним значением». [36]

ANOVA использует традиционную стандартизированную терминологию. Уравнение определения дисперсии выборки — , где делитель называется степенями свободы (DF), суммирование называется суммой квадратов (SS), результат называется средним квадратом (MS), а квадраты членов являются отклонениями от среднего выборки. ANOVA оценивает 3 дисперсии выборки: общую дисперсию, основанную на всех отклонениях наблюдений от общего среднего, дисперсию ошибки, основанную на всех отклонениях наблюдений от соответствующих средних значений обработки, и дисперсию обработки. Дисперсия обработки основана на отклонениях средних значений обработки от общего среднего, результат умножается на количество наблюдений в каждой обработке для учета разницы между дисперсией наблюдений и дисперсией средних значений.

Фундаментальный метод — это разбиение общей суммы квадратов SS на компоненты, связанные с эффектами, используемыми в модели. Например, модель для упрощенного ANOVA с одним типом лечения на разных уровнях.

Число степеней свободы DF можно разделить аналогичным образом: один из этих компонентов (для ошибки) определяет распределение хи-квадрат , которое описывает соответствующую сумму квадратов, в то время как то же самое справедливо для «обработок», если эффект обработки отсутствует.

F - тест используется для сравнения факторов общего отклонения. Например, в однофакторном ANOVA статистическая значимость проверяется путем сравнения статистики F-теста

где MS — среднеквадратичное значение, — количество процедур, — общее количество случаев.

к F -распределению , где числитель — это степени свободы, а знаменатель — это степени свободы. Использование F -распределения — естественный кандидат, поскольку тестовая статистика — это отношение двух масштабированных сумм квадратов, каждая из которых следует масштабированному распределению хи-квадрат .

Ожидаемое значение F равно (где — размер выборки лечения), что равно 1 при отсутствии эффекта лечения. По мере того, как значения F увеличиваются выше 1, доказательства все больше не согласуются с нулевой гипотезой. Два очевидных экспериментальных метода увеличения F — это увеличение размера выборки и уменьшение дисперсии ошибок путем жесткого экспериментального контроля.

Существует два метода завершения проверки гипотезы ANOVA, оба из которых дают одинаковый результат:

Известно, что F -тест ANOVA почти оптимален в смысле минимизации ложноотрицательных ошибок для фиксированного уровня ложноположительных ошибок (т. е. максимизации мощности для фиксированного уровня значимости). Например, для проверки гипотезы о том, что различные методы лечения имеют абсолютно одинаковый эффект, p -значения F -теста близко приближаются к p-значениям теста перестановки : приближение особенно близко, когда дизайн сбалансирован. [26] [37] Такие тесты перестановки характеризуют тесты с максимальной мощностью против всех альтернативных гипотез , как заметил Розенбаум . [nb 2] F -тест ANOVA (нулевой гипотезы о том, что все методы лечения имеют абсолютно одинаковый эффект) рекомендуется в качестве практического теста из-за его устойчивости против многих альтернативных распределений. [38] [nb 3]

ANOVA состоит из отдельных частей; разделение источников дисперсии и проверка гипотез могут использоваться по отдельности. ANOVA используется для поддержки других статистических инструментов. Регрессия сначала используется для подгонки более сложных моделей к данным, затем ANOVA используется для сравнения моделей с целью выбора простых(r) моделей, которые адекватно описывают данные. «Такие модели могут быть подогнаны без какой-либо ссылки на ANOVA, но инструменты ANOVA затем могут быть использованы для придания некоторого смысла подобранным моделям и для проверки гипотез о пакетах коэффициентов». [39] «[М]ы думаем об анализе дисперсии как о способе понимания и структурирования многоуровневых моделей — не как об альтернативе регрессии, а как об инструменте для обобщения сложных многомерных выводов...» [39]

Самый простой эксперимент, подходящий для анализа ANOVA, — это полностью рандомизированный эксперимент с одним фактором. Более сложные эксперименты с одним фактором включают ограничения на рандомизацию и включают полностью рандомизированные блоки и латинские квадраты (и варианты: греко-латинские квадраты и т. д.). Более сложные эксперименты разделяют многие сложности множественных факторов.

Существуют некоторые альтернативы традиционному однофакторному дисперсионному анализу, например: гетероскедастический F-тест Уэлча, гетероскедастический F-тест Уэлча с усеченными средними и винзоризованными дисперсиями, тест Брауна-Форсайта, тест Александера-Говерна, тест Джеймса второго порядка и тест Краскела-Уоллиса, доступные в однофакторных тестах R.

Полезно представить каждую точку данных в следующей форме, называемой статистической моделью: где

То есть мы представляем себе аддитивную модель, которая утверждает, что каждая точка данных может быть представлена путем суммирования трех величин: истинного среднего значения, усредненного по всем исследуемым уровням факторов, плюс инкрементный компонент, связанный с конкретным столбцом (уровнем факторов), плюс конечный компонент, связанный со всем остальным, что влияет на это конкретное значение данных.

ANOVA обобщает изучение эффектов множественных факторов. Когда эксперимент включает наблюдения при всех комбинациях уровней каждого фактора, он называется факторным . Факторные эксперименты более эффективны, чем серия экспериментов с одним фактором, и эффективность растет с увеличением числа факторов. [40] Следовательно, факторные планы широко используются.

Использование ANOVA для изучения эффектов нескольких факторов имеет сложность. В 3-факторном ANOVA с факторами x, y и z модель ANOVA включает термины для основных эффектов (x, y, z) и термины для взаимодействий (xy, xz, yz, xyz). Все термины требуют проверки гипотез. Распространение терминов взаимодействия увеличивает риск того, что некоторые проверки гипотез дадут ложноположительный результат случайно. К счастью, опыт показывает, что взаимодействия высокого порядка редки. [41] [ требуется проверка ] Возможность обнаруживать взаимодействия является основным преимуществом многофакторного ANOVA. Проверка одного фактора за раз скрывает взаимодействия, но дает явно непоследовательные экспериментальные результаты. [40]

Рекомендуется проявлять осторожность при столкновении со взаимодействиями; Сначала проверьте условия взаимодействия и расширьте анализ за пределы ANOVA, если взаимодействия обнаружены. Тексты различаются в своих рекомендациях относительно продолжения процедуры ANOVA после обнаружения взаимодействия. Взаимодействия усложняют интерпретацию экспериментальных данных. Ни расчеты значимости, ни предполагаемые эффекты лечения не могут быть приняты за чистую монету. «Значительное взаимодействие часто будет маскировать значимость основных эффектов». [42] Для улучшения понимания рекомендуются графические методы. Регрессия часто полезна. Подробное обсуждение взаимодействий доступно в Cox (1958). [43] Некоторые взаимодействия можно удалить (путем преобразований), а другие — нет.

Для снижения расходов в многофакторном ANOVA используются различные методы. Один из методов, используемых в факторных планах, заключается в минимизации повторений (возможно, без повторений с поддержкой аналитических уловок ) и объединении групп, когда эффекты оказываются статистически (или практически) незначимыми. Эксперимент со многими незначимыми факторами может свестись к эксперименту с несколькими факторами, поддерживаемыми многими повторениями. [44]

Некоторый анализ требуется для поддержки дизайна эксперимента , в то время как другой анализ выполняется после того, как формально обнаружено, что изменения факторов приводят к статистически значимым изменениям в ответах. Поскольку экспериментирование является итеративным, результаты одного эксперимента изменяют планы для следующих экспериментов.

При планировании эксперимента количество экспериментальных единиц планируется для удовлетворения целей эксперимента. Экспериментирование часто является последовательным.

Ранние эксперименты часто разрабатываются для получения несмещенных оценок эффектов лечения и экспериментальной ошибки. Более поздние эксперименты часто разрабатываются для проверки гипотезы о том, что эффект лечения имеет важную величину; в этом случае количество экспериментальных единиц выбирается таким образом, чтобы эксперимент не выходил за рамки бюджета и имел достаточную мощность, среди прочих целей.

Отчетность по анализу размера выборки обычно требуется в психологии. «Предоставьте информацию о размере выборки и процессе, который привел к решениям о размере выборки». [45] Анализ, который записывается в экспериментальном протоколе до проведения эксперимента, рассматривается в заявках на гранты и административных наблюдательных советах.

Помимо анализа мощности существуют менее формальные методы выбора числа экспериментальных единиц. К ним относятся графические методы, основанные на ограничении вероятности ложноотрицательных ошибок, графические методы, основанные на ожидаемом увеличении вариации (выше остатков) и методы, основанные на достижении желаемого доверительного интервала. [46]

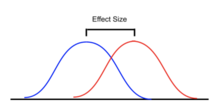

Анализ мощности часто применяется в контексте ANOVA для оценки вероятности успешного отклонения нулевой гипотезы, если мы предполагаем определенный дизайн ANOVA, размер эффекта в популяции, размер выборки и уровень значимости. Анализ мощности может помочь в разработке исследования, определяя, какой размер выборки потребуется для того, чтобы иметь разумный шанс отклонения нулевой гипотезы, когда альтернативная гипотеза верна. [47] [48] [49] [50]

Несколько стандартизированных мер эффекта были предложены для ANOVA, чтобы суммировать силу связи между предиктором(ами) и зависимой переменной или общей стандартизированной разницей полной модели. Стандартизированные оценки размера эффекта облегчают сравнение результатов в разных исследованиях и дисциплинах. Однако, хотя стандартизированные размеры эффекта обычно используются в большей части профессиональной литературы, нестандартизированная мера размера эффекта, которая имеет немедленно «значимые» единицы, может быть предпочтительнее для целей отчетности. [51]

Иногда проводятся тесты, чтобы определить, нарушаются ли предположения ANOVA. Остатки проверяются или анализируются для подтверждения гомоскедастичности и общей нормальности. [52] Остатки должны иметь вид шума (нормальное распределение с нулевым средним) при построении графика как функции чего-либо, включая время и смоделированные значения данных. Тенденции намекают на взаимодействие между факторами или между наблюдениями.

Статистически значимый эффект в ANOVA часто сопровождается дополнительными тестами. Это может быть сделано для того, чтобы оценить, какие группы отличаются от других групп, или для проверки различных других целевых гипотез. Последующие тесты часто различаются с точки зрения того, являются ли они «запланированными» ( a priori ) или «post hoc ». Запланированные тесты определяются до рассмотрения данных, а post hoc тесты задумываются только после рассмотрения данных (хотя термин «post hoc» используется непоследовательно).

Последующие тесты могут быть «простыми» парными сравнениями средних значений отдельных групп или «сложными» сравнениями (например, сравнением среднего объединения по группам A, B и C со средним значением группы D). Сравнения также могут рассматривать тесты тренда, такие как линейные и квадратичные отношения, когда независимая переменная включает упорядоченные уровни. Часто последующие тесты включают метод корректировки для проблемы множественных сравнений .

Последующие тесты для определения того, какие конкретные группы, переменные или факторы имеют статистически разные средние значения, включают тест размаха Тьюки и новый тест множественного размаха Дункана . В свою очередь, эти тесты часто сопровождаются методологией компактного отображения букв (CLD) , чтобы сделать вывод упомянутых тестов более прозрачным для аудитории, не являющейся статистиком.

Существует несколько типов ANOVA. Многие статистики основывают ANOVA на дизайне эксперимента , [53] особенно на протоколе, который определяет случайное назначение методов лечения субъектам; описание протокола механизма назначения должно включать спецификацию структуры методов лечения и любого блокирования . Также часто применяют ANOVA к данным наблюдений с использованием соответствующей статистической модели. [54]

Некоторые популярные разработки используют следующие типы ANOVA:

Сбалансированные эксперименты (с одинаковым размером выборки для каждого лечения) относительно легко интерпретировать; несбалансированные эксперименты предлагают больше сложности. Для однофакторного (одностороннего) ANOVA корректировка для несбалансированных данных проста, но несбалансированному анализу не хватает как надежности, так и мощности. [57] Для более сложных планов отсутствие баланса приводит к дальнейшим осложнениям. «Свойство ортогональности основных эффектов и взаимодействий, присутствующих в сбалансированных данных, не переносится на несбалансированный случай. Это означает, что обычные методы дисперсионного анализа неприменимы. Следовательно, анализ несбалансированных факториалов намного сложнее, чем для сбалансированных планов». [58] В общем случае «дисперсионный анализ также может быть применен к несбалансированным данным, но тогда суммы квадратов, средние квадраты и F -коэффициенты будут зависеть от порядка, в котором рассматриваются источники вариации». [39]

ANOVA (отчасти) является тестом статистической значимости. Американская психологическая ассоциация (и многие другие организации) придерживается мнения, что простое сообщение статистической значимости недостаточно и что предпочтительнее сообщение доверительных границ. [51]

ANOVA считается частным случаем линейной регрессии [59] [60] , которая в свою очередь является частным случаем общей линейной модели . [61] Все рассматривают наблюдения как сумму модели (подгонки) и остатка (ошибки), подлежащего минимизации.

Тест Краскела-Уоллиса и тест Фридмана являются непараметрическими тестами, которые не опираются на предположение о нормальности. [62] [63]

Ниже мы проясним связь между многофакторным дисперсионным анализом и линейной регрессией.

Линейно переупорядочиваем данные так, чтобы -ое наблюдение было связано с ответом и факторами , где обозначает различные факторы, а - общее количество факторов. В однофакторном ANOVA и двухфакторном ANOVA . Кроме того, мы предполагаем, что -ый фактор имеет уровни, а именно . Теперь мы можем закодировать факторы методом one-hot в размерный вектор .

Функция прямого кодирования определяется таким образом, что -й элемент равен Вектор является конкатенацией всех вышеуказанных векторов для всех . Таким образом, . Чтобы получить полностью общий -way ANOVA взаимодействия, мы должны также конкатенировать каждый дополнительный член взаимодействия в векторе , а затем добавить отсекаемый член. Пусть этот вектор будет .

С этой записью у нас теперь есть точная связь с линейной регрессией. Мы просто регрессируем ответ против вектора . Однако есть опасения по поводу идентифицируемости . Чтобы преодолеть такие проблемы, мы предполагаем, что сумма параметров в каждом наборе взаимодействий равна нулю. Отсюда можно использовать F -статистику или другие методы для определения релевантности отдельных факторов.

Мы можем рассмотреть пример двухстороннего взаимодействия, где мы предполагаем, что первый фактор имеет 2 уровня, а второй фактор — 3 уровня.

Определим , если и , если , то есть является прямым кодированием первого фактора, а является прямым кодированием второго фактора.

При этом, где последний член является термином перехвата. Для более конкретного примера предположим, что Тогда,

{{cite book}}: CS1 maint: отсутствует местоположение издателя ( ссылка )