Теория вероятностей или исчисление вероятностей — это раздел математики , изучающий вероятность . Хотя существует несколько различных интерпретаций вероятности , теория вероятностей рассматривает это понятие строгим математическим способом, выражая его через набор аксиом . Обычно эти аксиомы формализуют вероятность в терминах вероятностного пространства , которое присваивает меру , принимающую значения от 0 до 1, называемую вероятностной мерой , набору результатов, называемому выборочным пространством . Любое указанное подмножество выборочного пространства называется событием .

Центральные предметы теории вероятностей включают дискретные и непрерывные случайные величины , распределения вероятностей и случайные процессы (которые обеспечивают математические абстракции недетерминированных или неопределенных процессов или измеряемых величин , которые могут либо возникать единично, либо развиваться с течением времени случайным образом). Хотя невозможно точно предсказать случайные события, можно многое сказать об их поведении. Двумя основными результатами теории вероятностей, описывающими такое поведение, являются закон больших чисел и центральная предельная теорема .

В качестве математической основы статистики теория вероятностей важна для многих видов человеческой деятельности, связанных с количественным анализом данных. [1] Методы теории вероятностей также применимы к описаниям сложных систем при условии лишь частичного знания их состояния, как в статистической механике или последовательной оценке . Великим открытием физики двадцатого века стала вероятностная природа физических явлений на атомных масштабах, описанная в квантовой механике . [2]

Современная математическая теория вероятностей уходит своими корнями в попытки проанализировать азартные игры Джероламо Кардано в шестнадцатом веке, а также Пьера Ферма и Блеза Паскаля в семнадцатом веке (например, « проблема очков »). [3] Христиан Гюйгенс опубликовал книгу на эту тему в 1657 году. [4] В 19 веке то, что считается классическим определением вероятности, было завершено Пьером Лапласом . [5]

Первоначально теория вероятностей рассматривала в основном дискретные события, а ее методы были преимущественно комбинаторными . В конце концов, аналитические соображения вынудили включить в теорию непрерывные переменные.

Кульминацией этого стала современная теория вероятностей, основанная на основах, заложенных Андреем Николаевичем Колмогоровым . Колмогоров объединил понятие выборочного пространства , введенное Рихардом фон Мизесом , и теорию меры и представил свою систему аксиом теории вероятностей в 1933 году. Это стало в основном бесспорной аксиоматической основой современной теории вероятностей; но существуют альтернативы, такие как принятие Бруно де Финетти конечной, а не счетной аддитивности . [6]

В большинстве введений в теорию вероятностей дискретные и непрерывные распределения вероятностей рассматриваются отдельно. Рассмотрение вероятности, основанное на теории меры, охватывает дискретное, непрерывное, сочетание этих двух и многое другое.

Рассмотрим эксперимент , который может привести к ряду результатов. Набор всех результатов называется выборочным пространством эксперимента. Набор мощности выборочного пространства (или, что то же самое, пространства событий) формируется путем рассмотрения всех различных наборов возможных результатов. Например, бросок честной кости дает один из шести возможных результатов. Одна совокупность возможных результатов соответствует получению нечетного числа. Таким образом, подмножество {1,3,5} является элементом набора мощности выборочного пространства бросков игральных костей. Эти коллекции называются событиями . В данном случае {1,3,5} — это событие, когда на игральной кости выпадает некоторое нечетное число. Если результаты, которые действительно происходят, попадают в данное событие, говорят, что это событие произошло.

Вероятность — это способ присвоения каждому «событию» значения от нуля до единицы с требованием, чтобы событие состояло из всех возможных результатов (в нашем примере событие {1,2,3,4,5,6}). присвоить значение, равное единице. Чтобы квалифицироваться как распределение вероятностей , присвоение значений должно удовлетворять требованию, что если вы посмотрите на набор взаимоисключающих событий (событий, которые не содержат общих результатов, например, события {1,6}, {3} и { 2,4} являются взаимоисключающими), вероятность того, что любое из этих событий произойдет, определяется суммой вероятностей событий. [7]

Вероятность того, что произойдет любое из событий {1,6}, {3} или {2,4}, равна 5/6. Это то же самое, что сказать, что вероятность события {1,2,3,4,6} равна 5/6. Это событие предполагает возможность выпадения любого числа, кроме пяти. Взаимно исключающее событие {5} имеет вероятность 1/6, а событие {1,2,3,4,5,6} имеет вероятность 1, то есть абсолютную достоверность.

При расчетах по результатам эксперимента необходимо, чтобы всем этим элементарным событиям был присвоен номер. Это делается с помощью случайной величины . Случайная величина — это функция, которая присваивает каждому элементарному событию в выборочном пространстве действительное число . Эту функцию обычно обозначают заглавной буквой. [8] В случае игры в кости присвоение числа определенным элементарным событиям может быть выполнено с использованием тождественной функции . Это не всегда работает. Например, при подбрасывании монеты возможны два результата: «орёл» и «решка». В этом примере случайная величина X может присвоить результату «орёл» число «0» ( ), а результату «решка» — число «1» ( ).

Дискретная теория вероятностей имеет дело с событиями, которые происходят в счетных выборочных пространствах.

Примеры: бросание игральных костей , эксперименты с колодами карт , случайное блуждание и подбрасывание монет .

Классическое определение : Первоначально вероятность того, что событие произойдет, определялась как количество случаев, благоприятных для события, по отношению к общему числу возможных исходов в равновероятном выборочном пространстве: см. Классическое определение вероятности .

Например, если событием является «появление четного числа при броске игральной кости», вероятность определяется как , поскольку 3 грани из 6 имеют четные числа, и каждая грань имеет одинаковую вероятность появления.

Современное определение : Современное определение начинается с конечного или счетного набора , называемого выборочным пространством , которое относится к множеству всех возможных результатов в классическом смысле, обозначаемому . Затем предполагается, что каждому элементу присвоено внутреннее значение «вероятности» , которое удовлетворяет следующим свойствам:

То есть функция вероятности f ( x ) находится между нулем и единицей для каждого значения x в выборочном пространстве Ω , а сумма f ( x ) по всем значениям x в выборочном пространстве Ω равна 1. Событие определяется как любое подмножество выборочного пространства . Вероятность события определяется как

Таким образом, вероятность всего выборочного пространства равна 1, а вероятность нулевого события равна 0.

Функция , отображающая точку в выборочном пространстве на значение «вероятности», называется функцией массы вероятности, сокращенно pmf .

Теория непрерывной вероятности имеет дело с событиями, которые происходят в непрерывном выборочном пространстве.

Классическое определение . Классическое определение терпит неудачу при столкновении с непрерывным случаем. См. парадокс Бертрана .

Современное определение : Если выборочное пространство случайной величины X представляет собой набор действительных чисел ( ) или его подмножество, то существует функция, называемая кумулятивной функцией распределения ( CDF ) , определяемая . То есть F ( x ) возвращает вероятность того, что X будет меньше или равно x .

CDF обязательно удовлетворяет следующим свойствам.

Говорят, что случайная величина имеет непрерывное распределение вероятностей, если соответствующая CDF непрерывна. Если она абсолютно непрерывна , т. е. ее производная существует, и интегрирование производной снова дает нам CDF, то говорят, что случайная величина X имеет функцию плотности вероятности ( PDF ) или просто плотность

Для набора вероятность того, что случайная величина X окажется в нем, равна

Если PDF-файл существует, это можно записать как

В то время как PDF существует только для непрерывных случайных величин, CDF существует для всех случайных величин (включая дискретные случайные величины), которые принимают значения в

Эти концепции можно обобщить для многомерных случаев и других непрерывных выборочных пространств.

Полезность теоретико-мерной трактовки вероятности состоит в том, что она объединяет дискретный и непрерывный случаи и делает различие вопросом о том, какая мера используется. Более того, он охватывает распределения, которые не являются ни дискретными, ни непрерывными, ни смесью того и другого.

Примером таких распределений может быть сочетание дискретного и непрерывного распределений — например, случайная величина, равная 0 с вероятностью 1/2 и принимающая случайное значение из нормального распределения с вероятностью 1/2. Его все еще можно изучить в некоторой степени, рассматривая его как PDF-файл , где - дельта-функция Дирака .

Другие распределения могут даже не быть смешанными, например, распределение Кантора не имеет положительной вероятности для какой-либо отдельной точки и не имеет плотности. Современный подход к теории вероятностей решает эти проблемы, используя теорию меры для определения вероятностного пространства :

Учитывая любое множество (также называемое выборочным пространством ) и σ-алгебру на нем, мера , определенная на, называется вероятностной мерой, если

Если — борелевская σ-алгебра на множестве действительных чисел, то для любой CDF существует единственная вероятностная мера, и наоборот. Говорят, что мера, соответствующая CDF, индуцирована CDF . Эта мера совпадает с PMF для дискретных переменных и PDF для непрерывных переменных, что делает теоретико-мерный подход свободным от ошибок.

Вероятность множества в σ-алгебре определяется как

где интегрирование ведется по мере, индуцированной

Наряду с обеспечением лучшего понимания и объединения дискретных и непрерывных вероятностей, теоретико-мерная трактовка также позволяет нам работать с вероятностями снаружи , как в теории случайных процессов . Например, для изучения броуновского движения вероятность определяется в пространстве функций.

Когда удобно работать с доминирующей мерой, теорема Радона-Никодима используется для определения плотности как производной Радона-Никодима интересующего распределения вероятностей относительно этой доминирующей меры. Дискретные плотности обычно определяются как производная по счетной мере по множеству всех возможных результатов. Плотности для абсолютно непрерывных распределений обычно определяются как эта производная по мере Лебега . Если теорему можно доказать в этой общей ситуации, она справедлива как для дискретных, так и для непрерывных распределений, а также для других; для дискретных и непрерывных распределений отдельные доказательства не требуются.

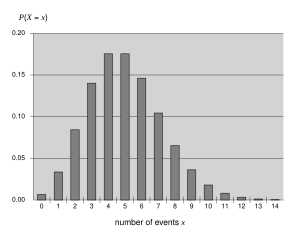

Определенные случайные величины очень часто встречаются в теории вероятностей, поскольку они хорошо описывают многие естественные или физические процессы. Поэтому их распределения приобрели особое значение в теории вероятностей. Некоторыми фундаментальными дискретными распределениями являются дискретное равномерное распределение , распределение Бернулли , биномиальное , отрицательное биномиальное , распределение Пуассона и геометрическое распределение . Важные непрерывные распределения включают непрерывное равномерное , нормальное , экспоненциальное , гамма- и бета-распределения .

В теории вероятностей существует несколько понятий сходимости случайных величин . Они перечислены ниже в порядке силы, т. е. любое последующее понятие сходимости в списке подразумевает сходимость по всем предыдущим понятиям.

Как видно из названий, слабая сходимость слабее сильной. Фактически, сильная сходимость подразумевает сходимость по вероятности, а сходимость по вероятности предполагает слабую сходимость. Обратные утверждения не всегда верны.

Общая интуиция подсказывает, что если честную монету подбросить много раз, то примерно в половине случаев она выпадет орлом , а в другой половине — решкой . Кроме того, чем чаще подбрасывается монета, тем больше вероятность того, что отношение количества орлов к числу решок приблизится к единице. Современная теория вероятностей предлагает формальную версию этой интуитивной идеи, известной как закон больших чисел . Этот закон примечателен тем, что он не предполагается в основах теории вероятностей, а вытекает из этих основ в виде теоремы. Поскольку он связывает теоретически полученные вероятности с их фактической частотой возникновения в реальном мире, закон больших чисел считается столпом истории статистической теории и имеет широкое влияние. [9]

Закон больших чисел (LLN) гласит, что выборочное среднее

последовательности независимых и одинаково распределенных случайных величин сходится к их общему математическому ожиданию (ожидаемому значению) при условии , что математическое ожидание конечно.

Именно разные формы сходимости случайных величин разделяют слабый и сильный закон больших чисел [10]

Из LLN следует, что если событие вероятности p наблюдается неоднократно в ходе независимых экспериментов, отношение наблюдаемой частоты этого события к общему числу повторений сходится к p .

Например, если являются независимыми случайными величинами Бернулли, принимающими значения 1 с вероятностью p и 0 с вероятностью 1- p , то для всех i , так что они почти наверняка сходятся к p .

Центральная предельная теорема (ЦПТ) объясняет повсеместное распространение нормального распределения в природе, и эта теорема, по словам Дэвида Уильямса, «является одним из величайших результатов математики». [11]

Теорема утверждает, что среднее значение многих независимых и одинаково распределенных случайных величин с конечной дисперсией стремится к нормальному распределению независимо от распределения, за которым следуют исходные случайные величины. Формально пусть – независимые случайные величины со средним значением и дисперсией . Тогда последовательность случайных величин

сходится по распределению к стандартной нормальной случайной величине.

Для некоторых классов случайных величин классическая центральная предельная теорема работает довольно быстро, как показано в теореме Берри–Эссеена . Например, распределения с конечными первым, вторым и третьим моментами из экспоненциального семейства ; с другой стороны, для некоторых случайных величин типа « тяжелый хвост » и «толстый хвост» он работает очень медленно или может не работать вообще: в таких случаях можно использовать Обобщенную центральную предельную теорему (GCLT).