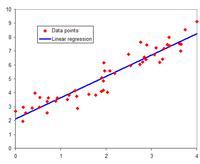

В статистическом моделировании регрессионный анализ представляет собой набор статистических процессов для оценки взаимосвязей между зависимой переменной (часто называемой переменной результата или отклика , или меткой на языке машинного обучения) и одной или несколькими независимыми переменными, не содержащими ошибок (часто называемыми регрессорами , предикторами , ковариатами , объясняющими переменными или признаками ). Наиболее распространенной формой регрессионного анализа является линейная регрессия , в которой находится линия (или более сложная линейная комбинация ), которая наиболее точно соответствует данным в соответствии с определенным математическим критерием. Например, метод наименьших квадратов вычисляет уникальную линию (или гиперплоскость ), которая минимизирует сумму квадратов разностей между истинными данными и этой линией (или гиперплоскостью). По определенным математическим причинам (см. линейная регрессия ) это позволяет исследователю оценить условное ожидание (или среднее значение популяции ) зависимой переменной, когда независимые переменные принимают заданный набор значений. Менее распространенные формы регрессии используют несколько иные процедуры для оценки альтернативных параметров местоположения (например, квантильная регрессия или анализ необходимых условий [1] ) или оценки условного ожидания в более широком наборе нелинейных моделей (например, непараметрическая регрессия ).

Регрессионный анализ в основном используется для двух концептуально различных целей. Во-первых, регрессионный анализ широко используется для прогнозирования и предсказания , где его применение существенно пересекается с областью машинного обучения . Во-вторых, в некоторых ситуациях регрессионный анализ может использоваться для вывода причинно-следственных связей между независимыми и зависимыми переменными. Важно отметить, что регрессии сами по себе выявляют только связи между зависимой переменной и набором независимых переменных в фиксированном наборе данных. Чтобы использовать регрессии для прогнозирования или для вывода причинно-следственных связей, соответственно, исследователь должен тщательно обосновать, почему существующие связи имеют предсказательную силу для нового контекста или почему связь между двумя переменными имеет причинно-следственную интерпретацию. Последнее особенно важно, когда исследователи надеются оценить причинно-следственные связи с использованием данных наблюдений . [2] [3]

Самой ранней формой регрессии был метод наименьших квадратов , опубликованный Лежандром в 1805 году [4] и Гауссом в 1809 году [5]. Лежандр и Гаусс оба применили этот метод к проблеме определения по астрономическим наблюдениям орбит тел вокруг Солнца (в основном комет, но позже и недавно открытых малых планет). Гаусс опубликовал дальнейшее развитие теории наименьших квадратов в 1821 году [6] , включая версию теоремы Гаусса–Маркова .

Термин «регрессия» был придуман Фрэнсисом Гальтоном в 19 веке для описания биологического явления. Явление заключалось в том, что рост потомков высоких предков имел тенденцию к снижению к нормальному среднему значению (явление, также известное как регрессия к среднему значению ). [7] [8] Для Гальтона регрессия имела только это биологическое значение, [9] [10] но его работа была позже расширена Удни Юлом и Карлом Пирсоном на более общий статистический контекст. [11] [12] В работе Юла и Пирсона совместное распределение ответной и объясняющей переменных предполагается гауссовым . Это предположение было ослаблено Р. А. Фишером в его работах 1922 и 1925 годов. [13] [14] [15] Фишер предположил, что условное распределение ответной переменной является гауссовым, но совместное распределение не обязательно должно быть таковым. В этом отношении предположение Фишера ближе к формулировке Гаусса 1821 года.

В 1950-х и 1960-х годах экономисты использовали электромеханические настольные калькуляторы для расчета регрессий. До 1970 года иногда требовалось до 24 часов, чтобы получить результат одной регрессии. [16]

Методы регрессии продолжают оставаться областью активных исследований. В последние десятилетия были разработаны новые методы для надежной регрессии , регрессии, включающей коррелированные ответы, такие как временные ряды и кривые роста , регрессии, в которой предиктор (независимая переменная) или переменные отклика являются кривыми, изображениями, графиками или другими сложными объектами данных, методов регрессии, учитывающих различные типы пропущенных данных, непараметрической регрессии , байесовских методов для регрессии, регрессии, в которой переменные-предикторы измеряются с ошибкой, регрессии с большим количеством переменных-предикторов, чем наблюдений, и причинно-следственной связи с регрессией.

На практике исследователи сначала выбирают модель, которую они хотели бы оценить, а затем используют выбранный ими метод (например, метод наименьших квадратов ) для оценки параметров этой модели. Регрессионные модели включают в себя следующие компоненты:

В различных областях применения вместо зависимых и независимых переменных используются разные термины .

Большинство регрессионных моделей предполагают, что является функцией ( функцией регрессии ) от и , с представлением аддитивного члена ошибки , который может заменять немоделируемые детерминанты или случайный статистический шум:

Обратите внимание, что предполагается, что независимые переменные не содержат ошибок. Это важное предположение часто упускается из виду, хотя модели с ошибками в переменных могут использоваться, когда предполагается, что независимые переменные содержат ошибки.

Цель исследователей — оценить функцию, которая наиболее точно соответствует данным. Для проведения регрессионного анализа необходимо указать форму функции. Иногда форма этой функции основана на знании о связи между и , которое не зависит от данных. Если такие знания отсутствуют, выбирается гибкая или удобная форма для . Например, простая одномерная регрессия может предложить , предполагая, что исследователь считает это разумным приближением для статистического процесса, генерирующего данные.

После того, как исследователи определяют свою предпочтительную статистическую модель , различные формы регрессионного анализа предоставляют инструменты для оценки параметров . Например, наименьшие квадраты (включая его наиболее распространенный вариант, обычный наименьшие квадраты ) находят значение , которое минимизирует сумму квадратов ошибок . Данный метод регрессии в конечном итоге предоставит оценку , обычно обозначаемую для отличия оценки от истинного (неизвестного) значения параметра, которое сгенерировало данные. Используя эту оценку, исследователь может затем использовать подобранное значение для прогнозирования или для оценки точности модели при объяснении данных. Будет ли исследователь внутренне заинтересован в оценке или предсказанном значении, будет зависеть от контекста и его целей. Как описано в обычном наименьшем квадрате , наименьшие квадраты широко используются, поскольку оцененная функция аппроксимирует условное ожидание . [5] Однако альтернативные варианты (например, наименьшие абсолютные отклонения или квантильная регрессия ) полезны, когда исследователи хотят смоделировать другие функции .

Важно отметить, что для оценки регрессионной модели должно быть достаточно данных. Например, предположим, что исследователь имеет доступ к строкам данных с одной зависимой и двумя независимыми переменными: . Предположим далее, что исследователь хочет оценить двумерную линейную модель с помощью наименьших квадратов : . Если у исследователя есть доступ только к точкам данных, то он может найти бесконечно много комбинаций , которые одинаково хорошо объясняют данные: можно выбрать любую комбинацию, которая удовлетворяет , все из которых приводят к и, следовательно, являются допустимыми решениями, которые минимизируют сумму квадратов остатков . Чтобы понять, почему существует бесконечно много вариантов, обратите внимание, что система уравнений должна быть решена для 3 неизвестных, что делает систему недоопределенной . В качестве альтернативы можно визуализировать бесконечно много 3-мерных плоскостей, которые проходят через фиксированные точки.

В более общем смысле, для оценки модели наименьших квадратов с различными параметрами необходимо иметь различные точки данных. Если , то, как правило, не существует набора параметров, который будет идеально соответствовать данным. Величина часто появляется в регрессионном анализе и называется степенями свободы в модели. Более того, для оценки модели наименьших квадратов независимые переменные должны быть линейно независимыми : нельзя иметь возможность реконструировать ни одну из независимых переменных путем сложения и умножения оставшихся независимых переменных. Как обсуждалось в обычных наименьших квадратах , это условие гарантирует, что является обратимой матрицей и, следовательно, что существует единственное решение .

Сама по себе регрессия — это просто расчет с использованием данных. Чтобы интерпретировать вывод регрессии как значимую статистическую величину, которая измеряет реальные отношения, исследователи часто полагаются на ряд классических предположений . Эти предположения часто включают:

Для того чтобы оценщик наименьших квадратов обладал желаемыми свойствами, достаточно нескольких условий: в частности, предположения Гаусса–Маркова подразумевают, что оценки параметров будут несмещенными , последовательными и эффективными в классе линейных несмещенных оценщиков. Практикующие специалисты разработали множество методов для поддержания некоторых или всех этих желаемых свойств в реальных условиях, поскольку эти классические предположения вряд ли будут соблюдаться точно. Например, моделирование ошибок в переменных может привести к разумным оценкам независимые переменные измеряются с ошибками. Гетероскедастично-согласованные стандартные ошибки позволяют дисперсии изменяться между значениями . Коррелированные ошибки, которые существуют в подмножествах данных или следуют определенным закономерностям, можно обрабатывать с помощью кластеризованных стандартных ошибок, географической взвешенной регрессии или стандартных ошибок Ньюи–Уэста , среди прочих методов. Когда строки данных соответствуют местоположениям в пространстве, выбор способа моделирования в географических единицах может иметь важные последствия. [17] [18] Подраздел эконометрики в значительной степени сосредоточен на разработке методов, которые позволяют исследователям делать обоснованные выводы в реальных условиях, где классические предположения не выполняются в точности.

В линейной регрессии спецификация модели заключается в том, что зависимая переменная, является линейной комбинацией параметров (но не обязательно должна быть линейной в независимых переменных ). Например, в простой линейной регрессии для моделирования точек данных есть одна независимая переменная: , и два параметра , и :

В множественной линейной регрессии имеется несколько независимых переменных или функций независимых переменных.

Добавление члена к предыдущей регрессии дает:

Это все еще линейная регрессия; хотя выражение в правой части является квадратичным по независимой переменной , оно линейно по параметрам , и

В обоих случаях — это ошибочный член, а нижний индекс указывает на конкретное наблюдение.

Возвращаясь к случаю прямой линии: имея случайную выборку из популяции, мы оцениваем параметры популяции и получаем модель линейной регрессии выборки:

Остаток , , представляет собой разницу между значением зависимой переменной, предсказанным моделью, , и истинным значением зависимой переменной, . Одним из методов оценки является метод наименьших квадратов . Этот метод получает оценки параметров, которые минимизируют сумму квадратов остатков , SSR :

Минимизация этой функции приводит к набору нормальных уравнений , набору одновременных линейных уравнений относительно параметров, которые решаются для получения оценок параметров, .

В случае простой регрессии формулы для оценок наименьших квадратов следующие:

где — среднее арифметическое значений , а — среднее арифметическое значений .

При предположении, что ошибка популяции имеет постоянную дисперсию, оценка этой дисперсии определяется по формуле:

Это называется средней квадратической ошибкой (MSE) регрессии. Знаменатель — это размер выборки, уменьшенный на количество параметров модели, оцененных по тем же данным, для регрессоров или если используется интерсепт. [19] В этом случае, поэтому знаменатель равен .

Стандартные ошибки оценок параметров определяются по формуле

При дальнейшем предположении, что ошибка популяции распределена нормально, исследователь может использовать эти оцененные стандартные ошибки для создания доверительных интервалов и проведения проверки гипотез о параметрах популяции .

В более общей модели множественной регрессии имеются независимые переменные:

где - -ое наблюдение по -ой независимой переменной. Если первая независимая переменная принимает значение 1 для всех , , то называется точкой отсечения регрессии .

Оценки параметров наименьших квадратов получаются из нормальных уравнений. Остаток можно записать как

Нормальные уравнения :

В матричной записи нормальные уравнения записываются как

где элемент равен , элемент вектора-столбца равен , а элемент равен . Таким образом , равен , равен , и равен . Решение равно

После построения регрессионной модели может быть важно подтвердить качество подгонки модели и статистическую значимость оцененных параметров. Обычно используемые проверки качества подгонки включают R-квадрат , анализы модели остатков и проверку гипотез. Статистическую значимость можно проверить с помощью F-теста общего соответствия, за которым следуют t-тесты отдельных параметров.

Интерпретации этих диагностических тестов в значительной степени опираются на предположения модели. Хотя проверка остатков может быть использована для признания модели недействительной, результаты t-теста или F-теста иногда сложнее интерпретировать, если предположения модели нарушены. Например, если член ошибки не имеет нормального распределения, в небольших выборках оцененные параметры не будут следовать нормальному распределению и усложнят вывод. Однако в случае относительно больших выборок можно вызвать центральную предельную теорему , так что проверка гипотез может продолжаться с использованием асимптотических приближений.

Ограниченные зависимые переменные , которые являются переменными отклика, являющимися категориальными переменными или переменными, ограниченными попаданием только в определенный диапазон, часто возникают в эконометрике .

Переменная отклика может быть не непрерывной («ограниченной» лежать на некотором подмножестве действительной линии). Для бинарных (ноль или одна) переменных, если анализ выполняется с помощью линейной регрессии наименьших квадратов, модель называется линейной вероятностной моделью . Нелинейные модели для бинарных зависимых переменных включают в себя пробит- и логит-модели . Многомерная пробит- модель является стандартным методом оценки совместной связи между несколькими бинарными зависимыми переменными и некоторыми независимыми переменными. Для категориальных переменных с более чем двумя значениями существует полиномиальный логит-модель . Для порядковых переменных с более чем двумя значениями существуют упорядоченные логит- и упорядоченные пробит- модели. Модели цензурированной регрессии могут использоваться, когда зависимая переменная наблюдается только иногда, а модели типа коррекции Хекмана могут использоваться, когда выборка не выбирается случайным образом из интересующей популяции. Альтернативой таким процедурам является линейная регрессия, основанная на полихорической корреляции (или полисериальных корреляциях) между категориальными переменными. Такие процедуры различаются в предположениях, сделанных относительно распределения переменных в популяции. Если переменная положительна с низкими значениями и представляет собой повторение возникновения события, то могут быть использованы модели подсчета, такие как регрессия Пуассона или отрицательная биномиальная модель.

Когда модельная функция нелинейна по параметрам, сумма квадратов должна быть минимизирована итеративной процедурой. Это вносит много осложнений, которые суммированы в Различия между линейными и нелинейными наименьшими квадратами .

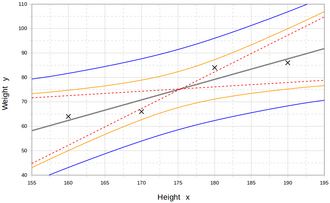

Регрессионные модели предсказывают значение переменной Y при известных значениях переменных X. Прогнозирование в пределах диапазона значений в наборе данных, используемом для подгонки модели, неформально известно как интерполяция . Прогнозирование за пределами этого диапазона данных известно как экстраполяция . Выполнение экстраполяции в значительной степени зависит от предположений регрессии. Чем дальше экстраполяция выходит за пределы данных, тем больше возможностей для сбоя модели из-за различий между предположениями и данными выборки или истинными значениями.

Интервал прогнозирования , который представляет неопределенность, может сопровождать точечный прогноз. Такие интервалы имеют тенденцию быстро расширяться, когда значения независимой переменной (переменных) выходят за пределы диапазона, охватываемого наблюдаемыми данными.

По этим и другим причинам некоторые склонны говорить, что было бы неразумно проводить экстраполяцию. [21]

Однако это не охватывает весь набор ошибок моделирования, которые могут быть сделаны: в частности, предположение о конкретной форме для связи между Y и X. Правильно проведенный регрессионный анализ будет включать оценку того, насколько хорошо предполагаемая форма соответствует наблюдаемым данным, но он может сделать это только в пределах диапазона значений фактически доступных независимых переменных. Это означает, что любая экстраполяция особенно зависит от предположений, сделанных относительно структурной формы регрессионной связи. Если это знание включает тот факт, что зависимая переменная не может выйти за пределы определенного диапазона значений, это можно использовать при выборе модели — даже если наблюдаемый набор данных не имеет значений, особенно близких к таким границам. Последствия этого шага выбора подходящей функциональной формы для регрессии могут быть значительными, когда рассматривается экстраполяция. Как минимум, он может гарантировать, что любая экстраполяция, вытекающая из подобранной модели, является «реалистичной» (или соответствует тому, что известно).

Не существует общепринятых методов для связи числа наблюдений с числом независимых переменных в модели. Один из методов, предложенных Гудом и Хардином, заключается в следующем: , где — размер выборки, — число независимых переменных, — число наблюдений, необходимое для достижения желаемой точности, если бы модель имела только одну независимую переменную. [22] Например, исследователь строит линейную регрессионную модель, используя набор данных, содержащий 1000 пациентов ( ). Если исследователь решает, что для точного определения прямой линии необходимо пять наблюдений ( ), то максимальное число независимых переменных, которое может поддерживать модель, равно 4, поскольку

Хотя параметры регрессионной модели обычно оцениваются с помощью метода наименьших квадратов, используются и другие методы, в том числе:

Все основные статистические программные пакеты выполняют регрессионный анализ наименьших квадратов и вывод. Простая линейная регрессия и множественная регрессия с использованием наименьших квадратов могут быть выполнены в некоторых приложениях электронных таблиц и на некоторых калькуляторах. Хотя многие статистические программные пакеты могут выполнять различные типы непараметрической и надежной регрессии, эти методы менее стандартизированы. Различные программные пакеты реализуют различные методы, и метод с заданным именем может быть реализован по-разному в различных пакетах. Специализированное регрессионное программное обеспечение было разработано для использования в таких областях, как анализ опросов и нейровизуализация.