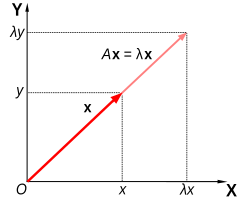

В линейной алгебре собственный вектор ( / ˈ aɪ ɡ ən -/ EYE -gən- ) или характеристический вектор — это вектор , направление которого не изменяется при заданном линейном преобразовании . Точнее, собственный вектор , линейного преобразования , масштабируется постоянным множителем , , когда к нему применяется линейное преобразование: . Часто важно знать эти векторы в линейной алгебре. Соответствующее собственное значение , характеристическое значение или характеристический корень — это множитель .

Геометрически векторы — это многомерные величины с величиной и направлением, часто изображаемые в виде стрелок. Линейное преобразование вращает , растягивает или сдвигает векторы, на которые оно действует. Его собственные векторы — это те векторы, которые только растягиваются, без вращения или сдвига. Соответствующее собственное значение — это коэффициент, на который собственный вектор растягивается или сжимается. Если собственное значение отрицательно, направление собственного вектора меняется на противоположное. [1]

Собственные векторы и собственные значения линейного преобразования служат для его характеристики, и поэтому они играют важную роль во всех областях, где применяется линейная алгебра, от геологии до квантовой механики . В частности, часто бывает так, что система представлена линейным преобразованием, выходные данные которого подаются в качестве входных данных для того же преобразования ( обратная связь ). В таком приложении наибольшее собственное значение имеет особое значение, поскольку оно управляет долгосрочным поведением системы после многих применений линейного преобразования, а связанный с ним собственный вектор является устойчивым состоянием системы.

Рассмотрим матрицу A и ненулевой вектор длины Если умножение A на (обозначается как ) просто масштабируется на коэффициент λ , где λ — скаляр , то называется собственным вектором A , а λ — соответствующим собственным значением. Это соотношение можно выразить как: . [2]

Существует прямое соответствие между квадратными матрицами n -на- n и линейными преобразованиями из n -мерного векторного пространства в себя, при условии любого базиса векторного пространства. Следовательно, в конечномерном векторном пространстве эквивалентно определять собственные значения и собственные векторы, используя либо язык матриц , либо язык линейных преобразований. [3] [4]

В следующем разделе представлена более общая точка зрения, которая охватывает также бесконечномерные векторные пространства .

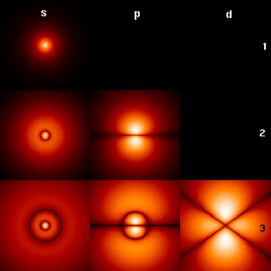

Собственные значения и собственные векторы играют важную роль в анализе линейных преобразований. Префикс eigen- заимствован из немецкого слова eigen ( родственного английскому слову own ) для «собственный», «характеристический», «собственный». [5] [6] Первоначально используемые для изучения главных осей вращательного движения твердых тел , собственные значения и собственные векторы имеют широкий спектр приложений, например, в анализе устойчивости , анализе вибрации , атомных орбиталях , распознавании лиц и диагонализации матриц .

По сути, собственный вектор v линейного преобразования T — это ненулевой вектор, который при применении к нему T не меняет направления. Применение T к собственному вектору только масштабирует собственный вектор на скалярное значение λ , называемое собственным значением. Это условие можно записать в виде уравнения, называемого уравнением собственного значения или собственным уравнением . В общем случае λ может быть любым скаляром . Например, λ может быть отрицательным, и в этом случае собственный вектор меняет направление как часть масштабирования, или он может быть нулевым или комплексным .

Пример здесь, основанный на Моне Лизе , дает простую иллюстрацию. Каждая точка на картине может быть представлена как вектор, указывающий из центра картины в эту точку. Линейное преобразование в этом примере называется сдвиговым отображением . Точки в верхней половине перемещаются вправо, а точки в нижней половине перемещаются влево, пропорционально тому, насколько далеко они находятся от горизонтальной оси, проходящей через середину картины. Векторы, указывающие на каждую точку на исходном изображении, поэтому наклоняются вправо или влево и становятся длиннее или короче в результате преобразования. Точки вдоль горизонтальной оси вообще не перемещаются при применении этого преобразования. Следовательно, любой вектор, который указывает прямо вправо или влево без вертикальной составляющей, является собственным вектором этого преобразования, потому что отображение не меняет его направления. Более того, все эти собственные векторы имеют собственное значение, равное единице, потому что отображение также не меняет их длину.

Линейные преобразования могут принимать множество различных форм, отображая векторы в различных векторных пространствах, поэтому собственные векторы также могут принимать множество форм. Например, линейное преобразование может быть дифференциальным оператором , например , в этом случае собственные векторы являются функциями, называемыми собственными функциями , которые масштабируются этим дифференциальным оператором, например Альтернативно, линейное преобразование может принимать форму матрицы n на n , в этом случае собственные векторы являются матрицами n на 1. Если линейное преобразование выражено в виде матрицы n на n A , то уравнение собственных значений для линейного преобразования выше можно переписать как умножение матриц , где собственный вектор v является матрицей n на 1. Для матрицы собственные значения и собственные векторы могут быть использованы для разложения матрицы — например, путем ее диагонализации .

Собственные значения и собственные векторы порождают множество тесно связанных математических понятий, и при их наименовании обычно используется префикс «собственный» :

Собственные значения часто вводятся в контексте линейной алгебры или теории матриц . Однако исторически они возникли при изучении квадратичных форм и дифференциальных уравнений .

В XVIII веке Леонард Эйлер изучал вращательное движение твердого тела и открыл важность главных осей . [a] Жозеф-Луи Лагранж понял, что главные оси являются собственными векторами матрицы инерции. [10]

В начале 19 века Огюстен-Луи Коши увидел, как их работа может быть использована для классификации квадратных поверхностей , и обобщил ее на произвольные измерения. [11] Коши также ввел термин racine caractéristique (характеристический корень) для того, что теперь называется собственным значением ; его термин сохранился в характеристическом уравнении . [b]

Позже Жозеф Фурье использовал работу Лагранжа и Пьера-Симона Лапласа для решения уравнения теплопроводности методом разделения переменных в своей знаменитой книге 1822 года «Аналитическая теория тепла» . [12] Шарль-Франсуа Штурм развил идеи Фурье дальше и привлек к ним внимание Коши, который объединил их со своими собственными идеями и пришел к тому факту, что действительные симметричные матрицы имеют действительные собственные значения. [11] Это было распространено Шарлем Эрмитом в 1855 году на то, что сейчас называется эрмитовыми матрицами . [13]

Примерно в то же время Франческо Бриоски доказал, что собственные значения ортогональных матриц лежат на единичной окружности , [11] а Альфред Клебш нашел соответствующий результат для кососимметричных матриц . [13] Наконец, Карл Вейерштрасс прояснил важный аспект в теории устойчивости, начатой Лапласом, поняв, что дефектные матрицы могут вызывать нестабильность. [11]

В то же время Жозеф Лиувилль изучал проблемы собственных значений, подобные проблемам Штурма; дисциплина, которая выросла из их работы, теперь называется теорией Штурма–Лиувилля . [14] Шварц изучал первое собственное значение уравнения Лапласа в общих областях к концу 19-го века, в то время как Пуанкаре изучал уравнение Пуассона несколько лет спустя. [15]

В начале 20-го века Давид Гильберт изучал собственные значения интегральных операторов , рассматривая операторы как бесконечные матрицы. [16] Он был первым, кто использовал немецкое слово eigen , что означает «собственный», [6] для обозначения собственных значений и собственных векторов в 1904 году, [c] хотя он, возможно, следовал связанному использованию Германа фон Гельмгольца . Некоторое время стандартным термином в английском языке было «собственное значение», но более характерный термин «собственное значение» является стандартным сегодня. [17]

Первый численный алгоритм для вычисления собственных значений и собственных векторов появился в 1929 году, когда Рихард фон Мизес опубликовал степенной метод . Один из самых популярных методов сегодня, алгоритм QR , был предложен независимо Джоном ГФ Фрэнсисом [18] и Верой Кублановской [19] в 1961 году. [20] [21]

Собственные значения и собственные векторы часто представляются студентам в контексте курсов линейной алгебры, посвященных матрицам. [22] [23] Кроме того, линейные преобразования в конечномерном векторном пространстве могут быть представлены с помощью матриц, [3] [4], что особенно распространено в числовых и вычислительных приложениях. [24]

Рассмотрим n -мерные векторы, сформированные как список из n скаляров, например, трехмерные векторы

Говорят, что эти векторы являются скалярными кратными друг другу, параллельными или коллинеарными , если существует скаляр λ такой, что

В этом случае, .

Теперь рассмотрим линейное преобразование n -мерных векторов, определяемое матрицей A размером n на n , или где для каждой строки

Если окажется, что v и w являются скалярными множителями, то есть если

тогда v — собственный вектор линейного преобразования A , а масштабный коэффициент λ — собственное значение, соответствующее этому собственному вектору. Уравнение ( 1 ) — это уравнение собственных значений для матрицы A.

Уравнение ( 1 ) можно эквивалентно записать как

где I — единичная матрица размером n на n , а 0 — нулевой вектор.

Уравнение ( 2 ) имеет ненулевое решение v тогда и только тогда, когда определитель матрицы ( A − λI ) равен нулю. Поэтому собственные значения A являются значениями λ , которые удовлетворяют уравнению

Используя формулу Лейбница для определителей , левая часть уравнения ( 3 ) является полиномиальной функцией переменной λ , а степень этого полинома равна n , порядку матрицы A. Ее коэффициенты зависят от элементов матрицы A , за исключением того, что ее член степени n всегда равен (−1) n λ n . Этот полином называется характеристическим полиномом матрицы A. Уравнение ( 3 ) называется характеристическим уравнением или секулярным уравнением матрицы A.

Основная теорема алгебры подразумевает, что характеристический многочлен матрицы A размером n на n , будучи многочленом степени n , может быть разложен на множители n линейных членов:

где каждое λ i может быть действительным, но в общем случае является комплексным числом. Числа λ 1 , λ 2 , ..., λ n , которые могут не все иметь различные значения, являются корнями многочлена и являются собственными значениями A .

В качестве краткого примера, который более подробно описан в разделе примеров далее, рассмотрим матрицу

Взяв определитель ( A − λI ) , характеристический многочлен A равен

Приравнивая характеристический многочлен к нулю, он имеет корни при λ=1 и λ=3 , которые являются двумя собственными значениями A. Собственные векторы, соответствующие каждому собственному значению, можно найти, решив для компонентов v в уравнении . В этом примере собственные векторы — это любые ненулевые скалярные кратные

Если все элементы матрицы A являются действительными числами, то коэффициенты характеристического многочлена также будут действительными числами, но собственные значения могут по-прежнему иметь ненулевые мнимые части. Элементы соответствующих собственных векторов, следовательно, также могут иметь ненулевые мнимые части. Аналогично, собственные значения могут быть иррациональными числами, даже если все элементы матрицы A являются рациональными числами или даже если они все целые числа. Однако, если все элементы матрицы A являются алгебраическими числами , которые включают рациональные числа, собственные значения также должны быть алгебраическими числами.

Недействительные корни действительного многочлена с действительными коэффициентами можно сгруппировать в пары комплексно сопряженных чисел , а именно, с двумя членами каждой пары, имеющими мнимые части, которые отличаются только знаком, и одинаковую действительную часть. Если степень нечетная, то по теореме о промежуточном значении по крайней мере один из корней является действительным. Следовательно, любая действительная матрица с нечетным порядком имеет по крайней мере одно действительное собственное значение, тогда как действительная матрица с четным порядком может не иметь никаких действительных собственных значений. Собственные векторы, связанные с этими комплексными собственными значениями, также являются комплексными и также появляются в комплексно сопряженных парах.

Спектр матрицы — это список собственных значений, повторяющихся в соответствии с кратностью; в альтернативной записи — множество собственных значений с их кратностями.

Важной величиной, связанной со спектром, является максимальное абсолютное значение любого собственного значения. Это известно как спектральный радиус матрицы.

Пусть λ i — собственное значение матрицы A размером n на n . Алгебраическая кратность μ A ( λ i ) собственного значения — это его кратность как корня характеристического многочлена, то есть наибольшее целое число k, такое, что ( λ − λ i ) k делит этот многочлен нацело . [9] [25] [26]

Предположим, что матрица A имеет размерность n и d ≤ n различных собственных значений. В то время как уравнение ( 4 ) разлагает характеристический многочлен матрицы A на произведение n линейных членов с некоторыми потенциально повторяющимися членами, характеристический многочлен также может быть записан как произведение d членов, каждый из которых соответствует отдельному собственному значению и возведен в степень алгебраической кратности,

Если d = n, то правая часть является произведением n линейных членов, и это то же самое, что и уравнение ( 4 ). Размер алгебраической кратности каждого собственного значения связан с размерностью n как

Если μ A ( λ i ) = 1, то λ i называется простым собственным значением . [26] Если μ A ( λ i ) равно геометрической кратности λ i , γ A ( λ i ), определенной в следующем разделе, то λ i называется полупростым собственным значением .

Дано конкретное собственное значение λ матрицы A размером n на n , определим множество E как все векторы v, которые удовлетворяют уравнению ( 2 ),

С одной стороны, это множество является в точности ядром или нулевым пространством матрицы ( A − λI ). С другой стороны, по определению любой ненулевой вектор, удовлетворяющий этому условию, является собственным вектором A, связанным с λ . Таким образом, множество E является объединением нулевого вектора с множеством всех собственных векторов A , связанных с λ , и E равно нулевому пространству ( A − λI ). E называется собственным пространством или характеристическим пространством A, связанным с λ . [27] [9] В общем случае λ является комплексным числом, а собственные векторы являются комплексными матрицами размера n на 1. Свойство нулевого пространства состоит в том, что оно является линейным подпространством , поэтому E является линейным подпространством .

Поскольку собственное пространство E является линейным подпространством, оно замкнуто относительно сложения. То есть, если два вектора u и v принадлежат множеству E , записанному как u , v ∈ E , то ( u + v ) ∈ E или, что эквивалентно, A ( u + v ) = λ ( u + v ) . Это можно проверить, используя дистрибутивное свойство умножения матриц. Аналогично, поскольку E является линейным подпространством, оно замкнуто относительно скалярного умножения. То есть, если v ∈ E и α является комплексным числом, ( α v ) ∈ E или, что эквивалентно, A ( α v ) = λ ( α v ) . Это можно проверить, заметив, что умножение комплексных матриц на комплексные числа коммутативно . Пока u + v и α v не равны нулю, они также являются собственными векторами A , связанными с λ .

Размерность собственного пространства E, связанного с λ , или, что эквивалентно, максимальное число линейно независимых собственных векторов, связанных с λ , называется геометрической кратностью собственного значения . Поскольку E также является нулевым пространством ( A − λI ), геометрическая кратность λ является размерностью нулевого пространства ( A − λI ), также называемой нулевым значением ( A − λI ), которая относится к размерности и рангу ( A − λI ) как

Из-за определения собственных значений и собственных векторов геометрическая кратность собственного значения должна быть не менее единицы, то есть каждое собственное значение имеет не менее одного связанного с ним собственного вектора. Более того, геометрическая кратность собственного значения не может превышать его алгебраическую кратность. Кроме того, напомним, что алгебраическая кратность собственного значения не может превышать n .

Чтобы доказать неравенство , рассмотрим, как определение геометрической кратности подразумевает существование ортонормированных собственных векторов , таких что . Поэтому мы можем найти (унитарную) матрицу, первые столбцы которой являются этими собственными векторами, а остальные столбцы могут быть любым ортонормированным набором векторов, ортогональных этим собственным векторам . Тогда имеет полный ранг и, следовательно, обратим. Оценивая , мы получаем матрицу, верхний левый блок которой является диагональной матрицей . Это можно увидеть, оценив то, что левая часть делает с базисными векторами первого столбца. Реорганизуя и добавляя с обеих сторон, мы получаем , поскольку коммутирует с . Другими словами, аналогично , и . Но из определения мы знаем, что содержит множитель , что означает, что алгебраическая кратность должна удовлетворять .

Предположим, что имеет различные собственные значения , где геометрическая кратность равна . Общая геометрическая кратность , является размерностью суммы всех собственных пространств собственных значений , или, что эквивалентно, максимальным числом линейно независимых собственных векторов . Если , то

Пусть будет произвольной матрицей комплексных чисел с собственными значениями . Каждое собственное значение появляется в этом списке раз, где — алгебраическая кратность собственного значения. Ниже приведены свойства этой матрицы и ее собственных значений:

Многие дисциплины традиционно представляют векторы как матрицы с одним столбцом, а не как матрицы с одной строкой. По этой причине слово «собственный вектор» в контексте матриц почти всегда относится к правому собственному вектору , а именно вектору- столбцу , который умножает справа матрицу в определяющем уравнении, уравнении ( 1 ),

Проблема собственных значений и собственных векторов может быть также определена для векторов- строк , которые оставили матрицу умножения . В этой формулировке определяющее уравнение имеет вид

где — скаляр, а — матрица. Любой вектор-строка, удовлетворяющий этому уравнению, называется левым собственным вектором и — его связанным собственным значением. Транспонируем это уравнение,

Сравнивая это уравнение с уравнением ( 1 ), сразу следует, что левый собственный вектор равен транспонированному правому собственному вектору с тем же собственным значением. Более того, поскольку характеристический многочлен равен характеристическому многочлену , левые и правые собственные векторы связаны с теми же собственными значениями.

Предположим, что собственные векторы матрицы A образуют базис, или, что эквивалентно, A имеет n линейно независимых собственных векторов v 1 , v 2 , ..., v n с соответствующими собственными значениями λ 1 , λ 2 , ..., λ n . Собственные значения не обязательно должны быть различными. Определим квадратную матрицу Q , столбцы которой являются n линейно независимыми собственными векторами матрицы A ,

Поскольку каждый столбец Q является собственным вектором A , правое умножение A на Q масштабирует каждый столбец Q на соответствующее ему собственное значение,

Имея это в виду, определим диагональную матрицу Λ, где каждый диагональный элемент Λ ii является собственным значением, связанным с i -м столбцом матрицы Q. Тогда

Поскольку столбцы Q линейно независимы, Q обратим. Умножая обе части уравнения справа на Q −1 ,

или вместо этого умножив обе стороны на Q −1 ,

Следовательно, A можно разложить на матрицу, составленную из ее собственных векторов, диагональную матрицу с собственными значениями вдоль диагонали и матрицу, обратную матрице собственных векторов. Это называется собственным разложением и является преобразованием подобия . Такая матрица A называется подобной диагональной матрице Λ или диагонализируемой . Матрица Q является матрицей изменения базиса преобразования подобия. По сути, матрицы A и Λ представляют одно и то же линейное преобразование, выраженное в двух разных базисах. Собственные векторы используются в качестве базиса при представлении линейного преобразования как Λ.

Наоборот, предположим, что матрица A диагонализируема. Пусть P — невырожденная квадратная матрица, такая что P −1 AP — некоторая диагональная матрица D . Умножая обе на P слева , получаем AP = PD . Таким образом, каждый столбец P должен быть собственным вектором A , собственное значение которого является соответствующим диагональным элементом D . Поскольку столбцы P должны быть линейно независимыми для того, чтобы P была обратимой, существует n линейно независимых собственных векторов A . Из этого следует, что собственные векторы A образуют базис тогда и только тогда, когда A диагонализируема.

Матрица, которая не диагонализируется, называется дефектной . Для дефектных матриц понятие собственных векторов обобщается до обобщенных собственных векторов , а диагональная матрица собственных значений обобщается до жордановой нормальной формы . Над алгебраически замкнутым полем любая матрица A имеет жорданову нормальную форму и, следовательно, допускает базис обобщенных собственных векторов и разложение в обобщенные собственные пространства .

В эрмитовом случае собственным значениям можно дать вариационную характеристику. Наибольшее собственное значение является максимальным значением квадратичной формы . Значение , которое реализует этот максимум, является собственным вектором.

Рассмотрим матрицу

Рисунок справа показывает влияние этого преобразования на координаты точек на плоскости. Собственные векторы v этого преобразования удовлетворяют уравнению ( 1 ), а значения λ , для которых определитель матрицы ( A − λI ) равен нулю, являются собственными значениями.

Используя определитель, находим характеристический многочлен A ,

Приравняв характеристический многочлен к нулю, получим корни при λ =1 и λ =3 , которые являются двумя собственными значениями A.

При λ =1 уравнение ( 2 ) принимает вид:

Любой ненулевой вектор с v 1 = − v 2 решает это уравнение. Следовательно, является собственным вектором A, соответствующим λ = 1, как и любой скалярный кратный этого вектора.

При λ =3 уравнение ( 2 ) принимает вид

Любой ненулевой вектор с v 1 = v 2 решает это уравнение. Следовательно,

является собственным вектором A, соответствующим λ = 3, как и любое скалярное кратное этого вектора.

Таким образом, векторы v λ =1 и v λ =3 являются собственными векторами матрицы A , связанными с собственными значениями λ =1 и λ =3 соответственно.

Рассмотрим матрицу

Характеристический многочлен A равен

Корни характеристического многочлена — 2, 1 и 11, которые являются единственными тремя собственными значениями A. Эти собственные значения соответствуют собственным векторам , , и , или любым их ненулевым кратным.

Рассмотрим матрицу циклической перестановки

Эта матрица сдвигает координаты вектора на одну позицию вверх и перемещает первую координату вниз. Ее характеристический полином равен 1 − λ 3 , корни которого равны , где — мнимая единица с .

Для действительного собственного значения λ 1 = 1 любой вектор с тремя равными ненулевыми элементами является собственным вектором. Например,

Для комплексно-сопряженной пары мнимых собственных значений,

Тогда и

Следовательно, два других собственных вектора A являются комплексными и имеют собственные значения λ 2 и λ 3 соответственно. Два комплексных собственных вектора также появляются в комплексно-сопряженной паре,

Матрицы с элементами только по главной диагонали называются диагональными матрицами . Собственные значения диагональной матрицы — это сами диагональные элементы. Рассмотрим матрицу

Характеристический многочлен A равен

который имеет корни λ 1 = 1 , λ 2 = 2 и λ 3 = 3. Эти корни являются диагональными элементами , а также собственными значениями A.

Каждый диагональный элемент соответствует собственному вектору, единственный ненулевой компонент которого находится в той же строке, что и этот диагональный элемент. В примере собственные значения соответствуют собственным векторам,

соответственно, а также скалярные кратные этих векторов.

Матрица, элементы которой выше главной диагонали все равны нулю, называется нижней треугольной матрицей , а матрица, элементы которой ниже главной диагонали все равны нулю, называется верхней треугольной матрицей . Как и в случае с диагональными матрицами, собственные значения треугольных матриц являются элементами главной диагонали.

Рассмотрим нижнюю треугольную матрицу,

Характеристический многочлен A равен

который имеет корни λ 1 = 1 , λ 2 = 2 и λ 3 = 3. Эти корни являются диагональными элементами , а также собственными значениями A.

Эти собственные значения соответствуют собственным векторам,

соответственно, а также скалярные кратные этих векторов.

Как и в предыдущем примере, нижняя треугольная матрица имеет характеристический многочлен, являющийся произведением ее диагональных элементов,

Корни этого многочлена, а значит и собственные значения, равны 2 и 3. Алгебраическая кратность каждого собственного значения равна 2; другими словами, они оба являются двойными корнями. Сумма алгебраических кратностей всех различных собственных значений равна μ A = 4 = n , порядок характеристического многочлена и размерность A .

С другой стороны, геометрическая кратность собственного значения 2 равна только 1, поскольку его собственное пространство охватывается всего одним вектором и, следовательно, является одномерным. Аналогично, геометрическая кратность собственного значения 3 равна 1, поскольку его собственное пространство охватывается всего одним вектором . Общая геометрическая кратность γ A равна 2, что является наименьшим возможным значением для матрицы с двумя различными собственными значениями. Геометрические кратности определяются в следующем разделе.

Для эрмитовой матрицы квадрат нормы j -го компонента нормализованного собственного вектора можно вычислить, используя только собственные значения матрицы и собственные значения соответствующей младшей матрицы , где — подматрица, образованная путем удаления j -й строки и столбца из исходной матрицы. [33] [34] [35] Это тождество также распространяется на диагонализуемые матрицы и многократно переоткрывалось в литературе. [34] [36]

Определения собственных значений и собственных векторов линейного преобразования T остаются в силе, даже если базовое векторное пространство является бесконечномерным гильбертовым или банаховым пространством . Широко используемый класс линейных преобразований, действующих на бесконечномерных пространствах, — это дифференциальные операторы на функциональных пространствах . Пусть D — линейный дифференциальный оператор на пространстве C ∞ бесконечно дифференцируемых действительных функций действительного аргумента t . Уравнение собственных значений для D — это дифференциальное уравнение

Функции, удовлетворяющие этому уравнению, являются собственными векторами D и обычно называются собственными функциями .

Рассмотрим производный оператор с уравнением на собственные значения

Это дифференциальное уравнение можно решить, умножив обе части на dt / f ( t ) и проинтегрировав . Его решение, экспоненциальная функция, является собственной функцией оператора производной. В этом случае собственная функция сама является функцией своего соответствующего собственного значения. В частности, при λ = 0 собственная функция f ( t ) является константой.

В основной статье о собственных функциях приведены и другие примеры.

Понятие собственных значений и собственных векторов естественным образом распространяется на произвольные линейные преобразования в произвольных векторных пространствах. Пусть V — любое векторное пространство над некоторым полем K скаляров , а T — линейное преобразование, отображающее V в V ,

Мы говорим, что ненулевой вектор v ∈ V является собственным вектором T тогда и только тогда, когда существует скаляр λ ∈ K такой, что

Это уравнение называется уравнением собственных значений для T , а скаляр λ является собственным значением T, соответствующим собственному вектору v . T ( v ) является результатом применения преобразования T к вектору v , тогда как λ v является произведением скаляра λ на v . [37] [38]

При заданном собственном значении λ рассмотрим множество

который является объединением нулевого вектора с множеством всех собственных векторов, связанных с λ . E называется собственным пространством или характеристическим пространством T, связанным с λ . [39]

По определению линейного преобразования,

для x , y ∈ V и α ∈ K. Следовательно, если u и v являются собственными векторами T , связанными с собственным значением λ , а именно u , v ∈ E , то

Итак, и u + v, и α v являются либо нулями, либо собственными векторами T , связанными с λ , а именно u + v , α v ∈ E , и E замкнуто относительно сложения и скалярного умножения. Собственное пространство E, связанное с λ, является, таким образом, линейным подпространством V. [40] Если это подпространство имеет размерность 1, его иногда называют собственной линией . [41]

Геометрическая кратность γ T ( λ ) собственного значения λ — это размерность собственного пространства, связанного с λ , т. е. максимальное число линейно независимых собственных векторов, связанных с этим собственным значением. [9] [26] [42] По определению собственных значений и собственных векторов, γ T ( λ ) ≥ 1, поскольку каждое собственное значение имеет по крайней мере один собственный вектор.

Собственные пространства T всегда образуют прямую сумму . Как следствие, собственные векторы различных собственных значений всегда линейно независимы. Следовательно, сумма размерностей собственных пространств не может превышать размерность n векторного пространства, на котором действует T , и не может быть более n различных собственных значений. [d]

Любое подпространство, охватываемое собственными векторами T, является инвариантным подпространством T , и ограничение T на такое подпространство диагонализуемо. Более того, если все векторное пространство V может быть охватываемо собственными векторами T , или, что эквивалентно, если прямая сумма собственных пространств, связанных со всеми собственными значениями T, является всем векторным пространством V , то базис V , называемый собственным базисом, может быть образован из линейно независимых собственных векторов T. Когда T допускает собственный базис, T диагонализуемо.

Если λ является собственным значением T , то оператор ( T − λI ) не является взаимно-однозначным , и, следовательно, его обратный оператор ( T − λI ) −1 не существует. Обратное верно для конечномерных векторных пространств, но не для бесконечномерных векторных пространств. В общем случае оператор ( T − λI ) может не иметь обратного оператора, даже если λ не является собственным значением.

По этой причине в функциональном анализе собственные значения могут быть обобщены на спектр линейного оператора T как множество всех скаляров λ, для которых оператор ( T − λI ) не имеет ограниченного обратного. Спектр оператора всегда содержит все его собственные значения, но не ограничивается ими.

Можно обобщить алгебраический объект, действующий на векторное пространство, заменив один оператор, действующий на векторное пространство, представлением алгебры – ассоциативной алгеброй, действующей на модуль . Изучение таких действий является областью теории представлений .

Представление теории веса является аналогом собственных значений, в то время как весовые векторы и весовые пространства являются аналогами собственных векторов и собственных пространств соответственно.

Собственный пучок Гекке является тензорным кратным самого себя и рассматривается в соответствии Ленглендса .

Простейшие разностные уравнения имеют вид

Решение этого уравнения относительно x относительно t находится с помощью его характеристического уравнения

которые можно найти, сложив в матричную форму набор уравнений, состоящий из вышеприведенного дифференциального уравнения и k – 1 уравнений, дающих k -мерную систему первого порядка в сложенном векторе переменных в терминах его однократно запаздывающего значения, и взяв характеристическое уравнение матрицы этой системы. Это уравнение дает k характеристических корней для использования в уравнении решения

Аналогичная процедура используется для решения дифференциального уравнения вида

Вычисление собственных значений и собственных векторов — это тема, где теория, представленная в учебниках элементарной линейной алгебры, часто очень далека от практики.

Классический метод заключается в том, чтобы сначала найти собственные значения, а затем вычислить собственные векторы для каждого собственного значения. Он в нескольких отношениях плохо подходит для неточной арифметики, такой как числа с плавающей точкой .

Собственные значения матрицы можно определить, найдя корни характеристического полинома. Это легко для матриц, но сложность быстро возрастает с размером матрицы.

Теоретически коэффициенты характеристического многочлена могут быть вычислены точно, поскольку они являются суммами произведений элементов матрицы; и существуют алгоритмы, которые могут найти все корни многочлена произвольной степени с любой требуемой точностью . [43] Однако этот подход нежизнеспособен на практике, поскольку коэффициенты будут загрязнены неизбежными ошибками округления , а корни многочлена могут быть чрезвычайно чувствительной функцией коэффициентов (как показано на примере многочлена Уилкинсона ). [43] Даже для матриц, элементы которых являются целыми числами, вычисление становится нетривиальным, поскольку суммы очень длинные; постоянный член является определителем , который для матрицы является суммой различных произведений. [e]

Явные алгебраические формулы для корней многочлена существуют только если степень равна 4 или меньше. Согласно теореме Абеля–Руффини не существует общей, явной и точной алгебраической формулы для корней многочлена степени 5 или больше. (Общность имеет значение, поскольку любой многочлен степени является характеристическим многочленом некоторой сопутствующей матрицы порядка .) Поэтому для матриц порядка 5 или больше собственные значения и собственные векторы не могут быть получены явной алгебраической формулой и поэтому должны вычисляться приближенными численными методами . Даже точная формула для корней многочлена степени 3 численно непрактична.

Как только (точное) значение собственного значения известно, соответствующие собственные векторы могут быть найдены путем нахождения ненулевых решений уравнения собственных значений, которое становится системой линейных уравнений с известными коэффициентами. Например, как только известно, что 6 является собственным значением матрицы

мы можем найти его собственные векторы, решив уравнение , то есть

Это матричное уравнение эквивалентно двум линейным уравнениям , то есть

Оба уравнения сводятся к одному линейному уравнению . Следовательно, любой вектор вида , для любого ненулевого действительного числа , является собственным вектором с собственным значением .

Матрица выше имеет еще одно собственное значение . Аналогичное вычисление показывает, что соответствующие собственные векторы являются ненулевыми решениями , то есть любым вектором вида , для любого ненулевого действительного числа .

Обратный подход, сначала поиск собственных векторов, а затем определение каждого собственного значения из его собственного вектора, оказывается гораздо более податливым для компьютеров. Самый простой алгоритм здесь состоит в выборе произвольного начального вектора и последующем многократном умножении его на матрицу (опционально нормализуя вектор, чтобы сохранить его элементы разумного размера); это заставляет вектор сходиться к собственному вектору. Вариация заключается в том, чтобы вместо этого умножить вектор на ; это заставляет его сходиться к собственному вектору собственного значения, ближайшего к .

Если является (хорошим приближением) собственным вектором , то соответствующее собственное значение можно вычислить как

где обозначает сопряженное транспонирование .

Эффективные и точные методы вычисления собственных значений и собственных векторов произвольных матриц не были известны до тех пор, пока в 1961 году не был разработан алгоритм QR . [43] Объединение преобразования Хаусхолдера с LU-разложением приводит к алгоритму с лучшей сходимостью, чем у алгоритма QR. [ требуется ссылка ] Для больших эрмитовых разреженных матриц алгоритм Ланцоша является одним из примеров эффективного итеративного метода вычисления собственных значений и собственных векторов, среди нескольких других возможностей. [43]

Большинство численных методов, вычисляющих собственные значения матрицы, также определяют набор соответствующих собственных векторов как побочный продукт вычисления, хотя иногда разработчики решают отбросить информацию о собственных векторах, как только она больше не нужна.

Собственные векторы и собственные значения могут быть полезны для понимания линейных преобразований геометрических фигур. В следующей таблице представлены некоторые примеры преобразований на плоскости вместе с их матрицами 2×2, собственными значениями и собственными векторами.

Характеристическое уравнение для поворота — это квадратное уравнение с дискриминантом , которое является отрицательным числом, когда θ не является целым кратным 180°. Поэтому, за исключением этих особых случаев, два собственных значения являются комплексными числами, ; и все собственные векторы имеют недействительные элементы. Действительно, за исключением этих особых случаев, поворот изменяет направление каждого ненулевого вектора в плоскости.

A linear transformation that takes a square to a rectangle of the same area (a squeeze mapping) has reciprocal eigenvalues.

The eigendecomposition of a symmetric positive semidefinite (PSD) matrix yields an orthogonal basis of eigenvectors, each of which has a nonnegative eigenvalue. The orthogonal decomposition of a PSD matrix is used in multivariate analysis, where the sample covariance matrices are PSD. This orthogonal decomposition is called principal component analysis (PCA) in statistics. PCA studies linear relations among variables. PCA is performed on the covariance matrix or the correlation matrix (in which each variable is scaled to have its sample variance equal to one). For the covariance or correlation matrix, the eigenvectors correspond to principal components and the eigenvalues to the variance explained by the principal components. Principal component analysis of the correlation matrix provides an orthogonal basis for the space of the observed data: In this basis, the largest eigenvalues correspond to the principal components that are associated with most of the covariability among a number of observed data.

Principal component analysis is used as a means of dimensionality reduction in the study of large data sets, such as those encountered in bioinformatics. In Q methodology, the eigenvalues of the correlation matrix determine the Q-methodologist's judgment of practical significance (which differs from the statistical significance of hypothesis testing; cf. criteria for determining the number of factors). More generally, principal component analysis can be used as a method of factor analysis in structural equation modeling.

In spectral graph theory, an eigenvalue of a graph is defined as an eigenvalue of the graph's adjacency matrix , or (increasingly) of the graph's Laplacian matrix due to its discrete Laplace operator, which is either (sometimes called the combinatorial Laplacian) or (sometimes called the normalized Laplacian), where is a diagonal matrix with equal to the degree of vertex , and in , the th diagonal entry is . The th principal eigenvector of a graph is defined as either the eigenvector corresponding to the th largest or th smallest eigenvalue of the Laplacian. The first principal eigenvector of the graph is also referred to merely as the principal eigenvector.

The principal eigenvector is used to measure the centrality of its vertices. An example is Google's PageRank algorithm. The principal eigenvector of a modified adjacency matrix of the World Wide Web graph gives the page ranks as its components. This vector corresponds to the stationary distribution of the Markov chain represented by the row-normalized adjacency matrix; however, the adjacency matrix must first be modified to ensure a stationary distribution exists. The second smallest eigenvector can be used to partition the graph into clusters, via spectral clustering. Other methods are also available for clustering.

A Markov chain is represented by a matrix whose entries are the transition probabilities between states of a system. In particular the entries are non-negative, and every row of the matrix sums to one, being the sum of probabilities of transitions from one state to some other state of the system. The Perron–Frobenius theorem gives sufficient conditions for a Markov chain to have a unique dominant eigenvalue, which governs the convergence of the system to a steady state.

Eigenvalue problems occur naturally in the vibration analysis of mechanical structures with many degrees of freedom. The eigenvalues are the natural frequencies (or eigenfrequencies) of vibration, and the eigenvectors are the shapes of these vibrational modes. In particular, undamped vibration is governed byor

That is, acceleration is proportional to position (i.e., we expect to be sinusoidal in time).

In dimensions, becomes a mass matrix and a stiffness matrix. Admissible solutions are then a linear combination of solutions to the generalized eigenvalue problemwhere is the eigenvalue and is the (imaginary) angular frequency. The principal vibration modes are different from the principal compliance modes, which are the eigenvectors of alone. Furthermore, damped vibration, governed byleads to a so-called quadratic eigenvalue problem,

This can be reduced to a generalized eigenvalue problem by algebraic manipulation at the cost of solving a larger system.

The orthogonality properties of the eigenvectors allows decoupling of the differential equations so that the system can be represented as linear summation of the eigenvectors. The eigenvalue problem of complex structures is often solved using finite element analysis, but neatly generalize the solution to scalar-valued vibration problems.

In mechanics, the eigenvectors of the moment of inertia tensor define the principal axes of a rigid body. The tensor of moment of inertia is a key quantity required to determine the rotation of a rigid body around its center of mass.

In solid mechanics, the stress tensor is symmetric and so can be decomposed into a diagonal tensor with the eigenvalues on the diagonal and eigenvectors as a basis. Because it is diagonal, in this orientation, the stress tensor has no shear components; the components it does have are the principal components.

An example of an eigenvalue equation where the transformation is represented in terms of a differential operator is the time-independent Schrödinger equation in quantum mechanics:

where , the Hamiltonian, is a second-order differential operator and , the wavefunction, is one of its eigenfunctions corresponding to the eigenvalue , interpreted as its energy.

However, in the case where one is interested only in the bound state solutions of the Schrödinger equation, one looks for within the space of square integrable functions. Since this space is a Hilbert space with a well-defined scalar product, one can introduce a basis set in which and can be represented as a one-dimensional array (i.e., a vector) and a matrix respectively. This allows one to represent the Schrödinger equation in a matrix form.

The bra–ket notation is often used in this context. A vector, which represents a state of the system, in the Hilbert space of square integrable functions is represented by . In this notation, the Schrödinger equation is:

where is an eigenstate of and represents the eigenvalue. is an observable self-adjoint operator, the infinite-dimensional analog of Hermitian matrices. As in the matrix case, in the equation above is understood to be the vector obtained by application of the transformation to .

Light, acoustic waves, and microwaves are randomly scattered numerous times when traversing a static disordered system. Even though multiple scattering repeatedly randomizes the waves, ultimately coherent wave transport through the system is a deterministic process which can be described by a field transmission matrix .[44][45] The eigenvectors of the transmission operator form a set of disorder-specific input wavefronts which enable waves to couple into the disordered system's eigenchannels: the independent pathways waves can travel through the system. The eigenvalues, , of correspond to the intensity transmittance associated with each eigenchannel. One of the remarkable properties of the transmission operator of diffusive systems is their bimodal eigenvalue distribution with and .[45] Furthermore, one of the striking properties of open eigenchannels, beyond the perfect transmittance, is the statistically robust spatial profile of the eigenchannels.[46]

In quantum mechanics, and in particular in atomic and molecular physics, within the Hartree–Fock theory, the atomic and molecular orbitals can be defined by the eigenvectors of the Fock operator. The corresponding eigenvalues are interpreted as ionization potentials via Koopmans' theorem. In this case, the term eigenvector is used in a somewhat more general meaning, since the Fock operator is explicitly dependent on the orbitals and their eigenvalues. Thus, if one wants to underline this aspect, one speaks of nonlinear eigenvalue problems. Such equations are usually solved by an iteration procedure, called in this case self-consistent field method. In quantum chemistry, one often represents the Hartree–Fock equation in a non-orthogonal basis set. This particular representation is a generalized eigenvalue problem called Roothaan equations.

In geology, especially in the study of glacial till, eigenvectors and eigenvalues are used as a method by which a mass of information of a clast fabric's constituents' orientation and dip can be summarized in a 3-D space by six numbers. In the field, a geologist may collect such data for hundreds or thousands of clasts in a soil sample, which can only be compared graphically such as in a Tri-Plot (Sneed and Folk) diagram,[47][48] or as a Stereonet on a Wulff Net.[49]

The output for the orientation tensor is in the three orthogonal (perpendicular) axes of space. The three eigenvectors are ordered by their eigenvalues ;[50] then is the primary orientation/dip of clast, is the secondary and is the tertiary, in terms of strength. The clast orientation is defined as the direction of the eigenvector, on a compass rose of 360°. Dip is measured as the eigenvalue, the modulus of the tensor: this is valued from 0° (no dip) to 90° (vertical). The relative values of , , and are dictated by the nature of the sediment's fabric. If , the fabric is said to be isotropic. If , the fabric is said to be planar. If , the fabric is said to be linear.[51]

The basic reproduction number () is a fundamental number in the study of how infectious diseases spread. If one infectious person is put into a population of completely susceptible people, then is the average number of people that one typical infectious person will infect. The generation time of an infection is the time, , from one person becoming infected to the next person becoming infected. In a heterogeneous population, the next generation matrix defines how many people in the population will become infected after time has passed. The value is then the largest eigenvalue of the next generation matrix.[52][53]

In image processing, processed images of faces can be seen as vectors whose components are the brightnesses of each pixel.[54] The dimension of this vector space is the number of pixels. The eigenvectors of the covariance matrix associated with a large set of normalized pictures of faces are called eigenfaces; this is an example of principal component analysis. They are very useful for expressing any face image as a linear combination of some of them. In the facial recognition branch of biometrics, eigenfaces provide a means of applying data compression to faces for identification purposes. Research related to eigen vision systems determining hand gestures has also been made.

Similar to this concept, eigenvoices represent the general direction of variability in human pronunciations of a particular utterance, such as a word in a language. Based on a linear combination of such eigenvoices, a new voice pronunciation of the word can be constructed. These concepts have been found useful in automatic speech recognition systems for speaker adaptation.

![]() Wikiversity uses introductory physics to introduce Eigenvalues and eigenvectors

Wikiversity uses introductory physics to introduce Eigenvalues and eigenvectors