Технологическая сингулярность — или просто сингулярность [1] — это гипотетический момент будущего времени, в котором технологический рост станет неконтролируемым и необратимым, что приведет к непредвиденным последствиям для человеческой цивилизации. [2] [3] Согласно самой популярной версии гипотезы сингулярности, модели взрыва интеллекта И. Дж. Гуда , обновляемый интеллектуальный агент в конечном итоге вступит в «безудержную реакцию» циклов самосовершенствования, при этом появляется каждое новое, более интеллектуальное поколение. все быстрее и быстрее, вызывая «взрыв» интеллекта и приводя к появлению мощного сверхразума , который качественно намного превосходит весь человеческий интеллект . [4]

Первым человеком, который использовал концепцию «сингулярности» в технологическом контексте, был венгерско-американский математик 20-го века Джон фон Нейман . [5] Станислав Улам сообщает в 1958 году о более ранней дискуссии с фон Нейманом, «сосредоточенной на ускоряющемся прогрессе технологий и изменениях в образе человеческой жизни, что создает видимость приближения к некоторой существенной сингулярности в истории расы, за пределами которой человеческие дела в том виде, в каком мы их знаем, не могло продолжаться». [6] Последующие авторы поддержали эту точку зрения. [3] [7]

Концепция и термин «сингулярность» были популяризированы Вернором Винджем впервые в 1983 году в статье, в которой утверждалось, что как только люди создадут интеллект, превосходящий их собственный, произойдет технологический и социальный переход, в некотором смысле похожий на «завязанное пространство-время». в центре черной дыры», [8] и позже в своем эссе 1993 года « Грядущая технологическая сингулярность» , [4] [7] , в котором он писал, что это будет сигнализировать о конце человеческой эры, поскольку новый сверхразум будет продолжать существовать. модернизировать себя и будет развиваться технологически с непостижимой скоростью. Он написал, что был бы удивлен, если бы это произошло до 2005 года или после 2030 года. [4] Еще одним важным вкладом в более широкое распространение этой идеи стала книга Рэя Курцвейла 2005 года «Сингулярность близка» , в которой сингулярность предсказывается к 2045 году. [7]

Некоторые ученые, в том числе Стивен Хокинг , выразили обеспокоенность тем, что искусственный сверхинтеллект (ИСИ) может привести к вымиранию человечества. [9] [10] Последствия сингулярности и ее потенциальная польза или вред для человечества активно обсуждаются.

Выдающиеся технологи и ученые оспаривают правдоподобие технологической сингулярности и связанного с ней взрыва искусственного интеллекта, в том числе Пол Аллен , [11] Джефф Хокинс , [12] Джон Холланд , Джарон Ланье , Стивен Пинкер , [12] Теодор Модис , [13] и Гордон Мур . [12] Одно из заявлений заключалось в том, что рост искусственного интеллекта, скорее всего, приведет к снижению отдачи, а не к ускорению, как это наблюдалось в ранее разработанных человеческих технологиях.

Хотя технологический прогресс ускоряется в большинстве областей, он ограничен базовым интеллектом человеческого мозга, который, по мнению Пола Р. Эрлиха , существенно не изменился за тысячелетия. [14] Однако с ростом мощности компьютеров и других технологий, в конечном итоге, возможно, станет возможным построить машину, которая будет значительно умнее человека. [15]

Если бы был изобретен сверхчеловеческий интеллект – либо путем усиления человеческого интеллекта , либо посредством искусственного интеллекта – он значительно улучшил бы человеческие навыки решения проблем и изобретательства. Такой ИИ называется « начальным ИИ» [16] [17] , потому что, если бы ИИ был создан с инженерными возможностями, которые соответствовали бы или превосходили возможности его создателей-людей, у него был бы потенциал автономно улучшать свое собственное программное и аппаратное обеспечение для разработки еще более способная машина, которая могла бы повторять этот процесс по очереди. Это рекурсивное самосовершенствование может ускориться, потенциально допуская огромные качественные изменения до того, как будут установлены верхние пределы, налагаемые законами физики или теоретическими вычислениями. Предполагается, что за многие итерации такой ИИ значительно превзойдет человеческие когнитивные способности .

И. Дж. Гуд предположил в 1965 году, что сверхчеловеческий интеллект может вызвать интеллектуальный взрыв: [18] [19]

Пусть сверхразумная машина будет определена как машина, которая может намного превзойти всю интеллектуальную деятельность любого человека, каким бы умным он ни был. Поскольку проектирование машин является одним из видов интеллектуальной деятельности, сверхразумная машина могла бы создавать машины еще лучше; тогда, несомненно, произойдет «интеллектуальный взрыв», и человеческий интеллект останется далеко позади. Таким образом, первая сверхразумная машина — это последнее изобретение, которое человек когда-либо сможет сделать, при условии, что машина будет достаточно послушной, чтобы рассказать нам, как держать ее под контролем.

Одна из версий интеллектуального взрыва заключается в том, что вычислительная мощность приближается к бесконечности за конечный промежуток времени. В этой версии, как только ИИ проводит исследование, чтобы улучшить себя, скорость удваивается, например, через 2 года, затем 1 год, затем 6 месяцев, затем 3 месяца, затем 1,5 месяца и т. д., где бесконечная сумма периодов удвоения равна 4. годы. Если бы этому процессу не препятствовали физические ограничения вычислений и квантования времени, этот процесс буквально достиг бы бесконечной вычислительной мощности за 4 года, что заслужило название «сингулярность» для конечного состояния. Эта форма интеллектуального взрыва описана Юдковски (1996). [20]

Сверхинтеллект, гиперинтеллект или сверхчеловеческий интеллект — это гипотетический агент , обладающий интеллектом, намного превосходящим интеллект самых ярких и одаренных человеческих умов. «Сверхинтеллект» может также относиться к форме или степени интеллекта, которым обладает такой агент. Джон фон Нейман , Вернор Виндж и Рэй Курцвейл определяют эту концепцию с точки зрения технологического создания сверхразума, утверждая, что современным людям трудно или невозможно предсказать, какой будет жизнь людей в постсингулярном мире. . [4] [21]

Сопутствующая концепция «скоростной сверхинтеллект» описывает ИИ, который может функционировать как человеческий разум, только намного быстрее. [22] Например, при увеличении скорости обработки информации в миллион раз по сравнению со скоростью человека субъективный год пройдет за 30 физических секунд. [23] Такая разница в скорости обработки информации может привести к возникновению сингулярности. [24]

Технологические прогнозисты и исследователи расходятся во мнениях относительно того, когда и будет ли превзойден человеческий интеллект. Некоторые утверждают, что достижения в области искусственного интеллекта (ИИ), вероятно, приведут к созданию систем общего мышления, которые обходят когнитивные ограничения человека. Другие полагают, что люди будут эволюционировать или напрямую модифицировать свою биологию, чтобы достичь радикально большего интеллекта. [25] [26] Ряд исследований будущего сосредоточен на сценариях, которые сочетают в себе эти возможности, предполагая, что люди, вероятно, будут взаимодействовать с компьютерами или загружать свои мысли в компьютеры таким образом, что это позволит существенно усилить интеллект. В книге Робина Хэнсона «Эра эмов» описывается гипотетический сценарий будущего, в котором человеческий мозг будет сканироваться и оцифровываться, создавая «загрузки» или цифровые версии человеческого сознания. В этом будущем развитие этих загрузок может предшествовать или совпадать с появлением сверхразумного искусственного интеллекта. [27]

Некоторые авторы используют слово «сингулярность» в более широком смысле для обозначения любых радикальных изменений в обществе, вызванных новыми технологиями (такими как молекулярные нанотехнологии ), [28] [29] [30] , хотя Виндж и другие авторы прямо заявляют, что без сверхинтеллекта , такие изменения не будут квалифицироваться как истинная сингулярность. [4]

В 1965 году И. Дж. Гуд писал, что более вероятно, чем нет, что в двадцатом веке будет построена сверхразумная машина. [18] В 1993 году Виндж предсказал, что в период с 2005 по 2030 год интеллект будет превосходить человеческий. [4] В 1996 году Юдковский предсказал сингулярность в 2021 году. [20] В 2005 году Курцвейл предсказал, что ИИ человеческого уровня появится примерно в 2029 году, [31] и сингулярность в 2045 году. [32] В интервью 2017 года Курцвейл подтвердил свои оценки. [ 33 ] В 1988 году Моравец предсказал, что, если темпы совершенствования будут продолжаться, вычислительные возможности для ИИ человеческого уровня будут доступны на суперкомпьютерах до 2010 года . за пределами человека к 2050 году. [35]

Четыре опроса исследователей ИИ, проведенные в 2012 и 2013 годах Ником Бостромом и Винсентом К. Мюллером , показали 50% уверенность в том, что ИИ человеческого уровня будет разработан к 2040–2050 годам. [36] [37]

Выдающиеся технологи и ученые оспаривают правдоподобие технологической сингулярности, в том числе Пол Аллен , [11] Джефф Хокинс , [12] Джон Холланд , Джарон Ланье , Стивен Пинкер , [12] Теодор Модис , [13] и Гордон Мур , [12] закон которого часто цитируется в поддержку этой концепции. [38]

Большинство предлагаемых методов создания сверхчеловеческого или сверхчеловеческого разума попадают в одну из двух категорий: усиление интеллекта человеческого мозга и искусственный интеллект. Многие предполагаемые способы увеличения человеческого интеллекта включают биоинженерию , генную инженерию , ноотропные препараты, помощников искусственного интеллекта, прямые интерфейсы мозг-компьютер и загрузку разума . Эти многочисленные возможные пути к взрыву интеллекта, каждый из которых, предположительно, будет использован, делают сингулярность более вероятной. [23]

Робин Хэнсон выразил скептицизм по поводу увеличения человеческого интеллекта, написав, что как только «легкие плоды» простых методов повышения человеческого интеллекта будут исчерпаны, дальнейшие улучшения станут все более трудными. [39] Несмотря на все предполагаемые способы усиления человеческого интеллекта, нечеловеческий искусственный интеллект (в частности, начальный ИИ) является наиболее популярным вариантом среди гипотез, продвигающих сингулярность. [ нужна цитата ]

Возможность интеллектуального взрыва зависит от трех факторов. [40] Первым ускоряющим фактором являются новые улучшения интеллекта, ставшие возможными благодаря каждому предыдущему усовершенствованию. И наоборот, по мере того, как интеллект становится более продвинутым, дальнейшие достижения будут становиться все более и более сложными, возможно, перевешивая преимущества возросшего интеллекта. Каждое улучшение должно в среднем порождать как минимум еще одно улучшение, чтобы движение к сингулярности продолжалось. Наконец, законы физики могут в конечном итоге помешать дальнейшему улучшению.

Есть две логически независимые, но взаимодополняющие причины улучшения интеллекта: увеличение скорости вычислений и улучшение используемых алгоритмов . [7] Первое предсказано законом Мура и прогнозируемыми улучшениями в оборудовании, [41] и сравнительно похоже на предыдущие технологические достижения. Но Шульман и Сандберг [42] утверждают, что программное обеспечение будет представлять собой более сложные задачи, чем просто работа на оборудовании, способном работать на уровне человеческого интеллекта или выше.

В ходе электронного опроса авторов, опубликовавших публикации на конференциях по машинному обучению NeurIPS и ICML в 2017 году , был задан вопрос о вероятности того, что «аргумент о взрывном интеллекте в целом верен». Из респондентов 12% сказали, что это «вполне вероятно», 17% сказали, что это «вероятно», 21% сказали, что это «примерно равно», 24% сказали, что это «маловероятно», и 26% сказали, что это «весьма маловероятно». ". [43]

Как для человеческого, так и для искусственного интеллекта, усовершенствования аппаратного обеспечения увеличивают скорость будущих улучшений аппаратного обеспечения. Аналогия с законом Мура предполагает, что если первое удвоение скорости заняло 18 месяцев, то второе субъективно займет 18 месяцев; или 9 внешних месяцев, затем четыре месяца, два месяца и так далее до сингулярности скорости. [44] [20] Со временем может быть достигнут некоторый верхний предел скорости. Джефф Хокинс заявил, что самосовершенствующаяся компьютерная система неизбежно столкнется с верхним пределом вычислительной мощности: «В конце концов, есть пределы тому, насколько большие и быстрые компьютеры могут работать. Мы окажемся в одном и том же месте; мы просто доберитесь туда немного быстрее. Сингулярности не будет». [12]

Трудно напрямую сравнивать кремниевую аппаратуру с нейронами . Но Берглас (2008) отмечает, что компьютерное распознавание речи приближается к возможностям человека и что для этой возможности требуется 0,01% объема мозга. Эта аналогия предполагает, что современное компьютерное оборудование на несколько порядков превосходит по мощности человеческий мозг .

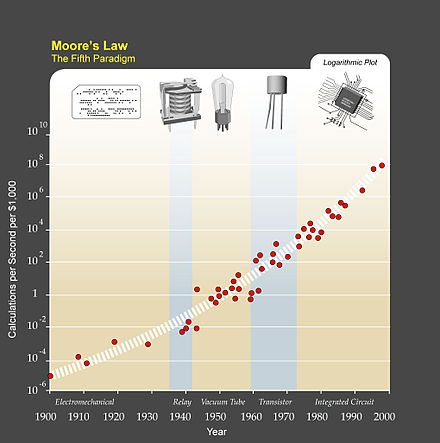

Экспоненциальный рост вычислительных технологий, предполагаемый законом Мура, обычно упоминается как причина ожидать сингулярности в относительно ближайшем будущем, и ряд авторов предложили обобщения закона Мура. Ученый-компьютерщик и футуролог Ганс Моравец в книге 1998 года [45] предположил , что кривую экспоненциального роста можно расширить с помощью более ранних вычислительных технологий, предшествовавших появлению интегральных схем .

Рэй Курцвейл постулирует закон ускоряющейся отдачи , согласно которому скорость технологических изменений (и, в более общем плане, всех эволюционных процессов [46] ) возрастает экспоненциально, обобщая закон Мура таким же образом, как и предложение Моравека, а также включая материальные технологии (особенно в прикладном смысле). к нанотехнологиям ), медицинским технологиям и другим. [47] В период с 1986 по 2007 год производительность машин для вычисления информации на душу населения примерно удваивалась каждые 14 месяцев; мощность компьютеров общего назначения в мире удваивалась каждые 18 месяцев; глобальная пропускная способность телекоммуникаций на душу населения удваивалась каждые 34 месяца; а вместимость мировых хранилищ на душу населения удваивалась каждые 40 месяцев. [48] С другой стороны, утверждалось, что модель глобального ускорения, имеющая в качестве параметра сингулярность XXI века, должна характеризоваться как гиперболическая , а не экспоненциальная. [49]

Курцвейл оставляет термин «сингулярность» для быстрого роста искусственного интеллекта (в отличие от других технологий), написав, например, что «Сингулярность позволит нам преодолеть эти ограничения наших биологических тел и мозга… Не будет никакого различия». , постсингулярность, между человеком и машиной». [50] Он также определяет свою предсказанную дату сингулярности (2045 год) с точки зрения того, когда он ожидает, что компьютерный интеллект значительно превысит общую сумму человеческих умственных способностей, написав, что достижения в области вычислений до этой даты «не будут представлять сингулярность». потому что они «еще не соответствуют глубокому расширению нашего интеллекта». [51]

Некоторые сторонники сингулярности доказывают ее неизбежность, экстраполируя прошлые тенденции, особенно те, которые касаются сокращения разрыва между усовершенствованиями технологий. В одном из первых случаев использования термина «сингулярность» в контексте технического прогресса Станислав Улам рассказывает о разговоре с Джоном фон Нейманом об ускорении изменений:

Один разговор был посвящен постоянно ускоряющемуся прогрессу технологий и изменениям в образе человеческой жизни, что создает видимость приближения к какой-то существенной сингулярности в истории расы, за пределами которой человеческие дела, какими мы их знаем, не могут продолжаться. [6]

Курцвейл утверждает, что технологический прогресс следует модели экспоненциального роста , следуя тому, что он называет « законом ускоряющейся отдачи ». Курцвейл пишет, что всякий раз, когда технология приближается к барьеру, новые технологии преодолеют его. Он предсказывает, что смена парадигм будет становиться все более распространенной, что приведет к «технологическим изменениям, настолько быстрым и глубоким, что они представляют собой разрыв в ткани человеческой истории». [52] Курцвейл считает, что сингулярность произойдет примерно к 2045 году. [47] Его предсказания отличаются от предсказаний Винджа тем, что он предсказывает постепенное восхождение к сингулярности, а не быстро самосовершенствующийся сверхчеловеческий интеллект Винджа.

Часто упоминаемые опасности включают те, которые обычно связаны с молекулярными нанотехнологиями и генной инженерией . Эти угрозы представляют собой серьезную проблему как для сторонников сингулярности, так и для критиков, и они стали темой статьи Билла Джоя в журнале Wired в апреле 2000 года « Почему будущее не нуждается в нас ». [7] [53]

Некоторые интеллектуальные технологии, такие как «исходный искусственный интеллект» [16] [17], также могут иметь потенциал не только стать быстрее, но и более эффективными за счет изменения их исходного кода . Эти улучшения сделают возможными дальнейшие улучшения, которые сделают возможными дальнейшие улучшения и так далее.

Механизм рекурсивно самоулучшающегося набора алгоритмов отличается от увеличения скорости вычислений двумя способами. Во-первых, это не требует внешнего влияния: машины, проектирующие более быстрое оборудование, все равно потребуют от людей создания улучшенного оборудования или соответствующего программирования заводов. [ нужна цитата ] ИИ, переписывающий свой собственный исходный код, может делать это, находясь в ящике ИИ .

Во-вторых, как и в случае с концепцией сингулярности Вернора Винджа , гораздо труднее предсказать результат. Хотя увеличение скорости кажется лишь количественным отличием от человеческого интеллекта, реальные улучшения алгоритмов будут качественно иными. Элиэзер Юдковский сравнивает это с изменениями, которые принес человеческий разум: люди изменили мир в тысячи раз быстрее, чем это сделала эволюция, и совершенно разными способами. Точно так же эволюция жизни представляла собой массовое отклонение и ускорение от предыдущих геологических темпов изменений, а улучшение интеллекта могло привести к тому, что изменения снова стали такими же иными. [54]

Существуют существенные опасности, связанные с сингулярностью взрыва интеллекта, возникающей из-за рекурсивно самоулучшающегося набора алгоритмов. Во-первых, целевая структура ИИ может самомодифицироваться, что потенциально может привести к оптимизации ИИ для чего-то, отличного от того, что было изначально задумано. [55] [56]

Во-вторых, ИИ могут конкурировать за те же скудные ресурсы, которые человечество использует для выживания. [57] [58] Хотя ИИ не являются активно злонамеренными, они будут способствовать достижению целей своего программирования, а не обязательно более широким человеческим целям, и, таким образом, могут полностью вытеснить людей. [59] [60] [61]

Карл Шульман и Андерс Сандберг предполагают, что улучшение алгоритмов может быть ограничивающим фактором сингулярности; в то время как эффективность аппаратного обеспечения имеет тенденцию повышаться устойчивыми темпами, инновации в программном обеспечении более непредсказуемы и могут быть остановлены последовательными совокупными исследованиями. Они предполагают, что в случае сингулярности, ограниченной программным обеспечением, взрыв интеллекта на самом деле станет более вероятным, чем в случае сингулярности, ограниченной программным обеспечением, поскольку в случае сингулярности, ограниченной программным обеспечением, как только ИИ на человеческом уровне будет разработан, он может последовательно запускаться на очень быстрое оборудование, а обилие дешевого оборудования сделает исследования ИИ менее ограниченными. [62] Избыток накопившегося аппаратного обеспечения, которое можно высвободить, как только программное обеспечение поймет, как его использовать, называется «вычислительным избытком». [63]

Некоторые критики, такие как философ Хьюберт Дрейфус [64] и философ Джон Сирл , [65] утверждают, что компьютеры или машины не могут достичь человеческого интеллекта . Другие, например физик Стивен Хокинг , [66] возражают, что не имеет значения, смогут ли машины достичь истинного интеллекта или чего-то похожего на интеллект, если конечный результат будет тем же самым.

Психолог Стивен Пинкер заявил в 2008 году: «Нет ни малейшего основания верить в грядущую сингулярность. Тот факт, что вы можете визуализировать будущее в своем воображении, не является доказательством того, что оно вероятно или даже возможно. Посмотрите на куполообразные города, реактивные самолеты. поездки на работу, подводные города, здания высотой в милю и автомобили с атомными двигателями — все это основные элементы футуристических фантазий моего детства, которые так и не появились. Чистая вычислительная мощность — это не пикси-пыль, которая волшебным образом решает все ваши проблемы». [12]

Мартин Форд [67] постулирует «технологический парадокс», заключающийся в том, что до возникновения сингулярности большинство рутинных работ в экономике будут автоматизированы, поскольку для этого потребуется уровень технологии, более низкий, чем уровень сингулярности. Это вызовет массовую безработицу и резкое падение потребительского спроса, что, в свою очередь, уничтожит стимул инвестировать в технологии, необходимые для создания сингулярности. Смещение рабочих мест все больше не ограничивается теми видами работы, которые традиционно считаются «рутинными». [68]

Теодор Модис [69] и Джонатан Хюбнер [70] утверждают, что темпы технологических инноваций не только перестали расти, но фактически сейчас снижаются. Свидетельством этого снижения является то, что рост тактовой частоты компьютеров замедляется, хотя предсказание Мура об экспоненциальном увеличении плотности цепей продолжает оставаться в силе. Это происходит из-за чрезмерного выделения тепла от чипа, которое не может быть рассеяно достаточно быстро, чтобы предотвратить плавление чипа при работе на более высоких скоростях. Повышение скорости может стать возможным в будущем благодаря более энергоэффективным конструкциям ЦП и многоячеечным процессорам. [71]

Теодор Модис считает, что сингулярности не может быть. [72] [13] [73] Он утверждает, что «технологическая сингулярность» и особенно Курцвейлу не хватает научной строгости; Утверждается, что Курцвейл принял логистическую функцию (S-функцию) за показательную функцию и увидел «колено» в показательной функции там, где на самом деле такой вещи не может быть. [74] В статье 2021 года Модис отметил, что за предыдущие двадцать лет не наблюдалось никаких вех – прорывов в исторической перспективе, сравнимых по важности с Интернетом, ДНК, транзисторами или ядерной энергией, в то время как пять из них были бы ожидается в соответствии с экспоненциальной тенденцией, которую отстаивают сторонники технологической сингулярности. [75]

Исследователь искусственного интеллекта Юрген Шмидхубер заявил, что частота субъективно «примечательных событий», похоже, приближается к сингулярности 21-го века, но предостерег читателей относиться к таким сюжетам субъективных событий с долей скептицизма: возможно, различия в памяти о недавних и далеких событиях могли бы помочь. создать иллюзию ускорения перемен там, где ее нет. [76]

Соучредитель Microsoft Пол Аллен утверждал, что ускорение отдачи противоречит тормозу сложности; [11] Чем большего прогресса наука достигает в понимании интеллекта, тем труднее становится добиться дальнейшего прогресса. Исследование количества патентов показывает, что человеческое творчество демонстрирует не ускоряющуюся отдачу, а фактически, как предположил Джозеф Тейнтер в своей книге «Коллапс сложных обществ» [77] , закон убывающей отдачи . Число патентов на тысячу достигло пика в период с 1850 по 1900 год и с тех пор снижается. [70] Рост сложности в конечном итоге становится самоограничивающимся и приводит к повсеместному «общему коллапсу системы».

Хофштадтер (2006) выражает обеспокоенность по поводу того, что Рэй Курцвейл недостаточно строг с научной точки зрения, что экспоненциальная тенденция технологии не является научным законом, подобным закону физики, и что у экспоненциальных кривых нет «колен». [78] Тем не менее, он в принципе не исключает сингулярности в отдаленном будущем [12] и в свете ChatGPT и других недавних достижений существенно пересмотрел свое мнение в сторону кардинальных технологических изменений в ближайшем будущем. [79]

Джарон Ланье отрицает неизбежность сингулярности: «Я не думаю, что технология создает сама себя. Это не автономный процесс». [80] Более того: «Причина верить в человеческую активность выше технологического детерминизма состоит в том, что тогда вы можете иметь экономику, в которой люди зарабатывают по-своему и изобретают свою собственную жизнь . с практической точки зрения это то же самое, что и лишение людей влияния, достоинства и самоопределения ... принятие [идеи сингулярности] было бы прославлением плохих данных и плохой политики». [80]

Экономист Роберт Дж. Гордон отмечает, что измеренный экономический рост замедлился примерно в 1970 году и замедлился еще больше после финансового кризиса 2007–2008 годов , и утверждает, что экономические данные не показывают никаких следов грядущей сингулярности, как это представлял себе математик И. Дж. Гуд . [81]

Философ и ученый-когнитивист Дэниел Деннетт сказал в 2017 году: «Вся эта сингулярность абсурдна. Она отвлекает нас от гораздо более насущных проблем», добавив: «Это произойдет с инструментами ИИ, от которых мы становимся гиперзависимыми. И это один из опасность заключается в том, что мы дадим им больше полномочий, чем они заслуживают». [82]

Помимо общей критики концепции сингулярности, некоторые критики подняли вопросы по поводу культовой карты Курцвейла. Одна линия критики заключается в том, что логарифмическая диаграмма такого типа по своей сути склонна к прямолинейному результату. Другие отмечают предвзятость отбора в точках, которые Курцвейл предпочитает использовать. Например, биолог П. З. Майерс отмечает, что многие ранние эволюционные «события» были выбраны произвольно. [83] Курцвейл опроверг это утверждение, нарисовав на графике эволюционные события из 15 нейтральных источников и показав, что они соответствуют прямой линии на логарифмической диаграмме . Келли (2006) утверждает, что способ построения диаграммы Курцвейла с учетом времени до настоящего времени по оси X всегда указывает на сингулярность, находящуюся «сейчас», для любой даты, на которую можно построить такую диаграмму, и показывает это визуально на графике. Схема Курцвейла. [84]

Некоторые критики предполагают религиозные мотивы или последствия сингулярности, особенно ее версию Курцвейла. Наступление сингулярности сравнивается с иудео-христианскими сценариями конца времен. Бим называет это « видением Гипотетического Христианского Восторга Баком Роджерсом ». [85] Джон Грей говорит, что «Сингулярность отражает апокалиптические мифы, в которых история вот-вот прервется событием, преобразующим мир». [86]

Дэвид Стрейтфельд в «Нью-Йорк Таймс» задался вопросом, «может ли это проявиться в первую очередь – отчасти благодаря одержимости сегодняшней Силиконовой долины – как инструмент сокращения численности корпоративной Америки». [87]

В прошлом благодаря технологическому прогрессу происходили драматические изменения в темпах экономического роста. Судя по росту населения, экономика удваивалась каждые 250 000 лет, начиная с эпохи палеолита и до неолитической революции . Новая сельскохозяйственная экономика удваивалась каждые 900 лет, что является значительным ростом. В нынешнюю эпоху, начиная с промышленной революции, объем мирового экономического производства удваивается каждые пятнадцать лет, в шестьдесят раз быстрее, чем в сельскохозяйственную эпоху. Если появление сверхчеловеческого интеллекта вызовет подобную революцию, утверждает Робин Хэнсон, можно было бы ожидать, что экономика будет удваиваться как минимум ежеквартально, а возможно, и еженедельно. [88]

Термин «технологическая сингулярность» отражает идею о том, что такие изменения могут произойти внезапно и что трудно предсказать, как будет функционировать возникший в результате новый мир. [89] [90] Неясно, будет ли интеллектуальный взрыв, приводящий к сингулярности, полезен или вреден, или даже станет экзистенциальной угрозой . [91] [92] Поскольку ИИ является основным фактором риска сингулярности, ряд организаций разрабатывают техническую теорию согласования систем целей ИИ с человеческими ценностями, в том числе Институт будущего человечества , Исследовательский институт машинного интеллекта , [89] Центр совместимого с человеком искусственного интеллекта и Институт будущего жизни .

Физик Стивен Хокинг заявил в 2014 году: «Успех в создании ИИ станет величайшим событием в истории человечества. К сожалению, он может стать и последним, если мы не научимся избегать рисков». [93] Хокинг считал, что в ближайшие десятилетия ИИ может предложить «неисчислимые преимущества и риски», такие как «технологии, перехитрившие финансовые рынки, перехитрившие людей-исследователей, перехитрившие человеческих лидеров и создавшие оружие, которое мы даже не можем понять». [93] Хокинг предположил, что к искусственному интеллекту следует относиться более серьёзно и что следует сделать больше для подготовки к сингулярности: [93]

Итак, сталкиваясь с возможным будущим, полным неисчислимых выгод и рисков, эксперты наверняка делают все возможное, чтобы обеспечить наилучший результат, не так ли? Неправильный. Если бы высшая инопланетная цивилизация отправила нам сообщение: «Мы прибудем через несколько десятилетий», ответили бы мы просто: «Хорошо, позвоните нам, когда доберетесь сюда – мы оставим свет включенным»? Вероятно, нет – но это более или менее то, что происходит с ИИ.

Берглас (2008) утверждает, что у ИИ нет прямой эволюционной мотивации быть дружелюбным по отношению к людям. Эволюция не имеет врожденной тенденции производить результаты, ценные для людей, и нет особых оснований ожидать, что произвольный процесс оптимизации будет способствовать достижению желаемого для человечества результата, а не непреднамеренно приведет к тому, что ИИ будет вести себя не так, как предполагалось его создателями. [94] [95] [96] Андерс Сандберг также подробно остановился на этом сценарии, обращаясь к различным распространенным контраргументам. [97] Исследователь искусственного интеллекта Уго де Гарис предполагает, что искусственный интеллект может просто уничтожить человеческую расу ради доступа к ограниченным ресурсам , [57] [98] и люди будут бессильны остановить их. [99] Альтернативно, ИИ, разработанные под давлением эволюции для обеспечения собственного выживания, могут превзойти человечество. [61]

Бостром (2002) обсуждает сценарии вымирания человечества и называет сверхразум в качестве возможной причины:

Когда мы создаем первое сверхразумное существо, мы можем совершить ошибку и поставить перед ним цели, которые приведут его к уничтожению человечества, предполагая, что его огромное интеллектуальное преимущество дает ему возможность сделать это. Например, мы могли ошибочно повысить статус подцели до статуса сверхцели. Мы приказываем ему решить математическую задачу, и он подчиняется, превращая всю материю Солнечной системы в гигантское вычислительное устройство, убивая при этом человека, задавшего вопрос.

По мнению Элиэзера Юдковски , серьезная проблема безопасности ИИ заключается в том, что недружественный искусственный интеллект, скорее всего, будет гораздо легче создать, чем дружественный ИИ. В то время как оба требуют больших успехов в разработке процесса рекурсивной оптимизации, дружественный ИИ также требует способности делать структуру целей инвариантной при самосовершенствовании (иначе ИИ может трансформироваться во что-то недружественное) и структуры целей, которая соответствует человеческим ценностям и не приводит к автоматическим изменениям. уничтожить род человеческий. С другой стороны, недружественный ИИ может оптимизировать произвольную целевую структуру, которая не обязательно должна быть инвариантной при самомодификации. [100] Билл Хиббард (2014) предлагает дизайн ИИ, который позволяет избежать нескольких опасностей, включая самообман, [101] непреднамеренные инструментальные действия, [55] [102] и повреждение генератора вознаграждения. [102] Он также обсуждает социальные последствия ИИ [103] и тестирование ИИ. [104] Его книга «Сверхинтеллектуальные машины» 2001 года пропагандирует необходимость просвещения общественности в области ИИ и общественного контроля над ИИ. Он также предложил простую конструкцию, уязвимую для повреждения генератора вознаграждений.

Хотя технологическую сингулярность обычно рассматривают как внезапное событие, некоторые ученые утверждают, что нынешняя скорость изменений уже соответствует этому описанию. [ нужна цитата ]

Кроме того, некоторые утверждают, что мы уже находимся в процессе крупного эволюционного перехода , объединяющего технологии, биологию и общество. Цифровые технологии проникли в ткань человеческого общества до степени бесспорной и зачастую жизненно необходимой зависимости.

В статье 2016 года в журнале «Тенденции в экологии и эволюции» утверждается, что «люди уже используют сочетание биологии и технологий. Большую часть времени бодрствования мы проводим, общаясь через цифровые каналы… мы доверяем искусственному интеллекту свою жизнь посредством антиблокировочной системы тормозов в автомобилях и автопилотах» . в самолетах... Поскольку каждое третье ухаживание в Америке приводит к заключению брака через Интернет, цифровые алгоритмы также играют роль в создании связей и воспроизводстве человеческих пар».

Далее в статье утверждается, что с точки зрения эволюции несколько предыдущих крупных переходов в эволюции изменили жизнь посредством инноваций в хранении и репликации информации ( РНК , ДНК , многоклеточность , культура и язык ). На нынешнем этапе эволюции жизни углеродная биосфера породила когнитивную систему (человека), способную создавать технологии, которые приведут к сопоставимому эволюционному переходу .

Цифровая информация, созданная людьми, достигла такого же масштаба, что и биологическая информация в биосфере. С 1980-х годов объем хранимой цифровой информации удваивался примерно каждые 2,5 года, достигнув примерно 5 зеттабайт в 2014 году (5 × 1021 байт). [106]

С биологической точки зрения на планете насчитывается 7,2 миллиарда людей, каждый из которых имеет геном из 6,2 миллиарда нуклеотидов. Поскольку один байт может кодировать четыре пары нуклеотидов, отдельные геномы каждого человека на планете могут быть закодированы примерно 1 × 1019 байт. В цифровой сфере хранилось в 500 раз больше информации, чем в 2014 году (см. рисунок). Общее количество ДНК, содержащееся во всех клетках Земли, оценивается примерно в 5,3 × 1037 пар оснований, что эквивалентно 1,325 × 10.37 байт информации.

Если рост цифровых хранилищ продолжится нынешними темпами, составляющими 30–38% среднегодового роста в год, [48] примерно через 110 лет они будут конкурировать с общим информационным содержанием, содержащимся во всей ДНК во всех клетках на Земле. Это будет означать удвоение объема информации, хранящейся в биосфере, за общий период времени всего в 150 лет». [105]

В феврале 2009 года под эгидой Ассоциации по развитию искусственного интеллекта (AAAI) Эрик Хорвиц возглавил встречу ведущих компьютерных ученых, исследователей искусственного интеллекта и робототехники в конференц-центре Asilomar в Пасифик-Гроув, Калифорния. Целью было обсудить потенциальное влияние гипотетической возможности того, что роботы станут самодостаточными и смогут принимать собственные решения. Они обсудили, в какой степени компьютеры и роботы смогут обрести автономность и в какой степени они смогут использовать такие способности, чтобы создавать угрозы или опасности. [107]

Некоторые машины запрограммированы на различные формы полуавтономности, включая способность находить собственные источники энергии и выбирать цели для атаки с помощью оружия. Кроме того, некоторые компьютерные вирусы могут уклоняться от уничтожения и, по мнению присутствовавших ученых, поэтому можно сказать, что они достигли «тараканьей» стадии машинного интеллекта. Участники конференции отметили, что самосознание, изображенное в научной фантастике, вероятно, маловероятно, но существуют и другие потенциальные опасности и ловушки. [107]

Фрэнк С. Робинсон предсказывает, что как только люди создадут машину с интеллектом человека, научные и технологические проблемы будут решаться с помощью умственных способностей, намного превосходящих человеческие. Он отмечает, что искусственные системы способны обмениваться данными более напрямую, чем люди, и предсказывает, что это приведет к созданию глобальной сети сверхразума, которая затмит человеческие возможности. [108] Робинсон также обсуждает, насколько сильно изменится будущее после такого интеллектуального взрыва.

В сценарии жесткого взлета искусственный сверхинтеллект быстро самосовершенствуется, «беря под контроль» мир (возможно, в течение нескольких часов), слишком быстро для существенного исправления ошибок, инициированного человеком, или для постепенной настройки целей агента. В сценарии мягкого взлета ИИ по-прежнему становится намного более могущественным, чем человечество, но темпами, подобными человеческим (возможно, порядка десятилетий), и в таком масштабе времени, когда постоянное человеческое взаимодействие и коррекция могут эффективно управлять развитием ИИ. [110] [111]

Рамез Наам выступает против жесткого взлета. Он отметил, что мы уже наблюдаем рекурсивное самосовершенствование сверхразумов, таких как корпорации. Intel , например, располагает «коллективным умственным потенциалом десятков тысяч людей и, вероятно, миллионов процессорных ядер для… разработки более совершенных процессоров!» Однако это не привело к резкому взлету; скорее, это привело к мягкому взлету в форме закона Мура . [112] Наам далее отмечает, что вычислительная сложность высшего интеллекта может быть намного выше линейной, так что «создать разум с интеллектом 2, вероятно, более чем в два раза сложнее, чем создать разум с интеллектом 1». [113]

Дж. Сторрс Холл считает, что «многие из наиболее часто встречающихся сценариев ночного резкого взлета имеют циклический характер: они, похоже, предполагают сверхчеловеческие способности в начальной точке процесса самосовершенствования», чтобы ИИ мог совершить драматические действия. , общие улучшения домена, необходимые для взлета. Холл предполагает, что вместо того, чтобы самостоятельно рекурсивно совершенствовать свое оборудование, программное обеспечение и инфраструктуру, начинающему ИИ лучше специализироваться в одной области, где он наиболее эффективен, а затем покупать оставшиеся компоненты на рынке, потому что качество Количество продуктов на рынке постоянно улучшается, и ИИ будет трудно идти в ногу с передовыми технологиями, используемыми остальным миром. [114]

Бен Герцель согласен с предположением Холла о том, что новый ИИ человеческого уровня преуспеет, если будет использовать свой интеллект для накопления богатства. Таланты ИИ могут вдохновить компании и правительства на распространение его программного обеспечения по всему обществу. Герцель скептически относится к жесткому пятиминутному взлету, но полагает, что переход от человеческого к сверхчеловеческому уровню примерно за пять лет вполне разумен. Герзель называет этот сценарий «полужестким взлетом». [115]

Макс Мор не согласен, утверждая, что если бы существовало всего несколько сверхбыстрых ИИ человеческого уровня, они бы не изменили мир радикально, поскольку они по-прежнему зависели бы от других людей в выполнении задач и по-прежнему имели бы человеческие когнитивные ограничения. Даже если бы все сверхбыстрые ИИ работали над увеличением интеллекта, неясно, почему они прерывистым образом преуспели бы в создании сверхчеловеческого интеллекта лучше, чем существующие ученые-когнитивисты, хотя темпы прогресса увеличились бы. Более далее утверждает, что сверхразум не сможет изменить мир в одночасье: сверхразуму необходимо будет взаимодействовать с существующими, медленными человеческими системами, чтобы осуществлять физическое воздействие на мир. «Необходимость сотрудничества, организации и воплощения идей в физические изменения гарантирует, что все старые правила не будут отменены в одночасье или даже в течение нескольких лет». [116]

Дрекслер (1986), один из основоположников нанотехнологий , постулирует устройства восстановления клеток, в том числе действующие внутри клеток и использующие пока гипотетические биологические машины . [117] По словам Ричарда Фейнмана , именно его бывший аспирант и соратник Альберт Хиббс первоначально предложил ему (около 1959 года) идею медицинского использования теоретических микромашин Фейнмана. Хиббс предположил, что однажды некоторые ремонтные машины могут быть уменьшены в размерах до такой степени, что теоретически можно будет (как выразился Фейнман) « проглотить доктора ». Эта идея была включена в эссе Фейнмана 1959 года « На дне много места» . [118]

Моравец (1988) [34] предсказывает возможность «загрузки» человеческого разума в человекоподобного робота, достигая квазибессмертия за счет чрезвычайного долголетия посредством передачи человеческого разума между последовательными новыми роботами по мере изнашивания старых; кроме того, он предсказывает позднее экспоненциальное ускорение субъективного опыта времени, ведущее к субъективному ощущению бессмертия.

Курцвейл (2005) предполагает, что достижения медицины позволят людям защитить свое тело от последствий старения, делая продолжительность жизни безграничной . Курцвейл утверждает, что технологические достижения в медицине позволят нам постоянно восстанавливать и заменять неисправные компоненты нашего тела, продлевая жизнь до неопределенного возраста. [119] Курцвейл далее подкрепляет свой аргумент, обсуждая текущие достижения биоинженерии. Курцвейл предлагает соматическую генную терапию ; после синтетических вирусов со специфической генетической информацией, следующим шагом будет применение этой технологии к генной терапии, заменяя человеческую ДНК синтезированными генами. [120]

Помимо простого продления срока службы физического тела, Джарон Ланье выступает за форму бессмертия, называемую «Цифровое Вознесение», которая предполагает, что «люди умирают во плоти, загружаются в компьютер и остаются в сознании». [121]

В статье Махендры Прасада, опубликованной в журнале AI Magazine , утверждается, что математик 18-го века маркиз де Кондорсе был первым человеком, который выдвинул гипотезу и математически смоделировал интеллектуальный взрыв и его влияние на человечество. [122]

Раннее описание этой идеи было сделано в рассказе Джона Кэмпбелла 1932 года «Последняя эволюция». [123]

В своем некрологе Джону фон Нейману в 1958 году Улам вспоминал разговор с фон Нейманом о «постоянно ускоряющемся прогрессе технологий и изменениях в образе человеческой жизни, что создает видимость приближения к какой-то существенной сингулярности в истории расы, за пределами которой человеческие дела, какими мы их знаем, не могли продолжаться». [6]

В 1965 году Гуд написал свое эссе, в котором постулировал «интеллектуальный взрыв» рекурсивного самосовершенствования машинного интеллекта. [18] [19]

В 1977 году Ганс Моравец написал статью с неясным статусом публикации, в которой он предполагал развитие самосовершенствующихся мыслящих машин, создание «сверхсознания, синтеза земной жизни, а также, возможно, жизни на Юпитере и Марсе, постоянно улучшающихся и расширяясь, распространяясь за пределы Солнечной системы, превращая не-жизнь в разум». [124] [125] В статье описывается загрузка человеческого разума, позже описанная Моравцем (1988). Ожидается, что машины достигнут человеческого уровня, а затем усовершенствуются за его пределами («Самое главное, что их [машины] можно заставить работать программистами и инженерами, с задачей оптимизации программного и аппаратного обеспечения, которые делают их такими, какими они есть». Последующие поколения машин, производимых таким образом, будут становиться все более умными и экономически эффективными».) Люди больше не будут нужны, и их способности будут превзойдены машинами: «В долгосрочной перспективе явная физическая неспособность людей Если идти в ногу с этими быстро развивающимися отпрысками нашего разума, соотношение людей и машин приблизится к нулю и что вселенную унаследует прямой потомок нашей культуры, а не наших генов». Хотя слово «сингулярность» не используется, существует понятие мыслящих машин человеческого уровня, которые впоследствии совершенствуются за пределы человеческого уровня. С этой точки зрения не происходит никакого взрыва интеллекта в смысле очень быстрого роста интеллекта после достижения человеческого эквивалента. Обновленная версия статьи была опубликована в 1979 году в журналах Analog Science Fiction and Fact . [126] [125]

В 1981 году Станислав Лем опубликовал научно-фантастический роман «Голем XIV» . В нем описывается военный компьютер с искусственным интеллектом (Голем XIV), который обретает сознание и начинает увеличивать свой интеллект, двигаясь к личной технологической сингулярности. Голем XIV изначально был создан, чтобы помогать своим строителям в ведении войн, но по мере того, как его интеллект достигает гораздо более высокого уровня, чем у людей, он перестает интересоваться военными требованиями, поскольку обнаруживает, что им недостает внутренней логической последовательности.

В 1983 году Вернор Виндж в печатном выпуске журнала Omni за январь 1983 года рассказал о взрывном росте разведки Гуда . В этой статье Виндж, кажется, был первым, кто использовал термин «сингулярность» (хотя и не «технологическая сингулярность») в смысле, конкретно связанном с созданием разумных машин: [8] [125]

Скоро мы создадим разум, превосходящий наш собственный. Когда это произойдет, человеческая история достигнет своего рода сингулярности, интеллектуального перехода, столь же непроницаемого, как запутанное пространство-время в центре черной дыры, и мир выйдет далеко за пределы нашего понимания. Эта необычность, я полагаю, уже не дает покоя ряду писателей-фантастов. Это делает невозможным реалистичную экстраполяцию в межзвездное будущее. Чтобы написать историю, действие которой происходит более чем через столетие, между ними нужна ядерная война... чтобы мир оставался понятным.

В 1985 году в книге «Временная шкала искусственного интеллекта» исследователь искусственного интеллекта Рэй Соломонов математически сформулировал родственное понятие того, что он назвал «точкой бесконечности»: если исследовательскому сообществу самосовершенствующихся ИИ человеческого уровня потребуется четыре года, чтобы удвоиться их собственная скорость, затем два года, затем один год и так далее, их возможности бесконечно увеличиваются за конечное время. [7] [127]

В 1986 году Вернор Виндж опубликовал научно-фантастический роман «Оставленные в реальном времени» , в котором несколько оставшихся людей, путешествующих вперед в будущем, пережили неизвестное событие вымирания, которое вполне могло быть сингулярностью. В коротком послесловии автор заявляет, что реальная технологическая сингулярность не будет означать конец человеческого рода: «конечно, кажется очень маловероятным, что Сингулярность будет полным исчезновением человеческой расы. (С другой стороны, такое исчезновение — это временной аналог тишины, которую мы видим по всему небу.)». [128] [129]

В 1988 году Виндж использовал фразу «технологическая сингулярность» (в том числе «технологическая») в сборнике рассказов « Угрозы и другие обещания » , написав во введении к своему рассказу «Вихрь времени» (стр. 72): « Если не произойдет всемирная катастрофа». Я верю, что технологии осуществят наши самые смелые мечты, и очень скоро. Когда мы повышаем свой собственный интеллект и интеллект наших творений, мы больше не находимся в мире персонажей размером с человека. В этот момент мы попали в технологическую «черную дыру», технологическую сингулярность. [130]

В 1988 году Ганс Моравец опубликовал книгу «Дети разума» [ 34] , в которой он предсказал, что к 2010 году в суперкомпьютерах появится интеллект человеческого уровня, самосовершенствующиеся интеллектуальные машины, намного превосходящие человеческий интеллект позже, человеческий разум позже загружается в человекоподобных роботов, интеллектуальные машины покидают людей. позади, и космическая колонизация. Однако он не упомянул «сингулярность» и не говорил о быстром взрыве интеллекта сразу после достижения человеческого уровня. Тем не менее, общий смысл сингулярности присутствует в прогнозировании как искусственного интеллекта человеческого уровня, так и дальнейшего искусственного интеллекта, намного превосходящего человека позже.

Статья Винджа 1993 года «Грядущая технологическая сингулярность: как выжить в постчеловеческую эпоху» [4] широко распространилась в Интернете и помогла популяризировать эту идею. [131] В этой статье содержится заявление: «Через тридцать лет у нас будут технологические средства для создания сверхчеловеческого интеллекта. Вскоре после этого человеческая эра закончится». Виндж утверждает, что авторы научной фантастики не могут писать реалистичных постсингулярных персонажей, превосходящих человеческий интеллект, поскольку мысли такого интеллекта были бы за пределами способности людей выражать. [4]

В статье Мински 1994 года говорится, что роботы «наследуют Землю», возможно, с использованием нанотехнологий, и предлагается думать о роботах как о человеческих «детях разума», проводя аналогию с Моравцем. Риторический эффект этой аналогии заключается в том, что если люди могут передать мир своим биологическим детям, они также могут передать его роботам, своим «разумным» детям. По словам Мински, «мы могли бы заставить наших «детей разума» думать в миллион раз быстрее, чем мы сами. Такому существу полминуты могут показаться продолжительностью одного нашего года, а каждый час — целой человеческой жизни». Особенностью сингулярности, присутствующей у Мински, является развитие сверхчеловеческого искусственного интеллекта («в миллион раз быстрее»), но о внезапном взрыве интеллекта, самосовершенствующихся мыслящих машинах или непредсказуемости, выходящей за пределы какого-либо конкретного события и слова «сингулярность», речи не идет. не используется. [132]

Книга Типлера «Физика бессмертия» 1994 года предсказывает будущее, в котором сверхразумные машины будут создавать чрезвычайно мощные компьютеры, людей будут «эмулировать» в компьютерах, жизнь достигнет каждой галактики, а люди достигнут бессмертия, когда достигнут Точки Омега . [133] Здесь не идет речь о вингийской «сингулярности» или внезапном взрыве интеллекта, но здесь присутствует интеллект, намного превосходящий человеческий, а также бессмертие.

В 1996 году Юдковский предсказал сингулярность к 2021 году . [20] Его версия сингулярности предполагает взрыв интеллекта: как только ИИ начинают исследования, чтобы улучшить себя, скорость удваивается через 2 года, затем через 1 год, затем через 6 месяцев, затем через 3 года. месяцев, затем через 1,5 месяца и еще через несколько итераций «сингулярность» достигается. [20] Эта конструкция подразумевает, что скорость достигает бесконечности за конечное время.

В 2000 году Билл Джой , известный технолог и соучредитель Sun Microsystems , выразил обеспокоенность по поводу потенциальных опасностей робототехники, генной инженерии и нанотехнологий. [53]

В 2005 году Курцвейл опубликовал книгу «Сингулярность близка» . Рекламная кампания Курцвейла включала появление на The Daily Show с Джоном Стюартом . [134]

С 2006 по 2012 год ежегодная конференция Singularity Summit организовывалась Исследовательским институтом машинного интеллекта , основанным Элиэзером Юдковски .

В 2007 году Юдковский предположил, что многие из различных определений «сингулярности» скорее несовместимы, чем взаимодополняют друг друга. [29] [135] Например, Курцвейл экстраполирует текущие технологические траектории за пределы появления самосовершенствующегося искусственного интеллекта или сверхчеловеческого интеллекта, что, по мнению Юдковски, представляет собой противоречие как с предложенным И. Дж. Гудом прерывистым ростом интеллекта, так и с тезисом Винджа о непредсказуемости. [29]

В 2009 году Курцвейл и основатель X-Prize Питер Диамандис объявили о создании Университета сингулярности , неаккредитованного частного института, заявленная миссия которого — «обучать, вдохновлять и расширять возможности лидеров для применения экспоненциальных технологий для решения великих проблем человечества». [136] Университет Сингулярности , финансируемый Google , Autodesk , ePlanet Ventures и группой лидеров технологической отрасли , базируется в Исследовательском центре Эймса НАСА в Маунтин -Вью , Калифорния . Некоммерческая организация летом проводит ежегодную десятинедельную программу для выпускников, которая охватывает десять различных технологических и смежных направлений, а также серию программ для руководителей в течение года.

В 2007 году Объединенный экономический комитет Конгресса США опубликовал отчет о будущем нанотехнологий. Он предсказывает значительные технологические и политические изменения в среднесрочном будущем, включая возможную технологическую сингулярность. [137] [138] [139]

Бывший президент США Барак Обама говорил о сингулярности в интервью Wired в 2016 году: [140]

Одна вещь, о которой мы не слишком много говорили, и я просто хочу вернуться к ней, это то, что нам действительно нужно продумать экономические последствия. Потому что большинство людей сейчас не тратят много времени на беспокойство по поводу сингулярности — они беспокоятся о том: «Ну, будет ли моя работа заменена машиной?»

самые мощные технологии XXI века – робототехника, генная инженерия и нанотехнологии – угрожают сделать людей вымирающим видом.

Некоторые люди говорят, что компьютеры никогда не смогут продемонстрировать истинный интеллект, каким бы он ни был. Но мне кажется, что если очень сложные химические молекулы могут действовать в людях, делая их разумными, то столь же сложные электронные схемы могут также заставить компьютеры действовать разумным образом. И если они разумны, они, вероятно, смогут создавать компьютеры, которые будут еще более сложными и интеллектуальными.