Синтез речи – это искусственное производство человеческой речи . Компьютерная система, используемая для этой цели, называется синтезатором речи и может быть реализована в программных или аппаратных продуктах. Система преобразования текста в речь ( TTS ) преобразует обычный языковой текст в речь; другие системы преобразуют в речь символические лингвистические представления , такие как фонетическая транскрипция . [1] Обратный процесс — распознавание речи .

Синтезированная речь может быть создана путем объединения фрагментов записанной речи, хранящихся в базе данных . Системы различаются размером хранимых речевых единиц; система, в которой хранятся телефоны или дифоны , обеспечивает самый большой диапазон выходного сигнала, но может не иметь четкости. Для определенных областей использования хранение целых слов или предложений позволяет получить высококачественный результат. Альтернативно, синтезатор может включать в себя модель речевого тракта и других характеристик человеческого голоса для создания полностью «синтетического» голосового вывода. [2]

О качестве синтезатора речи судят по его сходству с человеческим голосом и способности четко понимать его. Разборчивая программа преобразования текста в речь позволяет людям с нарушениями зрения или нарушениями чтения слушать написанные слова на домашнем компьютере. Многие компьютерные операционные системы включают в себя синтезаторы речи с начала 1990-х годов.

Система преобразования текста в речь (или «движок » ) состоит из двух частей: [3] внешней и внутренней частей . Передняя часть имеет две основные задачи. Во-первых, он преобразует необработанный текст, содержащий такие символы, как цифры и сокращения, в эквивалент написанных слов. Этот процесс часто называют нормализацией текста , предварительной обработкой или токенизацией . Затем интерфейсная часть назначает фонетическую транскрипцию каждому слову, а также разделяет и размечает текст на просодические единицы , такие как фразы , предложения и предложения . Процесс присвоения фонетических транскрипций словам называется преобразованием текста в фонему или графемы в фонему . Фонетическая транскрипция и просодическая информация вместе составляют символическое лингвистическое представление, которое выводится внешним интерфейсом. Серверная часть, часто называемая синтезатором , затем преобразует символическое лингвистическое представление в звук. В некоторых системах эта часть включает в себя вычисление целевой просодии (контура высоты тона, длительности фонем) [4] , которая затем накладывается на выходную речь.

Задолго до изобретения электронной обработки сигналов некоторые люди пытались создать машины, имитирующие человеческую речь. Некоторые ранние легенды о существовании « Медных голов » касались Папы Сильвестра II (ум. 1003 г. н.э.), Альберта Великого (1198–1280) и Роджера Бэкона (1214–1294).

В 1779 году немецко - датский учёный Кристиан Готлиб Краценштейн выиграл первую премию на конкурсе, объявленном Российской Императорской Академией наук и художеств, за построенные им модели речевого тракта человека , способные воспроизводить пять долгих гласных звуков (в обозначениях Международного фонетического алфавита). : [aː] , [eː] , [iː] , [oː] и [uː] ). [5] Затем последовала « акустико-механическая речевая машина » с сильфонным приводом Вольфганга фон Кемпелена из Прессбурга , Венгрия, описанная в статье 1791 года. [6] Эта машина добавила модели языка и губ, что позволило ей воспроизводить как согласные, так и гласные. В 1837 году Чарльз Уитстон изготовил «говорящую машину» по конструкции фон Кемпелена, а в 1846 году Джозеф Фабер выставил «Эуфонию » . В 1923 году Пейджет возродил дизайн Уитстона. [7]

В 1930-х годах лаборатория Белла разработала вокодер , который автоматически анализировал речь на ее основные тона и резонансы. На основе своей работы над вокодером Гомер Дадли разработал клавиатурный синтезатор голоса под названием The Voder (Voice Demonstrator), который он продемонстрировал на Всемирной выставке в Нью-Йорке в 1939 году .

Доктор Франклин С. Купер и его коллеги из Haskins Laboratories создали устройство воспроизведения паттернов в конце 1940-х годов и завершили его в 1950 году. Существовало несколько различных версий этого аппаратного устройства; в настоящее время выживает только один. Машина преобразует изображения акустических паттернов речи в виде спектрограммы обратно в звук. Используя это устройство, Элвин Либерман и его коллеги обнаружили акустические сигналы для восприятия фонетических сегментов (согласных и гласных).

.jpg/440px-Computer_and_speech_synthesiser_housing,_19_(9663804888).jpg)

Первые компьютерные системы синтеза речи возникли в конце 1950-х годов. Норико Умеда и др. разработал первую систему преобразования текста в речь на общем английском языке в 1968 году в Электротехнической лаборатории в Японии. [8] В 1961 году физик Джон Ларри Келли-младший и его коллега Луи Герстман [9] использовали компьютер IBM 704 для синтеза речи, и это событие было одним из самых выдающихся в истории Bell Labs . [ нужна цитация ] Синтезатор диктофона Келли ( вокодер ) воссоздал песню « Daisy Bell », с музыкальным сопровождением от Макса Мэтьюза . По совпадению, Артур Кларк гостил у своего друга и коллеги Джона Пирса в лаборатории Bell Labs в Мюррей-Хилл. Кларк был настолько впечатлен демонстрацией, что использовал ее в кульминационной сцене сценария своего романа « 2001: Космическая одиссея» , [10] где компьютер HAL 9000 поет ту же песню, которую астронавт Дэйв Боуман усыпляет. [11] Несмотря на успех чисто электронного синтеза речи, исследования механических синтезаторов речи продолжаются. [12] [ нужен сторонний источник ]

Линейное предсказательное кодирование (LPC), форма речевого кодирования , начало развиваться с работы Фумитады Итакуры из Нагойского университета и Сюдзо Сайто из Nippon Telegraph and Telephone (NTT) в 1966 году. Дальнейшие разработки в технологии LPC были сделаны Бишну С. Аталом. и Манфред Р. Шредер из Bell Labs в 1970-е годы. [13] Позже LPC стал основой для ранних микросхем синтезаторов речи, таких как речевые чипы LPC от Texas Instruments, используемые в игрушках Speak & Spell с 1978 года.

В 1975 году Фумитада Итакура разработал метод линейных спектральных пар (LSP) для кодирования речи с высокой степенью сжатия, находясь в NTT. [14] [15] [16] С 1975 по 1981 год Итакура изучал проблемы анализа и синтеза речи на основе метода LSP. [16] В 1980 году его команда разработала чип синтезатора речи на основе LSP. LSP является важной технологией синтеза и кодирования речи, и в 1990-х годах она была принята почти всеми международными стандартами кодирования речи в качестве важного компонента, способствуя совершенствованию цифровой речевой связи по мобильным каналам и Интернету. [15]

В 1975 году была выпущена MUSA , которая стала одной из первых систем синтеза речи. Он состоял из автономного компьютерного оборудования и специализированного программного обеспечения, позволяющего читать по-итальянски. Вторая версия, выпущенная в 1978 году, также могла петь по-итальянски в стиле « а капелла ». [17]

Доминирующими системами в 1980-х и 1990-х годах были система DECtalk , основанная в основном на работах Денниса Клатта из Массачусетского технологического института, и система Bell Labs; [18] последняя была одной из первых многоязычных, независимых от языка систем, широко использующих методы обработки естественного языка .

Портативная электроника с синтезатором речи начала появляться в 1970-х годах. Одним из первых был портативный калькулятор Speech+ для слепых Telesensory Systems Inc. (TSI) в 1976 году. [19] [20] Другие устройства преследовали в первую очередь образовательные цели, например игрушка Speak & Spell , выпущенная Texas Instruments в 1978 году . 21] Fidelity выпустила говорящую версию своего электронного шахматного компьютера в 1979 году. [22] Первой видеоигрой , в которой использовался синтез речи , была аркадная игра -стрелялка 1980 года Stratovox (известная в Японии как Speak & Rescue ) от Sun Electronics. . [23] [24] Первой компьютерной игрой с синтезатором речи была Manbiki Shoujo ( «Девушка-воровка »), выпущенная в 1980 году для PET 2001 , для которой разработчик игры Хироши Судзуки разработал технику программирования « нулевого креста » для создания синтезированная речевая волна. [25] Другой ранний пример, аркадная версия Berzerk , также датируется 1980 годом. Компания Milton Bradley выпустила первую многопользовательскую электронную игру с использованием синтеза голоса, Milton , в том же году.

Ранние электронные синтезаторы речи звучали как роботы и часто были едва разборчивы. Качество синтезированной речи неуклонно улучшается, но по состоянию на 2016 год [обновлять]выходные данные современных систем синтеза речи по-прежнему четко отличаются от реальной человеческой речи.

Синтезированные голоса обычно звучали мужскими до 1990 года, когда Энн Сирдал из AT&T Bell Laboratories создала женский голос. [26]

В 2005 году Курцвейл предсказал, что, поскольку соотношение цены и качества привело к тому, что синтезаторы речи стали дешевле и доступнее, больше людей выиграют от использования программ преобразования текста в речь. [27]

Важнейшими качествами системы синтеза речи являются естественность и разборчивость . [28] Естественность характеризует то, насколько близко вывод похож на человеческую речь, а разборчивость — это легкость, с которой вывод воспринимается. Идеальный синтезатор речи одновременно естественен и понятен. Системы синтеза речи обычно пытаются максимизировать обе характеристики.

Двумя основными технологиями, генерирующими синтетические речевые сигналы, являются конкатенативный синтез и формантный синтез . У каждой технологии есть сильные и слабые стороны, и предполагаемое использование системы синтеза обычно определяет, какой подход используется.

Конкатенативный синтез основан на конкатенации (связывании) сегментов записанной речи. Как правило, конкатенативный синтез дает наиболее естественно звучащую синтезированную речь. Однако различия между естественными изменениями речи и характером автоматизированных методов сегментации сигналов иногда приводят к слышимым сбоям на выходе. Существует три основных подтипа конкатенативного синтеза.

Синтез выбора единиц измерения использует большие базы данных записанной речи. Во время создания базы данных каждое записанное высказывание сегментируется на некоторые или все из следующих элементов: отдельные звуки , дифоны , полуфоны, слоги , морфемы , слова , фразы и предложения . Обычно разделение на сегменты выполняется с помощью специально модифицированного распознавателя речи , установленного в режим «принудительного выравнивания» с последующей ручной коррекцией, с использованием визуальных представлений, таких как форма волны и спектрограмма . [29] Затем создается индекс единиц в базе данных речи на основе сегментации и акустических параметров, таких как основная частота ( высота тона ), длительность , положение в слоге и соседние звуки. Во время выполнения желаемое целевое высказывание создается путем определения лучшей цепочки возможных единиц из базы данных (выбор единицы). Этот процесс обычно достигается с помощью специально взвешенного дерева решений .

Выбор единиц измерения обеспечивает максимальную естественность, поскольку к записанной речи применяется лишь небольшая часть цифровой обработки сигналов (DSP). DSP часто делает звук записанной речи менее естественным, хотя некоторые системы используют небольшую обработку сигнала в точке конкатенации для сглаживания формы сигнала. Результаты лучших систем выбора единиц часто неотличимы от реальных человеческих голосов, особенно в контекстах, для которых была настроена система TTS. Однако максимальная естественность обычно требует, чтобы базы данных речевых данных с выбором единиц были очень большими, в некоторых системах до гигабайт записанных данных, что соответствует десяткам часов речи. [30] Также известно, что алгоритмы выбора единиц выбирают сегменты из того места, что приводит к далеко не идеальному синтезу (например, второстепенные слова становятся неясными), даже если в базе данных существует лучший выбор. [31] Недавно исследователи предложили различные автоматизированные методы обнаружения неестественных сегментов в системах синтеза речи с выбором единиц. [32]

Синтез дифонов использует минимальную речевую базу данных, содержащую все дифоны (переходы между звуками), встречающиеся в языке. Количество дифонов зависит от фонотактики языка: например, в испанском языке около 800 дифонов, а в немецком - около 2500. При синтезе дифонов в речевой базе данных содержится только один пример каждого дифона. Во время выполнения целевая просодия предложения накладывается на эти минимальные единицы с помощью методов цифровой обработки сигналов , таких как кодирование с линейным предсказанием , PSOLA [33] или MBROLA . [34] или более поздние методы, такие как изменение высоты тона в исходной области с использованием дискретного косинусного преобразования . [35] Синтез дифонов страдает от звуковых сбоев конкатенативного синтеза и роботизированного характера формантного синтеза и имеет мало преимуществ любого подхода, кроме небольшого размера. Таким образом, его использование в коммерческих приложениях сокращается, хотя его продолжают использовать в исследованиях , поскольку существует ряд свободно доступных программных реализаций . Ранним примером синтеза дифонов является обучающий робот Leachim, изобретенный Майклом Дж. Фриманом . [36] Leachim содержал информацию об учебной программе класса и определенную биографическую информацию об учениках, для обучения которых он был запрограммирован. [37] Оно было протестировано в четвертом классе в Бронксе, Нью-Йорк . [38] [39]

Специализированный для предметной области синтез объединяет заранее записанные слова и фразы для создания законченных высказываний. Он используется в приложениях, где разнообразие текстов, выводимых системой, ограничено определенным доменом, например, объявления о расписании общественного транспорта или сводки погоды. [40] Эту технологию очень просто реализовать, и она уже давно используется в коммерческих целях в таких устройствах, как говорящие часы и калькуляторы. Уровень естественности этих систем может быть очень высоким, поскольку разнообразие типов предложений ограничено, и они точно соответствуют просодии и интонации оригинальных записей. [ нужна цитата ]

Поскольку эти системы ограничены количеством слов и фраз в своих базах данных, они не являются универсальными и могут синтезировать только те комбинации слов и фраз, которые были заранее запрограммированы. Однако смешение слов в естественном разговорном языке все равно может вызвать проблемы, если не принять во внимание множество вариаций. Например, в неротических диалектах английского языка буква «r» в таких словах, как «clear» /ˈklɪə/, обычно произносится только тогда, когда в следующем слове в качестве первой буквы стоит гласная (например, «clear out» реализуется как /ˌklɪəɹˈʌʊt/). ). Аналогично во французском языке многие конечные согласные перестают молчать, если за ними следует слово, начинающееся с гласной — эффект, называемый связью . Это чередование не может быть воспроизведено с помощью простой системы конкатенации слов, которая потребует дополнительной сложности, чтобы быть контекстно-зависимой .

Формантный синтез не использует образцы человеческой речи во время выполнения. Вместо этого синтезированный речевой вывод создается с использованием аддитивного синтеза и акустической модели ( синтез физического моделирования ). [41] Такие параметры, как основная частота , тембр голоса и уровни шума , изменяются со временем, создавая форму волны искусственной речи. Этот метод иногда называют синтезом на основе правил ; однако многие конкатенативные системы также имеют компоненты, основанные на правилах. Многие системы, основанные на технологии формантного синтеза, генерируют искусственную, роботизированную речь, которую никогда нельзя спутать с человеческой речью. Однако максимальная естественность не всегда является целью системы синтеза речи, и системы формантного синтеза имеют преимущества перед конкатенативными системами. Формантно-синтезированная речь может быть надежно разборчивой даже на очень высоких скоростях, избегая акустических сбоев, которые обычно мешают конкатенативным системам. Высокоскоростная синтезированная речь используется слабовидящими для быстрой навигации по компьютеру с помощью программы чтения с экрана . Формантные синтезаторы обычно представляют собой программы меньшего размера, чем конкатенативные системы, поскольку у них нет базы данных образцов речи. Поэтому их можно использовать во встроенных системах , где память и мощность микропроцессора особенно ограничены. Поскольку системы на основе формант полностью контролируют все аспекты выходной речи, можно выводить самые разнообразные просодии и интонации , передавая не только вопросы и утверждения, но и различные эмоции и тона голоса.

Примеры нереального, но высокоточного управления интонацией при синтезе формант включают работу, проделанную в конце 1970-х годов для игрушки Texas Instruments Speak & Spell , а также в начале 1980-х годов для аркадных автоматов Sega [42] и во многих Atari, Inc. аркадные игры [43] с использованием чипов TMS5220 LPC . Создание правильной интонации для этих проектов было кропотливым процессом, и результаты еще не были подтверждены интерфейсами преобразования текста в речь в реальном времени. [44]

Артикуляционный синтез — это вычислительные методы синтеза речи, основанные на моделях речевого тракта человека и происходящих там артикуляционных процессов. Первый артикуляционный синтезатор, регулярно используемый для лабораторных экспериментов, был разработан в лабораториях Хаскинса в середине 1970-х годов Филипом Рубином , Томом Баером и Полом Мермельштейном. Этот синтезатор, известный как ASY, был основан на моделях голосового тракта, разработанных в Bell Laboratories в 1960-х и 1970-х годах Полом Мермельштейном, Сесилом Кокером и его коллегами.

До недавнего времени модели артикуляционного синтеза не были включены в коммерческие системы синтеза речи. Заметным исключением является система на базе NeXT , первоначально разработанная и продаваемая Trillium Sound Research, дочерней компанией Университета Калгари , где была проведена большая часть первоначальных исследований. После упадка различных воплощений NeXT (начатой Стивом Джобсом в конце 1980-х годов и объединенной с Apple Computer в 1997 году) программное обеспечение Trillium было опубликовано под лицензией GNU General Public License, а работа продолжалась как gnuspech . Система, впервые представленная на рынке в 1994 году, обеспечивает полное артикуляционное преобразование текста в речь с использованием волновода или аналога линии передачи ротового и носового трактов человека, управляемого «моделью отличительной области» Карре.

Более поздние синтезаторы, разработанные Хорхе К. Лусеро и его коллегами, включают модели биомеханики голосовых связок, голосовой аэродинамики и распространения акустических волн в бронхах, трахее, носовой и ротовой полостях и, таким образом, представляют собой полноценные системы моделирования речи на основе физики. [45] [46]

Синтез на основе HMM — это метод синтеза, основанный на скрытых марковских моделях , также называемый статистическим параметрическим синтезом. В этой системе частотный спектр ( голосовой тракт ), основная частота (источник голоса) и длительность ( просодия ) речи моделируются одновременно с помощью HMM. Речевые сигналы генерируются из самих HMM на основе критерия максимального правдоподобия . [47]

Синусоидальный синтез — это метод синтеза речи путем замены формант (основных полос энергии) чистыми тонами свиста. [48]

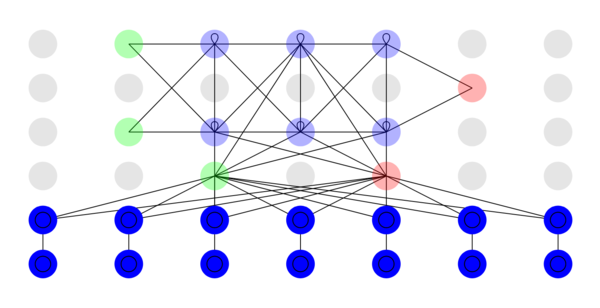

Синтез речи с глубоким обучением использует глубокие нейронные сети (DNN) для создания искусственной речи из текста (текст в речь) или спектра (вокодер). Глубокие нейронные сети обучаются с использованием большого количества записанной речи и, в случае системы преобразования текста в речь, связанных с ней меток и/или входного текста.

15.ai использует модель с несколькими динамиками — сотни голосов обучаются одновременно, а не последовательно, что сокращает необходимое время обучения и позволяет модели изучать и обобщать общий эмоциональный контекст, даже для голосов, не подвергающихся воздействию такого эмоционального контекста. [49] Модель глубокого обучения , используемая приложением, является недетерминированной : каждый раз, когда речь генерируется из одной и той же текстовой строки, интонация речи будет немного отличаться. Приложение также поддерживает ручное изменение эмоций сгенерированной строки с помощью эмоциональных контекстуализаторов (термин, придуманный в рамках этого проекта), предложения или фразы, передающей эмоции дубля, которые служат руководством для модели во время вывода. [50] [51] [52]

ElevenLabs в первую очередь известна своим браузерным программным обеспечением для преобразования текста в речь с помощью искусственного интеллекта Speech Synthesis, которое может воспроизводить реалистичную речь путем синтеза голосовых эмоций и интонации . [53] Компания заявляет, что ее программное обеспечение позволяет корректировать интонацию и темп речи в зависимости от контекста используемого языка. [54] Он использует передовые алгоритмы для анализа контекстуальных аспектов текста с целью обнаружения таких эмоций, как гнев, печаль, счастье или тревога, что позволяет системе понимать чувства пользователя, [55] что приводит к более реалистичному и человечному изображению. как перегиб. Другие функции включают в себя генерацию многоязычной речи и создание длинного контента с помощью контекстно-зависимых голосов. [56] [57]

Синтезаторы речи на основе DNN приближаются к естественности человеческого голоса. Примерами недостатков метода являются низкая устойчивость при недостаточности данных, отсутствие управляемости и низкая производительность в авторегрессионных моделях.

Для тональных языков, таких как китайский или тайваньский язык, требуются разные уровни тонального сандхи, и иногда выходные данные синтезатора речи могут приводить к ошибкам тонального сандхи. [58]

В 2023 году репортер VICE Джозеф Кокс опубликовал данные о том, что он записал пять минут своего разговора, а затем использовал инструмент, разработанный ElevenLabs, для создания голосовых дипфейков, которые обошли систему голосовой аутентификации банка . [64]

Процесс нормализации текста редко бывает простым. Тексты полны гетеронимов , цифр и сокращений , которые требуют расширения в фонетическое представление. В английском языке существует множество вариантов написания, которые произносятся по-разному в зависимости от контекста. Например, фраза «Мой последний проект — научиться лучше выражать свой голос» содержит два варианта произношения слова «проект».

Большинство систем преобразования текста в речь (TTS) не генерируют семантические представления входных текстов, поскольку процессы для этого ненадежны, плохо поняты и вычислительно неэффективны. В результате для угадывания правильного способа устранения неоднозначности омографов используются различные эвристические методы , такие как проверка соседних слов и использование статистики частоты встречаемости.

Недавно системы TTS начали использовать HMM (обсуждаемые выше) для генерации « частей речи », чтобы помочь устранить неоднозначность омографов. Этот метод весьма успешен во многих случаях, например, следует ли произносить слово «read» как «red», подразумевающее прошедшее время, или как «reed», подразумевающее настоящее время. Типичный уровень ошибок при таком использовании HMM обычно составляет менее пяти процентов. Эти методы также хорошо работают для большинства европейских языков, хотя доступ к необходимым учебным корпусам для этих языков часто затруднен.

Решение о том, как преобразовывать числа, — еще одна проблема, которую приходится решать системам TTS. Преобразовать число в слова (по крайней мере, на английском языке) — это простая задача программирования, например, «1325» в «одна тысяча триста двадцать пять». Однако числа встречаются во многих разных контекстах; «1325» также можно читать как «один три два пять», «тринадцать двадцать пять» или «тринадцатьсот двадцать пять». Система TTS часто может определить, как расширить число, на основе окружающих слов, цифр и знаков препинания, а иногда система предоставляет способ указать контекст, если он неоднозначен. [65] Римские цифры также могут читаться по-разному в зависимости от контекста. Например, «Генрих VIII» читается как «Генрих Восьмой», а «Глава VIII» читается как «Глава восьмая».

Точно так же сокращения могут быть неоднозначными. Например, аббревиатуру «in» для «дюймов» следует отличать от слова «in» и адреса «12 St John St.» использует одну и ту же аббревиатуру как для «Святого», так и для «Улицы». Системы TTS с интеллектуальным интерфейсом могут делать обоснованные предположения о неоднозначных сокращениях, в то время как другие дают один и тот же результат во всех случаях, что приводит к бессмысленным (а иногда и комичным) выводам, например, « Улисс С. Грант » отображается как «Улисс Южный Грант». .

Системы синтеза речи используют два основных подхода для определения произношения слова на основе его написания . Этот процесс часто называют преобразованием текста в фонему или графемы в фонему ( фонема — это термин, используемый лингвистами для описания отличительных звуков в речи). язык ) . Самый простой подход к преобразованию текста в фонему - это подход на основе словаря, при котором программа хранит большой словарь, содержащий все слова языка и их правильное произношение . Определение правильного произношения каждого слова заключается в поиске каждого слова в словаре и замене написания на произношение, указанное в словаре. Другой подход основан на правилах, при котором правила произношения применяются к словам, чтобы определить их произношение на основе их написания. Это похоже на «озвучивание», или синтетический фонетический подход к обучению чтению.

Каждый подход имеет преимущества и недостатки. Подход на основе словаря является быстрым и точным, но полностью терпит неудачу, если ему дано слово, которого нет в его словаре. По мере роста размера словаря растут и требования к объему памяти системы синтеза. С другой стороны, подход, основанный на правилах, работает с любыми входными данными, но сложность правил существенно возрастает, поскольку система учитывает неправильные написания и произношения. (Учтите, что слово «of» очень распространено в английском языке, но при этом является единственным словом, в котором буква «f» произносится как [v] .) В результате почти все системы синтеза речи используют комбинацию этих подходов.

Языки с фонематической орфографией имеют очень регулярную систему письма, и предсказание произношения слов на основе их написания весьма успешно. Системы синтеза речи для таких языков часто широко используют метод, основанный на правилах, прибегая к словарям только для тех немногих слов, таких как иностранные имена и заимствованные слова, произношение которых не очевидно из их написания. С другой стороны, системы синтеза речи для таких языков, как английский, которые имеют чрезвычайно нерегулярную систему правописания, чаще полагаются на словари и используют методы, основанные на правилах, только для необычных слов или слов, которых нет в их словарях.

Последовательная оценка систем синтеза речи может быть затруднена из-за отсутствия общепринятых объективных критериев оценки. Разные организации часто используют разные речевые данные. Качество систем синтеза речи также зависит от качества технологии производства (которая может включать аналоговую или цифровую запись) и от средств, используемых для воспроизведения речи. Поэтому оценка систем синтеза речи часто затрудняется различиями между методами производства и средствами воспроизведения.

Однако с 2005 года некоторые исследователи начали оценивать системы синтеза речи, используя общий набор речевых данных. [66]

Исследование, проведенное Эми Драготой и ее коллегами из Портсмутского университета ( Великобритания ), опубликованное в журнале Speech Communication , показало, что слушатели голосовых записей могут с большей вероятностью определить, улыбается ли говорящий. [67] [68] [69] Было высказано предположение, что идентификация голосовых особенностей, которые сигнализируют об эмоциональном содержании, может быть использована, чтобы сделать звучание синтезированной речи более естественным. Одним из связанных с этим вопросов является изменение тонального контура предложения в зависимости от того, является ли оно утвердительным, вопросительным или восклицательным. Один из методов модификации шага [70] использует дискретное косинусное преобразование в исходной области ( остаток линейного предсказания ). Такие способы изменения основного тона синхронного тона требуют априорной маркировки основного тона базы данных синтезированной речи с использованием таких методов, как извлечение эпохи с использованием индекса динамического взрыва , применяемого к интегрированному остатку линейного предсказания вокализованных областей речи. [71]

Популярные системы, предлагающие синтез речи в качестве встроенной возможности.

В начале 1980-х годов компания TI была известна как пионер в области синтеза речи, и для TI-99/4 и 4A был доступен очень популярный подключаемый модуль синтезатора речи. Синтезаторы речи предлагались бесплатно при покупке некоторого количества картриджей и использовались во многих видеоиграх, написанных TI (игры с речью, предлагаемые во время этой акции, включали Alpiner и Parsec ). Синтезатор использует вариант кодирования с линейным предсказанием и имеет небольшой встроенный словарь. Первоначальная цель заключалась в выпуске небольших картриджей, подключаемых непосредственно к синтезатору, что позволило бы расширить встроенный словарь устройства. Однако успех программного преобразования текста в речь в картридже Terminal Emulator II отменил этот план.

В 1982 году игровая консоль Mattel Intellivision предлагала модуль Intellivoice Voice Synthesis. Он включал в себя микросхему синтезатора речи SP0256 Narrator на съемном картридже. У Рассказчика было 2 КБ постоянной памяти (ПЗУ), которая использовалась для хранения базы данных общих слов, которые можно было комбинировать для создания фраз в играх Intellivision. Поскольку чип Orator также мог принимать речевые данные из внешней памяти, любые дополнительные слова или фразы могли храниться внутри самого картриджа. Данные состояли из строк коэффициентов аналогового фильтра, предназначенных для изменения поведения синтетической модели речевого тракта чипа, а не из простых оцифрованных выборок.

Software Automatic Mouth , также выпущенная в 1982 году, была первой коммерческой полностью программной программой синтеза голоса. Позже он был использован в качестве основы для Macintalk . Программа была доступна для компьютеров Apple, отличных от Macintosh (включая Apple II и Lisa), различных моделей Atari и Commodore 64. Версия Apple предпочитала дополнительное оборудование, содержащее ЦАП, хотя вместо этого она могла использовать однобитный звук компьютера. вывод (с добавлением большого количества искажений), если карты не было. В Atari использовался встроенный аудиочип POKEY. Воспроизведение речи на Atari обычно отключало запросы на прерывание и отключало чип ANTIC во время вывода голоса. Звуковой сигнал представляет собой сильно искаженную речь, когда экран включен. В Commodore 64 использовался встроенный в 64 аудиочип SID.

Вероятно, первой речевой системой, интегрированной в операционную систему , были персональные компьютеры 1400XL/1450XL, разработанные Atari, Inc. с использованием чипа Votrax SC01 в 1983 году. Компьютеры 1400XL/1450XL использовали конечный автомат, позволяющий передавать текст World English Spelling. -синтез речи. [73] К сожалению, персональные компьютеры 1400XL/1450XL никогда не поставлялись в больших количествах.

Компьютеры Atari ST продавались с файлом «stspeech.tos» на дискете.

Первой речевой системой, интегрированной в операционную систему , которая поставлялась в больших количествах, была MacInTalk от Apple Computer . Программное обеспечение было лицензировано у сторонних разработчиков Джозефа Каца и Марка Бартона (позже SoftVoice, Inc.) и было представлено во время представления компьютера Macintosh в 1984 году. Для этой январской демо-версии требовалось 512 килобайт оперативной памяти. В результате он не мог работать со 128 килобайтами оперативной памяти, с которыми фактически поставлялся первый Mac. [74] Итак, демонстрация была проведена на прототипе Mac 512k, хотя присутствующим об этом не сообщили, а демонстрация синтеза вызвала значительный ажиотаж вокруг Macintosh. В начале 1990-х годов Apple расширила свои возможности, предложив общесистемную поддержку преобразования текста в речь. С появлением более быстрых компьютеров на базе PowerPC они включили в себя более качественную выборку голоса. Apple также внедрила распознавание речи в свои системы, что обеспечило гибкий набор команд. Совсем недавно Apple добавила голоса на основе сэмплов. Начав с любопытства, речевая система Apple Macintosh превратилась в полностью поддерживаемую программу PlainTalk для людей с проблемами зрения. VoiceOver впервые был представлен в 2005 году в Mac OS X Tiger (10.4). В версии 10.4 (Tiger) и первых выпусках 10.5 ( Leopard ) в Mac OS X была только одна стандартная голосовая доставка. Начиная с версии 10.6 ( Snow Leopard ), пользователь может выбирать несколько голосов из широкого списка. Голоса VoiceOver обеспечивают реалистичное дыхание между предложениями, а также улучшенную четкость при высокой скорости чтения по сравнению с PlainTalk. Mac OS X также включает, скажем, приложение на основе командной строки , которое преобразует текст в звуковую речь. Стандартные дополнения AppleScript включают глагол «сказать», который позволяет сценарию использовать любой из установленных голосов и контролировать высоту звука, скорость речи и модуляцию произнесенного текста.

Используется в Alexa и как «Программное обеспечение как услуга» в AWS [75] (с 2017 г.).

Второй операционной системой с расширенными возможностями синтеза речи была AmigaOS , представленная в 1985 году. Синтез голоса был лицензирован Commodore International у компании SoftVoice, Inc., которая также разработала оригинальную систему преобразования текста в речь MacinTalk . В нем была реализована полная система голосовой эмуляции американского английского с мужскими и женскими голосами и маркерами индикатора «стресса», что стало возможным благодаря аудиочипсету Amiga . [76] Система синтеза была разделена на библиотеку переводчика, которая преобразовывала неограниченный английский текст в стандартный набор фонетических кодов, и устройство рассказчика, реализовавшее формантную модель генерации речи. AmigaOS также имела высокоуровневый « Speak Handler », что позволяло пользователям командной строки перенаправлять текстовый вывод в речь. Синтез речи иногда использовался в сторонних программах, особенно в текстовых процессорах и образовательном программном обеспечении. Программное обеспечение синтеза практически не изменилось с момента первого выпуска AmigaOS, и Commodore в конечном итоге удалил поддержку синтеза речи, начиная с AmigaOS 2.1.

Несмотря на ограничение фонем американского английского языка, была разработана неофициальная версия с многоязычным синтезатором речи. При этом использовалась расширенная версия библиотеки переводчика, которая могла переводить несколько языков с учетом набора правил для каждого языка. [77]

Современные настольные системы Windows могут использовать компоненты SAPI 4 и SAPI 5 для поддержки синтеза и распознавания речи . SAPI 4.0 был доступен как дополнительное дополнение для Windows 95 и Windows 98 . В Windows 2000 добавлен экранный диктор — утилита преобразования текста в речь для людей с нарушениями зрения. Сторонние программы, такие как JAWS для Windows, Window-Eyes, Non-visual Desktop Access, Supernova и System Access, могут выполнять различные задачи преобразования текста в речь, такие как чтение текста вслух с указанного веб-сайта, учетной записи электронной почты, текстового документа, Буфер обмена Windows, набор текста с клавиатуры пользователя и т. д. Не все программы могут использовать синтез речи напрямую. [78] Некоторые программы могут использовать плагины, расширения или надстройки для чтения текста вслух. Доступны сторонние программы, которые могут читать текст из системного буфера обмена.

Microsoft Speech Server — это серверный пакет для синтеза и распознавания голоса. Он предназначен для использования в сети с веб-приложениями и центрами обработки вызовов .

С 1971 по 1996 год Votrax произвела ряд коммерческих компонентов синтезаторов речи. Синтезатор Votrax был включен в читальную машину Kurzweil первого поколения для слепых.

Преобразование текста в речь (TTS) означает способность компьютеров читать текст вслух. Механизм TTS преобразует письменный текст в фонематическое представление, а затем преобразует фонематическое представление в сигналы, которые можно вывести в виде звука. Движки TTS с разными языками, диалектами и специализированными словарями доступны через сторонних издателей. [79]

В версии Android 1.6 добавлена поддержка синтеза речи (TTS). [80]

В настоящее время существует ряд приложений , плагинов и гаджетов, которые могут читать сообщения непосредственно из почтового клиента и веб-страницы из веб-браузера или панели инструментов Google . Некоторые специализированные программы могут комментировать RSS-каналы . С одной стороны, онлайн-рассказчики RSS упрощают доставку информации, позволяя пользователям слушать свои любимые источники новостей и конвертировать их в подкасты . С другой стороны, онлайновые программы чтения RSS доступны практически на любом персональном компьютере, подключенном к Интернету. Пользователи могут загружать сгенерированные аудиофайлы на портативные устройства, например, с помощью приемника подкастов , и слушать их во время прогулки, пробежки или по дороге на работу.

Растущей областью TTS на базе Интернета являются вспомогательные веб-технологии , например, «Browseloud» от британской компании и Readspeaker . Он может предоставить функциональность TTS любому человеку (по соображениям доступности, удобства, развлечения или информации), имеющему доступ к веб-браузеру. Некоммерческий проект Pediaphon был создан в 2006 году для предоставления веб-интерфейса TTS, аналогичного Википедии. [81]

Другая работа проводится в контексте W3C через группу W3C Audio Incubator Group с участием BBC и Google Inc.

Доступны некоторые системы программного обеспечения с открытым исходным кодом , такие как:

На конференции по нейронным системам обработки информации (NeurIPS) 2018 года исследователи из Google представили работу «Перенос обучения от проверки говорящего к синтезу текста в речь с несколькими динамиками», которая переносит обучение от проверки говорящего для достижения синтеза речи, что можно заставить звучать почти так же, как кто-либо, используя образец речи продолжительностью всего 5 секунд. [84]

Также исследователи из Baidu Research представили систему клонирования голоса с аналогичными целями на конференции NeurIPS 2018 года [85] , хотя результат оказался довольно неубедительным.

К 2019 году цифровые звуковые копии попали в руки преступников: исследователям Symantec известны три случая, когда технология цифровых звуковых аналогов использовалась в преступных целях. [86] [87]

Это увеличивает нагрузку на ситуацию с дезинформацией в сочетании с фактами, которые

В марте 2020 года было выпущено бесплатное веб-приложение 15.ai , которое генерирует высококачественные голоса множества вымышленных персонажей из различных медиа-источников. [90] Первоначальными персонажами были ГЛаДОС из «Портала» , Сумеречная Искорка и Флаттершай из сериала « Мой маленький пони: Дружба – это чудо» , а также Десятый Доктор из «Доктора Кто» .

Для преобразования текста в речь в формате, совместимом с XML , создан ряд языков разметки . Самым последним из них является язык разметки синтеза речи (SSML), который стал рекомендацией W3C в 2004 году. Более старые языки разметки синтеза речи включают язык разметки речи Java ( JSML ) и SABLE . Хотя каждый из них был предложен в качестве стандарта, ни один из них не получил широкого распространения. [ нужна цитата ]

Языки разметки синтеза речи отличаются от языков разметки диалогов. VoiceXML , например, включает в себя теги, связанные с распознаванием речи, управлением диалогами и тональным набором номера, в дополнение к разметке преобразования текста в речь. [ нужна цитата ]

Синтез речи уже давно стал жизненно важным инструментом ассистивных технологий, и его применение в этой области значимо и широко распространено. Это позволяет устранить экологические барьеры для людей с широким спектром инвалидности. Самым долгим применением программ чтения с экрана для людей с нарушениями зрения является использование систем преобразования текста в речь в настоящее время широко используется людьми с дислексией и другими нарушениями чтения , а также детьми, не умеющими читать. [91] Их также часто используют для помощи людям с серьезными нарушениями речи , обычно с помощью специального средства голосовой связи . [92] Работа по персонализации синтетического голоса, чтобы он лучше соответствовал личности человека или историческому голосу, становится доступной. [93] Известным применением синтеза речи была « Читающая машина для слепых» Kurzweil , которая включала в себя программное обеспечение для преобразования текста в фонетику, основанное на разработках Haskins Laboratories , и синтезатор «черного ящика», созданный Votrax . [94]

Методы синтеза речи также используются в развлекательных программах, таких как игры и анимация. В 2007 году Animo Limited объявила о разработке пакета программных приложений на основе своего программного обеспечения для синтеза речи FineSpeech, специально предназначенного для клиентов в индустрии развлечений и способного генерировать повествование и строки диалога в соответствии с требованиями пользователя. [95] Приложение достигло зрелости в 2008 году, когда NEC Biglobe анонсировала веб-сервис, который позволяет пользователям создавать фразы из голосов персонажей японского аниме- сериала Code Geass: Lelouch of the Rebellion R2 . [96] 15.ai часто использовался для создания контента в различных фандомах , включая фандом My Little Pony: Friendship Is Magic , фандом Team Fortress 2 , фандом Portal и фандом SpongeBob SquarePants . [97]

Преобразование текста в речь для людей с ограниченными возможностями и средства коммуникации с нарушениями речи стали широко доступны. Преобразование текста в речь также находит новые применения; например, синтез речи в сочетании с распознаванием речи позволяет взаимодействовать с мобильными устройствами через интерфейсы обработки естественного языка . Некоторые пользователи также создали виртуальных помощников с искусственным интеллектом , используя 15.ai и внешнее программное обеспечение для голосового управления. [98] [99]

Преобразование текста в речь также используется при овладении вторым языком. Например, Voki — это образовательный инструмент, созданный Oddcast, который позволяет пользователям создавать свои собственные говорящие аватары, используя разные акценты. Их можно отправлять по электронной почте, размещать на веб-сайтах или публиковать в социальных сетях.

Создатели контента использовали инструменты клонирования голоса, чтобы воссоздать свои голоса для подкастов, [100] [101] повествования, [102] и комедийных шоу. [103] [104] [105] Издатели и авторы также использовали такое программное обеспечение для озвучивания аудиокниг и информационных бюллетеней. [106] [107] Другая область применения — создание видео с помощью ИИ с говорящими головами. Веб-приложения и видеоредакторы, такие как Elai.io или Synthesia , позволяют пользователям создавать видеоконтент с участием аватаров искусственного интеллекта, которые заставляют говорить с использованием технологии преобразования текста в речь. [108] [109]

Синтез речи является ценным вычислительным средством для анализа и оценки речевых нарушений. Синтезатор качества голоса , разработанный Хорхе К. Лусеро и др. в Университете Бразилиа имитирует физику фонации и включает модели дрожания и тремора голосовых частот, шума воздушного потока и асимметрии гортани. [45] Синтезатор использовался для имитации тембра дисфонических динамиков с контролируемыми уровнями шероховатости, одышки и напряжения. [46]