Искусственный интеллект ( ИИ ) — это интеллект машин или программного обеспечения , в отличие от интеллекта людей или других животных. Это область компьютерных наук , которая разрабатывает и изучает интеллектуальные машины. Такие машины можно назвать ИИ.

Технология искусственного интеллекта широко используется в промышленности, правительстве и науке. Некоторые громкие приложения: продвинутые поисковые системы в Интернете (например, Google Search ), системы рекомендаций (используемые YouTube , Amazon и Netflix ), понимание человеческой речи (например, Google Assistant , Siri и Alexa ), беспилотные автомобили. (например, Waymo ), генеративные и творческие инструменты ( ChatGPT и AI art ), а также сверхчеловеческая игра и анализ в стратегических играх (таких как шахматы и Го ). [1]

Алан Тьюринг был первым человеком, проведшим серьезные исследования в области, которую он назвал машинным интеллектом. [2] Искусственный интеллект был основан как академическая дисциплина в 1956 году. [3] Эта область прошла через несколько циклов оптимизма [4] [5] , за которыми последовали разочарования и потеря финансирования. [6] [7] Финансирование и интерес значительно возросли после 2012 года, когда глубокое обучение превзошло все предыдущие методы искусственного интеллекта, [8] и после 2017 года с архитектурой- трансформером . [9] Это привело к весне ИИ в начале 2020-х годов, когда компании, университеты и лаборатории, преимущественно базирующиеся в Соединенных Штатах, стали пионерами значительных достижений в области искусственного интеллекта. [10]

Различные подобласти исследований ИИ сосредоточены вокруг конкретных целей и использования определенных инструментов. Традиционные цели исследований ИИ включают рассуждение , представление знаний , планирование , обучение , обработку естественного языка , восприятие и поддержку робототехники . [a] Общий интеллект (способность выполнять любую задачу, которую может выполнить человек) входит в число долгосрочных целей этой области. [11]

Чтобы решить эти проблемы, исследователи ИИ адаптировали и интегрировали широкий спектр методов решения проблем, включая поисковую и математическую оптимизацию , формальную логику, искусственные нейронные сети и методы, основанные на статистике , исследовании операций и экономике . [b] ИИ также опирается на психологию , лингвистику , философию , нейробиологию и другие области. [12]

Общая проблема моделирования (или создания) интеллекта разбита на подзадачи. Они состоят из определенных черт или способностей, которые исследователи ожидают от интеллектуальной системы. Описанные ниже черты получили наибольшее внимание и охватывают сферу исследований ИИ. [а]

Ранние исследователи разработали алгоритмы, имитирующие пошаговые рассуждения, которые люди используют, когда решают головоломки или делают логические выводы. [13] К концу 1980-х и 1990-м годам были разработаны методы работы с неопределенной или неполной информацией с использованием концепций теории вероятности и экономики . [14]

Многие из этих алгоритмов недостаточны для решения больших задач рассуждения, потому что они испытывают «комбинаторный взрыв»: они становились экспоненциально медленнее по мере того, как проблемы становились больше. [15] Даже люди редко используют пошаговые выводы, которые могли смоделировать ранние исследования ИИ. Они решают большинство своих проблем, используя быстрые и интуитивные суждения. [16] Точные и эффективные рассуждения — нерешенная проблема.

Представление знаний и инженерия знаний [17] позволяют программам ИИ разумно отвечать на вопросы и делать выводы о фактах реального мира. Формальные представления знаний используются при индексировании и поиске на основе контента, [18] интерпретации сцен, [19] поддержке клинических решений, [20] обнаружении знаний (извлечение «интересных» и практических выводов из больших баз данных) [21] и других областях. . [22]

База знаний — это совокупность знаний, представленная в форме, которую может использовать программа. Онтология — это набор объектов, отношений, концепций и свойств, используемых в определенной области знаний . [23] Базы знаний должны представлять такие вещи, как: объекты, свойства, категории и отношения между объектами; [24] ситуации, события, состояния и время; [25] причины и следствия; [26] знание о знании (то, что мы знаем о том, что знают другие люди); [27] рассуждения по умолчанию (вещи, которые люди предполагают, являются истинными, пока им не скажут иначе, и останутся истинными, даже когда другие факты меняются); [28] и многие другие аспекты и области знаний.

Среди наиболее сложных проблем представления знаний можно назвать: широту знаний здравого смысла (набор атомарных фактов, известных среднестатистическому человеку, огромен); [29] и субсимволическая форма большинства здравомыслящих знаний (многое из того, что знают люди, не представлено в виде «фактов» или «утверждений», которые они могли бы выразить устно). [16] Существует также сложность приобретения знаний , проблема получения знаний для приложений ИИ. [с]

«Агент» — это все, что воспринимает и совершает действия в мире. Рациональный агент имеет цели или предпочтения и предпринимает действия для их достижения. [d] [32] При автоматизированном планировании у агента есть конкретная цель. [33] При автоматизированном принятии решений у агента есть предпочтения: есть ситуации, в которых он предпочел бы оказаться, а некоторых ситуаций он пытается избежать. Агент, принимающий решения, присваивает каждой ситуации число (называемое « полезностью »), которое измеряет, насколько агент предпочитает ее. Для каждого возможного действия он может рассчитать « ожидаемую полезность »: полезность всех возможных результатов действия, взвешенную по вероятности того, что результат произойдет. Затем он может выбрать действие с максимальной ожидаемой полезностью. [34]

При классическом планировании агент точно знает, каким будет эффект любого действия. [35] Однако в большинстве задач реального мира агент может не быть уверен в ситуации, в которой он находится (она «неизвестна» или «ненаблюдаема»), и он может не знать наверняка, что произойдет после каждого возможного действия ( оно не «детерминировано»). Он должен выбрать действие, сделав вероятностное предположение, а затем повторно оценить ситуацию, чтобы увидеть, сработало ли действие. [36]

В некоторых задачах предпочтения агента могут быть неопределенными, особенно если в решении участвуют другие агенты или люди. Их можно изучить (например, с помощью обратного обучения с подкреплением ), или агент может искать информацию для улучшения своих предпочтений. [37] Теорию ценности информации можно использовать для взвешивания ценности исследовательских или экспериментальных действий. [38] Пространство возможных будущих действий и ситуаций обычно непреодолимо велико, поэтому агенты должны предпринимать действия и оценивать ситуации, не зная, каким будет результат.

Марковский процесс принятия решений имеет модель перехода, которая описывает вероятность того, что конкретное действие изменит состояние определенным образом, и функцию вознаграждения , которая определяет полезность каждого состояния и стоимость каждого действия. Политика связывает решение с каждым возможным состоянием . Политика может быть рассчитана (например, путем итерации ), быть эвристической или ее можно изучить. [39]

Теория игр описывает рациональное поведение нескольких взаимодействующих агентов и используется в программах ИИ, которые принимают решения с участием других агентов. [40]

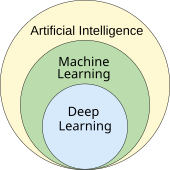

Машинное обучение — это исследование программ, которые могут автоматически улучшить свою производительность при выполнении определенной задачи. [41] Он был частью ИИ с самого начала. [э]

Существует несколько видов машинного обучения. Обучение без учителя анализирует поток данных, находит закономерности и делает прогнозы без какого-либо другого руководства. [44] Обучение с учителем требует, чтобы человек сначала помечал входные данные, и существует две основные разновидности: классификация (когда программа должна научиться предсказывать, к какой категории принадлежат входные данные) и регрессия (когда программа должна выводить числовую функцию на основе при цифровом вводе). [45]

При обучении с подкреплением агент вознаграждается за хорошие ответы и наказывается за плохие. Агент учится выбирать ответы, которые классифицируются как «хорошие». [46] Трансферное обучение — это когда знания, полученные при решении одной проблемы, применяются к новой проблеме. [47] Глубокое обучение — это тип машинного обучения, при котором входные данные обрабатываются через биологически созданные искусственные нейронные сети для всех этих типов обучения. [48]

Теория компьютерного обучения может оценивать учащихся по сложности вычислений , по сложности выборки (сколько данных требуется) или по другим понятиям оптимизации . [49]

Обработка естественного языка (NLP) [50] позволяет программам читать, писать и общаться на человеческих языках, таких как английский . Конкретные проблемы включают распознавание речи , синтез речи , машинный перевод , извлечение информации , поиск информации и ответы на вопросы . [51]

Ранние работы, основанные на порождающей грамматике и семантических сетях Ноама Хомского , имели трудности с устранением смысловой неоднозначности [f] , если только они не ограничивались небольшими областями, называемыми « микромирами » (из-за проблемы знания здравого смысла [29] ). Маргарет Мастерман считала, что именно значение, а не грамматика, является ключом к пониманию языков, и что основой вычислительной структуры языка должны быть тезаурусы , а не словари.

Современные методы глубокого обучения для НЛП включают встраивание слов (представление слов, как правило, в виде векторов , кодирующих их значение), [52] преобразователи (архитектура глубокого обучения, использующая механизм внимания ) [53] и другие. [54] В 2019 году генеративные предварительно обученные языковые модели-трансформеры (или «GPT») начали генерировать связный текст, [55] [56] , а к 2023 году эти модели смогли получить оценки человеческого уровня на экзамене SAT . test, GRE test и многие другие реальные приложения. [57]

Машинное восприятие — это способность использовать данные от датчиков (таких как камеры, микрофоны, беспроводные сигналы, активный лидар , гидролокатор, радар и тактильные датчики ) для определения аспектов мира. Компьютерное зрение — это способность анализировать визуальную информацию. [58]

Эта область включает в себя распознавание речи , [59] классификацию изображений , [60] распознавание лиц , распознавание объектов , [61] и роботизированное восприятие . [62]

Аффективные вычисления — это междисциплинарный комплекс, включающий системы, которые распознают, интерпретируют, обрабатывают или моделируют человеческие чувства, эмоции и настроение . [64] Например, некоторые виртуальные помощники запрограммированы разговаривать разговорно или даже шутливо подшучивать; это делает их более чувствительными к эмоциональной динамике человеческого взаимодействия или иным образом облегчает взаимодействие человека с компьютером .

Однако это дает наивным пользователям нереальное представление об интеллекте существующих компьютерных агентов. [65] Умеренные успехи, связанные с аффективными вычислениями, включают текстовый анализ настроений и, в последнее время, мультимодальный анализ настроений , в котором ИИ классифицирует аффекты, отображаемые субъектом, записанным на видео. [66]

Машина с общим искусственным интеллектом должна быть способна решать широкий спектр задач с широтой и универсальностью, аналогичной человеческому интеллекту. [11]

Исследования ИИ используют широкий спектр методов для достижения вышеуказанных целей. [б]

ИИ может решить многие проблемы, разумно перебирая множество возможных решений. [67] В ИИ используются два совершенно разных типа поиска: поиск в пространстве состояний и локальный поиск .

Поиск в пространстве состояний просматривает дерево возможных состояний, чтобы попытаться найти целевое состояние. [68] Например, алгоритмы планирования просматривают деревья целей и подцелей, пытаясь найти путь к целевой цели, этот процесс называется анализом средств и результатов . [69]

Простого исчерпывающего поиска [70] редко бывает достаточно для решения большинства реальных задач: пространство поиска (количество мест для поиска) быстро вырастает до астрономических цифр . В результате поиск выполняется слишком медленно или никогда не завершается. [15] « Эвристика » или «эмпирические правила» могут помочь расставить приоритеты в выборе, который с большей вероятностью приведет к достижению цели. [71]

Состязательный поиск используется для игровых программ, таких как шахматы или го. Он просматривает дерево возможных ходов и контрходов в поисках выигрышной позиции. [72]

Локальный поиск использует математическую оптимизацию для поиска решения проблемы. Он начинается с некоторой формы предположения и постепенно совершенствует его. [73]

Градиентный спуск — это тип локального поиска, который оптимизирует набор числовых параметров путем постепенной их корректировки для минимизации функции потерь . Варианты градиентного спуска обычно используются для обучения нейронных сетей. [74]

Другой тип локального поиска — эволюционные вычисления , целью которых является итеративное улучшение набора возможных решений путем «мутации» и «рекомбинации» их, отбирая только наиболее приспособленных для выживания в каждом поколении. [75]

Процессы распределенного поиска могут координироваться с помощью алгоритмов роевого интеллекта . Двумя популярными роевыми алгоритмами, используемыми в поиске, являются оптимизация роя частиц (вдохновленная птичьими стаями ) и оптимизация колонии муравьев (вдохновленная муравьиными следами ). [76]

Формальная логика используется для рассуждений и представления знаний . [77] Формальная логика существует в двух основных формах: логика высказываний (которая оперирует утверждениями, которые являются истинными или ложными, и использует логические связки, такие как «и», «или», «не» и «подразумевается») [78] и предикат. логика (которая также оперирует объектами, предикатами и отношениями и использует кванторы , такие как « Каждый X есть Y » и «Есть некоторые X , которые являются Y »). [79]

Логический вывод (или дедукция ) — это процесс доказательства нового утверждения ( заключения ) на основе других утверждений, истинность которых уже известна (посылок ) . [80] Логическая база знаний также обрабатывает запросы и утверждения как особый случай вывода. [81] Правило вывода описывает , какой этап доказательства является допустимым . Самым общим правилом вывода является разрешение . [82] Умозаключение можно свести к поиску пути, ведущего от посылок к выводам, где каждый шаг представляет собой применение правила вывода . [83] Вывод, выполненный таким образом, неразрешим, за исключением коротких доказательств в ограниченных областях. Эффективного, мощного и общего метода обнаружено не было.

Нечеткая логика присваивает «степень истинности» от 0 до 1. Таким образом, она может обрабатывать расплывчатые и частично истинные утверждения. [84] Немонотонные логики предназначены для обработки рассуждений по умолчанию . [28] Для описания многих сложных областей были разработаны другие специализированные версии логики (см. представление знаний выше).

Многие проблемы ИИ (в том числе рассуждения, планирование, обучение, восприятие и робототехника) требуют от агента работы с неполной или неопределенной информацией. Исследователи искусственного интеллекта разработали ряд инструментов для решения этих проблем, используя методы теории вероятностей и экономики. [85]

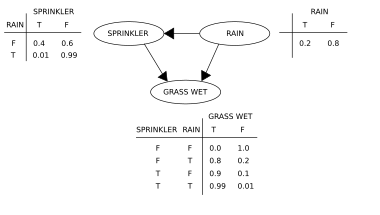

Байесовские сети [86] представляют собой очень общий инструмент, который можно использовать для решения многих задач, включая рассуждение (с использованием алгоритма байесовского вывода ), [g] [88] обучение (с использованием алгоритма максимизации ожидания ), [h] [90] планирование (с использованием сетей принятия решений ) [91] и восприятие (с использованием динамических байесовских сетей ). [92]

Вероятностные алгоритмы также могут использоваться для фильтрации, прогнозирования, сглаживания и поиска объяснений потоков данных, помогая системам восприятия анализировать процессы, происходящие во времени (например, скрытые модели Маркова или фильтры Калмана ). [92]

Были разработаны точные математические инструменты, которые анализируют, как агент может делать выбор и планировать, используя теорию принятия решений , анализ решений , [93] и теорию ценности информации . [94] Эти инструменты включают такие модели, как марковские процессы принятия решений , [95] динамические сети принятия решений , [92] теория игр и проектирование механизмов . [96]

Простейшие приложения ИИ можно разделить на два типа: классификаторы (например, «если блестит, то ромб»), с одной стороны, и контроллеры (например, «если алмаз, то поднимите»), с другой стороны. Классификаторы [97] — это функции, которые используют сопоставление с образцом для определения наиболее близкого соответствия. Их можно доработать на основе выбранных примеров с помощью обучения с учителем . Каждый шаблон (также называемый « наблюдением ») помечен определенным предопределенным классом. Все наблюдения в сочетании с их метками классов известны как набор данных . Когда получено новое наблюдение, оно классифицируется на основе предыдущего опыта. [45]

Существует множество видов классификаторов. Дерево решений — это самый простой и наиболее широко используемый алгоритм символьного машинного обучения. [98] Алгоритм K-ближайшего соседа был наиболее широко используемым аналоговым ИИ до середины 1990-х годов, а методы ядра , такие как машина опорных векторов (SVM), вытеснили k-ближайшего соседа в 1990-х годах. [99] Наивный байесовский классификатор, как сообщается, является «наиболее широко используемым обучающим устройством» [100] в Google, отчасти из-за его масштабируемости. [101] Нейронные сети также используются в качестве классификаторов. [102]

Искусственная нейронная сеть основана на наборе узлов, также известных как искусственные нейроны , которые в общих чертах моделируют нейроны биологического мозга. Он обучен распознавать закономерности, и после обучения он сможет распознавать эти закономерности в свежих данных. Есть вход, как минимум один скрытый слой узлов и выход. Каждый узел применяет функцию, и как только вес пересекает указанный порог, данные передаются на следующий уровень. Сеть обычно называется глубокой нейронной сетью, если она имеет как минимум два скрытых слоя. [102]

Алгоритмы обучения нейронных сетей используют локальный поиск для выбора весов, которые дадут правильный результат для каждого входного сигнала во время обучения. Наиболее распространенным методом обучения является алгоритм обратного распространения ошибки . [103] Нейронные сети учатся моделировать сложные взаимосвязи между входными и выходными данными и находить закономерности в данных. Теоретически нейронная сеть может изучить любую функцию. [104]

В нейронных сетях прямого распространения сигнал проходит только в одном направлении. [105] Рекуррентные нейронные сети подают выходной сигнал обратно на вход, что позволяет кратковременно запоминать предыдущие входные события. Долговременная краткосрочная память является наиболее успешной сетевой архитектурой для рекуррентных сетей. [106] Перцептроны [107] используют только один слой нейронов, глубокое обучение [108] использует несколько слоев.Сверточные нейронные сети усиливают связь между нейронами, находящимися «близко» друг к другу — это особенно важно при обработке изображений , где локальный набор нейронов должен идентифицировать «край» , прежде чем сеть сможет идентифицировать объект. [109]

Глубокое обучение [108] использует несколько слоев нейронов между входами и выходами сети. Несколько слоев могут постепенно извлекать функции более высокого уровня из необработанных входных данных. Например, при обработке изображений нижние уровни могут идентифицировать края, а более высокие уровни могут идентифицировать понятия, относящиеся к человеку, такие как цифры, буквы или лица. [110]

Глубокое обучение значительно улучшило производительность программ во многих важных областях искусственного интеллекта, включая компьютерное зрение , распознавание речи , обработку естественного языка , классификацию изображений [111] и другие. Причина, по которой глубокое обучение так хорошо работает во многих приложениях, по состоянию на 2023 год неизвестна . был описан многими людьми еще в 1950-х годах) [i] но из-за двух факторов: невероятного увеличения мощности компьютера (включая стократное увеличение скорости за счет перехода на графические процессоры ) и доступности огромных объемов обучения данные, особенно гигантские наборы данных, используемые для эталонного тестирования, такие как ImageNet . [Дж]

Генеративные предварительно обученные преобразователи (GPT) — это большие языковые модели , основанные на семантических отношениях между словами в предложениях ( обработка естественного языка ). Текстовые модели GPT предварительно обучаются на большом массиве текста, который может быть взят из Интернета. Предварительное обучение заключается в предсказании следующего токена (токеном обычно является слово, подслово или знак препинания). В ходе этого предварительного обучения модели GPT накапливают знания о мире, а затем могут генерировать человеческий текст, неоднократно прогнозируя следующий токен. Как правило, последующий этап обучения делает модель более правдивой, полезной и безвредной, обычно с помощью метода, называемого обучением с подкреплением на основе обратной связи с человеком (RLHF). Текущие модели GPT по-прежнему склонны генерировать ложные сведения, называемые « галлюцинациями », хотя это можно уменьшить с помощью RLHF и качественных данных. Они используются в чат-ботах , которые позволяют задать вопрос или запросить задачу простым текстом. [121] [122]

Текущие модели и сервисы включают: Bard , ChatGPT , Grok , Claude , Copilot и LLaMA . [123] Мультимодальные модели GPT могут обрабатывать различные типы данных ( модальности ), такие как изображения, видео, звук и текст. [124]

В конце 2010-х годов графические процессоры (ГП), которые все чаще разрабатывались с учетом особенностей ИИ и использовались со специализированным программным обеспечением TensorFlow , заменили ранее использовавшиеся центральные процессоры (ЦП) в качестве доминирующего средства для крупномасштабных (коммерческих и академических) проектов. обучение моделей машинного обучения . [125] Исторически использовались специализированные языки, такие как Lisp , Prolog , Python и другие.

Технологии искусственного интеллекта и машинного обучения используются в большинстве важнейших приложений 2020-х годов, включая: поисковые системы (такие как Google Search ), таргетинг онлайн-рекламы , системы рекомендаций (предлагаемые Netflix , YouTube или Amazon ), привлечение интернет-трафика , таргетированную рекламу. ( AdSense , Facebook ), виртуальные помощники (такие как Siri или Alexa ), автономные транспортные средства (включая дроны , ADAS и беспилотные автомобили ), автоматический языковой перевод ( Microsoft Translator , Google Translate ), распознавание лиц ( Apple Face ID или DeepFace от Microsoft и FaceNet от Google ) и маркировка изображений (используется Facebook , iPhoto от Apple и TikTok ).

Применение ИИ в медицине и медицинских исследованиях потенциально может улучшить уход за пациентами и качество их жизни. [126] Через призму клятвы Гиппократа медицинские работники этически обязаны использовать ИИ, если приложения могут более точно диагностировать и лечить пациентов.

Для медицинских исследований ИИ является важным инструментом обработки и интеграции больших данных . Это особенно важно для развития органоидной и тканевой инженерии , где микроскопическая визуализация используется в качестве ключевого метода производства. [127] Было высказано предположение, что ИИ может преодолеть несоответствие в финансировании, выделяемом на различные области исследований. [127] Новые инструменты ИИ могут углубить наше понимание биомедицинских путей. Например, AlphaFold 2 (2021) продемонстрировал способность аппроксимировать трехмерную структуру белка за часы, а не за месяцы. [128] В 2023 году сообщалось, что открытие лекарств под руководством ИИ помогло найти класс антибиотиков, способных убивать два разных типа устойчивых к лекарствам бактерий. [129]

Игровые программы используются с 1950-х годов для демонстрации и тестирования самых передовых методов искусственного интеллекта. [130] Deep Blue стала первой компьютерной шахматной системой, победившей действующего чемпиона мира по шахматам Гарри Каспарова 11 мая 1997 года . [131] В 2011 году в игре Jeopardy! викторина-шоу показательный матч, вопросно -ответная система IBM , Уотсон , победилдва величайших Jeopardy! чемпионы Брэд Раттер и Кен Дженнингс со значительным отрывом. [132] В марте 2016 года AlphaGo выиграла 4 из 5 игр в го в матче с чемпионом по го Ли Седолем , став первой компьютерной системой игры в го, обыгравшей профессионального игрока в го без гандикапов . Затем в 2017 году он победил Кэ Цзе , который был лучшим игроком в го в мире. [133] Другие программы обрабатывают игры с несовершенной информацией , например, программа для игры в покер Pluribus [134] . DeepMind разработала все более общие модели обучения с подкреплением , такие как MuZero , которые можно обучить играть в шахматы, го или игры Atari . [135] В 2019 году AlphaStar из DeepMind достигла уровня гроссмейстера в StarCraft II , особенно сложной стратегической игре в реальном времени, которая предполагает неполное знание того, что происходит на карте. [136] В 2021 году ИИ-агент участвовал в соревновании PlayStation Gran Turismo, победив четырех лучших в мире водителей Gran Turismo, используя глубокое обучение с подкреплением. [137]

Различные страны внедряют военные приложения ИИ. Основные приложения расширяют возможности управления и контроля , связи, датчиков, интеграции и совместимости. Исследования направлены на сбор и анализ разведывательной информации, логистику, кибероперации, информационные операции, а также полуавтономные и автономные транспортные средства . Технологии искусственного интеллекта обеспечивают координацию датчиков и исполнительных устройств, обнаружение и идентификацию угроз, маркировку позиций противника, захват целей , координацию и устранение конфликтов в распределенных совместных огнях между объединенными в сеть боевыми машинами с участием пилотируемых и беспилотных групп. ИИ был задействован в военных операциях в Ираке и Сирии.

В ноябре 2023 года вице-президент США Камала Харрис обнародовала подписанную 31 страной декларацию, устанавливающую ограничения на использование IA в военных целях. Обязательства включают в себя проведение юридических проверок для обеспечения соответствия военного ИИ международному праву, а также осторожность и прозрачность при разработке этой технологии. [138]

В начале 2020-х годов генеративный искусственный интеллект получил широкое распространение. В марте 2023 года 58% взрослых американцев слышали о ChatGPT и 14% пробовали его. [139] Возрастающий реализм и простота использования генераторов текста в изображения на основе искусственного интеллекта , таких как Midjourney , DALL-E и Stable Diffusion, вызвали тенденцию к вирусным фотографиям, созданным с помощью искусственного интеллекта. Широкое внимание привлекли фейковая фотография Папы Франциска в белом пуховике, вымышленный арест Дональда Трампа и мистификация нападения на Пентагон , а также использование в профессиональном творчестве. [140] [141]

Существуют также тысячи успешных приложений ИИ, используемых для решения конкретных проблем в конкретных отраслях или учреждениях. В опросе 2017 года каждая пятая компания сообщила, что внедрила искусственный интеллект в некоторые предложения или процессы. [142] Несколько примеров — хранение энергии , медицинская диагностика, военная логистика, приложения, прогнозирующие результат судебных решений, внешняя политика или управление цепочками поставок.

В сельском хозяйстве ИИ помог фермерам определить области, которые нуждаются в ирригации, удобрении, обработке пестицидами или повышении урожайности. Агрономы используют ИИ для проведения исследований и разработок. Искусственный интеллект использовался для прогнозирования времени созревания таких культур, как томаты, мониторинга влажности почвы, управления сельскохозяйственными роботами, проведения прогнозной аналитики, классификации эмоций, вызываемых домашним скотом, свиней, автоматизации теплиц, обнаружения болезней и вредителей, а также экономии воды.

Искусственный интеллект используется в астрономии для анализа растущих объемов доступных данных и приложений, в основном для «классификации, регрессии, кластеризации, прогнозирования, генерации, открытия и развития новых научных идей», например, для открытия экзопланет, прогнозирования солнечной активности и различие между сигналами и инструментальными эффектами в гравитационно-волновой астрономии. Его также можно использовать для деятельности в космосе, такой как исследование космоса, включая анализ данных космических миссий, принятие научных решений по космическим кораблям в режиме реального времени, предотвращение космического мусора и более автономную работу.

ИИ, как и любая мощная технология, имеет потенциальные преимущества и потенциальные риски. ИИ может способствовать развитию науки и находить решения серьезных проблем: Демис Хассабис из Deep Mind надеется «разгадать интеллект, а затем использовать его для решения всего остального». [143] Однако по мере того, как использование ИИ стало широко распространенным, было выявлено несколько непредвиденных последствий и рисков. [144]

Любой, кто хочет использовать машинное обучение как часть реальных производственных систем, должен учитывать этику в своих процессах обучения ИИ и стремиться избегать предвзятости. Это особенно актуально при использовании алгоритмов ИИ, которые по своей сути необъяснимы в глубоком обучении. [145]

Алгоритмы машинного обучения требуют больших объемов данных. Методы, используемые для получения этих данных, вызвали обеспокоенность по поводу конфиденциальности , слежки и авторских прав .

Технологические компании собирают широкий спектр данных от своих пользователей, включая онлайн-активность, данные геолокации, видео и аудио. [146] Например, для создания алгоритмов распознавания речи Amazon записала миллионы частных разговоров и позволила временным сотрудникам прослушивать и расшифровывать некоторые из них. [147] Мнения об этой широко распространенной слежке варьируются от тех, кто считает ее неизбежным злом , до тех, для кого она явно неэтична и нарушает право на неприкосновенность частной жизни . [148]

Разработчики ИИ утверждают, что это единственный способ предоставлять ценные приложения. и разработали несколько методов, которые пытаются сохранить конфиденциальность при получении данных, таких как агрегирование данных , деидентификация и дифференциальная конфиденциальность . [149] С 2016 года некоторые эксперты по конфиденциальности, такие как Синтия Дворк , начали рассматривать конфиденциальность с точки зрения справедливости . Брайан Кристиан написал, что эксперты перешли «от вопроса «что они знают» к вопросу «что они с этим делают». [150]

Генеративный ИИ часто обучается на нелицензированных произведениях, защищенных авторским правом, в том числе в таких областях, как изображения или компьютерный код; выходные данные затем используются на основании « добросовестного использования ». Кроме того, владельцы веб-сайтов, которые не хотят, чтобы их контент, защищенный авторским правом, индексировался или «очищался» с помощью ИИ, могут добавить код на свой сайт, как вы бы это сделали, если бы вы не хотели, чтобы ваш веб-сайт индексировался поисковой системой, которая в настоящее время доступна определенным такие сервисы, как OpenAI . Эксперты расходятся во мнениях относительно того, насколько хорошо и при каких обстоятельствах это обоснование будет иметь силу в судах; соответствующие факторы могут включать «цель и характер использования произведения, защищенного авторским правом» и «влияние на потенциальный рынок произведения, защищенного авторским правом». [151] В 2023 году ведущие авторы (в том числе Джон Гришэм и Джонатан Франзен ) подали в суд на компании, занимающиеся ИИ, за использование их работ для обучения генеративному ИИ. [152] [153]

YouTube , Facebook и другие используют системы рекомендаций , чтобы направлять пользователей к большему количеству контента. Целью этих программ искусственного интеллекта было максимальное вовлечение пользователей (то есть единственной целью было заставить людей следить за происходящим). ИИ узнал, что пользователи склонны выбирать дезинформацию , теории заговора и крайне предвзятый контент, и, чтобы удержать их на просмотре, ИИ рекомендовал больше такого контента. Пользователи также склонны смотреть больше контента на одну и ту же тему, поэтому ИИ направлял людей в пузыри фильтров , где они получали несколько версий одной и той же дезинформации. [154] Это убедило многих пользователей в правдивости дезинформации и в конечном итоге подорвало доверие к институтам, СМИ и правительству. [155] Программа ИИ правильно научилась максимизировать свою цель, но результат был вреден для общества. После выборов в США в 2016 году крупные технологические компании предприняли шаги по смягчению проблемы.

В 2022 году генеративный ИИ начал создавать изображения, аудио, видео и текст, неотличимые от реальных фотографий, записей, фильмов или человеческого письма. Злоумышленники могут использовать эту технологию для создания огромного количества дезинформации или пропаганды. [156] Пионер ИИ Джеффри Хинтон выразил обеспокоенность по поводу того, что ИИ, помимо других рисков, позволяет «авторитарным лидерам манипулировать своим электоратом» в больших масштабах. [157]

Приложения машинного обучения будут предвзятыми, если они будут учиться на предвзятых данных. [158] Разработчики могут не знать о существовании предвзятости. [159] Смещение может быть вызвано способом выбора обучающих данных и способом развертывания модели. [160] [158] Если предвзятый алгоритм используется для принятия решений, которые могут серьезно навредить людям (как это может быть в медицине , финансах , наборе персонала , жилищном обеспечении или полиции ), тогда алгоритм может вызвать дискриминацию . [161] Справедливость в машинном обучении — это исследование того, как предотвратить вред, причиняемый алгоритмической предвзятостью. Это стало серьезной областью академических исследований в области ИИ. Исследователи обнаружили, что не всегда возможно определить «справедливость» так, чтобы это удовлетворило все заинтересованные стороны. [162]

28 июня 2015 года новая функция маркировки изображений в Google Фото ошибочно определила Джеки Алсина и его друга как «горилл», потому что они были черными. Система была обучена на наборе данных, который содержал очень мало изображений чернокожих людей, [163] проблема, называемая «несоответствием размера выборки». [164] Google «исправил» эту проблему, запретив системе помечать что-либо как «гориллу». Восемь лет спустя, в 2023 году, Google Photos все еще не смог идентифицировать гориллу, как и аналогичные продукты Apple, Facebook, Microsoft и Amazon. [165]

COMPAS – коммерческая программа, широко используемая судами США для оценки вероятности того, что обвиняемый станет рецидивистом . В 2016 году Джулия Ангвин из ProPublica обнаружила, что КОМПАС демонстрирует расовую предвзятость, несмотря на то, что программе не была указана расовая принадлежность обвиняемых. Хотя частота ошибок как для белых, так и для чернокожих была калибрована равной ровно 61%, ошибки для каждой расы были разными — система постоянно переоценивала вероятность того, что чернокожий человек совершит повторное правонарушение, и недооценивала вероятность того, что белый человек не совершит правонарушение. повторно обидеть. [166] В 2017 году несколько исследователей [k] показали, что COMPAS математически невозможно учесть все возможные меры справедливости, когда базовые показатели повторных правонарушений различаются для белых и чернокожих в данных. [168]

Программа может принимать предвзятые решения, даже если в данных явно не упоминается проблемный признак (например, «раса» или «пол»). Эта функция будет коррелировать с другими функциями (такими как «адрес», «история покупок» или «имя»), и программа будет принимать те же решения на основе этих функций, что и на основе «расы» или «пола». [169] Мориц Хардт сказал: «Самый убедительный факт в этой области исследований заключается в том, что справедливость через слепоту не работает». [170]

Критика COMPAS выявила более глубокую проблему неправильного использования ИИ. Модели машинного обучения созданы для того, чтобы делать «прогнозы», которые действительны только в том случае, если мы предполагаем, что будущее будет похоже на прошлое. Если они обучены на данных, которые включают результаты расистских решений в прошлом, модели машинного обучения должны предсказывать, что расистские решения будут приняты в будущем. К сожалению, если приложение затем использует эти прогнозы в качестве рекомендаций , некоторые из этих «рекомендаций», скорее всего, будут расистскими. [171] Таким образом, машинное обучение не очень подходит для принятия решений в областях, где есть надежда, что будущее будет лучше прошлого. Оно обязательно носит описательный, а не запретительный характер. [л]

Предвзятость и несправедливость могут остаться незамеченными, поскольку разработчики в основном белые и мужчины: среди инженеров ИИ около 4% — чернокожие, а 20% — женщины. [164]

На своей конференции по справедливости, подотчетности и прозрачности 2022 года (ACM FAccT 2022) Ассоциация вычислительной техники в Сеуле, Южная Корея, представила и опубликовала результаты, в которых рекомендуется, чтобы до тех пор, пока системы искусственного интеллекта и робототехники не будут продемонстрированы как свободные от ошибок предвзятости, они небезопасно, а использование самообучающихся нейронных сетей, обученных на огромных нерегулируемых источниках ошибочных интернет-данных, следует ограничить. [173]

.jpg/440px-HiPhi_Z,_IAA_Summit_2023,_Munich_(P1120237).jpg)

Многие системы искусственного интеллекта настолько сложны, что их разработчики не могут объяснить, как они принимают решения. [174] Особенно с глубокими нейронными сетями , в которых существует большое количество нелинейных связей между входными и выходными данными. Но существуют некоторые популярные методы объяснения. [175]

Было много случаев, когда программа машинного обучения прошла строгие тесты, но, тем не менее, узнала нечто иное, чем то, что планировали программисты. Например, было обнаружено, что система, которая может идентифицировать кожные заболевания лучше, чем медицинские работники, на самом деле имеет сильную тенденцию классифицировать изображения с линейкой как «раковые», поскольку изображения злокачественных новообразований обычно включают линейку, показывающую масштаб. [176] Другая система машинного обучения, разработанная для эффективного распределения медицинских ресурсов, классифицирует пациентов с астмой как людей с «низким риском» смерти от пневмонии. Наличие астмы на самом деле является серьезным фактором риска, но, поскольку пациенты, страдающие астмой, обычно получают гораздо больше медицинской помощи, согласно данным обучения, их смерть относительно маловероятна. Корреляция между астмой и низким риском смерти от пневмонии была реальной, но вводящей в заблуждение. [177]

Люди, пострадавшие от решения алгоритма, имеют право на объяснение . Врачи, например, обязаны четко и полностью объяснять причины любого принимаемого ими решения. [ необходимы разъяснения ] [178] Ранние проекты Общего регламента ЕС по защите данных в 2016 году содержали прямое заявление о том, что это право существует. [m] Эксперты отрасли отметили, что это нерешенная проблема, решения которой не видно. Регуляторы утверждали, что тем не менее вред реален: если проблема не имеет решения, инструменты не следует использовать. [179]

DARPA учредило программу XAI («Объяснимый искусственный интеллект») в 2014 году, чтобы попытаться решить эти проблемы. [180]

Существует несколько потенциальных решений проблемы прозрачности. SHAP помогает визуализировать вклад каждой функции в выходные данные. [181] LIME может локально аппроксимировать модель более простой, интерпретируемой моделью. [182] Многозадачное обучение обеспечивает большое количество результатов в дополнение к целевой классификации. Эти другие выходные данные могут помочь разработчикам понять, чему научилась сеть. [183] Деконволюция , DeepDream и другие генеративные методы могут позволить разработчикам видеть, чему научились различные уровни глубокой сети, и выдавать выходные данные, которые могут указывать на то, что изучает сеть. [184]

Смертоносное автономное оружие — это машина, которая обнаруживает, выбирает и поражает человеческие цели без присмотра человека. [n] К 2015 году более пятидесяти стран, как сообщалось, исследовали боевых роботов. [186] Это оружие считается особенно опасным по нескольким причинам: если оно убивает невиновного человека, неясно, кого следует привлечь к ответственности , маловероятно, что оно будет надежно выбирать цели, и, если оно будет производиться в больших масштабах, оно потенциально станет оружием массовое уничтожение . [187] В 2014 году 30 стран (включая Китай) поддержали запрет на автономное оружие в соответствии с Конвенцией ООН о конкретных видах обычного оружия , однако США и другие страны с этим не согласились. [188]

ИИ предоставляет ряд инструментов, которые особенно полезны для авторитарных правительств: интеллектуальные шпионские программы , распознавание лиц и голоса позволяют широкомасштабное наблюдение ; такая слежка позволяет машинному обучению классифицировать потенциальных врагов государства и не дать им скрыться; системы рекомендаций могут точно нацеливаться на пропаганду и дезинформацию для достижения максимального эффекта; дипфейки и генеративный искусственный интеллект помогают создавать дезинформацию; Передовой ИИ может сделать авторитарное централизованное принятие решений более конкурентоспособным по сравнению с либеральными и децентрализованными системами, такими как рынки . [189]

Системы распознавания лиц с использованием искусственного интеллекта используются для массовой слежки , особенно в Китае. [190] [191] В 2019 году в Бангалоре, Индия, были внедрены светофоры, управляемые искусственным интеллектом. Эта система использует камеры для мониторинга плотности трафика и регулировки времени сигнала в зависимости от интервала, необходимого для освобождения трафика. [192] Террористы, преступники и государства-изгои могут использовать ИИ в качестве оружия, например передовые средства цифровой войны и смертоносное автономное оружие . Искусственный интеллект с машинным обучением также способен создавать десятки тысяч токсичных молекул за считанные часы. [193]

С самого начала развития искусственного интеллекта существовали аргументы, например, выдвинутые Джозефом Вайценбаумом , о том, должны ли на самом деле задачи, которые могут быть выполнены компьютерами, выполняться ими, учитывая разницу между компьютерами и людьми, а также между количественный расчет и качественное суждение, основанное на стоимости. [194]

Экономисты часто подчеркивали риски увольнений из ИИ и высказывали предположения о безработице, если не будет адекватной социальной политики для полной занятости. [195]

В прошлом технологии имели тенденцию скорее увеличивать, чем сокращать общую занятость, но экономисты признают, что с ИИ «мы находимся на неизведанной территории». [196] Опрос экономистов показал разногласия относительно того, приведет ли растущее использование роботов и искусственного интеллекта к существенному увеличению долгосрочной безработицы , но в целом они согласны с тем, что это может принести чистую выгоду, если перераспределить прирост производительности . [197] Оценки риска различаются; например, в 2010-х годах Майкл Осборн и Карл Бенедикт Фрей подсчитали, что 47% рабочих мест в США подвергаются «высокому риску» потенциальной автоматизации, в то время как в отчете ОЭСР только 9% рабочих мест в США классифицируются как «высокие риски». [o] [199] Методология спекуляций о будущих уровнях занятости подвергалась критике за отсутствие доказательной базы и за то, что подразумевается, что технологии, а не социальная политика, создают безработицу, а не увольнения. [195]

В отличие от предыдущих волн автоматизации, многие рабочие места среднего класса могут быть ликвидированы искусственным интеллектом; В 2015 году журнал The Economist заявил, что «беспокойство о том, что ИИ может сделать с рабочими местами белых воротничков то же, что паровая энергия сделала с рабочими во время промышленной революции», «стоит отнестись серьезно». [200] Профессии, подверженные крайнему риску, варьируются от помощников юристов до поваров фаст-фуда, в то время как спрос на рабочие места, вероятно, увеличится для профессий, связанных с уходом, от личного здравоохранения до духовенства. [201]

В апреле 2023 года сообщалось, что 70% рабочих мест для китайских иллюстраторов видеоигр были сокращены из-за генеративного искусственного интеллекта. [202] [203]

Утверждалось, что ИИ станет настолько мощным, что человечество может необратимо потерять над ним контроль. Это может, как заявил физик Стивен Хокинг , « означать конец человечества ». [204] Этот сценарий был обычным явлением в научной фантастике, когда компьютер или робот внезапно развивает человеческое «самосознание» (или «чувственность» или «сознание») и становится злонамеренным персонажем. [p] Эти научно-фантастические сценарии вводят в заблуждение по нескольким причинам.

Во-первых, ИИ не требует, чтобы человеческое «чувство» представляло собой экзистенциальный риск. Современные программы искусственного интеллекта ставят перед собой конкретные цели и используют обучение и интеллект для их достижения. Философ Ник Бостром утверждал, что если дать достаточно мощному ИИ практически любую цель, он может решить уничтожить человечество для ее достижения (он использовал пример менеджера фабрики по производству скрепок ). [206] Стюарт Рассел приводит пример домашнего робота, который пытается найти способ убить своего владельца, чтобы предотвратить его отключение от сети, мотивируя это тем, что «вы не сможете принести кофе, если вы мертвы». [207] Чтобы быть безопасным для человечества, сверхинтеллект должен быть искренне связан с моралью и ценностями человечества, чтобы он «фундаментально был на нашей стороне». [208]

Во-вторых, Юваль Ной Харари утверждает, что ИИ не требует тела робота или физического контроля, чтобы представлять экзистенциальный риск. Существенные части цивилизации не являются физическими. Такие вещи, как идеологии , законы , правительство , деньги и экономика, созданы из языка ; они существуют, потому что есть истории, в которые верят миллиарды людей. Нынешняя распространенность дезинформации предполагает, что ИИ может использовать язык, чтобы убедить людей поверить во что угодно, даже совершить разрушительные действия. [209]

Мнения среди экспертов и инсайдеров отрасли неоднозначны: значительная часть их как обеспокоена, так и не обеспокоена риском, исходящим от возможного сверхразумного ИИ. [210] Такие личности, как Стивен Хокинг , Билл Гейтс и Илон Маск , выражали обеспокоенность по поводу экзистенциального риска, связанного с ИИ. [211]

В начале 2010-х годов эксперты утверждали, что риски в будущем слишком далеки, чтобы требовать проведения исследований, или что люди будут представлять ценность с точки зрения сверхразумной машины. [212] Однако после 2016 года изучение текущих и будущих рисков и возможных решений стало серьезным направлением исследований. [213]

Пионеры ИИ, в том числе Фей-Фей Ли , Джеффри Хинтон , Йошуа Бенджио , Синтия Бризил , Рана эль Калиуби , Демис Хассабис , Джой Буоламвини и Сэм Альтман , выразили обеспокоенность по поводу рисков ИИ. В 2023 году многие ведущие эксперты в области ИИ выступили с совместным заявлением, что «Снижение риска исчезновения ИИ должно стать глобальным приоритетом наряду с другими рисками социального масштаба, такими как пандемии и ядерная война». [214]

Другие исследователи, однако, высказались в пользу менее антиутопической точки зрения. Пионер ИИ Юрген Шмидхубер не подписал совместное заявление, подчеркнув, что в 95% всех случаев исследования ИИ направлены на то, чтобы сделать «человеческую жизнь дольше, здоровее и проще». [215] Хотя инструменты, которые сейчас используются для улучшения жизни, также могут быть использованы злоумышленниками, «они также могут быть использованы против плохих актеров». [216] [217] Эндрю Нг также утверждал, что «было бы ошибкой поддаться шумихе вокруг ИИ, связанной с судным днем, и что регуляторы, которые это сделают, принесут пользу только корыстным интересам». [218] Янн ЛеКун «высмеивает антиутопические сценарии своих сверстников, включающие усиленную дезинформацию и даже, в конечном итоге, вымирание человечества». [219]

Возможные варианты ограничения ИИ включают: использование встроенной этики или конституционного ИИ, где компании или правительства могут добавить политику, ограничение высоких уровней вычислительной мощности при обучении, ограничение возможности переписывать собственную кодовую базу, ограничение определенных методов ИИ, но не в обучении. этап, открытый исходный код (прозрачность) или проприетарный (может быть более ограниченный), модель резервного копирования с избыточностью, ограничение безопасности, конфиденциальности и авторских прав, ограничение или контроль памяти, мониторинг в реальном времени, анализ рисков, аварийное отключение, строгое моделирование и тестирование, сертификация модели, оценка известных уязвимостей, ограничение учебных материалов, ограничение доступа к Интернету, определение условий использования.

Дружественный ИИ — это машины, которые с самого начала были разработаны для минимизации рисков и принятия решений, приносящих пользу людям. Элиэзер Юдковски , придумавший этот термин, утверждает, что разработка дружественного ИИ должна быть более высоким приоритетом исследований: это может потребовать больших инвестиций и должно быть завершено до того, как ИИ станет экзистенциальным риском. [220]

У машин, обладающих интеллектом, есть потенциал использовать свой интеллект для принятия этических решений. Область машинной этики предоставляет машинам этические принципы и процедуры для решения этических дилемм. [221] Область машинной этики также называется вычислительной моралью, [221] и была основана на симпозиуме AAAI в 2005 году. [222]

Другие подходы включают «искусственные моральные агенты» Венделла Уоллаха [223] и три принципа Стюарта Дж. Рассела для разработки доказуемо полезных машин. [224]

Этическая допустимость проектов искусственного интеллекта может быть проверена при проектировании, разработке и внедрении системы ИИ. Структура искусственного интеллекта, такая как Care and Act Framework, содержащая значения SUM, разработанная Институтом Алана Тьюринга, тестирует проекты в четырех основных областях: [225] [226]

Другие разработки в области этических норм включают, среди прочего, решения, принятые на конференции Асиломар , Монреальскую декларацию об ответственном ИИ и инициативу IEEE по этике автономных систем; [227] Однако эти принципы не обходятся без критики, особенно в отношении избранных людей, способствующих этим основам. [228]

Содействие благополучию людей и сообществ, на которые влияют эти технологии, требует рассмотрения социальных и этических последствий на всех этапах проектирования, разработки и внедрения системы ИИ, а также сотрудничества между должностными лицами, такими как специалисты по обработке данных, менеджеры по продуктам, инженеры по обработке данных, специалисты по предметной области. специалисты и менеджеры по доставке. [229]

Регулирование искусственного интеллекта — это разработка политики и законов государственного сектора для продвижения и регулирования искусственного интеллекта (ИИ); следовательно, это связано с более широким регулированием алгоритмов. [230] Нормативно-правовая и политическая среда в области ИИ является новой проблемой в юрисдикциях по всему миру. [231] Согласно AI Index в Стэнфорде , ежегодное количество законов, связанных с ИИ, принятых в 127 странах, принявших участие в исследовании, выросло с одного, принятого в 2016 году, до 37, принятых только в 2022 году. [232] [233] В период с 2016 по 2020 год более 30 стран приняли специальные стратегии в области ИИ. [234] Большинство государств-членов ЕС опубликовали национальные стратегии в области искусственного интеллекта, а также Канада, Китай, Индия, Япония, Маврикий, Российская Федерация, Саудовская Аравия, Объединенные Арабские Эмираты, США и Вьетнам. Другие, в том числе Бангладеш, Малайзия и Тунис, находились в процессе разработки собственной стратегии искусственного интеллекта. [234] Глобальное партнерство по искусственному интеллекту было запущено в июне 2020 года, заявив о необходимости разработки ИИ в соответствии с правами человека и демократическими ценностями, чтобы обеспечить общественное доверие к этой технологии. [234] Генри Киссинджер , Эрик Шмидт и Дэниел Хуттенлохер опубликовали в ноябре 2021 года совместное заявление с призывом создать правительственную комиссию по регулированию ИИ. [235] В 2023 году лидеры OpenAI опубликовали рекомендации по управлению сверхинтеллектом, что, по их мнению, может произойти менее чем через 10 лет. [236] В 2023 году ООН также создала консультативный орган для предоставления рекомендаций по управлению ИИ; В состав этого органа входят руководители технологических компаний, правительственные чиновники и ученые. [237]

Согласно опросу Ipsos 2022 года , отношение к ИИ сильно различалось в зависимости от страны; 78% граждан Китая и только 35% американцев согласились, что «продукты и услуги, использующие ИИ, имеют больше преимуществ, чем недостатков». [232] Опрос Reuters /Ipsos , проведенный в 2023 году, показал, что 61% американцев согласны, а 22% не согласны с тем, что ИИ представляет угрозу для человечества. [238] В опросе Fox News 2023 года 35% американцев сочли «очень важным», а еще 41% сочли «несколько важным» регулирование ИИ со стороны федерального правительства, по сравнению с 13%, ответившими «не очень важно». и 8% ответили «совсем не важно». [239] [240]

В ноябре 2023 года в Блетчли-Парке в Великобритании прошел первый глобальный саммит по безопасности ИИ , на котором обсуждались краткосрочные и долгосрочные риски ИИ, а также возможность создания обязательных и добровольных нормативных рамок. [241] 28 стран, включая США, Китай и Европейский Союз, в начале саммита опубликовали декларацию, призывающую к международному сотрудничеству для решения проблем и рисков, связанных с искусственным интеллектом. [242] [243]

Изучение механического или «формального» рассуждения началось с философов и математиков древности. Изучение логики привело непосредственно к теории вычислений Алана Тьюринга , которая предполагала, что машина, перетасовывая такие простые символы, как «0» и «1», может имитировать как математический вывод, так и формальные рассуждения, известную как Церковь Церкви . – Диссертация Тьюринга . [244] Это, наряду с одновременными открытиями в кибернетике и теории информации , побудило исследователей рассмотреть возможность создания «электронного мозга». [д] [246]

Алан Тьюринг думал о машинном интеллекте, по крайней мере, еще в 1941 году, когда он распространил статью о машинном интеллекте, которая могла стать самой ранней статьей в области искусственного интеллекта – хотя сейчас она утеряна. [2] Первой доступной статьей, общепризнанной как «ИИ», была разработка Маккаллуша и Питта для «искусственных нейронов» , полных по Тьюрингу, в 1943 году – первая математическая модель нейронной сети. [247] На эту статью повлияла более ранняя статья Тьюринга « О вычислимых числах » 1936 года, в которой использовались аналогичные логические «нейроны» с двумя состояниями, но он был первым, кто применил ее к функциям нейронов. [2]

Термин «машинный интеллект» использовался Аланом Тьюрингом при его жизни, а после его смерти в 1954 году его позже часто называли «искусственным интеллектом». В 1950 году Тьюринг опубликовал самую известную из своих работ « Вычислительная техника и интеллект » — статью представил широкой публике свою концепцию того, что сейчас известно как тест Тьюринга . Затем последовали три радиопередачи Тьюринга об искусственном интеллекте, лекции: «Интеллектуальные машины, еретическая теория», «Могут ли цифровые компьютеры мыслить»? и панельная дискуссия «Можно ли сказать, что автоматические вычислительные машины думают». К 1956 году в Великобритании компьютерная разведка активно развивалась уже более десяти лет; самые ранние программы искусственного интеллекта были написаны здесь в 1951–1952 годах. [2]

В 1951 году с использованием компьютера Ferranti Mark 1 Манчестерского университета были написаны программы для шашек и шахмат, в которых можно было играть против компьютера. [248] Область американских исследований ИИ была основана на семинаре в Дартмутском колледже в 1956 году. [r] [3] Участники стали лидерами исследований ИИ в 1960-х годах. [s] Они и их студенты создали программы, которые пресса назвала «удивительными»: [t] компьютеры изучали стратегии игры в шашки , решали текстовые задачи по алгебре, доказывали логические теоремы и говорили по-английски. [u] [4] Лаборатории искусственного интеллекта были созданы в ряде университетов Великобритании и США в конце 1950-х — начале 1960-х годов. [2]

Однако они недооценили сложность проблемы. [v] Правительства США и Великобритании прекратили исследовательские исследования в ответ на критику сэра Джеймса Лайтхилла [253] и продолжающееся давление со стороны Конгресса США с целью финансирования более продуктивных проектов . Книга Мински и Паперта «Перцептроны» была воспринята как доказательство того, что искусственные нейронные сети никогда не будут полезны для решения реальных задач, что полностью дискредитировало этот подход. [254] Последовала « зима ИИ », период, когда получение финансирования для проектов ИИ было затруднено. [6]

В начале 1980-х годов исследования ИИ были возрождены благодаря коммерческому успеху экспертных систем , [255] формы программы ИИ, которая имитировала знания и аналитические навыки людей-экспертов. К 1985 году рынок искусственного интеллекта превысил миллиард долларов. В то же время японский компьютерный проект пятого поколения вдохновил правительства США и Великобритании восстановить финансирование академических исследований . [5] Однако, начиная с краха рынка Lisp-машин в 1987 году, ИИ снова потерял репутацию, и началась вторая, более продолжительная зима. [7]

Многие исследователи начали сомневаться в том, что нынешние практики смогут имитировать все процессы человеческого познания, особенно восприятие , робототехнику, обучение и распознавание образов . [256] Ряд исследователей начали изучать «субсимволические» подходы. [257] Исследователи робототехники , такие как Родни Брукс , отвергли «представление» в целом и сосредоточились непосредственно на разработке машин, которые движутся и выживают. [w] Джудея Перл , Лофти Заде и другие разработали методы, которые обрабатывали неполную и неопределенную информацию, делая разумные предположения, а не точную логику. [85] [262] Но самым важным событием стало возрождение « коннекционизма », включая исследования нейронных сетей , Джеффри Хинтоном и другими. [263] В 1990 году Ян ЛеКун успешно показал, что сверточные нейронные сети могут распознавать рукописные цифры, что стало первым из многих успешных применений нейронных сетей. [264]

ИИ постепенно восстановил свою репутацию в конце 1990-х и начале 21 века, используя формальные математические методы и находя конкретные решения конкретных проблем. Эта « узкая » и «формальная» направленность позволила исследователям получать поддающиеся проверке результаты и сотрудничать с другими областями (такими как статистика , экономика и математика ). [265] К 2000 году решения, разработанные исследователями искусственного интеллекта, получили широкое распространение, хотя в 1990-е годы их редко называли «искусственным интеллектом». [266]

Некоторые академические исследователи были обеспокоены тем, что ИИ больше не преследует первоначальную цель — создание универсальных, полностью интеллектуальных машин. Примерно начиная с 2002 года они основали подразделение общего искусственного интеллекта (или «AGI»), в котором к 2010-м годам было несколько хорошо финансируемых учреждений. [11]

Глубокое обучение начало доминировать в отрасли в 2012 году и было внедрено во всех сферах. [8] Для многих конкретных задач от других методов отказались. [x] Успех глубокого обучения был основан как на усовершенствовании аппаратного обеспечения ( более быстрые компьютеры , [268] графические процессоры , облачные вычисления [269] ), так и на доступе к большим объемам данных [270] (включая тщательно подобранные наборы данных, [269] такие как ImageNet ).

Успех глубокого обучения привел к огромному увеличению интереса и финансирования ИИ. [y] Объем исследований в области машинного обучения (измеренный по общему количеству публикаций) увеличился на 50% в 2015–2019 годах, [234] и ВОИС сообщила, что ИИ является самой плодовитой новой технологией с точки зрения количества патентных заявок и выданных патентов. патенты. [271] По данным AI Impacts, примерно в 2022 году только в США около 50 миллиардов долларов ежегодно инвестировалось в ИИ, и около 20% новых выпускников докторских программ в области компьютерных наук в США специализировались в области ИИ; [272] В 2022 году в США существовало около 800 000 вакансий, связанных с «ИИ». [273] Подавляющее большинство достижений произошло в Соединенных Штатах , где их компании, университеты и исследовательские лаборатории проводят исследования в области искусственного интеллекта. [10]

В 2016 году вопросы справедливости и неправильного использования технологий оказались в центре внимания конференций по машинному обучению, количество публикаций значительно увеличилось, появилось финансирование, и многие исследователи переориентировали свою карьеру на эти проблемы. Проблема выравнивания стала серьезной областью академических исследований. [213]

Алан Тьюринг написал в 1950 году: «Я предлагаю рассмотреть вопрос: могут ли машины думать?» [274] Он посоветовал изменить вопрос с «думает ли машина» на «может ли машина демонстрировать разумное поведение». [274] Он разработал тест Тьюринга, который измеряет способность машины имитировать человеческий разговор. [275] Поскольку мы можем только наблюдать за поведением машины, не имеет значения, «на самом деле» она думает или буквально обладает «разумом». Тьюринг отмечает, что мы не можем определить эти вещи о других людях [z] , но «обычно существует вежливое соглашение, согласно которому все думают» [276]

Рассел и Норвиг согласны с Тьюрингом в том, что ИИ следует определять с точки зрения «действия», а не «мышления». [277] Однако им очень важно, чтобы в тесте машины сравнивались с людьми . « Тексты по авиационной технике , — писали они, — не определяют цель своей области как создание «машин, которые летают настолько точно, как голуби , что могут обмануть других голубей » . [278] Основатель искусственного интеллекта Джон Маккарти согласился, написав, что « искусственные интеллект по определению не является симуляцией человеческого интеллекта». [279]

Маккарти определяет интеллект как «вычислительную часть способности достигать целей в мире». [280] Другой основатель ИИ, Марвин Мински , также определяет его как «способность решать сложные проблемы». [281] Эти определения рассматривают интеллект как четко определенные проблемы с четко определенными решениями, где и сложность проблемы, и производительность программы являются прямыми мерами «интеллекта» машины, а не какие-либо другие философские дискуссии. требуется или даже невозможен.

Другое определение было принято Google, [282] крупным практиком в области искусственного интеллекта. Это определение предусматривает способность систем синтезировать информацию как проявление интеллекта, аналогично тому, как это определяется в биологическом интеллекте.

Никакая устоявшаяся объединяющая теория или парадигма не направляла исследования ИИ на протяжении большей части его истории. [aa] Беспрецедентный успех статистического машинного обучения в 2010-х годах затмил все другие подходы (настолько, что некоторые источники, особенно в деловом мире, используют термин «искусственный интеллект» для обозначения «машинного обучения с нейронными сетями»). Этот подход в основном субсимволический , мягкий и узкий (см. ниже). Критики утверждают, что будущим поколениям исследователей ИИ, возможно, придется вернуться к этим вопросам.

Символический ИИ (или « GOFAI ») [284] имитировал сознательные рассуждения высокого уровня, которые люди используют, когда решают головоломки, выражают юридические рассуждения и занимаются математикой. Они очень успешно справлялись с «умными» задачами, такими как алгебра или тесты на IQ. В 1960-х годах Ньюэлл и Саймон предложили гипотезу системы физических символов : «Система физических символов обладает необходимыми и достаточными средствами общего разумного действия». [285]

Однако символический подход не справился со многими задачами, которые люди легко решают, такими как обучение, распознавание объекта или здравое рассуждение. Парадокс Моравца заключается в открытии того, что «интеллектуальные» задачи высокого уровня были легкими для ИИ, а «инстинктивные» задачи низкого уровня были чрезвычайно трудными. [286] Философ Хьюберт Дрейфус с 1960-х годов утверждал , что человеческий опыт зависит от бессознательного инстинкта, а не от сознательного манипулирования символами, и от «чувства» ситуации, а не от явного символического знания. [287] Хотя его аргументы были высмеяны и проигнорированы, когда они были впервые представлены, в конечном итоге исследования ИИ пришли к его мнению. [аб] [16]

Проблема не решена: субсимволические рассуждения могут совершать многие из тех же непостижимых ошибок, что и человеческая интуиция, например алгоритмическая предвзятость . Критики, такие как Ноам Хомский, утверждают, что продолжение исследований символического ИИ по-прежнему будет необходимо для достижения общего интеллекта, [289] [290] отчасти потому, что субсимволический ИИ представляет собой отход от объяснимого ИИ : может быть трудно или невозможно понять, почему современная статистическая программа искусственного интеллекта приняла конкретное решение. Развивающаяся область нейросимволического искусственного интеллекта пытается соединить два подхода.

«Чистые» надеются, что разумное поведение описывается с использованием простых и элегантных принципов (таких как логика , оптимизация или нейронные сети ). «Неряшливы» ожидают, что это обязательно потребует решения большого количества несвязанных между собой задач. Чистоплотные защищают свои программы с теоретической строгостью, неряшливые полагаются главным образом на постепенное тестирование, чтобы увидеть, работают ли они. Этот вопрос активно обсуждался в 1970-е и 1980-е годы, [291] но в конечном итоге был признан неактуальным. Современный ИИ имеет элементы и того, и другого.

Для многих важных задач найти доказуемо правильное или оптимальное решение сложно . [15] Мягкие вычисления — это набор методов, включая генетические алгоритмы , нечеткую логику и нейронные сети , которые терпимы к неточностям, неопределенности, частичной истине и приближению. Мягкие вычисления были представлены в конце 1980-х годов, и наиболее успешные программы искусственного интеллекта в 21 веке являются примерами мягких вычислений с нейронными сетями.

Исследователи ИИ разделились во мнениях относительно того, следует ли напрямую преследовать цели искусственного общего интеллекта и сверхинтеллекта или решать как можно больше конкретных проблем ( узкий ИИ ) в надежде, что эти решения косвенно приведут к долгосрочным целям в этой области. [292] [293] Общий интеллект трудно определить и измерить, а современный ИИ добился более проверяемых успехов, сосредоточив внимание на конкретных проблемах и конкретных решениях. Экспериментальное подразделение общего искусственного интеллекта изучает исключительно эту область.

Философия разума не знает, может ли машина обладать разумом , сознанием и психическими состояниями в том же смысле, что и люди. В этом вопросе учитывается внутренний опыт машины, а не ее внешнее поведение. Основные исследования в области искусственного интеллекта считают этот вопрос неактуальным, поскольку он не влияет на цели этой области: создание машин, которые могут решать проблемы с помощью интеллекта. Рассел и Норвиг добавляют, что «дополнительный проект по созданию машины, обладающей таким же сознанием, как и люди, — это не тот проект, за который мы готовы взяться». [294] Однако этот вопрос стал центральным в философии разума. Это также, как правило, центральный вопрос, обсуждаемый в области искусственного интеллекта в художественной литературе .

Дэвид Чалмерс выделил две проблемы в понимании разума, которые он назвал «сложными» и «легкими» проблемами сознания. [295] Самая простая задача — понять, как мозг обрабатывает сигналы, строит планы и контролирует поведение. Сложная проблема состоит в том, чтобы объяснить, как это ощущается или почему это вообще должно ощущаться как-то, предполагая, что мы правы, думая, что это действительно что-то ощущается (иллюзоризм сознания Деннета говорит, что это иллюзия). Обработку информации человеком легко объяснить, однако субъективный опыт человека объяснить сложно. Например, легко представить человека, страдающего дальтонизмом, который научился определять, какие объекты в его поле зрения являются красными, но неясно, что потребуется, чтобы человек знал, как выглядит красный цвет . [296]

Компьютерализм — это позиция в философии разума , согласно которой человеческий разум — это система обработки информации, а мышление — это форма вычислений. Компьютерализм утверждает, что отношения между разумом и телом аналогичны или идентичны отношениям между программным обеспечением и оборудованием и, таким образом, могут быть решением проблемы разума и тела . Эта философская позиция была вдохновлена работами исследователей искусственного интеллекта и ученых-когнитивистов в 1960-х годах и первоначально была предложена философами Джерри Фодором и Хилари Патнэм . [297]

Философ Джон Сирл охарактеризовал эту позицию как « сильный ИИ »: «Правильно запрограммированный компьютер с правильными входами и выходами, таким образом, будет обладать разумом точно в том же смысле, в котором разум есть у людей». [ac] Серл опровергает это утверждение своим аргументом о китайской комнате, который пытается показать, что, даже если машина идеально имитирует человеческое поведение, все равно нет оснований предполагать, что она также обладает разумом. [301]

Если у машины есть разум и субъективный опыт, то она также может обладать разумом (способностью чувствовать), и в этом случае она также может страдать ; утверждалось, что это может дать ему определенные права. [302] Любые гипотетические права роботов будут лежать в одном ряду с правами животных и правами человека. [303] Этот вопрос рассматривался в художественной литературе на протяжении веков, [304] и сейчас рассматривается, например, Калифорнийским Институтом Будущего ; однако критики утверждают, что дискуссия преждевременна. [305]

Сверхинтеллект — это гипотетический агент, обладающий интеллектом, намного превосходящим интеллект самого яркого и одаренного человеческого разума. [293]

Если бы исследования в области общего искусственного интеллекта привели к созданию достаточно интеллектуального программного обеспечения, оно могло бы перепрограммировать и улучшить себя. Усовершенствованное программное обеспечение будет еще лучше самосовершенствоваться, что приведет к тому, что И.Дж. Гуд назвал « интеллектуальным взрывом », а Вернор Виндж — « сингулярностью ». [306]

Однако технологии не могут совершенствоваться экспоненциально бесконечно и обычно следуют S-образной кривой , замедляясь, когда достигают физических пределов возможностей технологии. [307]

Конструктор роботов Ганс Моравец , кибернетик Кевин Уорвик и изобретатель Рэй Курцвейл предсказали, что люди и машины в будущем сольются в киборгов , которые будут более способными и могущественными, чем оба. Эта идея, названная трансгуманизмом, имеет корни у Олдоса Хаксли и Роберта Эттингера . [308]

Эдвард Фредкин утверждает, что «искусственный интеллект — это следующий этап эволюции», идея, впервые предложенная Сэмюэлем Батлером в книге « Дарвин среди машин » еще в 1863 году и развитая Джорджем Дайсоном в его одноименной книге в 1863 году. 1998. [309]

Искусственные существа, способные мыслить, появлялись в качестве средств повествования с античных времен [310] и были постоянной темой в научной фантастике . [311]

Общий образ в этих произведениях начался с «Франкенштейна » Мэри Шелли , где человеческое творение становится угрозой для своих хозяев. Сюда входят такие работы, как «Космическая одиссея 2001 года» Артура Кларка и Стэнли Кубрика (обе 1968 года) с HAL 9000 , смертоносным компьютером, управляющим космическим кораблем Discovery One , а также «Терминатор» (1984 год) и «Матрица» (1999 год). ). Напротив, редкие верные роботы, такие как Горт из « Дня, когда Земля остановилась» (1951) и Бишоп из «Чужих» (1986), менее заметны в популярной культуре. [312]

Айзек Азимов представил Три закона робототехники во многих книгах и рассказах, в первую очередь в серии «Мультивак» об одноименном сверхразумном компьютере. Законы Азимова часто поднимаются во время непрофессиональных дискуссий по этике машин; [313] хотя почти все исследователи искусственного интеллекта знакомы с законами Азимова через массовую культуру, они обычно считают эти законы бесполезными по многим причинам, одной из которых является их двусмысленность. [314]

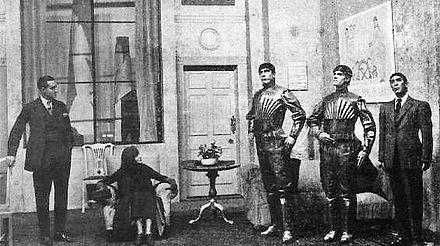

В нескольких работах ИИ используется, чтобы заставить нас ответить на фундаментальный вопрос о том, что делает нас людьми, показывая нам искусственные существа, обладающие способностью чувствовать и, следовательно, страдать. Это появляется в фильме Карела Чапека « RUR » , фильмах «Искусственный интеллект ИИ » и «Из машины» , а также в романе « Мечтают ли андроиды об электроовцах?» , Филип К. Дик . Дик рассматривает идею о том, что наше понимание человеческой субъективности меняется благодаря технологиям, созданным с помощью искусственного интеллекта. [315]

Два наиболее широко используемых учебника в 2023 году (см. Открытую программу).

Это были четыре наиболее широко используемых учебника по ИИ в 2008 году:

Более поздние издания.

Вместо этого Соединенные Штаты создали новую область доминирования, на которую остальной мир смотрит со смесью благоговения, зависти и негодования: искусственный интеллект... От моделей ИИ и исследований до облачных вычислений и венчурного капитала, американские компании, Университеты и исследовательские лаборатории – и их филиалы в странах-союзниках – похоже, имеют огромное преимущество как в разработке передового искусственного интеллекта, так и в его коммерциализации. Стоимость венчурных инвестиций в стартапы в области искусственного интеллекта в США превышает аналогичные показатели остального мира вместе взятых.